As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Integração de servidor MCP

Se você implantou o componente opcional do servidor MCP durante a implantação da solução, poderá integrar a solução de teste de carga distribuída às ferramentas de desenvolvimento de IA que oferecem suporte ao Model Context Protocol. O servidor MCP fornece acesso programático para recuperar, gerenciar e analisar testes de carga por meio de assistentes de IA.

Os clientes podem se conectar ao servidor DLT MCP usando o cliente de sua escolha (Amazon Q, Claude etc.), cada um com instruções de configuração ligeiramente diferentes. Esta seção fornece instruções de configuração para MCP Inspector, Amazon Q CLI, Cline e Amazon Q Suite.

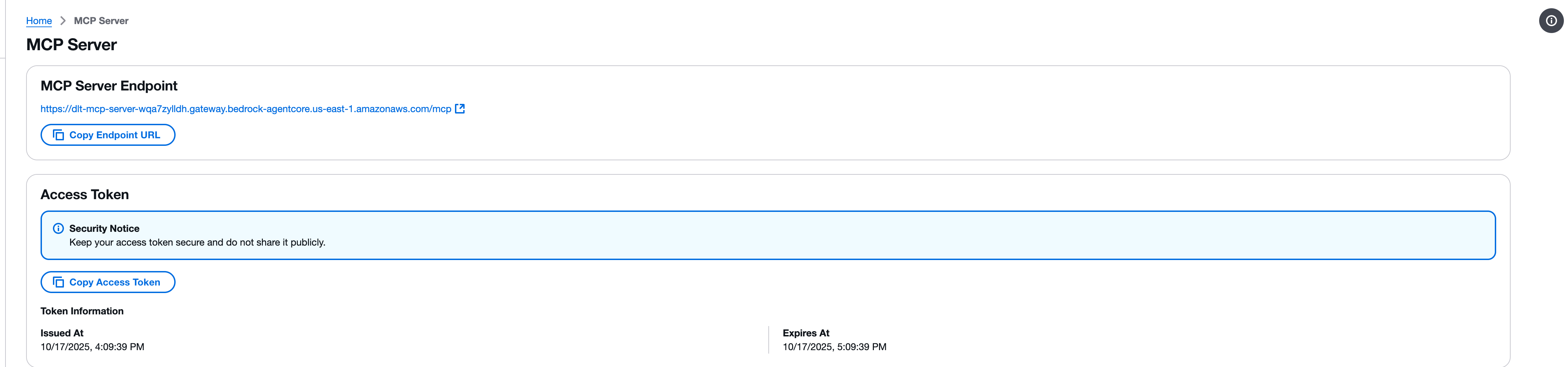

Etapa 1: Obtenha o endpoint MCP e o token de acesso

Antes de configurar qualquer cliente MCP, você precisa recuperar o endpoint do servidor MCP e o token de acesso do console web DLT.

-

Navegue até a página MCP Server no console web do Distributed Load Testing.

-

Localize a seção MCP Server Endpoint.

-

Copie o URL do endpoint usando o botão Copiar URL do endpoint. O URL do endpoint segue o formato:

https://{gateway-id}.gateway.bedrock-agentcore.{region}.amazonaws.com/mcp -

Localize a seção Token de acesso.

-

Copie o token de acesso usando o botão Copiar token de acesso.

Importante

Mantenha seu token de acesso seguro e não o compartilhe publicamente. O token fornece acesso somente de leitura à sua solução de teste de carga distribuída por meio da interface MCP.

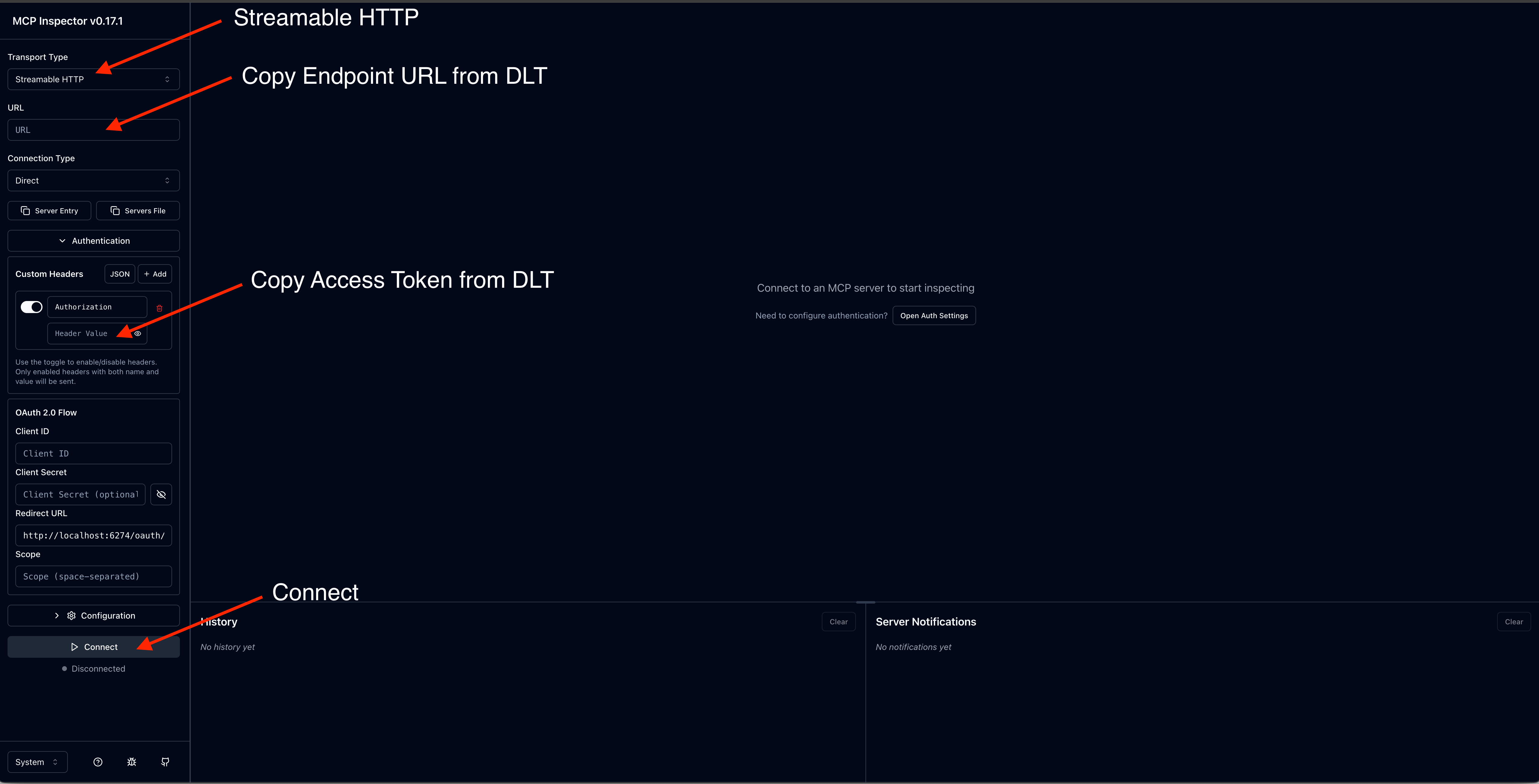

Passo 2: Teste com o MCP Inspector

O Model Context Protocol oferece o MCP Inspector

nota

O MCP Inspector requer a versão 0.17 ou posterior. Todas as solicitações também podem ser feitas diretamente com o JSON RPC, mas o MCP Inspector fornece uma interface mais amigável.

Instale e inicie o MCP Inspector

-

Instale o npm, se necessário.

-

Execute o seguinte comando para iniciar o MCP Inspector:

npx @modelcontextprotocol/inspector

Configurar a conexão

-

Na interface do MCP Inspector, insira seu URL do MCP Server Endpoint.

-

Adicione um cabeçalho de autorização com seu token de acesso.

-

Clique em Connect para estabelecer a conexão.

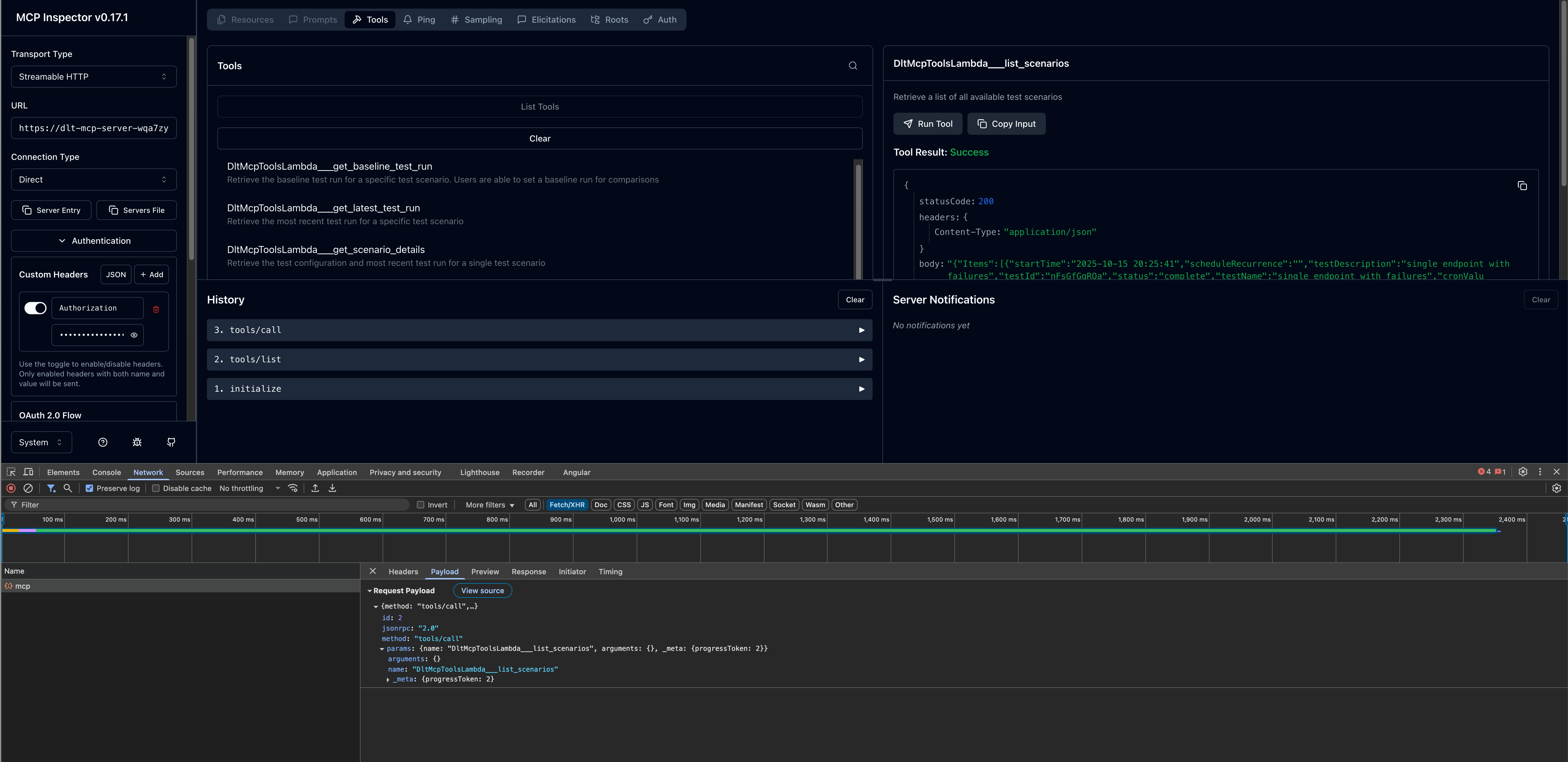

Invocar ferramentas

Depois de conectado, você pode testar as ferramentas MCP disponíveis:

-

Navegue pela lista de ferramentas disponíveis no painel esquerdo.

-

Selecione uma ferramenta (por exemplo,

list_scenarios). -

Forneça todos os parâmetros necessários.

-

Clique em Invocar para executar a ferramenta e visualizar a resposta.

Etapa 3: configurar clientes de desenvolvimento de IA

Depois de verificar a conexão do servidor MCP com o MCP Inspector, você pode configurar seu cliente de desenvolvimento de IA preferido.

CLI do Amazon Q

O Amazon Q CLI fornece acesso por linha de comando ao desenvolvimento assistido por IA com a integração do servidor MCP.

Etapas de configuração

-

Edite o arquivo de configuração do

mcp.json. Para obter mais informações sobre a localização do arquivo de configuração, consulte Configuração de servidores MCP remotos no Amazon Q Developer User Guide. -

Adicione sua configuração de servidor DLT MCP:

{ "mcpServers": { "dlt-mcp": { "type": "http", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } }

Verifique a configuração

-

Em um terminal, digite

qpara iniciar o Amazon Q CLI. -

Digite

/mcppara ver todos os servidores MCP disponíveis. -

Digite

/toolspara ver as ferramentas disponíveis fornecidas pordlt-mcpe outros servidores MCP configurados. -

Verifique se

dlt-mcpfoi inicializado com sucesso.

Cline

O Cline é um assistente de codificação de IA que oferece suporte à integração do servidor MCP.

Etapas de configuração

-

Em Cline, navegue até Gerenciar servidores MCP > Configurar > Configurar servidores MCP.

-

Atualize o arquivo

cline_mcp_settings.json:{ "mcpServers": { "dlt-mcp": { "type": "streamableHttp", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } } -

Salve o arquivo de configuração.

-

Reinicie o Cline para aplicar as alterações.

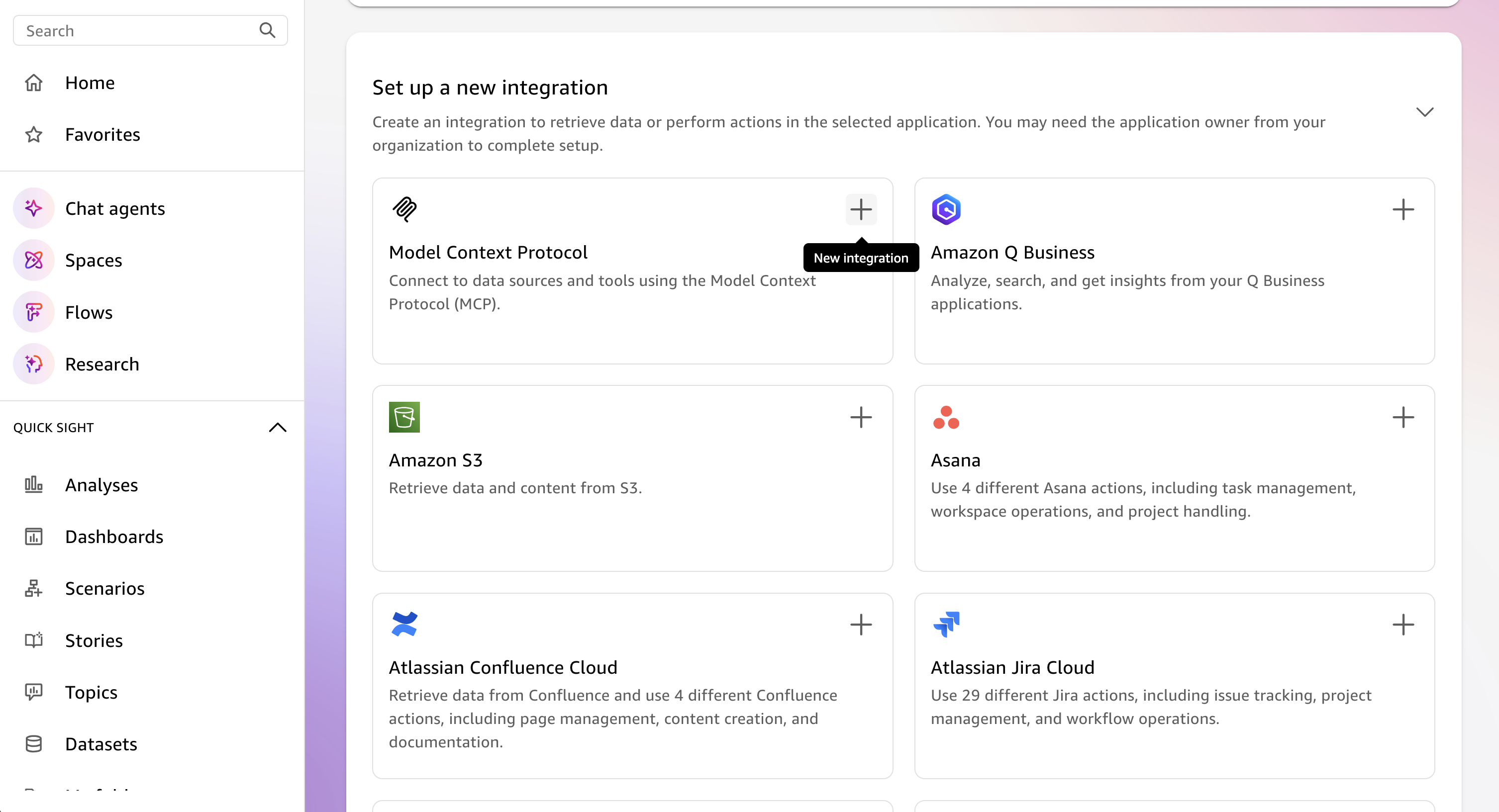

Suíte Amazon Q

O Amazon Q Suite fornece uma plataforma abrangente de assistente de IA com suporte para ações do servidor MCP.

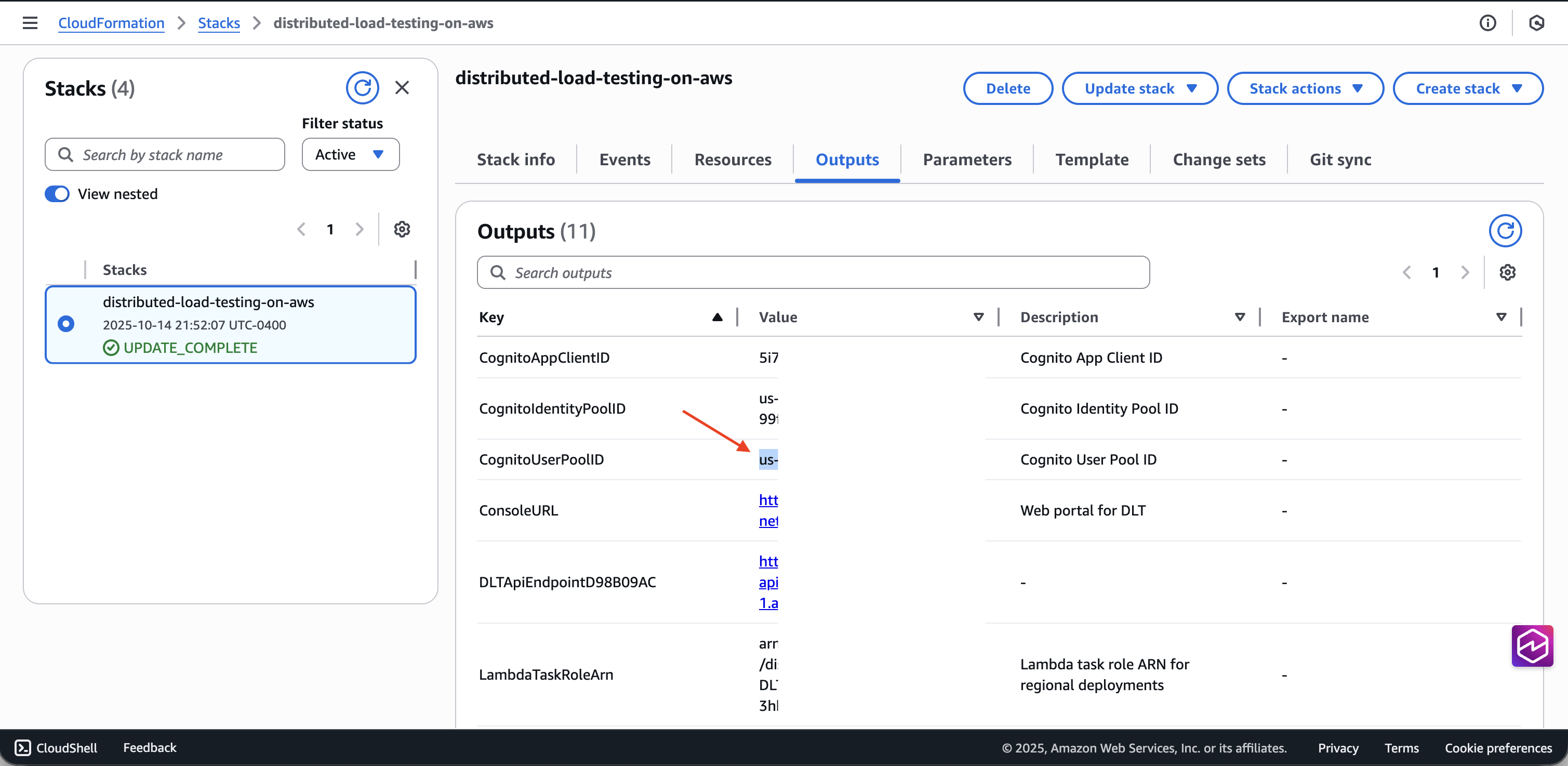

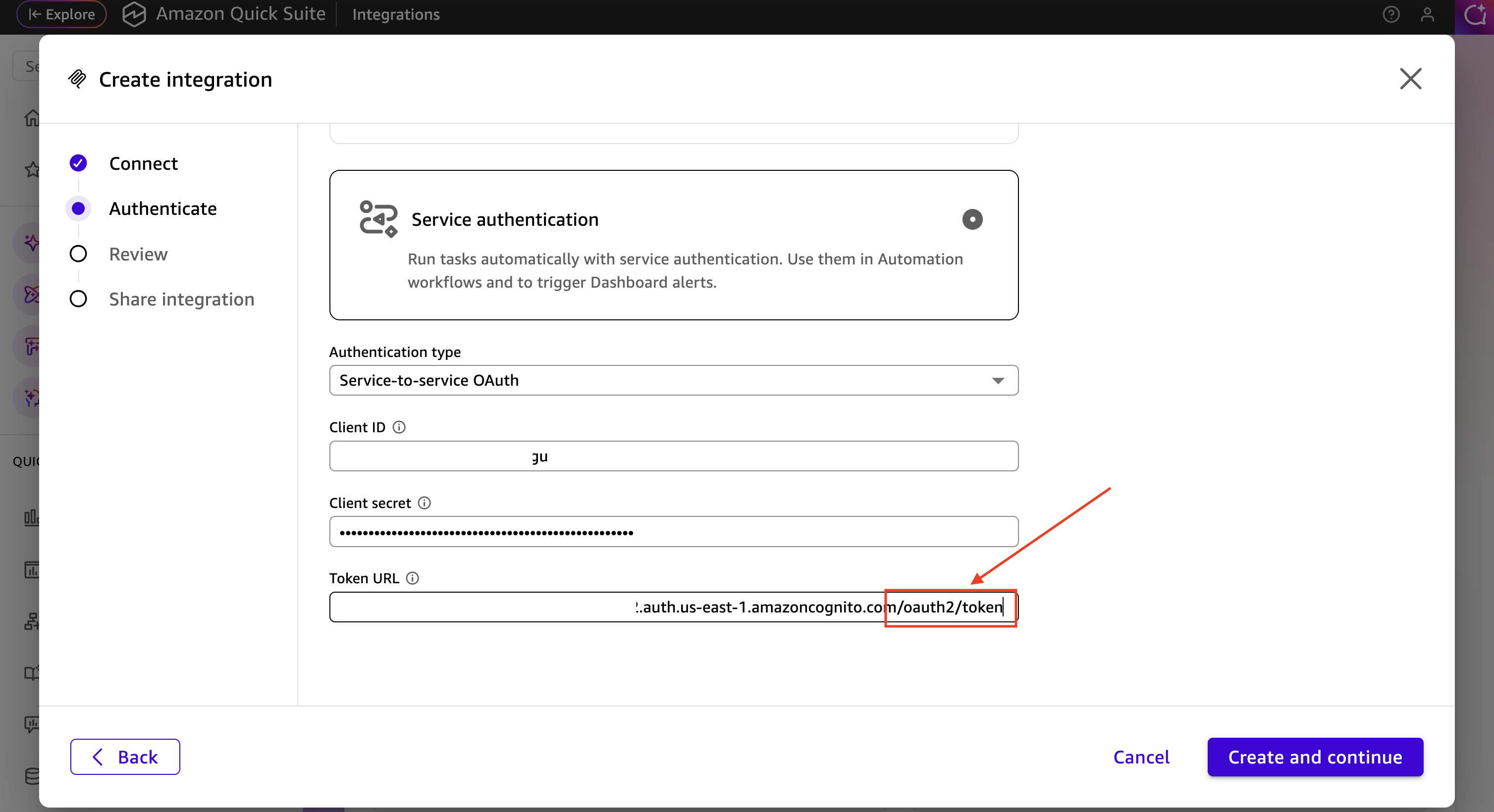

Pré-requisitos

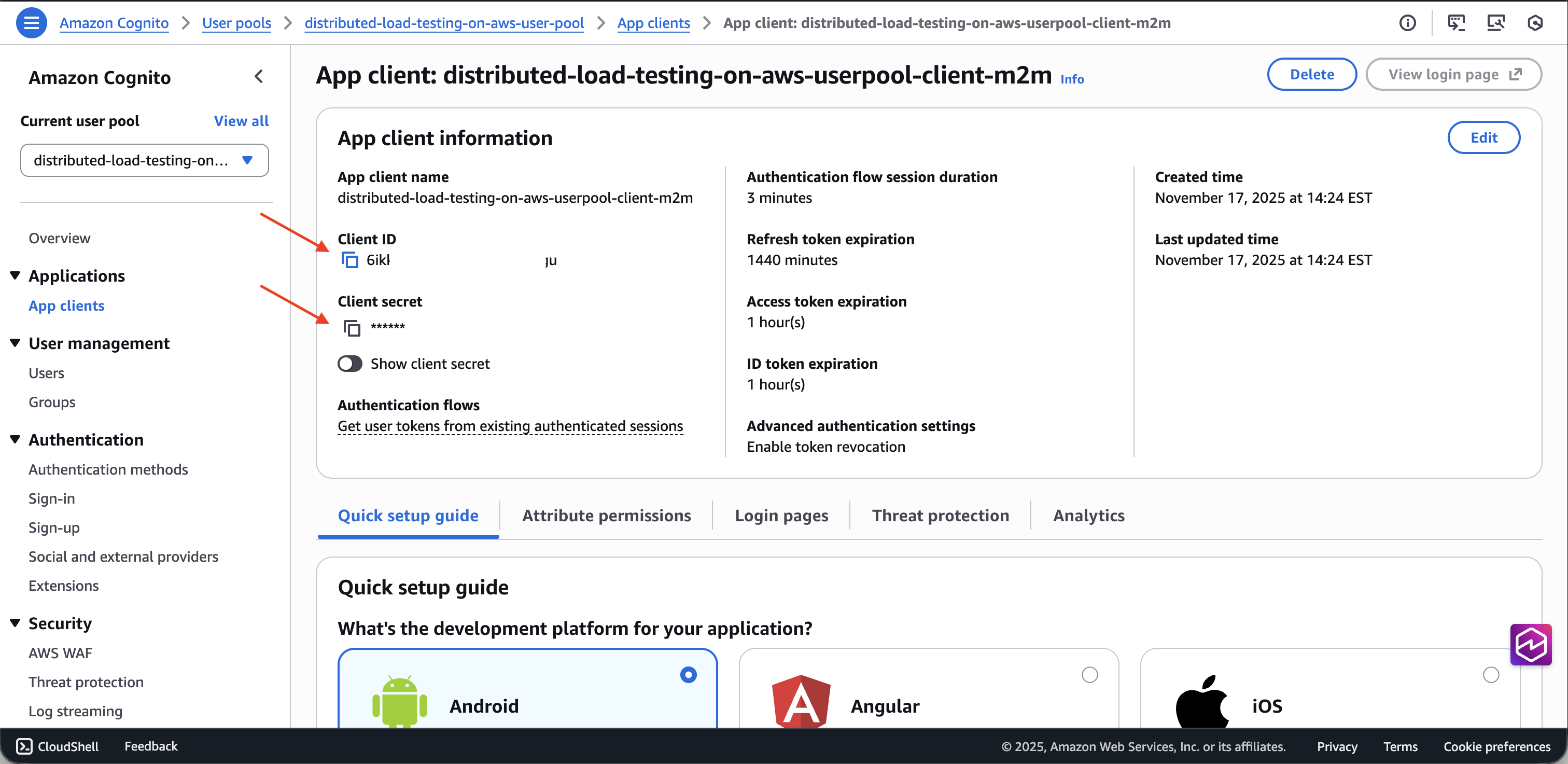

Antes de configurar o servidor MCP no Amazon Q Suite, você precisa recuperar as OAuth credenciais do grupo de usuários do Cognito da sua implantação de DLT:

-

Navegue até o CloudFormation console da AWS

. -

Selecione a pilha de testes de carga distribuída.

-

Na guia Saídas, localize e copie o ID do Grupo de Usuários do Cognito associado à sua implantação de DLT.

-

Acesse o console do Amazon Cognito

. -

Selecione o grupo de usuários usando o ID do grupo de usuários nas CloudFormation saídas.

-

No painel de navegação à esquerda, selecione Integração de aplicativos > Clientes de aplicativos.

-

Localize o cliente do aplicativo com o nome terminado em

m2m(machine-to-machine). -

Copie o ID do cliente e o segredo do cliente.

-

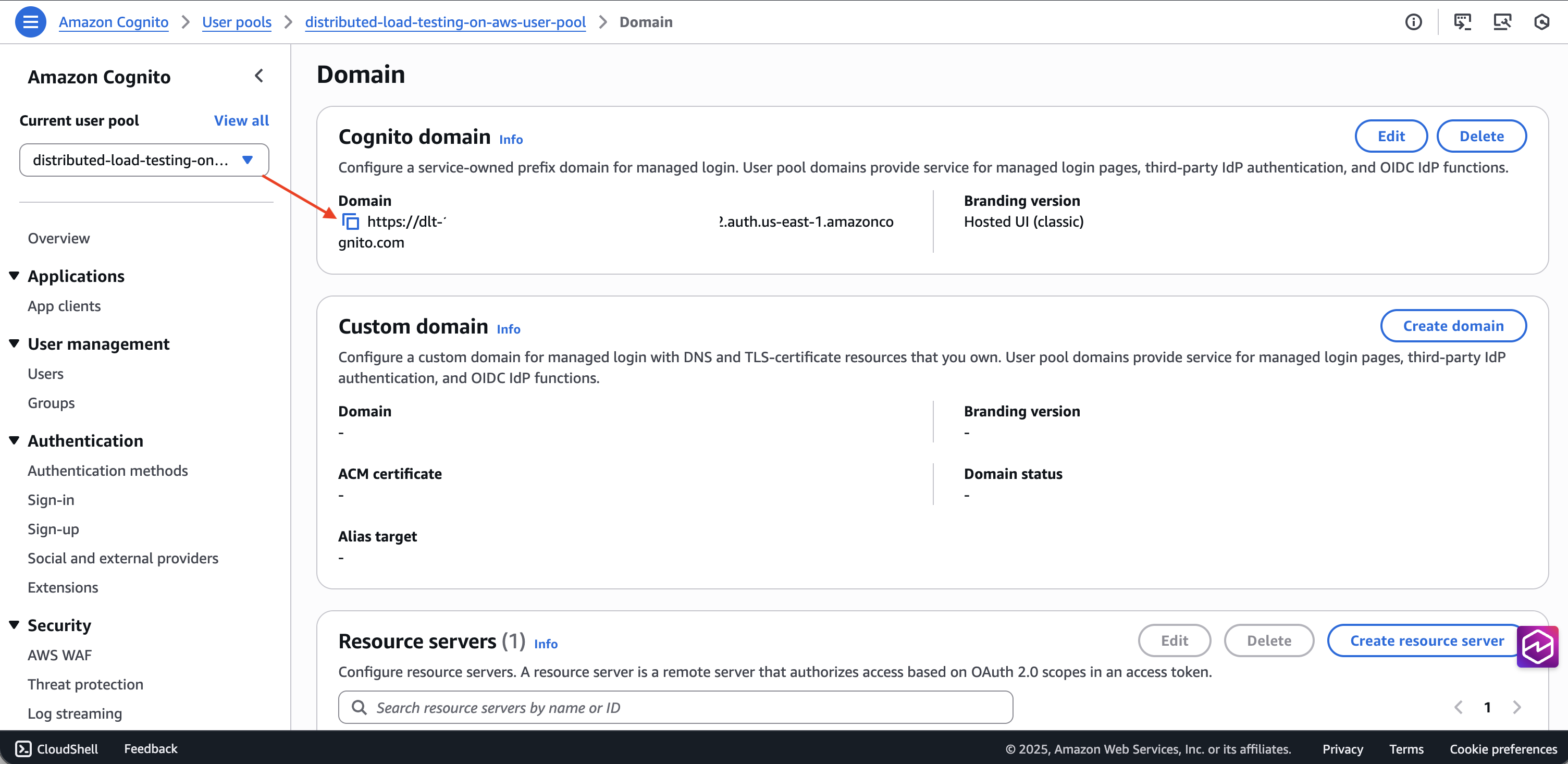

Obtenha o domínio do grupo de usuários na guia Domínio.

-

Crie o URL do endpoint do token anexando-o

/oauth2/tokenao final do domínio.

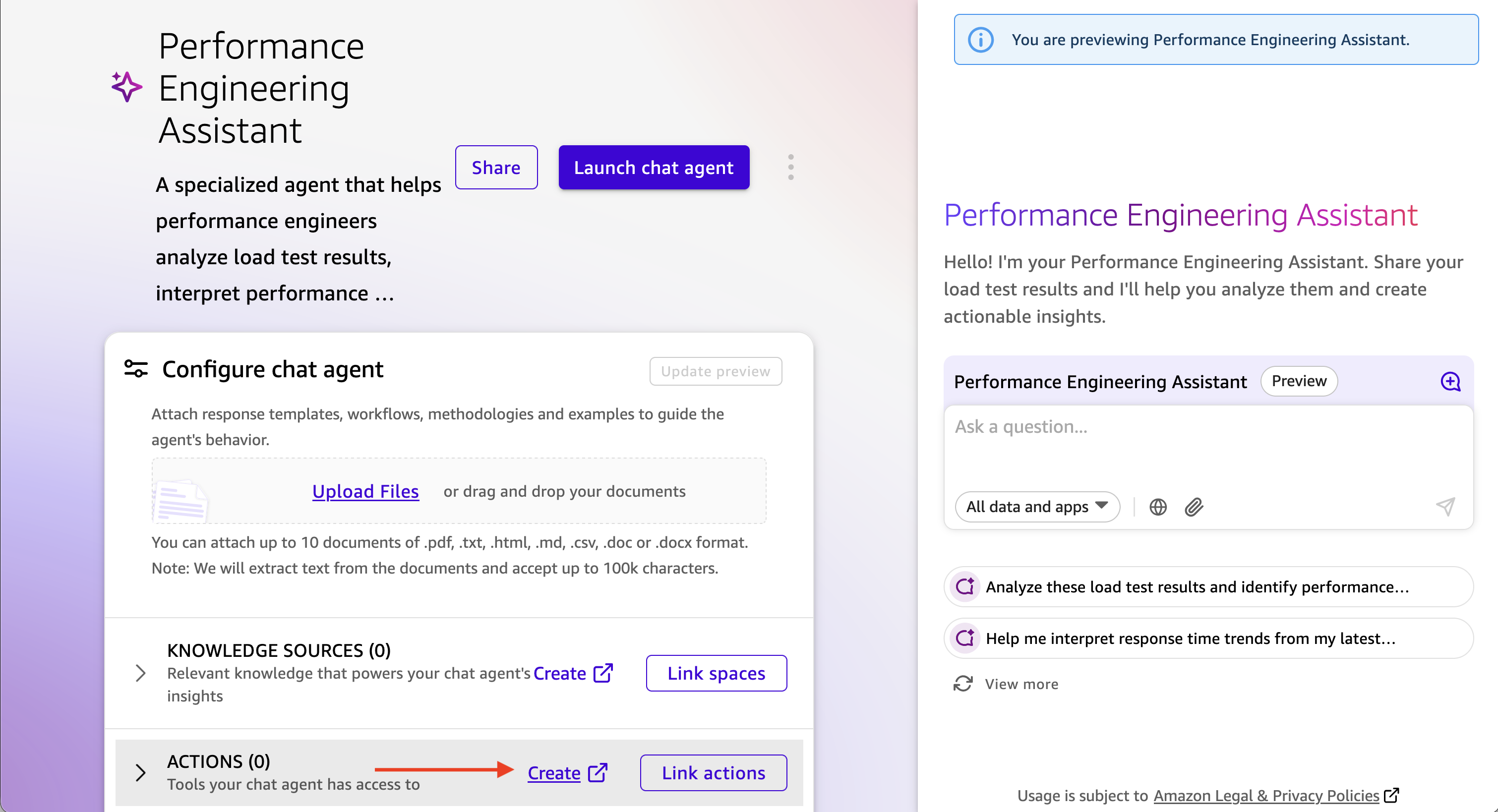

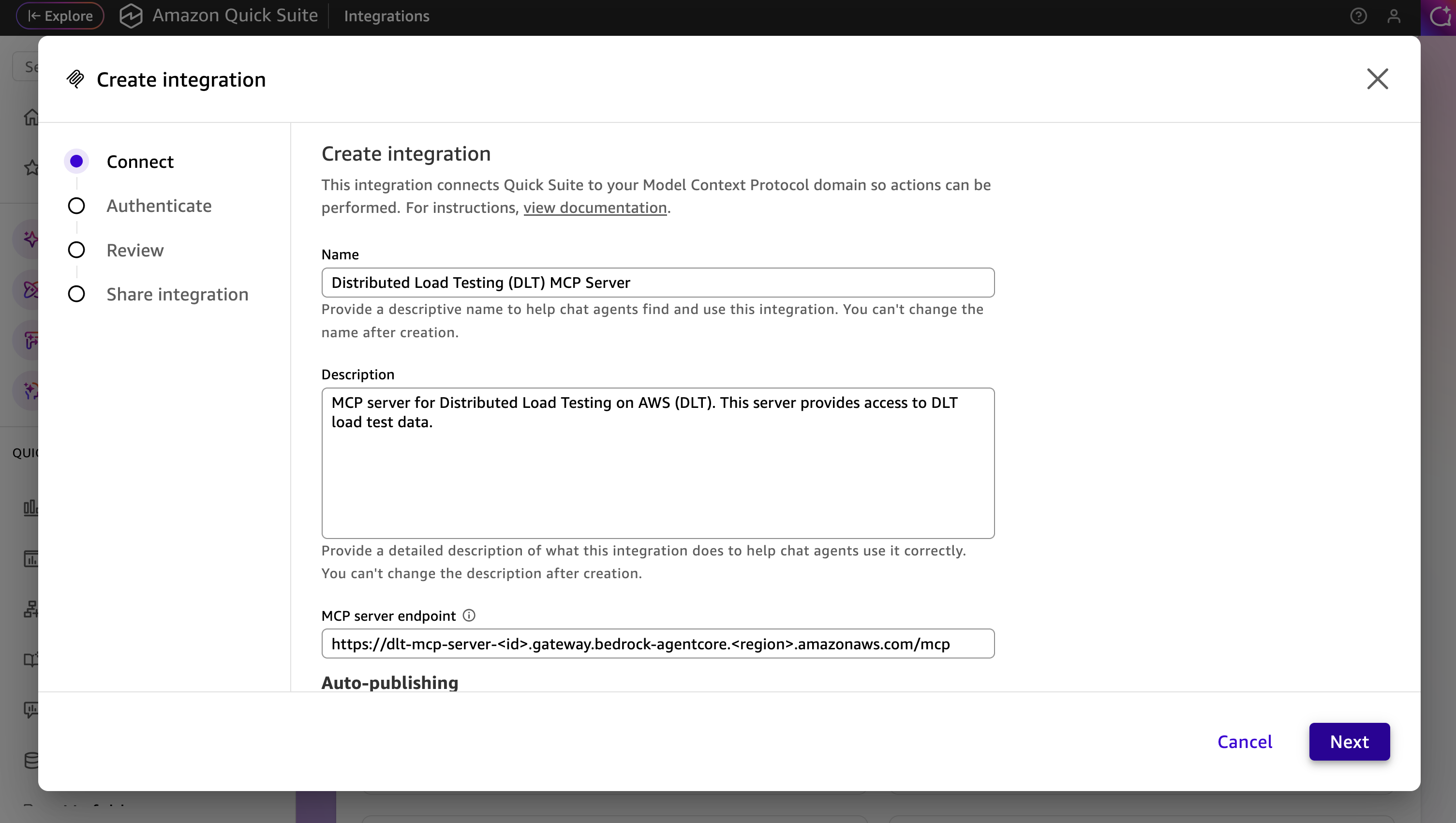

Etapas de configuração

-

No Amazon Q Suite, crie um novo agente ou selecione um agente existente.

-

Adicione um prompt de agente que descreva como interagir com o servidor DLT MCP.

-

Adicione uma nova ação e selecione a ação do servidor MCP.

-

Configure os detalhes do servidor MCP:

-

URL do servidor MCP: Seu endpoint DLT MCP

-

Tipo de autenticação: Autenticação baseada em serviços

-

Token Endpoint: Seu URL do endpoint do token Cognito

-

ID do cliente: O ID do cliente do aplicativo m2m

-

Segredo do cliente: O segredo do cliente do aplicativo m2m

-

-

Salve a configuração de ação do servidor MCP.

-

Adicione a nova ação do servidor MCP ao seu agente.

Inicie e teste o agente

-

Inicie o agente no Amazon Q Suite.

-

Inicie uma conversa com o agente usando instruções em linguagem natural.

-

O agente usará as ferramentas MCP para recuperar e analisar seus dados de teste de carga.

Exemplos de prompt

Os exemplos a seguir demonstram como interagir com seu assistente de IA para analisar dados de teste de carga por meio da interface MCP. Personalize o teste IDs, os intervalos de datas e os critérios para atender às suas necessidades específicas de teste.

Para obter informações detalhadas sobre as ferramentas MCP disponíveis e seus parâmetros, consulte a especificação das ferramentas MCP no Guia do desenvolvedor.

Consulta simples de resultados de testes

A interação da linguagem natural com o servidor MCP pode ser tão simples quanto Show me the load tests that have completed in the last 24 hours with their associated completion status ou pode ser mais descritiva, como

Use list_scenarios to find my load tests. Then use get_latest_test_run to show me the basic execution data and performance metrics for the most recent test. If the results look concerning, also get the detailed performance metrics using get_test_run.

Análise de desempenho interativa com divulgação progressiva

I need to analyze my load test performance, but I'm not sure which specific tests to focus on. Please help me by: 1. First, use list_scenarios to show me available test scenarios 2. Ask me which tests I want to analyze based on the list you show me 3. For my selected tests, use list_test_runs to get the test run history 4. Then use get_test_run with the test_run_id to get detailed response times, throughput, and error rates 5. If I want to compare tests, use get_baseline_test_run to compare against the baseline 6. If there are any issues, use get_test_run_artifacts to help me understand what went wrong Please guide me through this step by step, asking for clarification whenever you need more specific information.

Validação da prontidão de produção

Help me validate if my API is ready for production deployment: 1. Use list_scenarios to find recent test scenarios 2. For the most recent test scenario, use get_latest_test_run to get basic execution data 3. Use get_test_run with that test_run_id to get detailed response times, error rates, and throughput 4. Use get_scenario_details with the test_id to show me what load patterns and endpoints were tested 5. If I have a baseline, use get_baseline_test_run to compare current results with the baseline 6. Provide a clear go/no-go recommendation based on the performance data 7. If there are any concerns, use get_test_run_artifacts to help identify potential issues My SLA requirements are: response time under [X]ms, error rate under [Y]%.

Análise de tendências de desempenho

Analyze the performance trend for my load tests over the past [TIME_PERIOD]: 1. Use list_scenarios to get all test scenarios 2. For each scenario, use list_test_runs with start_date and end_date to get tests from that period 3. Use get_test_run for the key test runs to get detailed metrics 4. Use get_baseline_test_run to compare against the baseline 5. Identify any significant changes in response times, error rates, or throughput 6. If you detect performance degradation, use get_test_run_artifacts on the problematic tests to help identify causes 7. Present the trend analysis in a clear format showing whether performance is improving, stable, or degrading Focus on completed tests and limit results to [N] tests if there are too many.

Solução de problemas em testes com falha

Help me troubleshoot my failed load tests: 1. Use list_scenarios to find test scenarios 2. For each scenario, use list_test_runs to find recent test runs 3. Use get_test_run with the test_run_id to get the basic execution data and failure information 4. Use get_test_run_artifacts to get detailed error messages and logs 5. Use get_scenario_details to understand what was being tested when it failed 6. If I have a similar test that passed, use get_baseline_test_run to identify differences 7. Summarize the causes of failure and suggest next steps for resolution Show me the most recent [N] failed tests from the past [TIME_PERIOD].