As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Crie um cenário de teste

A criação de um cenário de teste envolve quatro etapas principais: definir as configurações gerais, definir o cenário, moldar os padrões de tráfego e revisar sua configuração.

Etapa 1: configurações gerais

Configure os parâmetros básicos para seu teste de carga, incluindo nome do teste, descrição e opções gerais de configuração.

Identificação do teste

-

Nome do teste (obrigatório) - Um nome descritivo para seu cenário de teste

-

Descrição do teste (Obrigatório) - Detalhes adicionais sobre a finalidade e a configuração do teste

-

Tags (opcional) - adicione até 5 tags para categorizar e organizar seus cenários de teste

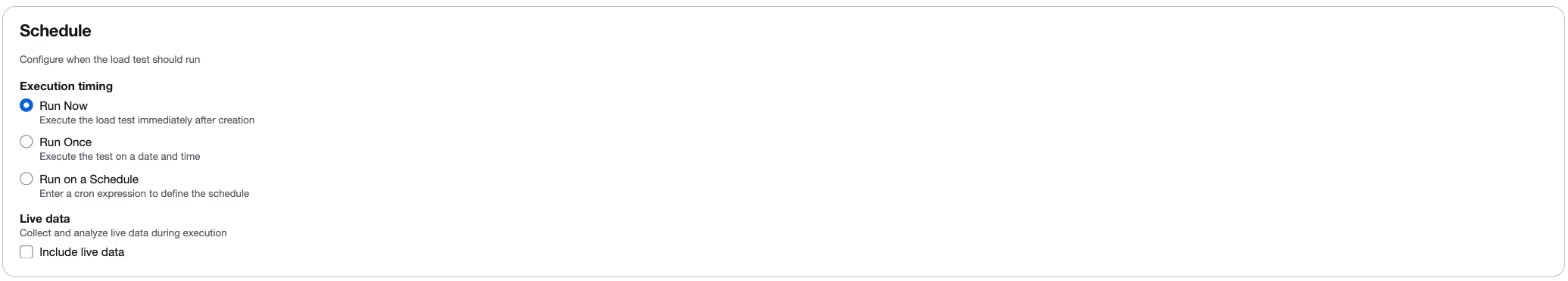

Opções de agendamento

Configure quando o teste deve ser executado:

-

Executar agora - Execute o teste imediatamente após a criação.

-

Executar uma vez - Agende o teste para ser executado em uma data e hora específicas.

-

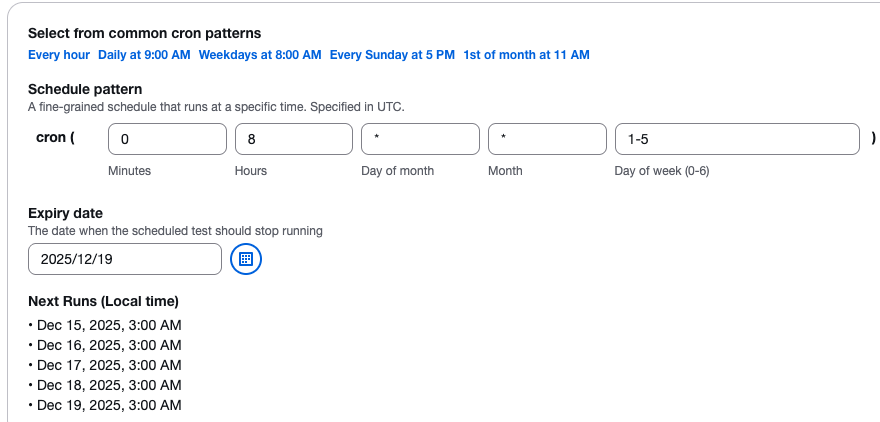

Executar em um cronograma - Use o agendamento baseado em cron para executar testes automaticamente em intervalos regulares. Você pode selecionar padrões comuns (a cada hora, diariamente, semanalmente) ou definir uma expressão cron personalizada.

Fluxo de trabalho de agendamento

Quando você agenda um teste, ocorre o seguinte fluxo de trabalho:

-

Os parâmetros do cronograma são enviados para a API da solução por meio do Amazon API Gateway.

-

A API passa os parâmetros para uma função Lambda que cria uma regra de CloudWatch eventos programada para ser executada na data especificada.

-

Para testes únicos (Run Once), a regra CloudWatch Events é executada na data especificada e a função

api-servicesLambda executa o teste. -

Para testes recorrentes (Executar em um cronograma), a regra de CloudWatch eventos é ativada na data especificada, e a função

api-servicesLambda cria uma nova regra que é executada imediatamente e de forma recorrente com base na frequência especificada.

Dados dinâmicos

Marque a caixa de seleção Incluir dados ativos para visualizar métricas em tempo real enquanto o teste está sendo executado. Quando ativado, você pode monitorar:

-

Tempo médio de resposta.

-

Contagens de usuários virtuais.

-

Solicitações bem-sucedidas contam.

-

Contagens de solicitações falhadas.

O recurso de dados ao vivo fornece gráficos em tempo real com dados agregados em intervalos de um segundo. Para obter mais informações, consulte Monitoramento com dados ativos.

Etapa 2: configuração do cenário

Defina o cenário de teste específico e selecione sua estrutura de teste preferida.

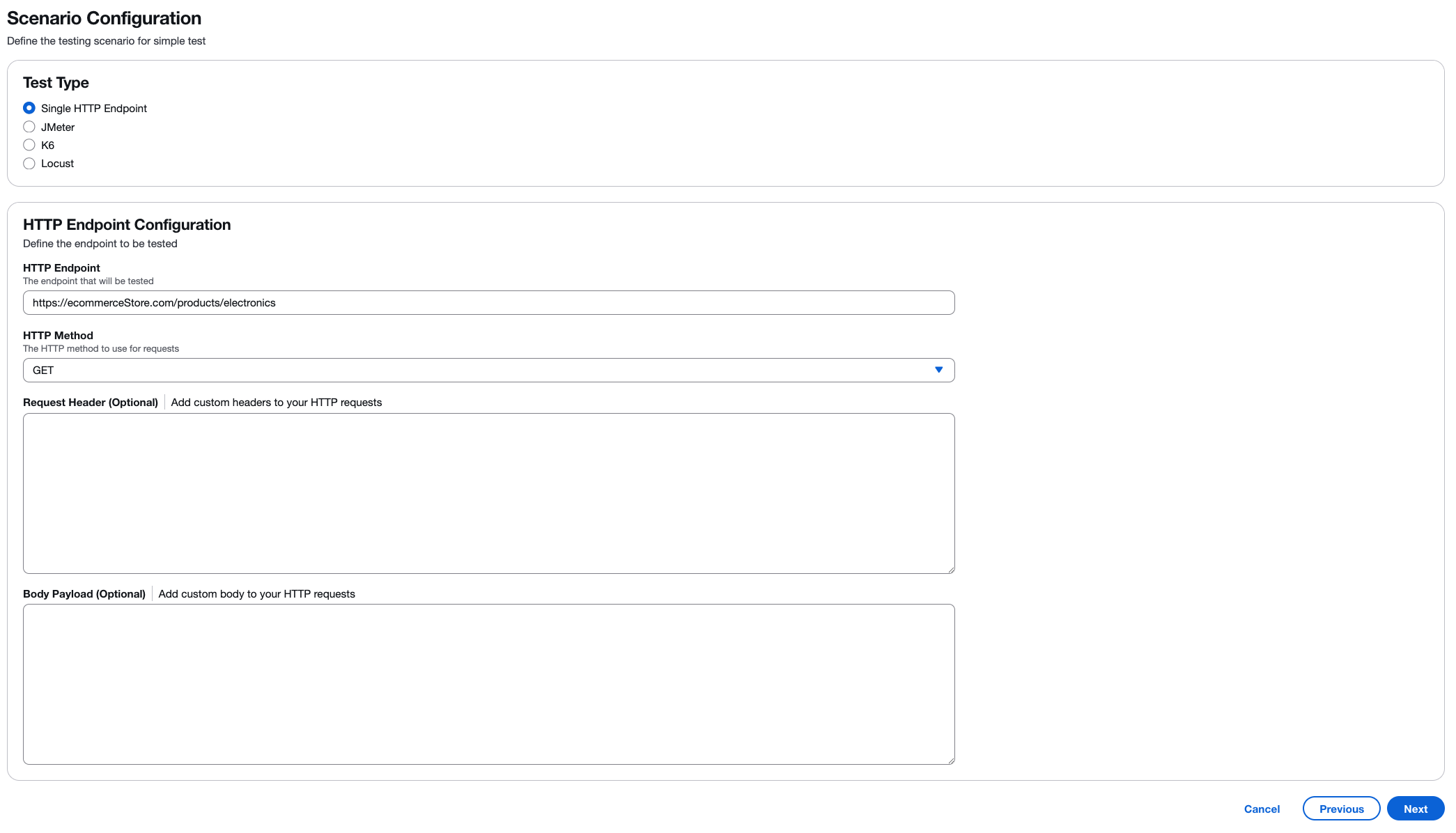

Seleção do tipo de teste

Escolha o tipo de teste de carga que você deseja realizar:

-

Endpoint HTTP único - Teste um único endpoint de API ou página da web com configuração simples.

-

JMeter- Faça upload JMeter de scripts de teste (arquivos.jmx ou arquivos.zip).

-

K6 - Faça upload de scripts de teste K6 (arquivos.js ou arquivos.zip).

-

Locust - Faça upload dos scripts de teste do Locust (arquivos.py ou arquivos.zip).

Imagem de configuração do endpoint HTTP: :images/test-types.png [Selecione o tipo de teste a ser executado] Quando “Endpoint HTTP único” for selecionado, defina estas configurações:

- Endpoint HTTP (obrigatório)

-

Insira o URL completo do endpoint que você deseja testar. Por exemplo, .

https://api.example.com/usersGaranta que o endpoint seja acessível a partir da infraestrutura da AWS. - Método HTTP (obrigatório)

-

Selecione o método HTTP para suas solicitações. O padrão é

GET. Outras opções incluemPOSTPUT,DELETE,PATCHHEAD,,OPTIONSe. - Cabeçalho da solicitação (opcional)

-

Adicione cabeçalhos HTTP personalizados às suas solicitações. Os exemplos comuns incluem:

-

Content-Type: application/json -

Authorization: Bearer <token> -

User-Agent: LoadTest/1.0Escolha Adicionar cabeçalho para incluir vários cabeçalhos.

-

- Carga útil do corpo (opcional)

-

Adicione o conteúdo do corpo da solicitação para solicitações POST ou PUT. Suporta formatos JSON, XML ou texto sem formatação. Por exemplo:

{"userId": 123, "action": "test"}.

Scripts de estrutura de teste

Ao usar JMeter K6 ou Locust, carregue seu arquivo de script de teste ou um arquivo.zip contendo seu script de teste e arquivos de suporte. Pois JMeter, você pode incluir plug-ins personalizados em uma /plugins pasta dentro do seu arquivo.zip.

Importante

Embora seu script de teste (JMeter, K6 ou Locust) possa definir simultaneidade (usuários virtuais), taxas de transação (TPS), tempos de aceleração e outros parâmetros de carregamento, a solução substituirá essas configurações pelos valores especificados na tela do Traffic Shape durante a criação do teste. A configuração do Traffic Shape controla a contagem de tarefas, a simultaneidade (usuários virtuais por tarefa), a duração do aumento e a duração da espera para a execução do teste.

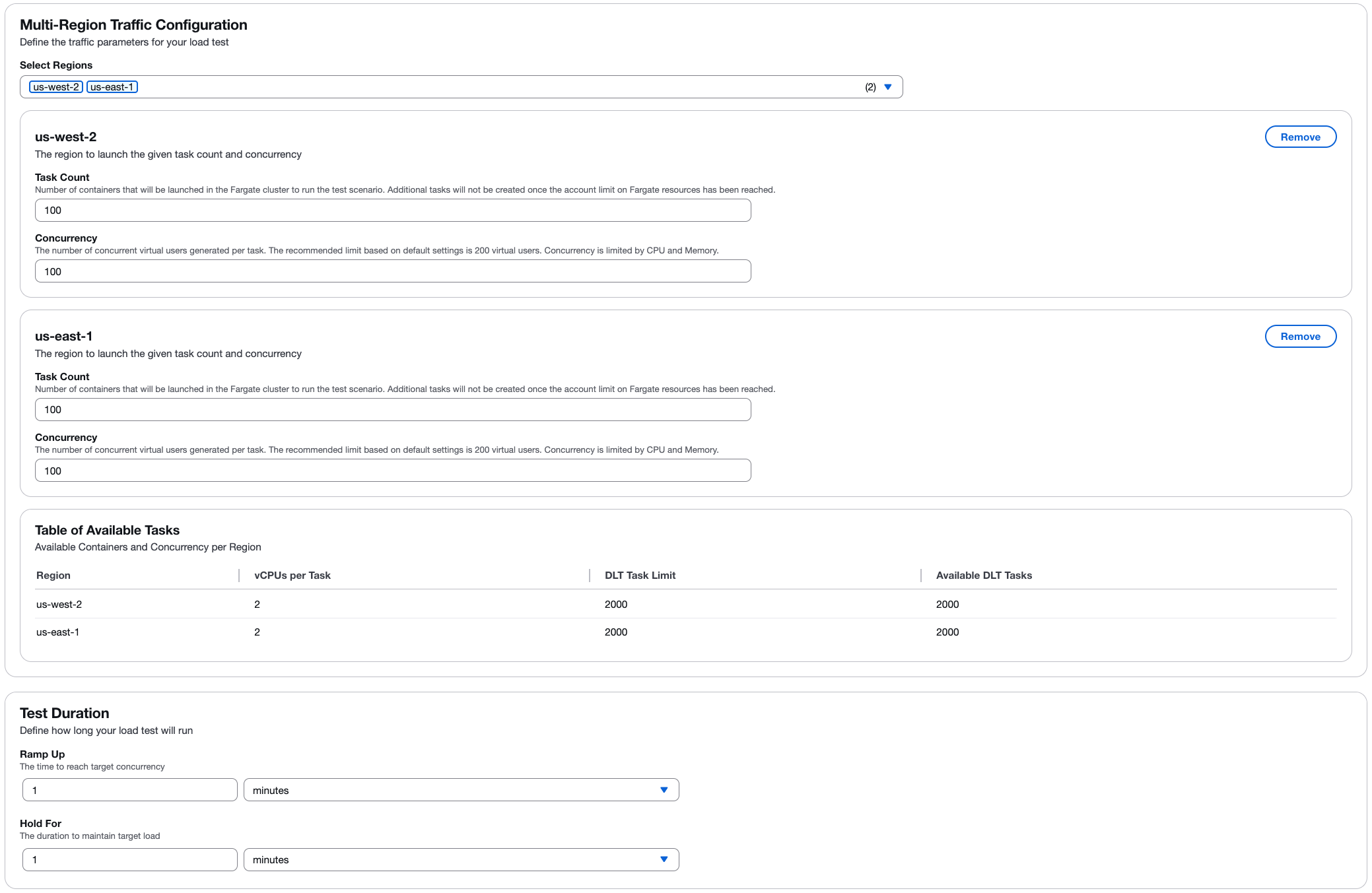

Etapa 3: forma do tráfego

Configure como o tráfego será distribuído durante o teste, incluindo suporte multirregional.

Configuração de tráfego multirregional

Selecione uma ou mais regiões da AWS para distribuir seu teste de carga geograficamente. Para cada região selecionada, configure:

- Contagem de tarefas

-

O número de contêineres (tarefas) que serão lançados no cluster Fargate para o cenário de teste. Tarefas adicionais não serão criadas quando a conta atingir o limite “O recurso Fargate foi atingido”.

- Simultaneidade

-

O número de usuários virtuais simultâneos gerados por tarefa. O limite recomendado é baseado nas configurações padrão de 2 v CPUs por tarefa. A simultaneidade é limitada pelos recursos de CPU e memória.

Determine o número de usuários

O número de usuários que um contêiner pode suportar para um teste pode ser determinado aumentando gradualmente o número de usuários e monitorando o desempenho na Amazon CloudWatch. Depois de observar que o desempenho da CPU e da memória está se aproximando do limite, você atingiu o número máximo de usuários que um contêiner pode suportar para esse teste em sua configuração padrão (2 vCPU e 4 GB de memória).

Processo de calibração

Você pode começar a determinar os limites de usuários simultâneos para seu teste usando o exemplo a seguir:

-

Crie um teste com no máximo 200 usuários.

-

Enquanto o teste é executado, monitore a CPU e a memória usando o CloudWatch console

: -

No painel de navegação esquerdo, em Container Insights, selecione Monitoramento de desempenho.

-

Na página Monitoramento de desempenho, no menu suspenso esquerdo, selecione ECS Clusters.

-

No menu suspenso à direita, selecione seu cluster do Amazon Elastic Container Service (Amazon ECS).

-

-

Durante o monitoramento, observe a CPU e a memória. Se a CPU não ultrapassar 75% ou a memória não ultrapassar 85% (ignore picos únicos), você poderá executar outro teste com um número maior de usuários.

Repita as etapas de 1 a 3 se o teste não exceder os limites de recursos. Opcionalmente, você pode aumentar os recursos do contêiner para permitir um número maior de usuários simultâneos. No entanto, isso resulta em um custo maior. Para obter detalhes, consulte o Guia do desenvolvedor.

nota

Para obter resultados precisos, execute somente um teste por vez ao determinar os limites de usuários simultâneos. Todos os testes usam o mesmo cluster, e o CloudWatch container insights agrega os dados de desempenho com base no cluster. Isso faz com que os dois testes sejam reportados ao CloudWatch Container Insights simultaneamente, o que resulta em métricas imprecisas de utilização de recursos para um único teste.

Para obter mais informações sobre como calibrar usuários por motor, consulte Calibrando um teste Taurus

nota

A solução exibe as informações de capacidade disponíveis para cada região, ajudando você a planejar sua configuração de teste dentro dos limites disponíveis.

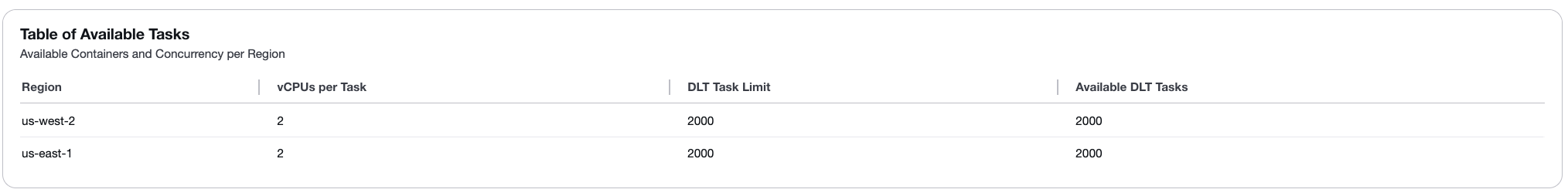

Tabela de tarefas disponíveis

A Tabela de Tarefas Disponíveis exibe a disponibilidade de recursos para cada região selecionada:

-

Região - O nome da região da AWS.

-

v CPUs por tarefa - O número de virtuais CPUs alocados para cada tarefa (padrão: 2).

-

Limite de tarefas DLT - O número máximo de tarefas que podem ser criadas com base nos limites do Fargate da sua conta (padrão: 2000).

-

Tarefas DLT disponíveis - O número atual de tarefas disponíveis para uso na região (padrão: 2000).

Para aumentar o número de tarefas disponíveis ou v CPUs por tarefa, consulte o Guia do desenvolvedor.

Duração do teste

Defina por quanto tempo seu teste de carga será executado:

- Ramp Up

-

A hora de atingir a simultaneidade desejada. A carga aumenta gradualmente de 0 para o nível de simultaneidade configurado durante esse período.

- Espere por

-

A duração para manter a carga alvo. O teste continua em total concorrência durante esse período.

Etapa 4: revisar e criar

Revise todas as suas configurações antes de criar o cenário de teste. Verificar:

-

Configurações gerais (nome, descrição, cronograma).

-

Configuração do cenário (tipo de teste, endpoint ou script).

-

Forma do tráfego (tarefas, usuários, duração, regiões).

Depois de revisar, escolha Criar para salvar seu cenário de teste.

Gerenciando cenários de teste

Depois de criar um cenário de teste, você pode:

-

Editar - Modifique a configuração do teste. Entre os casos de uso comuns estão:

-

Refinando a forma do tráfego para atingir a taxa de transação desejada.

-

-

Copiar - Duplique um cenário de teste existente para criar variações. Entre os casos de uso comuns estão:

-

Atualizando endpoints ou adicionando headers/body parâmetros.

-

Adicionar ou modificar scripts de teste.

-

-

Excluir - Remova cenários de teste que você não precisa mais.