As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

O que é o Amazon Data Firehose?

O Amazon Data Firehose é um serviço totalmente gerenciado para entrega de dados em streaming

Para obter mais informações sobre as soluções de big data da AWS, consulte Big Data na AWS

Noções básicas dos principais conceitos

Ao começar a usar o Amazon Data Firehose, pode ser vantajoso compreender os conceitos a seguir.

- Fluxo do Firehose

-

A entidade subjacente do Amazon Data Firehose. Você usa o Amazon Data Firehose criando um fluxo do Firehose e enviando dados a ele. Para obter mais informações, consulte Tutorial: Criação de um fluxo do Firehose a partir do console e Envio de dados a um fluxo do Firehose.

- Registro

-

Os dados de interesse que seu produtor de dados envia para um fluxo do Firehose. Um registro pode ter, no máximo, 1,000 KB.

- Produtor de dados

-

Os produtores enviam registros para os fluxos do Firehose. Por exemplo, um servidor Web que envia dados de log para um fluxo do Firehose é um produtor de dados. Você também pode configurar o fluxo do Firehose para ler automaticamente os dados de um fluxo de dados existente do Kinesis e carregá-lo nos destinos. Para obter mais informações, consulte Envio de dados a um fluxo do Firehose.

- Tamanho e intervalo de buffer

-

O Amazon Data Firehose armazena em buffer os dados de streaming recebidos até um determinado tamanho ou por um determinado período antes de entregá-los aos destinos. O Buffer Size é em MBs e o Buffer Interval é em segundos.

Noções básicas sobre o fluxo de dados no Amazon Data Firehose

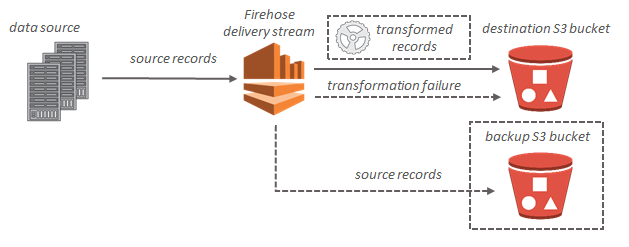

Para destinos do Amazon S3, os dados em streaming são entregues no bucket do S3. Se a transformação de dados estiver habilitada, você também poderá fazer backup dos dados da fonte em outro bucket do Amazon S3.

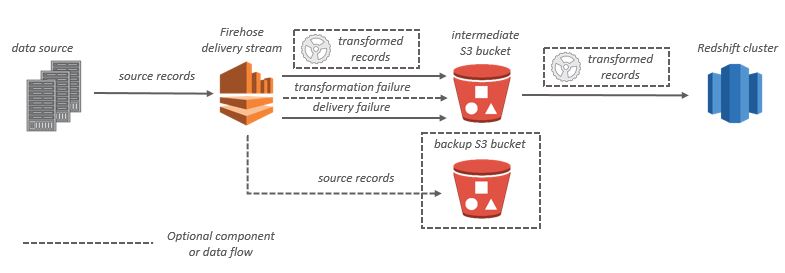

Para os destinos do Amazon Redshift, os dados em streaming são entregues primeiro no bucket do S3. Depois, o Amazon Data Firehose emite um comando COPY do Amazon Redshift para carregar os dados do bucket do S3 no cluster provisionado do Amazon Redshift. Se a transformação de dados estiver habilitada, você também poderá fazer backup dos dados da fonte em outro bucket do Amazon S3.

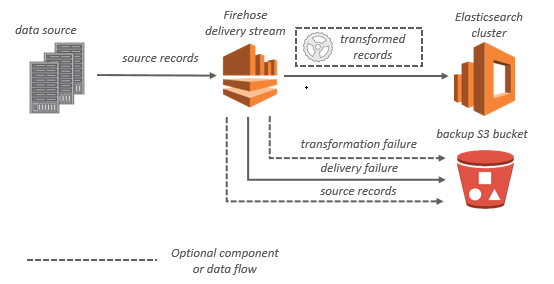

Para destinos no OpenSearch Service, os dados em streaming são entregues ao cluster do OpenSearch Service e você tem a opção de fazer backup desses dados em um bucket do S3 simultaneamente.

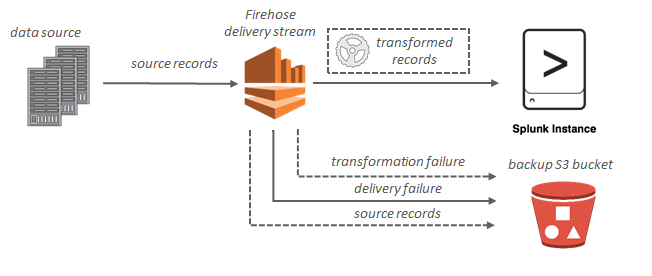

Para destinos do Splunk, os dados em streaming são entregues ao Splunk e eles podem ser submetidos a backup no bucket do S3 simultaneamente, se você desejar.