As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Armazenamento em cache de prompts para agilizar a inferência do modelo

nota

O armazenamento em cache de prompts do Amazon Bedrock geralmente está disponível no Claude 3.7 Sonnet, Claude 3.5 Haiku, Amazon Nova Micro, Amazon Nova Lite, Amazon Nova Pro e Amazon Nova Premier. Os clientes que receberam acesso ao Claude 3.5 Sonnet v2 durante versão prévia do armazenamento em cache de prompts manterão o acesso, mas nenhum cliente adicional terá acesso ao armazenamento em cache de prompts no modelo Claude 3.5 Sonnet v2.

O armazenamento em cache de prompts é um recurso opcional que você pode usar com modelos compatíveis no Amazon Bedrock para reduzir a latência da resposta de inferência e os custos de token de entrada. Ao adicionar partes do contexto a um cache, o modelo pode utilizar o cache para ignorar o recálculo das entradas, permitindo que o Bedrock se beneficie da economia de computação e reduza a latência das respostas.

O armazenamento em cache de prompts pode ajudar quando você tem workloads com contextos longos e repetidos que são frequentemente reutilizados para várias consultas. Por exemplo, se você tiver um chatbot em que os usuários possam fazer upload de documentos e fazer perguntas a esses documentos, o modelo pode demorar para processá-los sempre que o usuário fornecer entradas. Com o armazenamento em cache de prompts, é possível armazenar um documento em cache para que futuras consultas contendo o documento não precisem reprocessá-lo.

Ao usar o armazenamento em cache de prompts, é aplicada uma taxa de cobrança reduzida pelos tokens lidos do cache. Dependendo do modelo, pode ser aplicada uma taxa de cobrança mais alta aos tokens gravados em cache do que a dos tokens de entrada não armazenados em cache. Todos os tokens não lidos ou gravados em cache são cobrados de acordo com a taxa de token de entrada padrão desse modelo. Para obter mais informações, consulte a página de preços do Amazon Bedrock

Como funciona

Se você optar por usar o armazenamento em cache de prompts, o Amazon Bedrock criará um cache composto de pontos de verificação de cache. Esses são marcadores que definem a subseção contígua do prompt que você deseja armazenar em cache (geralmente chamada de prefixo do prompt). Esses prefixos de prompt devem ser estáticos entre as solicitações. Alterações no prefixo do prompt em solicitações subsequentes resultarão em ausências no cache.

Os pontos de verificação de cache têm um número mínimo e máximo de tokens, dependendo do modelo específico que você está usando. Só é possível criar um ponto de verificação de cache se o prefixo total do prompt atender ao número mínimo de tokens. Por exemplo, o modelo Claude 3.7 Sonnet da Anthropic requer pelo menos 1.024 tokens por ponto de verificação de cache. Isso significa que seu primeiro ponto de verificação de cache pode ser definido após 1.024 tokens e seu segundo ponto de verificação de cache pode ser definido após 2.048 tokens. Se você tentar adicionar um ponto de verificação de cache antes de atingir o número mínimo de tokens, a inferência ainda assim será bem-sucedida, mas o prefixo não será armazenado em cache. O cache tem uma vida útil (TTL) de cinco minutos, que é reiniciada a cada acerto de cache. Durante esse período, o contexto no cache é preservado. Se nenhum acerto de cache ocorrer na janela de TTL, o cache expirará.

Você pode usar o armazenamento em cache de prompts sempre que obtiver inferência do modelo no Amazon Bedrock para modelos compatíveis. Os seguintes recursos do Amazon Bedrock permitem usar o armazenamento em cache de prompts:

- Converse e ConverseStream APIs

-

Você pode manter uma conversa com um modelo em que especifica pontos de verificação de cache em seus prompts.

- InvokeModel e InvokeModelWithResponseStream APIs

-

Você pode enviar solicitações de prompt único nas quais habilita o armazenamento em cache de prompts e especifica os pontos de verificação de cache.

- Armazenamento em cache de prompts com inferência entre regiões

-

O armazenamento em cache de prompts pode ser usado em conjunto com a inferência entre regiões. A inferência entre regiões seleciona automaticamente a AWS região ideal em sua geografia para atender à sua solicitação de inferência, maximizando assim os recursos disponíveis e a disponibilidade do modelo. Em momentos de alta demanda, essas otimizações podem aumentar as gravações em cache.

- Gerenciamento de Prompts do Amazon Bedrock

-

Ao criar ou modificar um prompt, você pode optar por ativar o armazenamento em cache de prompts. Dependendo do modelo, é possível armazenar em cache os prompts do sistema, as instruções do sistema e as mensagens (usuário e assistente). Também é possível optar por desabilitar o armazenamento em cache de prompts.

Eles APIs fornecem a você a maior flexibilidade e controle granular sobre o cache de solicitações. É possível definir um ponto de verificação de cache individual nos prompts. Você pode ampliar o cache criando mais pontos de verificação de cache, até o número máximo de pontos de verificação de cache permitido para o modelo em questão. Para obter mais informações, consulte Modelos, regiões e limites oferecidos.

Modelos, regiões e limites oferecidos

A tabela a seguir lista os modelos compatíveis, bem como os tokens mínimos, o número máximo de pontos de verificação de cache e os campos que permitem pontos de verificação de cache.

| Nome do modelo | ID do modelo | Tipo de versão | Número mínimo de tokens por ponto de verificação de cache | Número máximo de pontos de verificação de cache por solicitação | Campos que aceitam pontos de verificação de armazenamento em cache de prompts |

|---|---|---|---|---|---|

Claude Opus4.5 |

antropic.claude-opus-4-5-20251101-v 1:0 |

Disponível para o público |

4.096 |

4 |

“system”, “messages” e “tools” |

Claude Opus4.1 |

anthropic.claude-opus-4-1-20250805-v1:0 |

Disponível para o público |

1,024 |

4 |

“system”, “messages” e “tools” |

Claude Opus 4 |

anthropic.claude-opus-4-20250514-v1:0 |

Disponível para o público |

1,024 |

4 |

“system”, “messages” e “tools” |

Claude Sonnet 4.5 |

anthropic.claude-sonnet-4-5-20250929-v1:0 |

Disponível para o público |

1,024 |

4 |

“system”, “messages” e “tools” |

Claude Haiku 4.5 |

anthropic.claude-haiku-4-5-20251001-v1:0 |

Disponível para o público |

4.096 |

4 |

“system”, “messages” e “tools” |

Claude Sonnet 4 |

anthropic.claude-sonnet-4-20250514-v1:0 |

Disponível para o público |

1,024 |

4 |

“system”, “messages” e “tools” |

Claude 3.7 Sonnet |

anthropic.claude-3-7-sonnet-20250219-v 1:0 |

Disponível para o público |

1,024 |

4 |

“system”, “messages” e “tools” |

Claude 3.5 Haiku |

anthropic.claude-3-5-haiku-20241022-v1:0 |

Disponível para o público |

2.048 |

4 |

“system”, “messages” e “tools” |

Claude 3.5 Sonnet v2 |

anthropic.claude-3-5-sonnet-20241022-v2:0 |

Demonstração |

1,024 |

4 |

“system”, “messages” e “tools” |

Amazon Nova Micro |

amazônia. nova-micro-v1:0 |

Disponível ao público |

1.0001 |

4 |

“system” e “messages” |

Amazon Nova Lite |

amazônia. nova-lite-v1:0 |

Disponível ao público |

1.0001 |

4 |

“system” e “messages”2 |

Amazon Nova Pro |

amazônia. nova-pro-v1:0 |

Disponível ao público |

1.0001 |

4 |

“system” e “messages”2 |

Amazon Nova Premier |

amazônia. nova-premier-v1:0 |

Disponível ao público |

1.0001 |

4 |

“system” e “messages”2 |

1. Os modelos do Amazon Nova comportam no máximo 20 mil tokens para armazenamento em cache de prompts.

2. O armazenamento em cache de prompts destina-se principalmente a solicitações de texto.

O Amazon Nova oferece armazenamento em cache de prompts automático para todos os prompts de texto, inclusive para mensagens User e System. Esse mecanismo pode fornecer benefícios de latência quando os prompts começam com partes repetitivas, mesmo sem configuração explícita. No entanto, para reduzir os custos e garantir benefícios de desempenho mais consistentes, recomendamos optar pelo armazenamento em cache de prompts explícito.

Gerenciamento de cache simplificado para modelos Claude

Para os modelos Claude, o Amazon Bedrock oferece uma abordagem simplificada para o gerenciamento de cache que reduz a complexidade da colocação manual de pontos de verificação de cache. Em vez de exigir que você especifique os locais exatos dos pontos de verificação de cache, é possível usar o gerenciamento de cache automático com um único ponto de interrupção no final do conteúdo estático.

Ao habilitar o gerenciamento de cache simplificado, o sistema verifica automaticamente os acertos de cache nos limites anteriores do bloco de conteúdo, analisando aproximadamente vinte blocos de conteúdo a partir do ponto de interrupção especificado. Isso permite que o modelo encontre o prefixo correspondente mais longo do cache sem exigir que você preveja os locais ideais dos pontos de verificação. Para usar isso, coloque um único ponto de verificação de cache no final do conteúdo estático, antes de qualquer conteúdo dinâmico ou variável. O sistema encontrará automaticamente a melhor correspondência de cache.

Para ter um controle mais granular, você ainda pode usar vários pontos de verificação de cache (até quatro para os modelos Claude) para especificar limites exatos de cache. Você deve usar vários pontos de verificação de cache se estiver armazenando seções que mudam em frequências diferentes ou se quiser ter maior controle sobre exatamente o que é armazenado em cache.

Importante

A verificação automática de prefixo só analisa aproximadamente vinte blocos de conteúdo do ponto de verificação de cache. Se o conteúdo estático ultrapassar esse intervalo, considere a possibilidade de usar vários pontos de verificação de cache ou reestruturar o prompt para colocar o conteúdo reutilizado com maior frequência dentro desse intervalo.

Introdução

As seções a seguir mostram uma breve visão geral de como usar o recurso de armazenamento em cache de prompts para cada método de interação com modelos por meio do Amazon Bedrock.

A API Converse oferece opções avançadas e flexíveis para implementar o armazenamento em cache de prompts em conversas de vários turnos. Para ter mais informações sobre os requisitos de prompt para cada modelo, consulte a seção anterior Modelos, regiões e limites oferecidos.

Exemplo de solicitação

Os exemplos a seguir mostram um ponto de verificação de cache definido nos campos messages, system ou tools de uma solicitação para a API Converse. É possível colocar pontos de verificação em qualquer um desses locais para uma determinada solicitação. Por exemplo, ao enviar uma solicitação ao modelo Claude 3.5 Sonnet v2, você pode colocar dois pontos de verificação de cache em messages, um ponto de verificação de cache em system e um em tools. Para ter informações mais detalhadas e exemplos de estruturação e envio de solicitações de API Converse, consulte Realizar uma conversa com as operações de API Converse.

A resposta do modelo da API Converse inclui dois novos campos que são específicos para o armazenamento em cache de prompts. Os valores CacheReadInputTokens e CacheWriteInputTokens informam quantos tokens foram lidos do cache e quantos tokens foram gravados no cache em resposta à sua solicitação anterior. Esses são os valores com base nos quais o Amazon Bedrock aplica cobranças, a uma taxa inferior ao custo de inferência de modelo completa.

O cache de prompts é ativado por padrão quando você chama a InvokeModelAPI. Você pode definir pontos de verificação de cache em qualquer ponto do corpo da solicitação, de modo semelhante ao exemplo anterior da API Converse.

Para obter mais informações sobre o envio de uma InvokeModel solicitação, consulteEnvie uma única solicitação com InvokeModel.

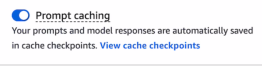

Em um playground de chat no console do Amazon Bedrock, é possível ativar a opção de armazenamento em cache de prompts para que o Amazon Bedrock crie automaticamente pontos de verificação de cache para você.

Siga as instruções em Gerar respostas no console usando playgrounds para começar a usar prompts em um playground do Amazon Bedrock. Para modelos compatíveis, o armazenamento em cache de prompts é ativado automaticamente no playground. No entanto, se não estiver, faça o seguinte para ativá-lo:

-

No painel lateral esquerdo, abra o menu Configurações.

-

Ative o botão Armazenamento em cache de prompts.

-

Execute seus prompts.

Depois que as entradas e respostas do modelo atingem, em conjunto, o número mínimo necessário de tokens para um ponto de verificação (que varia de acordo com o modelo), o Amazon Bedrock cria automaticamente o primeiro ponto de verificação de cache para você. Conforme o chat continua, a cada vez subsequente que o número mínimo de tokens é atingido, é criado um ponto de verificação, até o número máximo de pontos de verificação permitido para o modelo. É possível visualizar os pontos de verificação de cache a qualquer momento escolhendo Visualizar pontos de verificação de cache ao lado do botão Armazenamento em cache de prompts, conforme mostrado na captura de tela a seguir.

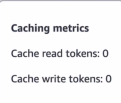

É possível ver quantos tokens estão sendo lidos e gravados no cache em resposta a cada interação com o modelo visualizando o pop-up Métricas de cache (

![]() ) nas respostas do playground.

) nas respostas do playground.

Se você desativar o botão de armazenamento em cache de prompts no meio de uma conversa, poderá continuar conversando com o modelo.