翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

SageMaker HyperPod レシピ

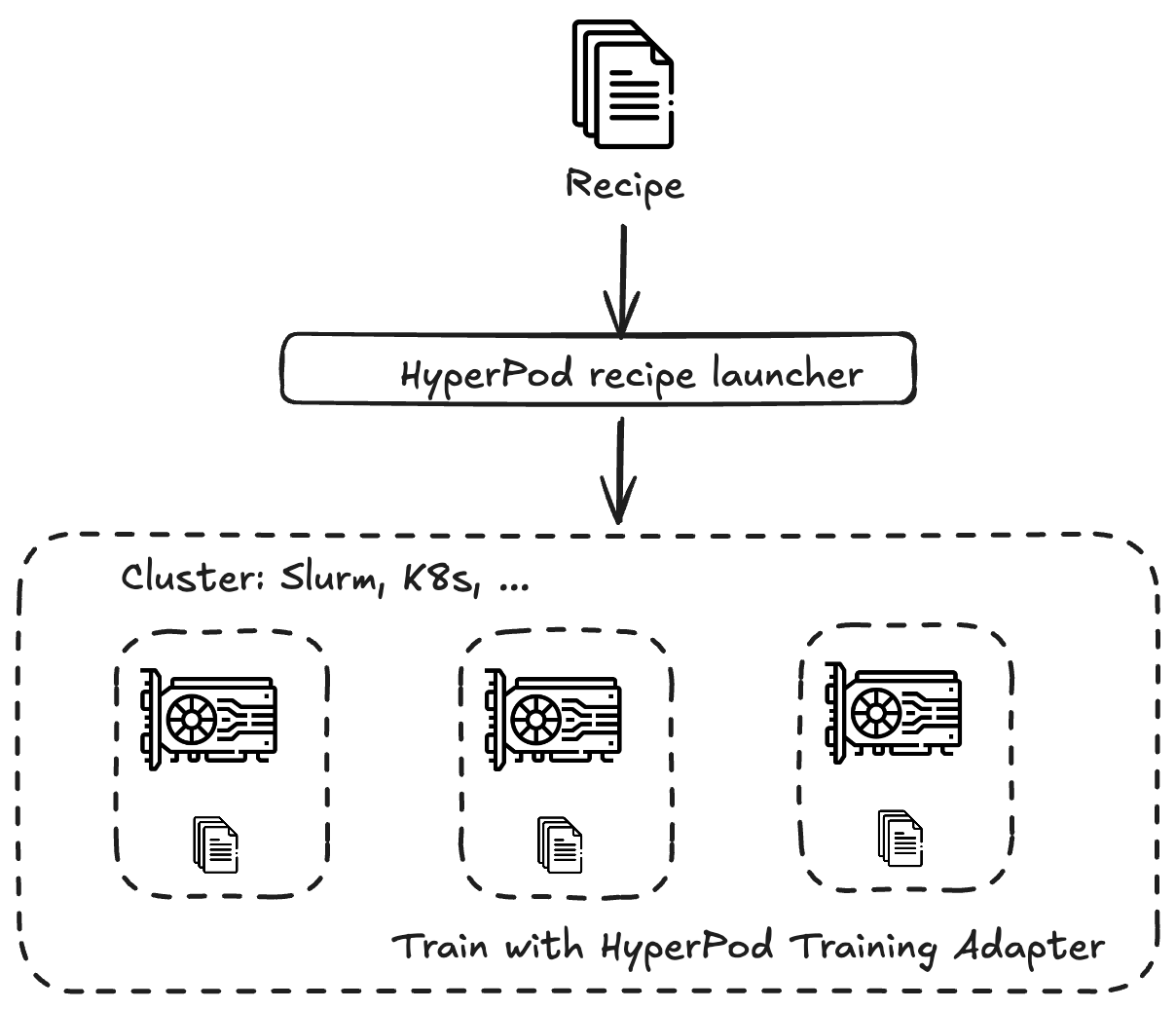

Amazon SageMaker HyperPod レシピは、Llama、Mistral、Mixtral、DeepSeek などのさまざまなモデルファミリーから公開されている基盤モデル (FMs) のトレーニングと微調整をすばやく開始AWSできるように、 が提供する事前設定されたトレーニングスタックです。レシピは、データセットのロード、分散トレーニング手法の適用、チェックポイントの管理など、エンドツーエンドのトレーニングループを自動化して、障害からの迅速な復旧を実現します。

SageMaker HyperPod レシピは、大規模なモデルのトレーニングに伴う複雑さの大部分を抽象化するため、深層機械学習の専門知識がないユーザーにとって特に有益です。

レシピは、SageMaker HyperPod 内で、または SageMaker トレーニングジョブとして実行できます。

次の表は SageMaker HyperPod GitHub リポジトリに保持されており、事前トレーニングとファインチューニングでサポートされているモデル、それぞれのレシピと起動スクリプト、サポートされているインスタンスタイプなどに関する最新の情報を提供しています。

-

事前トレーニングでサポートされているモデル、レシピ、起動スクリプトの最新リストについては、「事前トレーニングの表

」を参照してください。 -

事前トレーニングでサポートされているモデル、レシピ、起動スクリプトの最新リストについては、「ファインチューニングの表

」を参照してください。

SageMaker HyperPod を使用する場合、エンドツーエンドのトレーニングワークフローの自動化は、トレーニングアダプタと SageMaker HyperPod レシピの統合により提供されます。トレーニングアダプタは、NVIDIA NeMo フレームワーク

独自のカスタムレシピを定義して、独自のモデルをトレーニングすることもできます。

チュートリアルを使用して使用を開始するには、「チュートリアル」を参照してください。