翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

生成 AI エージェント: シンボリックロジックを LLMs

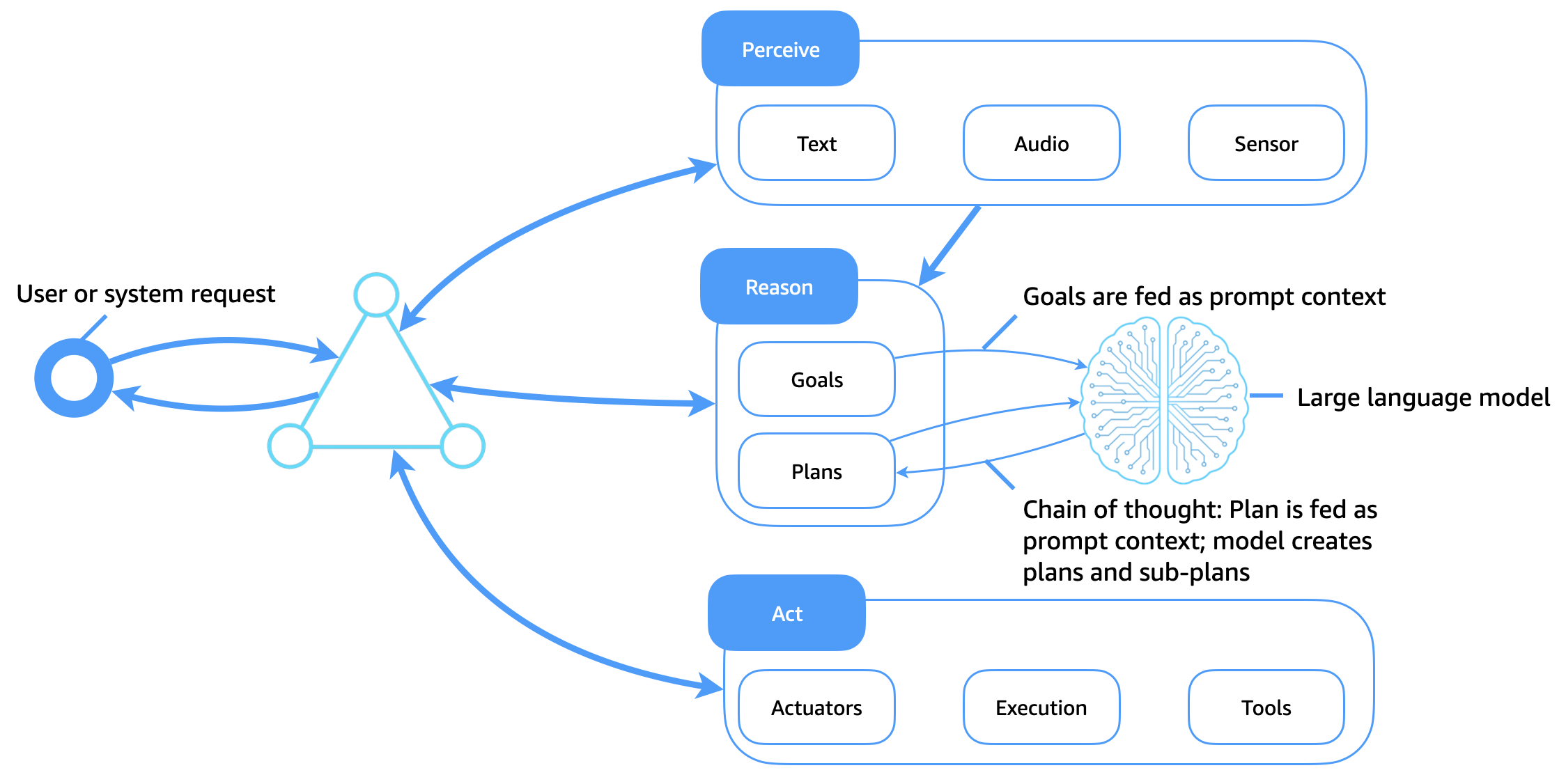

次の図は、大規模言語モデル (LLMs) がソフトウェアエージェントの柔軟でインテリジェントなコグニティブコアとしてどのように機能するかを示しています。静的プランライブラリとハンドコードされたルールに依存する従来のシンボリックロジックシステムとは異なり、LLMs適応的推論、コンテキストプランニング、動的ツールの使用を可能にし、エージェントが認識、理由、行動する方法を変換します。

主な機能強化

このアーキテクチャは、従来のエージェントアーキテクチャを次のように強化します。

-

認識エンジンとしての LLMs: 目標、計画、クエリは プロンプトコンテキストとしてモデルに渡されます。LLM は推論パス (思考の連鎖など) を生成し、タスクをサブ目標に分解して、次のアクションを決定します。

-

プロンプトによるツールの使用: LLMs は、ツールの使用エージェント、または APIs を呼び出し、出力を検索、クエリ、計算、解釈するための推論とアクション (ReAct) プロンプトを通じて指示できます。

-

コンテキスト対応計画: エージェントは、ハードコードされた計画ライブラリを必要とせずに、エージェントの現在の目標、入力環境、フィードバックに基づいて計画を動的に生成または修正します。

-

プロンプトコンテキストをメモリとして: シンボリックナレッジベースを使用する代わりに、エージェントはメモリ、計画、目標をモデルに渡されるプロンプトトークンとしてエンコードします。

-

数ショットのコンテキスト内学習による学習: LLMsプロンプトエンジニアリングを通じて動作を適応させるため、明示的な再トレーニングやリジッドプランライブラリの必要性が軽減されます。

LLM ベースのエージェントの長期メモリの達成

構造化ナレッジベースに長期メモリを保存していた従来のエージェントとは異なり、生成 AI エージェントは LLMs のコンテキストウィンドウの制限内で動作する必要があります。メモリを拡張し、永続的なインテリジェンスをサポートするために、生成 AI エージェントは、エージェントストア、検索拡張生成 (RAG)、コンテキスト内学習とプロンプト連鎖、事前トレーニングなど、いくつかの補完的な手法を使用します。

エージェントストア: 外部長期メモリ

エージェントの状態、ユーザー履歴、決定、結果は、長期エージェントメモリストア (ベクトルデータベース、オブジェクトストア、ドキュメントストアなど) に保存されます。関連するメモリはオンデマンドで取得され、実行時に LLM プロンプトコンテキストに挿入されます。これにより、永続的なメモリループが作成され、エージェントはセッション、タスク、またはインタラクション間で継続性を保持します。

RAG

RAG は、取得した知識を生成機能と組み合わせることで LLM のパフォーマンスを向上させます。目標またはクエリが発行されると、エージェントは検索インデックスを検索します (たとえば、ドキュメントのセマンティック検索、以前の会話、構造化された知識など)。取得した結果は LLM プロンプトに追加され、外部ファクトまたはパーソナライズされたコンテキストに基づいて生成されます。この方法では、エージェントの有効なメモリが拡張され、信頼性と事実の正確性が向上します。

コンテキスト内学習とプロンプト連鎖

エージェントは、セッション内のトークンコンテキストと構造化されたプロンプトチェイニングを使用して、短期的なメモリを維持します。現在の計画、以前のアクション結果、エージェントステータスなどのコンテキスト要素は、動作をガイドするために呼び出し間で渡されます。

継続的な事前トレーニングと微調整

ドメイン固有のエージェントの場合、LLMs はログ、エンタープライズデータ、製品ドキュメントなどのカスタムコレクションで引き続き事前トレーニングできます。または、ヒューマンフィードバック (RLHF) からの命令ファインチューニングまたは強化学習は、エージェントのような動作をモデルに直接埋め込むことができます。これにより、推論パターンがプロンプト時間ロジックからモデルの内部表現に移行し、プロンプトの長さが短縮され、効率が向上します。

エージェント AI の利点の組み合わせ

これらの手法を併用すると、生成 AI エージェントは次のことが可能になります。

-

経時的なコンテキスト認識を維持します。

-

ユーザー履歴または設定に基づいて動作を適応させます。

-

up-to-date、事実、またはプライベートな知識を使用して意思決定を行います。

-

永続的、準拠、説明可能な動作でエンタープライズユースケースにスケールします。

外部メモリ、取り出しレイヤー、継続的なトレーニングで LLMs を強化することで、エージェントはシンボリックシステムだけでは達成できなかったレベルの認知継続性と目的を達成できます。