Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Agenti di intelligenza artificiale generativa: sostituiscono la logica simbolica con LLMs

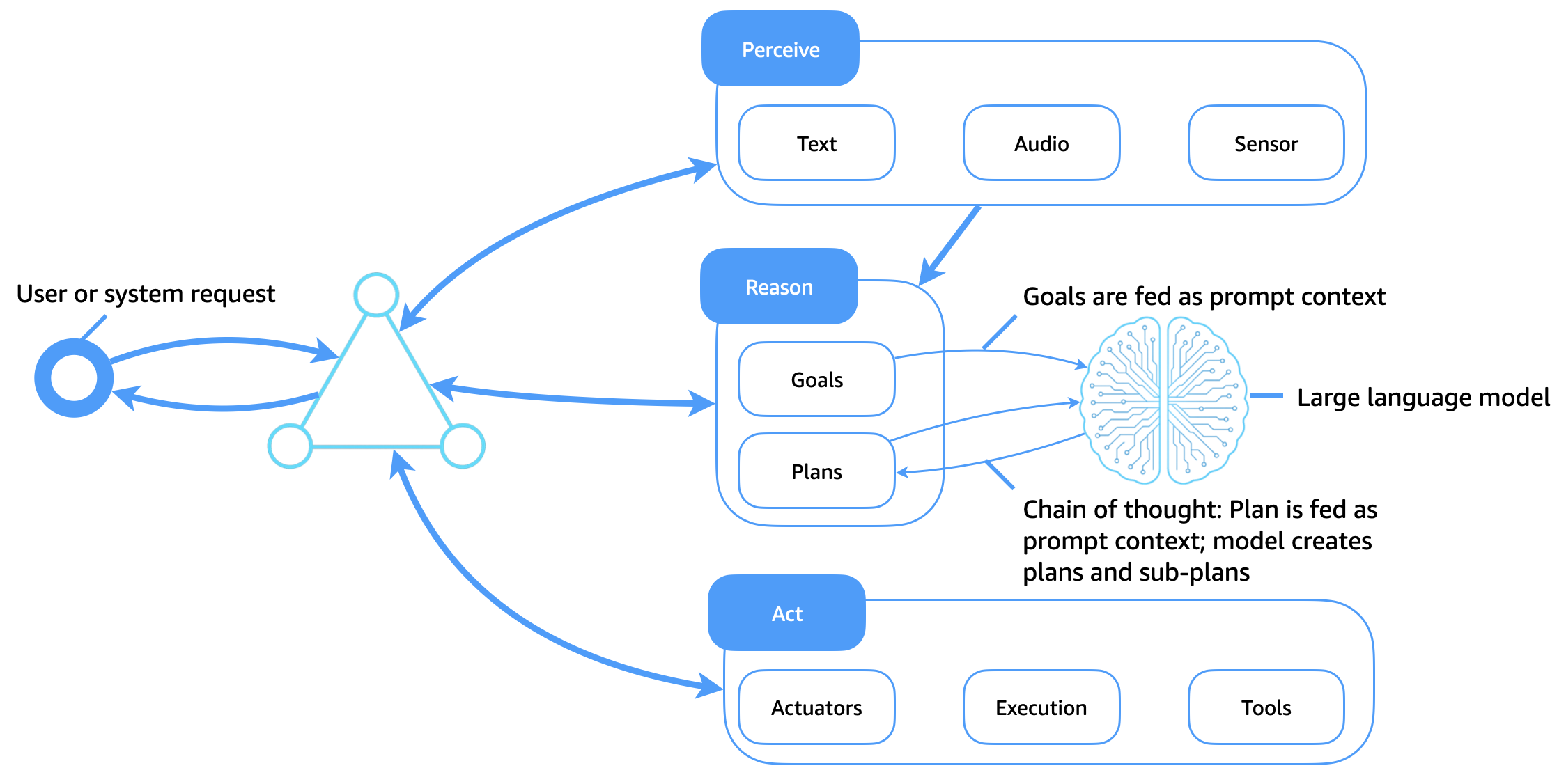

Il diagramma seguente illustra come i modelli linguistici di grandi dimensioni (LLMs) fungano ora da nucleo cognitivo flessibile e intelligente per gli agenti software. A differenza dei tradizionali sistemi logici simbolici, che si basano su librerie di piani statiche e regole codificate manualmente, LLMs consentono il ragionamento adattivo, la pianificazione contestuale e l'uso dinamico degli strumenti, che trasformano il modo in cui gli agenti percepiscono, ragionano e agiscono.

Miglioramenti chiave

Questa architettura migliora l'architettura tradizionale degli agenti come segue:

-

LLMs come motori cognitivi: gli obiettivi, i piani e le domande vengono passati al modello come contesto immediato. L'LLM genera percorsi di ragionamento (come la catena di pensiero), scompone le attività in obiettivi secondari e decide le azioni successive.

-

Utilizzo dello strumento tramite richiesta: LLMs può essere indirizzato tramite agenti di utilizzo dello strumento o ragionamento e azione (ReAct) che richiedono di chiamare e cercare, interrogare, calcolare APIs e interpretare gli output.

-

Pianificazione sensibile al contesto: gli agenti generano o rivedono i piani in modo dinamico in base all'obiettivo attuale, all'ambiente di input e al feedback dell'agente, senza richiedere librerie di piani codificate.

-

Richiedi il contesto come memoria: invece di utilizzare basi di conoscenza simboliche, gli agenti codificano la memoria, i piani e gli obiettivi come token di richiesta che vengono passati al modello.

-

Apprendimento mediante un apprendimento contestuale in pochi passaggi: LLMs adattate i comportamenti mediante una progettazione tempestiva, che riduce la necessità di riqualificazione esplicita o di rigide librerie di piani.

Raggiungere una memoria a lungo termine negli agenti basati su LLM

A differenza degli agenti tradizionali, che immagazzinavano la memoria a lungo termine in basi di conoscenza strutturate, gli agenti di intelligenza artificiale generativa devono funzionare entro i limiti della finestra di contesto di. LLMs Per estendere la memoria e supportare l'intelligenza persistente, gli agenti di intelligenza artificiale generativa utilizzano diverse tecniche complementari: agent store, Retrieval-Augmented Generation (RAG), apprendimento contestuale e concatenamento rapido e preformazione.

Agent store: memoria esterna a lungo termine

Lo stato dell'agente, la cronologia degli utenti, le decisioni e i risultati vengono archiviati in un archivio di memoria a lungo termine per agenti (ad esempio un database vettoriale, un archivio di oggetti o un archivio di documenti). Le memorie pertinenti vengono recuperate su richiesta e inserite nel contesto del prompt LLM in fase di esecuzione. Questo crea un ciclo di memoria persistente, in cui l'agente mantiene la continuità tra sessioni, attività o interazioni.

STRACCIO

RAG migliora le prestazioni LLM combinando le conoscenze recuperate con capacità generative. Quando viene emesso un obiettivo o una richiesta, l'agente cerca un indice di recupero (ad esempio, tramite una ricerca semantica di documenti, conversazioni precedenti o conoscenze strutturate). I risultati recuperati vengono aggiunti al prompt LLM, che basa la generazione su fatti esterni o su un contesto personalizzato. Questo metodo estende la memoria effettiva dell'agente e migliora l'affidabilità e la correttezza dei fatti.

Apprendimento contestuale e concatenamento rapido

Gli agenti mantengono la memoria a breve termine utilizzando il contesto dei token all'interno della sessione e il concatenamento strutturato dei prompt. Gli elementi contestuali, come il piano attuale, i risultati delle azioni precedenti e lo stato dell'agente, vengono trasmessi tra le chiamate per guidare il comportamento.

Preformazione e perfezionamento continui

Per gli agenti specifici del dominio, è LLMs possibile continuare la formazione preliminare su raccolte personalizzate come registri, dati aziendali o documentazione di prodotto. In alternativa, la messa a punto delle istruzioni o l'apprendimento per rinforzo basato sul feedback umano (RLHF) possono incorporare un comportamento simile a quello di un agente direttamente nel modello. Ciò sposta i modelli di ragionamento dalla logica del momento immediato alla rappresentazione interna del modello, riduce la lunghezza dei prompt e migliora l'efficienza.

Vantaggi combinati dell'intelligenza artificiale agentica

Queste tecniche, se utilizzate insieme, consentono agli agenti di intelligenza artificiale generativa di:

-

Mantieni la consapevolezza contestuale nel tempo.

-

Adatta il comportamento in base alla cronologia o alle preferenze degli utenti.

-

Prendi decisioni utilizzando up-to-date conoscenze concrete o private.

-

Adattate ai casi d'uso aziendali con comportamenti persistenti, conformi e spiegabili.

LLMs Grazie all'utilizzo della memoria esterna, ai livelli di recupero e alla formazione continua, gli agenti possono raggiungere un livello di continuità cognitiva e uno scopo che non poteva essere raggiunto in precedenza attraverso i soli sistemi simbolici.