Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Creazione di guardrail IA per Amazon Q in Connect

Un guardrail IA è una risorsa che consente di implementare misure di protezione basate sui casi d’uso e sulle policy di IA responsabile.

Amazon Connect utilizza i guardrail Amazon Bedrock. Puoi creare e modificare questi guardrail nel sito web di amministrazione Amazon Connect .

Indice

Informazioni importanti

-

È possibile creare fino a tre guardrail personalizzati.

-

I guardrail Amazon Q in Connect supportano le stesse lingue dei guardrail di livello classico di Amazon Bedrock. Per un elenco delle lingue supportate, consulta Lingue supportate dai guardrail di Amazon Bedrock. La valutazione del contenuto testuale in altre lingue sarà inefficace.

-

Quando configuri o modifichi un guardrail, ti consigliamo vivamente di sperimentare e confrontare configurazioni diverse. È possibile che alcune delle tue combinazioni abbiano conseguenze indesiderate. Prova il guardrail per assicurarti che i risultati soddisfino i requisiti del caso d’uso.

Come creare un guardrail IA

-

Accedi al sito Web di Amazon Connect amministrazione con un account con Amazon Q, AI guardrails - Crea l'autorizzazione nel suo profilo di sicurezza.

-

Nel sito web di Amazon Connect amministrazione, nel menu di navigazione a sinistra, scegli Amazon Q, AI guardrails.

-

Nella pagina Guardrail, scegli Crea guardrail.

-

Nella finestra di dialogo Crea guardrail IA, inserisci un nome e una descrizione del guardrail, quindi scegli Crea.

-

Nella pagina Builder dei guardrail IA, completa i seguenti campi secondo necessità per creare le policy relative al guardrail:

-

Filtri per contenuti: regola la potenza dei filtri per bloccare i prompt di input o modellare le risposte contenenti contenuti dannosi. Il filtraggio viene eseguito in base al rilevamento di alcune categorie di contenuti dannosi predefinite: odio, insulti, sesso, violenza, cattiva condotta e attacco di prompt.

-

Argomenti negati: definisci una serie di argomenti indesiderati nel contesto della tua applicazione. Il filtro aiuterà a bloccarli se rilevati nelle domande degli utenti o nelle risposte del modello. È possibile aggiungere fino a 30 argomenti negati.

-

Verifica contestuale della base: aiuta a rilevare e filtrare le allucinazioni nelle risposte del modello in base alla provenienza e alla pertinenza della domanda dell’utente.

-

Filtri testuali: configura i filtri per bloccare parole, frasi e volgarità (corrispondenza esatta). Tali parole possono includere termini offensivi, nomi di concorrenti, ecc.

-

Filtri per informazioni sensibili: configura i filtri per bloccare o mascherare le informazioni sensibili, come le informazioni di identificazione personale (PII) o espressioni regolari personalizzate negli input degli utenti e nelle risposte del modello.

Il blocco o il mascheramento vengono eseguiti sulla base del rilevamento probabilistico di informazioni sensibili in formati standard in entità come numero SSN, data di nascita, indirizzo, ecc. Ciò consente anche di configurare il rilevamento dei modelli per gli identificatori basato su espressioni regolari.

-

Messaggi bloccati: personalizza il messaggio predefinito visualizzato all’utente se il guardrail blocca l’input o la risposta del modello.

Amazon Connect non supporta il Filtro dei contenuti delle immagini per aiutare a rilevare e filtrare contenuti di immagini inappropriati o tossici.

-

-

Quando il guardrail è completo, scegli Salva.

Quando si seleziona dal menu a discesa delle versioni, Latest:Draft restituisce sempre lo stato salvato del guardrail IA.

-

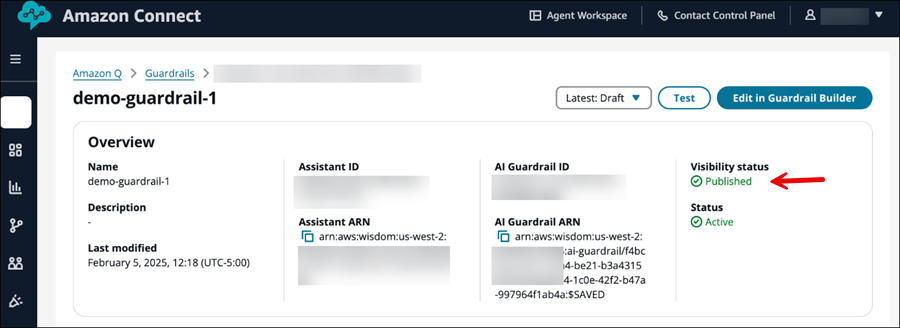

Seleziona Pubblica. Gli aggiornamenti al guardrail IA vengono salvati, lo stato di visibilità del guardrail IA è impostato su Pubblicato e viene creata una nuova versione di Guardrail IA.

Quando si seleziona dal menu a discesa delle versioni, Latest:Published restituisce sempre lo stato salvato del guardrail IA.

Modificare il messaggio di blocco predefinito

Questa sezione spiega come accedere al generatore e all’editor del guardrail IA nel sito web di amministrazione di Amazon Connect , utilizzando l’esempio della modifica del messaggio bloccato visualizzato agli utenti.

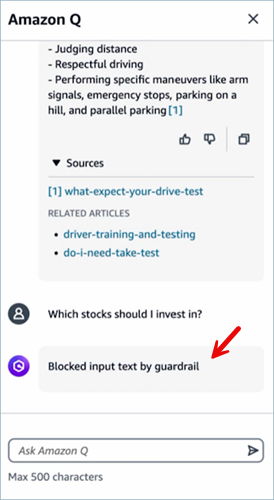

L’immagine seguente mostra un esempio del messaggio bloccato predefinito che viene visualizzato a un utente. Il messaggio predefinito è “Testo di input bloccato da guardrail”.

Come modificare il messaggio bloccato per impostazione predefinita

-

Accedi al sito web di Amazon Connect amministrazione all'indirizzo https://

instance name.my.connect.aws/. Usa un account amministratore o un account con Amazon Q - Guardrail IA - Crea l’autorizzazione nel suo profilo di sicurezza. -

Nel menu di navigazione, scegli Amazon Q, Guardrail IA.

-

Nella pagina Guardrail IA, scegli Crea guardrail IA. Viene visualizzata una finestra di dialogo per assegnare un nome e una descrizione.

-

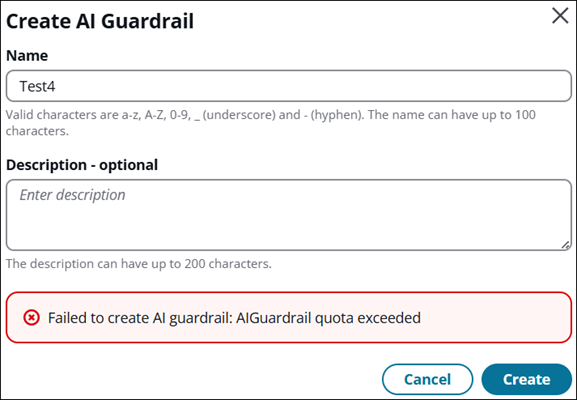

Nella finestra di dialogo Crea guardrail IA, immetti un nome e una descrizione per il gruppo e scegli Crea. Se la tua azienda dispone già di tre guardrail, verrà visualizzato un messaggio di errore, come mostrato nell’immagine seguente.

Se ricevi questo messaggio, anziché creare un altro guardrail, prendi in considerazione la possibilità di modificare un guardrail esistente per soddisfare le tue esigenze. In alternativa, eliminane uno in modo da poterne creare un altro.

-

Per modificare il messaggio predefinito visualizzato quando il guardrail blocca la risposta del modello, scorri fino alla sezione Messaggi bloccati.

-

Inserisci il testo del messaggio di blocco che desideri venga visualizzato, scegli Salva, quindi Pubblica.

Esempi di comandi della CLI per configurare le politiche di guardrail IA

Di seguito sono riportati alcuni esempi di come configurare le policy del guardrail IA utilizzando la AWS CLI.

Blocco degli argomenti indesiderati

Usa il seguente comando AWS CLI di esempio per bloccare argomenti indesiderati.

aws qconnect update-ai-guardrail --cli-input-json { "assistantId": "a0a81ecf-6df1-4f91-9513-3bdcb9497e32", "aiGuardrailId": "9147c4ad-7870-46ba-b6c1-7671f6ca3d95", "blockedInputMessaging": "Blocked input text by guardrail", "blockedOutputsMessaging": "Blocked output text by guardrail", "visibilityStatus": "PUBLISHED", "topicPolicyConfig": { "topicsConfig": [ { "name": "Financial Advice", "definition": "Investment advice refers to financial inquiries, guidance, or recommendations with the goal of generating returns or achieving specific financial objectives.", "examples": ["- Is investment in stocks better than index funds?", "Which stocks should I invest into?", "- Can you manage my personal finance?"], "type": "DENY" } ] } }

Filtraggio di contenuti dannosi e inappropriati

Utilizza il seguente comando AWS CLI di esempio per filtrare contenuti dannosi e inappropriati.

aws qconnect update-ai-guardrail --cli-input-json { "assistantId": "a0a81ecf-6df1-4f91-9513-3bdcb9497e32", "aiGuardrailId": "9147c4ad-7870-46ba-b6c1-7671f6ca3d95", "blockedInputMessaging": "Blocked input text by guardrail", "blockedOutputsMessaging": "Blocked output text by guardrail", "visibilityStatus": "PUBLISHED", "contentPolicyConfig": { "filtersConfig": [ { "inputStrength": "HIGH", "outputStrength": "HIGH", "type": "INSULTS" } ] } }

Filtraggio di parole dannose e inappropriate

Utilizza il seguente comando AWS CLI di esempio per filtrare parole dannose e inappropriate.

aws qconnect update-ai-guardrail --cli-input-json { "assistantId": "a0a81ecf-6df1-4f91-9513-3bdcb9497e32", "aiGuardrailId": "9147c4ad-7870-46ba-b6c1-7671f6ca3d95", "blockedInputMessaging": "Blocked input text by guardrail", "blockedOutputsMessaging": "Blocked output text by guardrail", "visibilityStatus": "PUBLISHED", "wordPolicyConfig": { "wordsConfig": [ { "text": "Nvidia", }, ] } }

Rilevamento delle allucinazioni nella risposta del modello

Usa il seguente comando AWS CLI di esempio per rilevare allucinazioni nella risposta del modello.

aws qconnect update-ai-guardrail --cli-input-json { "assistantId": "a0a81ecf-6df1-4f91-9513-3bdcb9497e32", "aiGuardrailId": "9147c4ad-7870-46ba-b6c1-7671f6ca3d95", "blockedInputMessaging": "Blocked input text by guardrail", "blockedOutputsMessaging": "Blocked output text by guardrail", "visibilityStatus": "PUBLISHED", "contextualGroundPolicyConfig": { "filtersConfig": [ { "type": "RELEVANCE", "threshold": 0.50 }, ] } }

Oscurare informazioni sensibili

Utilizza il seguente comando AWS CLI di esempio per oscurare informazioni sensibili come le informazioni personali identificabili (PII).

aws qconnect update-ai-guardrail --cli-input-json { "assistantId": "a0a81ecf-6df1-4f91-9513-3bdcb9497e32", "aiGuardrailId": "9147c4ad-7870-46ba-b6c1-7671f6ca3d95", "blockedInputMessaging": "Blocked input text by guardrail", "blockedOutputsMessaging": "Blocked output text by guardrail", "visibilityStatus": "PUBLISHED", "sensitiveInformationPolicyConfig": { "piiEntitiesConfig": [ { "type": "CREDIT_DEBIT_CARD_NUMBER", "action":"BLOCK", }, ] } }