Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Gestion des dépendances Python dans requirements.txt

Cette rubrique explique comment installer et gérer les dépendances Python dans un requirements.txt fichier pour un environnement Amazon Managed Workflows for Apache Airflow.

Table des matières

Installation de dépendances Python à l'aide du format de fichier d'exigences PyPi .org

Erreurs d'accès dans l'interface utilisateur d'Apache Airflow

Tests DAGs à l'aide de l'utilitaire Amazon MWAA CLI

-

L'utilitaire d'interface de ligne de commande (CLI) reproduit localement un environnement Amazon Managed Workflows pour Apache Airflow.

-

La CLI crée localement une image de conteneur Docker similaire à une image de production Amazon MWAA. Vous pouvez l'utiliser pour exécuter un environnement Apache Airflow local afin de développer et de tester DAGs des plugins personnalisés et des dépendances avant le déploiement sur Amazon MWAA.

-

Pour exécuter la CLI, reportez-vous à la section aws-mwaa-docker-images

on GitHub.

Installation de dépendances Python à l'aide du format de fichier d'exigences PyPi .org

La section suivante décrit les différentes manières d'installer les dépendances Python conformément au format de fichier d'exigences PyPi

Option 1 : dépendances Python à partir de l'index des packages Python

La section suivante décrit comment spécifier les dépendances Python à partir de l'index des packages Pythonrequirements.txt fichier.

Deuxième option : roues Python (.whl)

Une roue Python est un format de package conçu pour expédier des bibliothèques contenant des artefacts compilés. Les packages Wheel présentent plusieurs avantages en tant que méthode d'installation de dépendances dans Amazon MWAA :

-

Installation plus rapide : les fichiers WHL sont copiés dans le conteneur sous la forme d'un seul fichier ZIP, puis installés localement, sans qu'il soit nécessaire de les télécharger.

-

Moins de conflits : vous pouvez déterminer à l'avance la compatibilité des versions de vos packages. Par conséquent, il n'est pas nécessaire de trouver

pipde manière récursive des versions compatibles. -

Plus de résilience : avec les bibliothèques hébergées en externe, les exigences en aval peuvent changer, ce qui entraîne une incompatibilité des versions entre les conteneurs d'un environnement Amazon MWAA. En ne dépendant pas d'une source externe pour les dépendances, chaque conteneur possède les mêmes bibliothèques, quel que soit le moment où chaque conteneur est instancié.

Nous recommandons les méthodes suivantes pour installer les dépendances Python à partir d'une archive Python Wheel (.whl) dans votrerequirements.txt.

Méthodes

Utilisation du plugins.zip fichier dans un compartiment Amazon S3

Le planificateur, les outils de traitement et le serveur Web d'Apache Airflow (pour Apache Airflow v2.2.2 et versions ultérieures) recherchent des plugins personnalisés lors du démarrage sur le conteneur Fargate géré pour votre environnement à l'adresse. AWS/usr/local/airflow/plugins/ Ce processus commence avant Amazon MWAA *pip3 install -r requirements.txt pour les dépendances Python et le démarrage du service Apache Airflow. Un plugins.zip fichier peut être utilisé pour tous les fichiers que vous ne souhaitez pas modifier en permanence pendant l'exécution de l'environnement ou pour lesquels vous ne souhaitez pas accorder l'accès aux utilisateurs qui écrivent DAGs. Par exemple, les fichiers de roue de la bibliothèque Python, les fichiers PEM de certificats et les fichiers de configuration YAML.

La section suivante décrit comment installer une roue qui se trouve dans le plugins.zip fichier de votre compartiment Amazon S3.

-

Téléchargez les fichiers WHL nécessaires Vous pouvez les utiliser

pip downloadavec votre conteneur Amazon MWAA existant aws-mwaa-docker-images ou requirements.txtsur un autre conteneur Amazon Linux 2pour résoudre et télécharger les fichiers Python Wheel nécessaires. pip3 download -r "$AIRFLOW_HOME/dags/requirements.txt" -d "$AIRFLOW_HOME/plugins"cd "$AIRFLOW_HOME/plugins"zip "$AIRFLOW_HOME/plugins.zip" * -

Spécifiez le chemin dans votre

requirements.txt. Spécifiez le répertoire des plugins en haut de votre fichier requirements.txt en utilisant--find-linkset demandez de pipne pas les installer à partir d'autres sources en utilisant--no-index, comme indiqué dans le code suivant : --find-links /usr/local/airflow/plugins --no-indexExemple roue dans requirements.txt

L'exemple suivant suppose que vous avez chargé la roue dans un

plugins.zipfichier à la racine de votre compartiment Amazon S3. Par exemple :--find-links /usr/local/airflow/plugins --no-index numpyAmazon MWAA récupère la

numpy-1.20.1-cp37-cp37m-manylinux1_x86_64.whlrouepluginsdans le dossier et l'installe dans votre environnement.

Utilisation d'un fichier WHL hébergé sur une URL

La section suivante décrit comment installer une roue hébergée sur une URL. L'URL doit être accessible au public ou accessible depuis le VPC Amazon personnalisé que vous avez spécifié pour votre environnement Amazon MWAA.

-

Fournissez une URL. Fournissez l'URL d'une roue dans votre

requirements.txt.Exemple archive de roues sur une URL publique

L'exemple suivant télécharge une roue depuis un site public.

--find-links https://files.pythonhosted.org/packages/ --no-indexAmazon MWAA récupère la roue à partir de l'URL que vous avez spécifiée et l'installe dans votre environnement.

Note

URLs ne sont pas accessibles à partir de serveurs Web privés, exigences d'installation dans Amazon MWAA v2.2.2 et versions ultérieures.

Création d'un fichier WHL à partir d'un DAG

Si vous avez un serveur Web privé utilisant Apache Airflow v2.2.2 ou version ultérieure et que vous ne parvenez pas à installer les exigences car votre environnement n'a pas accès à des référentiels externes, vous pouvez utiliser le DAG suivant pour prendre vos exigences Amazon MWAA existantes et les intégrer à Amazon S3 :

from airflow import DAG from airflow.operators.bash_operator import BashOperator from airflow.utils.dates import days_ago S3_BUCKET = 'my-s3-bucket' S3_KEY = 'backup/plugins_whl.zip' with DAG(dag_id="create_whl_file", schedule_interval=None, catchup=False, start_date=days_ago(1)) as dag: cli_command = BashOperator( task_id="bash_command", bash_command=f"mkdir /tmp/whls;pip3 download -r /usr/local/airflow/requirements/requirements.txt -d /tmp/whls;zip -j /tmp/plugins.zip /tmp/whls/*;aws s3 cp /tmp/plugins.zip s3://amzn-s3-demo-bucket/{S3_KEY}" )

Après avoir exécuté le DAG, utilisez ce nouveau fichier comme Amazon MWAAplugins.zip, éventuellement, empaqueté avec d'autres plugins. Ensuite, mettez à jour votre requirements.txt liste précédée par --find-links /usr/local/airflow/plugins --no-index ou sans ajout--constraint.

Vous pouvez utiliser cette méthode pour utiliser les mêmes bibliothèques hors ligne.

Troisième option : dépendances Python hébergées sur un dépôt privé conforme à PyPi /PEP-503

La section suivante décrit comment installer un Apache Airflow extra hébergé sur une URL privée avec authentification.

-

Ajoutez votre nom d'utilisateur et votre mot de passe comme options de configuration d'Apache Airflow. Par exemple :

-

foo.user:YOUR_USER_NAME -

foo.pass:YOUR_PASSWORD

-

-

Créez votre

requirements.txtdossier. Dans l'exemple suivant, remplacez les espaces réservés par votre URL privée, ainsi que par le nom d'utilisateur et le mot de passe que vous avez ajoutés comme options de configuration d'Apache Airflow. Par exemple :--index-url https://${AIRFLOW__FOO__USER}:${AIRFLOW__FOO__PASS}@my.privatepypi.com -

Ajoutez des bibliothèques supplémentaires à votre

requirements.txtfichier. Par exemple :--index-url https://${AIRFLOW__FOO__USER}:${AIRFLOW__FOO__PASS}@my.privatepypi.com my-private-package==1.2.3

Activation des journaux sur la console Amazon MWAA

Le rôle d'exécution de votre environnement Amazon MWAA nécessite une autorisation pour envoyer des CloudWatch journaux à Logs. Pour mettre à jour les autorisations d'un rôle d'exécution, reportez-vous àRôle d'exécution Amazon MWAA.

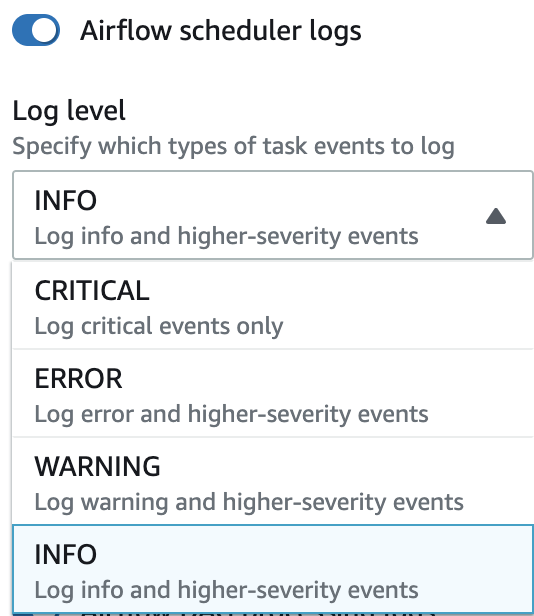

Vous pouvez activer les journaux Apache Airflow au niveauINFO, WARNINGERROR, ouCRITICAL. Lorsque vous choisissez un niveau de journalisation, Amazon MWAA envoie des journaux correspondant à ce niveau et à tous les niveaux de gravité supérieurs. Par exemple, si vous activez les journaux au INFO niveau, Amazon MWAA envoie INFO les journaux et WARNING les niveaux de CRITICAL journalisation à CloudWatch Logs. ERROR Nous recommandons d'activer les journaux Apache Airflow au INFO niveau du planificateur afin qu'il puisse accéder aux journaux reçus pour le. requirements.txt

Accès aux journaux sur la console CloudWatch Logs

Vous pouvez accéder aux journaux d'Apache Airflow pour le planificateur qui planifie vos flux de travail et analyse votre dossier. dags Les étapes suivantes décrivent comment ouvrir le groupe de journaux pour le planificateur sur la console Amazon MWAA et accéder aux journaux Apache Airflow sur la console Logs. CloudWatch

Pour accéder aux journaux d'un requirements.txt

-

Ouvrez la page Environnements

sur la console Amazon MWAA. -

Choisissez un environnement.

-

Choisissez le groupe de journaux du planificateur Airflow dans le volet de surveillance.

-

Choisissez le

requirements_install_iplog in Log streams. -

Reportez-vous à la liste des packages installés sur l'environnement à l'adresse

/usr/local/airflow/.local/bin. Par exemple :Collecting appdirs==1.4.4 (from -r /usr/local/airflow/.local/bin (line 1)) Downloading https://files.pythonhosted.org/packages/3b/00/2344469e2084fb28kjdsfiuyweb47389789vxbmnbjhsdgf5463acd6cf5e3db69324/appdirs-1.4.4-py2.py3-none-any.whl Collecting astroid==2.4.2 (from -r /usr/local/airflow/.local/bin (line 2)) -

Consultez la liste des packages et vérifiez si l'un d'entre eux a rencontré une erreur lors de l'installation. En cas de problème, vous pouvez obtenir un message d'erreur similaire à ce qui suit :

2021-03-05T14:34:42.731-07:00 No matching distribution found for LibraryName==1.0.0 (from -r /usr/local/airflow/.local/bin (line 4)) No matching distribution found for LibraryName==1.0.0 (from -r /usr/local/airflow/.local/bin (line 4))

Erreurs d'accès dans l'interface utilisateur d'Apache Airflow

Vous pouvez également vérifier l'interface utilisateur d'Apache Airflow pour déterminer si une erreur est liée à un autre problème. L'erreur la plus courante que vous pouvez rencontrer avec Apache Airflow sur Amazon MWAA est la suivante :

Broken DAG: No module namedx

Si vous trouvez cette erreur dans l'interface utilisateur d'Apache Airflow, il vous manque probablement une dépendance requise dans votre requirements.txt fichier.

Connectez-vous à Apache Airflow

Vous avez besoin d'Politique d'accès à l'interface utilisateur d'Apache Airflow : Amazon MWAAWeb ServerAccessautorisations pour que votre Compte AWS identifiant AWS Identity and Access Management (IAM) puisse accéder à votre interface utilisateur Apache Airflow.

Pour accéder à votre interface utilisateur Apache Airflow

-

Ouvrez la page Environnements

sur la console Amazon MWAA. -

Choisissez un environnement.

-

Choisissez Open Airflow UI.

Exemples de requirements.txt scénarios

Vous pouvez mélanger et assortir différents formats dans votrerequirements.txt. L'exemple suivant utilise une combinaison des différentes méthodes pour installer des options supplémentaires.

Exemple Des suppléments sur PyPi .org et une URL publique

Vous devez utiliser --index-url cette option lorsque vous spécifiez des packages provenant de PyPi .org, en plus des packages sur une URL publique, tels que le dépôt URLs personnalisé conforme à la norme PEP 503.

aws-batch == 0.6 phoenix-letter >= 0.3 --index-url http://dist.repoze.org/zope2/2.10/simple zopelib