Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Datos personales: OU: cuenta de aplicación PDF

Encuesta

Nos encantaría saber de ti. Envíe sus comentarios sobre la AWS PRA mediante una breve encuesta

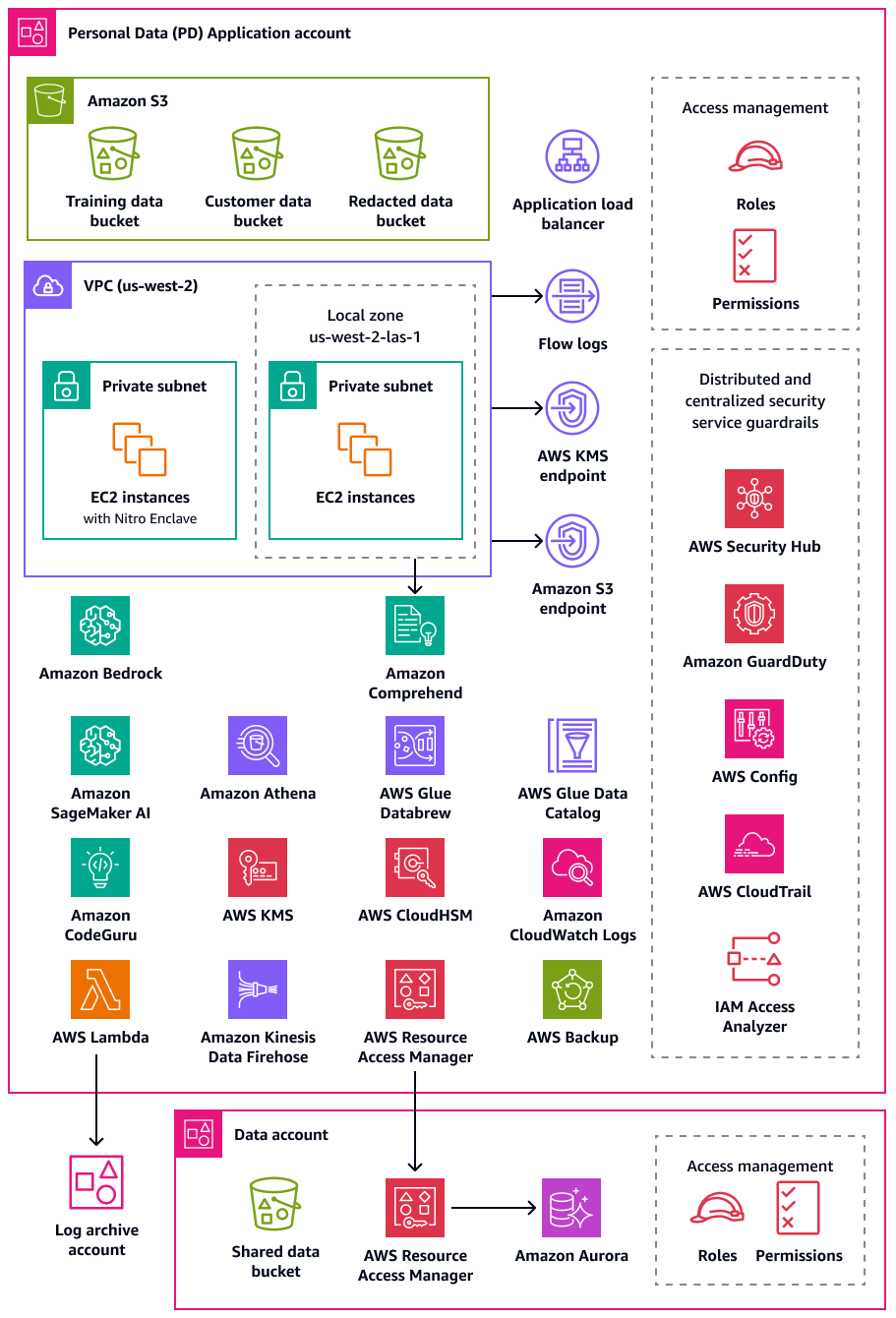

La cuenta de la solicitud de datos personales (PD) es el lugar donde su organización aloja los servicios que recopilan y procesan datos personales. En concreto, puede almacenar lo que define como datos personales en esta cuenta. La AWS PRA muestra varios ejemplos de configuraciones de privacidad a través de una arquitectura web sin servidor de varios niveles. Cuando se trata de operar cargas de trabajo en una AWS landing zone, las configuraciones de privacidad no deben considerarse one-size-fits-all soluciones. Por ejemplo, su objetivo podría ser comprender los conceptos subyacentes, cómo pueden mejorar la privacidad y cómo su organización puede aplicar las soluciones a sus arquitecturas y casos de uso particulares.

Cuentas de AWS En su organización que recopila, almacena o procesa datos personales, puede utilizar AWS Organizations e AWS Control Tower implementar barreras fundamentales y repetibles. Es fundamental establecer una unidad organizativa (OU) dedicada a estas cuentas. Por ejemplo, es posible que desee aplicar barreras de residencia de datos solo a un subconjunto de cuentas en las que la residencia de los datos sea una consideración de diseño fundamental. Para muchas organizaciones, estas son las cuentas que almacenan y procesan los datos personales.

Su organización podría considerar la posibilidad de crear una cuenta de datos dedicada, que es donde almacena la fuente autorizada de sus conjuntos de datos personales. Una fuente de datos autorizada es una ubicación en la que se almacena la versión principal de los datos, que podría considerarse la versión más fiable y precisa de los datos. Por ejemplo, puede copiar los datos de la fuente de datos autorizada a otras ubicaciones, como los depósitos de Amazon Simple Storage Service (Amazon S3) en la cuenta de la aplicación PD que se utilizan para almacenar datos de entrenamiento, un subconjunto de datos de clientes y datos redactados. Al adoptar este enfoque multicuenta para separar los conjuntos de datos personales completos y definitivos de la cuenta de datos de las cargas de trabajo de los consumidores intermedios de la cuenta de la aplicación PD, puede reducir el alcance del impacto en caso de acceso no autorizado a sus cuentas.

El siguiente diagrama ilustra los servicios de AWS seguridad y privacidad que están configurados en las cuentas de datos y aplicaciones de PD.

En esta sección se proporciona información más detallada sobre lo siguiente Servicios de AWS que se utiliza en estas cuentas:

Amazon Athena

Puede considerar los controles de limitación de las consultas de datos para cumplir sus objetivos de privacidad. Amazon Athena es un servicio de consultas interactivo que facilita el análisis de datos en Amazon S3 con SQL estándar. No es necesario cargar los datos en Athena; funciona directamente con los datos almacenados en los cubos S3.

Un caso de uso común de Athena es proporcionar a los equipos de análisis de datos conjuntos de datos personalizados y saneados. Si los conjuntos de datos contienen datos personales, puede desinfectarlos ocultando columnas enteras de datos personales que proporcionan poco valor a los equipos de análisis de datos. Para obtener más información, consulte Anonimizar y administrar los datos de su lago de datos con Amazon Athena y AWS Lake Formation

Si su enfoque de transformación de datos requiere flexibilidad adicional fuera de las funciones compatibles con Athena, puede definir funciones personalizadas, denominadas funciones definidas por el usuario (UDF). Puede invocar UDFs una consulta SQL enviada a Athena y se ejecutará. AWS Lambda Puede utilizar FILTER

SQL consultas UDFs de entrada SELECT y, además, puede invocar varias UDFs en la misma consulta. Por motivos de privacidad, puede crear UDFs dispositivos que utilicen tipos específicos de enmascaramiento de datos, como mostrar solo los últimos cuatro caracteres de cada valor de una columna.

Amazon Bedrock

Amazon Bedrock es un servicio totalmente gestionado que proporciona acceso a los modelos básicos de las principales empresas de IA, como AI21 Labs, Anthropic, Meta, Mistral AI y Amazon. Ayuda a las organizaciones a crear y escalar aplicaciones de IA generativa. Independientemente de la plataforma que se utilice, al utilizar la IA generativa, las organizaciones podrían enfrentarse a riesgos de privacidad, como la posible exposición de los datos personales, el acceso no autorizado a los datos y otras infracciones de conformidad.

Amazon Bedrock Guardrails está diseñado para ayudar a mitigar estos riesgos mediante la aplicación de las mejores prácticas de seguridad y conformidad en todas sus cargas de trabajo generativas de IA en Amazon Bedrock. Es posible que el despliegue y el uso de los recursos de IA no siempre se ajusten a los requisitos de privacidad y conformidad de una organización. Las organizaciones pueden tener dificultades para mantener la privacidad de los datos cuando utilizan modelos de IA generativa porque estos modelos pueden memorizar o reproducir información confidencial. Amazon Bedrock Guardrails ayuda a proteger la privacidad al evaluar las entradas de los usuarios y las respuestas del modelo. En general, si los datos de entrada contienen datos personales, existe el riesgo de que esta información quede expuesta en la salida del modelo.

Amazon Bedrock Guardrails proporciona mecanismos para hacer cumplir las políticas de protección de datos y ayudar a evitar la exposición no autorizada de los datos. Ofrece funciones de filtrado de contenido para detectar y bloquear los datos personales en las entradas, restricciones temáticas para evitar el acceso a temas inapropiados o riesgosos, y filtros de palabras para ocultar o redactar términos sensibles en las solicitudes y respuestas modelo. Estas funciones ayudan a prevenir situaciones que podrían provocar violaciones de la privacidad, como las respuestas sesgadas o la erosión de la confianza de los clientes. Estas funciones pueden ayudarle a garantizar que sus modelos de IA no procesen ni divulguen datos personales de forma inadvertida. Amazon Bedrock Guardrails también admite la evaluación de entradas y respuestas fuera de Amazon Bedrock. Para obtener más información, consulte Implementación de medidas de seguridad independientes del modelo con Amazon Bedrock Guardrails

Con Amazon Bedrock Guardrails, puede limitar el riesgo de alucinaciones modelo mediante comprobaciones contextuales, que evalúan los fundamentos fácticos y la relevancia de las respuestas. Un ejemplo es la implementación de una aplicación de IA generativa orientada al cliente que utiliza fuentes de datos de terceros en una aplicación de generación aumentada de recuperación (RAG).

AWS Clean Rooms

A medida que las organizaciones buscan formas de colaborar entre sí mediante el análisis de conjuntos de datos confidenciales que se cruzan o se superponen, es fundamental mantener la seguridad y la privacidad de esos datos compartidos. AWS Clean Roomsle ayuda a implementar salas limpias de datos, que son entornos seguros y neutrales en los que las organizaciones pueden analizar conjuntos de datos combinados sin compartir los propios datos sin procesar. También puede generar información única al proporcionar acceso a otras organizaciones AWS sin mover o copiar datos de sus propias cuentas y sin revelar el conjunto de datos subyacente. Todos los datos permanecen en la ubicación de origen. Las reglas de análisis integradas restringen la salida y restringen las consultas SQL. Todas las consultas se registran y los miembros de la colaboración pueden ver cómo se consultan sus datos.

Puede crear una AWS Clean Rooms colaboración e invitar a otros AWS clientes a ser miembros de esa colaboración. Concedes a un miembro la posibilidad de consultar los conjuntos de datos de los miembros y puedes elegir miembros adicionales para recibir los resultados de esas consultas. Si más de un miembro necesita consultar los conjuntos de datos, puedes crear colaboraciones adicionales con las mismas fuentes de datos y diferentes configuraciones de miembros. Cada miembro puede filtrar los datos que se comparten con los miembros de la colaboración, y puedes usar reglas de análisis personalizadas para establecer limitaciones sobre la forma en que se pueden analizar los datos que proporcionan a la colaboración.

Además de restringir los datos que se presentan a la colaboración y la forma en que otros miembros pueden utilizarlos, AWS Clean Rooms ofrece las siguientes funciones que pueden ayudarle a proteger la privacidad:

-

La privacidad diferencial es una técnica matemática que mejora la privacidad del usuario al añadir una cantidad de ruido cuidadosamente calibrada a los datos. Esto ayuda a reducir el riesgo de que los usuarios individuales se reidentifiquen en el conjunto de datos sin ocultar los valores de interés. El uso de la privacidad AWS Clean Rooms diferencial no requiere experiencia en privacidad diferencial.

-

AWS Clean Rooms El aprendizaje automático permite que dos o más partes identifiquen a usuarios similares en sus datos sin compartir directamente los datos entre sí. Esto reduce el riesgo de ataques de inferencia de miembros, en los que un miembro de la colaboración puede identificar a las personas en el conjunto de datos del otro miembro. Al crear un modelo similar y generar un segmento similar, AWS Clean Rooms el aprendizaje automático le ayuda a comparar conjuntos de datos sin exponer los datos originales. Esto no requiere que ninguno de los miembros tenga experiencia en aprendizaje automático ni que realice ningún trabajo ajeno a ellos. AWS Clean Rooms Usted conserva el control y la propiedad totales del modelo entrenado.

-

La computación criptográfica para salas limpias (C3R) se puede utilizar con reglas de análisis para obtener información a partir de datos confidenciales. Limita criptográficamente lo que cualquier otra parte de la colaboración puede aprender. Con el cliente de cifrado C3R, los datos se cifran en el cliente antes de proporcionárselos. AWS Clean Rooms Como las tablas de datos se cifran con una herramienta de cifrado del lado del cliente antes de cargarlas en Amazon S3, los datos permanecen cifrados y persisten durante el procesamiento.

En la AWS PRA, le recomendamos que cree AWS Clean Rooms colaboraciones en la cuenta de datos. Puede utilizarlos para compartir datos cifrados de clientes con terceros. Úselos solo cuando haya una superposición en los conjuntos de datos proporcionados. Para obtener más información sobre cómo determinar la superposición, consulte la regla de análisis de listas en la AWS Clean Rooms documentación.

Amazon CloudWatch Logs

Amazon CloudWatch Logs le ayuda a centralizar los registros de todos sus sistemas y aplicaciones Servicios de AWS para que pueda supervisarlos y archivarlos de forma segura. En CloudWatch Logs, puede utilizar una política de protección de datos para los grupos de registros nuevos o existentes a fin de minimizar el riesgo de divulgación de datos personales. Las políticas de protección de datos pueden detectar datos confidenciales, como datos personales, en sus registros. La política de protección de datos puede enmascarar esos datos cuando los usuarios acceden a los registros a través del Consola de administración de AWS. Cuando los usuarios necesiten acceder directamente a los datos personales, de acuerdo con la especificación de propósito general de su carga de trabajo, puede asignar logs:Unmask permisos a esos usuarios. También puede crear una política de protección de datos para toda la cuenta y aplicarla de forma coherente en todas las cuentas de su organización. Esto configura el enmascaramiento de forma predeterminada para todos los grupos de registros actuales y futuros en CloudWatch Logs. También le recomendamos que habilite los informes de auditoría y los envíe a otro grupo de registros, a un bucket de Amazon S3 o a Amazon Data Firehose. Estos informes contienen un registro detallado de los resultados de protección de datos en cada grupo de registros.

CodeGuru Revisor de Amazon

Tanto para la privacidad como para la seguridad, es vital para muchas organizaciones que respalden el cumplimiento continuo durante las fases de implementación y posteriores a la implementación. La AWS PRA incluye controles proactivos en los procesos de implementación de las aplicaciones que procesan datos personales. Amazon CodeGuru Reviewer puede detectar posibles defectos que podrían exponer datos personales en código Java y Python. JavaScript Ofrece sugerencias a los desarrolladores para mejorar el código. CodeGuru El revisor puede identificar los defectos en una amplia gama de prácticas de seguridad, privacidad y recomendaciones generales. Está diseñado para funcionar con varios proveedores de fuentes AWS CodeCommit, incluidos Bitbucket y Amazon S3. GitHub Algunos de los defectos relacionados con la privacidad que CodeGuru Reviewer puede detectar incluyen:

-

Inyección de SQL

-

Cookies no seguras

-

Falta la autorización

-

Recrificación del lado del cliente AWS KMS

Para obtener una lista completa de lo que CodeGuru Reviewer puede detectar, consulte la biblioteca de Amazon CodeGuru Detector.

Amazon Comprehend

Amazon Comprehend es un servicio de procesamiento del lenguaje natural (PNL) que utiliza el aprendizaje automático para descubrir información y conexiones valiosas en documentos de texto en inglés. Amazon Comprehend puede detectar y redactar datos personales en documentos de texto estructurados, semiestructurados o no estructurados. Para obtener más información, consulte Información de identificación personal (PII) en la documentación de Amazon Comprehend.

Puede utilizar la API de AWS SDKs y Amazon Comprehend para integrar Amazon Comprehend con muchas aplicaciones. Un ejemplo es el uso de Amazon Comprehend para detectar y redactar datos personales con Amazon S3 Object Lambda. Las organizaciones pueden usar S3 Object Lambda para añadir código personalizado a las solicitudes GET de Amazon S3 para modificar y procesar los datos a medida que se devuelven a una aplicación. S3 Object Lambda puede filtrar filas, cambiar el tamaño de las imágenes de forma dinámica, redactar datos personales y mucho más. Gracias a AWS Lambda sus funciones, el código se ejecuta en una infraestructura totalmente gestionada AWS, lo que elimina la necesidad de crear y almacenar copias derivadas de los datos o de ejecutar proxies. No necesita cambiar sus aplicaciones para transformar objetos con S3 Object Lambda. Puede utilizar la función ComprehendPiiRedactionS3Object Lambda AWS Serverless Application Repository para redactar datos personales. Esta función utiliza Amazon Comprehend para detectar entidades de datos personales y las redacta sustituyéndolas por asteriscos. Para obtener más información, consulte Detección y redacción de datos de PII con S3 Object Lambda y Amazon Comprehend en la documentación de Amazon S3.

Como Amazon Comprehend tiene muchas opciones para la integración de aplicaciones a través de AWS SDKs, puede usar Amazon Comprehend para identificar datos personales en muchos lugares diferentes donde recopila, almacena y procesa datos. Puede utilizar las capacidades de Amazon Comprehend ML para detectar y redactar datos personales en los registros de aplicaciones

-

REPLACE_WITH_PII_ENTITY_TYPEreemplaza cada entidad de PII por sus tipos. Por ejemplo, Jane Doe se sustituiría por NAME. -

MASKreemplaza los caracteres de las entidades PII por un carácter de su elección (! , #, $,%, &, o @). Por ejemplo, Jane Doe podría sustituirse por **** ***.

Amazon Data Firehose

Amazon Data Firehose se puede utilizar para capturar, transformar y cargar datos de streaming en servicios descendentes, como Amazon Managed Service para Apache Flink o Amazon S3. Firehose se suele utilizar para transportar grandes cantidades de datos de streaming, como registros de aplicaciones, sin tener que construir canalizaciones de procesamiento desde cero.

Puede utilizar las funciones de Lambda para realizar un procesamiento personalizado o integrado antes de que los datos se envíen aguas abajo. En aras de la privacidad, esta capacidad admite los requisitos de minimización de datos y transferencia de datos transfronteriza. Por ejemplo, puede usar Lambda y Firehose para transformar los datos de registro de varias regiones antes de que se centralicen en la cuenta de Log Archive. Para obtener más información, consulte Biogen: solución de registro centralizada para cuentas múltiples

Amazon DataZone

A medida que las organizaciones amplían su enfoque para compartir datos AWS Lake Formation, por Servicios de AWS ejemplo, quieren asegurarse de que el acceso diferencial esté controlado por quienes están más familiarizados con los datos: los propietarios de los datos. Sin embargo, es posible que estos propietarios de datos conozcan los requisitos de privacidad, como el consentimiento o las consideraciones sobre la transferencia de datos transfronteriza. Amazon DataZone ayuda a los propietarios de los datos y al equipo de gobierno de datos a compartir y consumir datos en toda la organización de acuerdo con sus políticas de gobierno de datos. En Amazon DataZone, las líneas de negocio (LOBs) administran sus propios datos y un catálogo rastrea esta propiedad. Las partes interesadas pueden buscar datos y solicitar acceso a ellos como parte de sus tareas empresariales. Siempre que cumpla con las políticas establecidas por los editores de datos, el propietario de los datos puede conceder el acceso a las tablas subyacentes sin necesidad de un administrador ni de mover los datos.

En un contexto de privacidad, Amazon DataZone puede ser útil en los siguientes casos de uso de ejemplo:

-

Una aplicación orientada al cliente genera datos de uso que se pueden compartir con un LOB de marketing independiente. Debe asegurarse de que solo se publiquen en el catálogo los datos de los clientes que hayan optado por el marketing.

-

Los datos de los clientes europeos se publican, pero solo los usuarios LOBs locales del Espacio Económico Europeo (EEE) pueden suscribirse a ellos. Para obtener más información, consulta Mejora la seguridad de los datos con controles de acceso detallados en Amazon

. DataZone

En la AWS PRA, puede conectar los datos del bucket compartido de Amazon S3 a Amazon DataZone como productor de datos.

AWS Glue

El mantenimiento de conjuntos de datos que contienen datos personales es un componente clave de Privacy by Design

AWS Glue Data Catalog

AWS Glue Data Catalogle ayuda a establecer conjuntos de datos fáciles de mantener. El catálogo de datos contiene referencias a los datos que se utilizan como fuentes y destinos para las tareas de extracción, transformación y carga (ETL). AWS Glue La información del catálogo de datos se almacena como tablas de metadatos y cada tabla especifica un único banco de datos. Se ejecuta un AWS Glue

rastreador para hacer un inventario de los datos de diversos tipos de almacenes de datos. Agrega clasificadores integrados y personalizados al rastreador, y estos clasificadores deducen el formato y el esquema de los datos personales. A continuación, el rastreador escribe los metadatos en el catálogo de datos. Una tabla de metadatos centralizada puede facilitar la respuesta a las solicitudes de los interesados (como el derecho a la supresión), ya que añade estructura y previsibilidad a las distintas fuentes de datos personales de su entorno. AWS Para ver un ejemplo completo de cómo utilizar Data Catalog para responder automáticamente a estas solicitudes, consulte Gestión de las solicitudes de borrado de datos en su lago de datos con Amazon S3 Find and Forget

AWS Glue DataBrew

AWS Glue DataBrewle ayuda a limpiar y normalizar los datos, y puede realizar transformaciones en los datos, como eliminar o enmascarar la información de identificación personal y cifrar los campos de datos confidenciales en las canalizaciones de datos. También puede mapear visualmente el linaje de sus datos para comprender las distintas fuentes de datos y los pasos de transformación por los que han pasado los datos. Esta función adquiere cada vez más importancia a medida que su organización trabaja para comprender mejor la procedencia de los datos personales y hacer un seguimiento de la procedencia de los datos personales. DataBrew le ayuda a ocultar los datos personales durante la preparación de los datos. Puede detectar datos personales como parte de una labor de elaboración de perfiles de datos y recopilar estadísticas, como el número de columnas que pueden contener datos personales y las posibles categorías. A continuación, puede utilizar técnicas integradas de transformación de datos reversibles o irreversibles, como la sustitución, el cifrado y el descifrado, todo ello sin necesidad de escribir ningún código. A continuación, puede utilizar los conjuntos de datos limpios y enmascarados en un momento posterior para realizar tareas de análisis, elaboración de informes y aprendizaje automático. Algunas de las técnicas de enmascaramiento de datos disponibles en incluyen: DataBrew

-

Procesamiento de hash: aplique funciones de hash a los valores de las columnas.

-

Sustitución: sustituye los datos personales por otros valores que parezcan auténticos.

-

Anulación o eliminación: sustituye un campo concreto por un valor nulo o elimina la columna.

-

Enmascaramiento: utilice la codificación de caracteres o oculte determinadas partes de las columnas.

Las siguientes son las técnicas de cifrado disponibles:

-

Cifrado determinista: aplique algoritmos de cifrado determinista a los valores de las columnas. El cifrado determinista siempre produce el mismo texto cifrado para un valor.

-

Cifrado probabilístico: aplique algoritmos de cifrado probabilístico a los valores de las columnas. El cifrado probabilístico produce un texto cifrado diferente cada vez que se aplica.

Para obtener una lista completa de las recetas de transformación de datos personales proporcionadas en DataBrew, consulte los pasos básicos de la información de identificación personal (PII).

AWS Glue Calidad de los datos

AWS Glue La calidad de los datos le ayuda a automatizar y poner en funcionamiento la entrega de datos de alta calidad en todas las canalizaciones de datos, de forma proactiva, antes de entregarlos a sus consumidores de datos. AWS Glue Data Quality proporciona un análisis estadístico de los problemas de calidad de los datos en todos sus flujos de datos, puede activar alertas en Amazon EventBridge y puede hacer recomendaciones de normas de calidad para su corrección. AWS Glue Data Quality también permite la creación de reglas con un lenguaje específico del dominio para que pueda crear reglas de calidad de datos personalizadas.

AWS Key Management Service

AWS Key Management Service (AWS KMS) le ayuda a crear y controlar claves criptográficas para proteger sus datos. AWS KMS utiliza módulos de seguridad de hardware para proteger y validar AWS KMS keys en el marco del programa de validación de módulos criptográficos FIPS 140-2. Para obtener más información sobre cómo se utiliza este servicio en un contexto de seguridad, consulte la arquitectura de referencia de AWS seguridad.

AWS KMS se integra con la mayoría de los sistemas Servicios de AWS que ofrecen cifrado, y puede utilizar claves KMS en las aplicaciones que procesan y almacenan datos personales. Puede utilizarlas AWS KMS para cumplir diversos requisitos de privacidad y proteger los datos personales, entre los que se incluyen:

-

Uso de claves gestionadas por el cliente para tener un mayor control sobre la resistencia, la rotación, la caducidad y otras opciones.

-

Uso de claves exclusivas administradas por el cliente para proteger los datos personales y los secretos que permiten el acceso a los datos personales.

-

Definir los niveles de clasificación de datos y designar al menos una clave dedicada gestionada por el cliente por nivel. Por ejemplo, puede tener una clave para cifrar los datos operativos y otra para cifrar los datos personales.

-

Impedir el acceso involuntario entre cuentas a las claves de KMS.

-

Almacenar las claves de KMS en el mismo lugar Cuenta de AWS que el recurso que se va a cifrar.

-

Implementar la separación de tareas para la administración y el uso de las claves de KMS. Para obtener más información, consulte Cómo usar KMS e IAM para habilitar controles de seguridad independientes para los datos cifrados en S3

(entrada del AWS blog). -

Impulsar la rotación automática de las llaves mediante barandillas preventivas y reactivas.

De forma predeterminada, las claves KMS se almacenan y solo se pueden usar en la región en la que se crearon. Si su organización tiene requisitos específicos de residencia y soberanía de los datos, considere si las claves KMS multirregionales son adecuadas para su caso de uso. Las claves multirregionales son claves KMS de uso especial en diferentes formatos Regiones de AWS que se pueden usar indistintamente. El proceso de creación de una clave multirregional traslada el material clave más allá de Región de AWS las fronteras internas AWS KMS, por lo que esta falta de aislamiento regional podría no ser compatible con los objetivos de soberanía y residencia de la organización. Una forma de solucionar este problema es utilizar un tipo diferente de clave de KMS, como una clave gestionada por el cliente específica de una región.

Almacenes de claves externos

Para muchas organizaciones, el almacén de AWS KMS claves predeterminado Nube de AWS puede cumplir con sus requisitos de soberanía de datos y reglamentarios generales. Sin embargo, algunas pueden requerir que las claves de cifrado se creen y mantengan fuera de un entorno de nube y que dispongas de rutas de autorización y auditoría independientes. Con los almacenes de claves externos AWS KMS, puede cifrar los datos personales con material clave que su organización posea y controle fuera de Nube de AWSél. Seguirá interactuando con la AWS KMS API como de costumbre, pero solo AWS KMS interactúa con el software de proxy de almacén de claves externo (proxy XKS) que usted proporcione. A continuación, el proxy del almacén de claves externo interviene en todas las comunicaciones entre AWS KMS y el administrador de claves externo.

Al utilizar un almacén de claves externo para el cifrado de datos, es importante tener en cuenta la sobrecarga operativa adicional en AWS KMS comparación con el mantenimiento de las claves. Con un almacén de claves externo, debe crear, configurar y mantener el almacén de claves externo. Además, si hay errores en la infraestructura adicional que debe mantener, como el proxy XKS, y se pierde la conectividad, es posible que los usuarios no puedan descifrar los datos ni acceder a ellos temporalmente. Trabaje en estrecha colaboración con las partes interesadas en materia de cumplimiento y regulación para comprender las obligaciones legales y contractuales en materia de cifrado de datos personales y sus acuerdos de nivel de servicio en materia de disponibilidad y resiliencia.

AWS Lake Formation

Muchas organizaciones que catalogan y categorizan sus conjuntos de datos mediante catálogos de metadatos estructurados desean compartir esos conjuntos de datos en toda la organización. Puede usar políticas de permisos AWS Identity and Access Management (IAM) para controlar el acceso a conjuntos de datos completos, pero a menudo se requiere un control más detallado para los conjuntos de datos que contienen datos personales de distinta sensibilidad. Por ejemplo, la especificación del propósito y la limitación de uso

Los lagos de datos también plantean problemas de privacidad, ya

Puede utilizar la función de control de acceso basada en etiquetas en Lake Formation. El control de acceso basado en etiquetas es una estrategia de autorización que define los permisos en función de los atributos. En Lake Formation, estos atributos se denominan etiquetas LF. Con una etiqueta LF, puede adjuntar estas etiquetas a las bases de datos, tablas y columnas del catálogo de datos y conceder las mismas etiquetas a los directores de IAM. Lake Formation permite realizar operaciones en esos recursos cuando al director se le ha concedido acceso a un valor de etiqueta que coincide con el valor de la etiqueta del recurso. La siguiente imagen muestra cómo asignar etiquetas LF y permisos para proporcionar un acceso diferenciado a los datos personales.

En este ejemplo, se utiliza la naturaleza jerárquica de las etiquetas. Ambas bases de datos contienen información de identificación personal (PII:true), pero las etiquetas en el nivel de columnas limitan las columnas específicas a los diferentes equipos. En este ejemplo, los directores de IAM que tienen la etiqueta PII:true LF pueden acceder a los recursos de la AWS Glue base de datos que tienen esta etiqueta. Los directores con la etiqueta LOB:DataScience LF pueden acceder a columnas específicas que tengan esta etiqueta, y los directores con la etiqueta LOB:Marketing LF solo pueden acceder a las columnas que tengan esta etiqueta. El departamento de marketing solo puede acceder a la PII que sea relevante para los casos de uso de marketing, y el equipo de ciencia de datos solo puede acceder a la PII que sea relevante para sus casos de uso.

Zonas locales de AWS

Si necesita cumplir con los requisitos de residencia de los datos, puede implementar recursos que almacenen y procesen datos personales de forma específica Regiones de AWS para cumplir con estos requisitos. También puede utilizarlos Zonas locales de AWS, lo que le ayuda a ubicar los recursos informáticos, de almacenamiento, de bases de datos y otros AWS recursos selectos cerca de grandes centros industriales y de población. Una zona local es una extensión de una Región de AWS que se encuentra en proximidad geográfica a una gran área metropolitana. Puede colocar tipos específicos de recursos dentro de una zona local, cerca de la región a la que corresponde la zona local. Las Zonas Locales pueden ayudarlo a cumplir con los requisitos de residencia de datos cuando una región no esté disponible dentro de la misma jurisdicción legal. Cuando utilice Zonas Locales, tenga en cuenta los controles de residencia de datos que se implementan en su organización. Por ejemplo, es posible que necesite un control para evitar la transferencia de datos de una zona local específica a otra región. Para obtener más información sobre cómo SCPs mantener las barreras de transferencia de datos transfronterizas, consulte Mejores prácticas para gestionar la residencia de datos al Zonas locales de AWS usar controles de landing zone

AWS Enclaves Nitro

Considere su estrategia de segmentación de datos desde una perspectiva de procesamiento, como el procesamiento de datos personales con un servicio informático como Amazon Elastic Compute Cloud (Amazon EC2). La computación confidencial, como parte de una estrategia de arquitectura más amplia, puede ayudarlo a aislar el procesamiento de datos personales en un enclave de CPU aislado, protegido y confiable. Los enclaves son máquinas virtuales independientes, reforzadas y muy restringidas. AWS Nitro Enclaves es una EC2 función de Amazon que puede ayudarte a crear estos entornos informáticos aislados. Para obtener más información, consulte El diseño de seguridad del sistema AWS Nitro (AWS documento técnico).

Nitro Enclaves despliega un núcleo que está separado del núcleo de la instancia principal. El núcleo de la instancia principal no tiene acceso al enclave. Los usuarios no pueden acceder mediante SSH ni de forma remota a los datos y las aplicaciones del enclave. Las aplicaciones que procesan datos personales pueden integrarse en el enclave y configurarse para usar el Vsock del enclave, el socket que facilita la comunicación entre el enclave y la instancia principal.

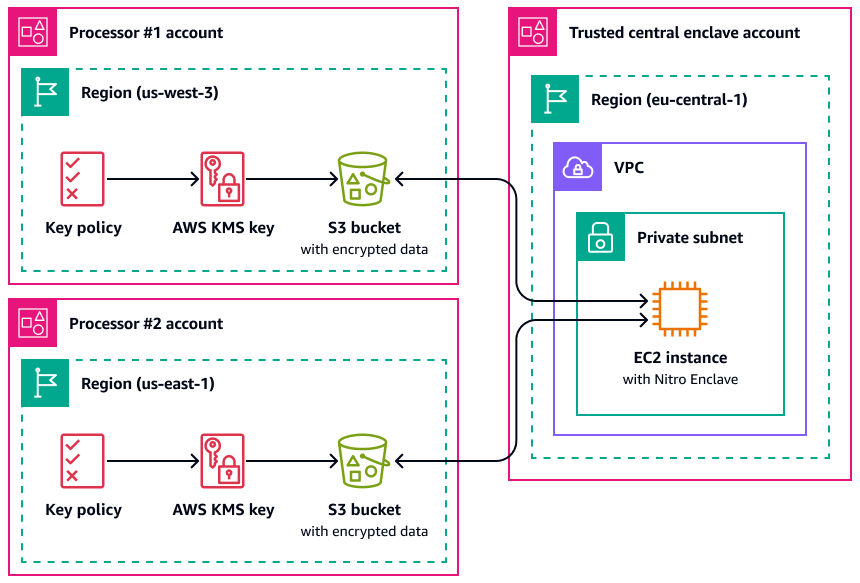

Un caso de uso en el que Nitro Enclaves puede resultar útil es el procesamiento conjunto entre dos procesadores de datos que están separados Regiones de AWS y que podrían no confiar entre sí. La siguiente imagen muestra cómo se puede utilizar un enclave para el procesamiento centralizado, una clave KMS para cifrar los datos personales antes de enviarlos al enclave y una AWS KMS key política que compruebe que el enclave que solicita el descifrado tiene las medidas únicas en su documento de certificación. Para obtener más información e instrucciones, consulte Uso de la atestación criptográfica con. AWS KMS Para ver un ejemplo de política de claves, consulta Exija una certificación para usar una clave AWS KMS esta guía.

Con esta implementación, solo los procesadores de datos respectivos y el enclave subyacente tienen acceso a los datos personales en texto plano. El único lugar donde están expuestos los datos, fuera del entorno de los respectivos procesadores de datos, es en el propio enclave, que está diseñado para evitar el acceso y la manipulación.

AWS PrivateLink

Muchas organizaciones desean limitar la exposición de los datos personales a redes que no son de confianza. Por ejemplo, si desea mejorar la privacidad del diseño general de la arquitectura de la aplicación, puede segmentar las redes en función de la confidencialidad de los datos (de forma similar a la separación lógica y física de los conjuntos de datos que se analiza en la Servicios de AWS y funciones que ayudan a segmentar los datos sección). AWS PrivateLinkle ayuda a crear conexiones unidireccionales y privadas desde sus nubes privadas virtuales (VPCs) a servicios externos a la VPC. Con AWS PrivateLinkél, puede configurar conexiones privadas dedicadas a los servicios que almacenan o procesan datos personales en su entorno; no es necesario conectarse a puntos finales públicos ni transferir estos datos a través de redes públicas que no sean de confianza. Al habilitar los puntos finales de AWS PrivateLink servicio para los servicios incluidos, no se necesita una pasarela de Internet, un dispositivo NAT, una dirección IP pública, una AWS Direct Connect conexión o una conexión para AWS Site-to-Site VPN comunicarse. Cuando te conectas AWS PrivateLink a un servicio que proporciona acceso a datos personales, puedes usar políticas de puntos finales de VPC y grupos de seguridad para controlar el acceso, de acuerdo con la definición del perímetro de datos

AWS Resource Access Manager

AWS Resource Access Manager (AWS RAM) le ayuda a compartir sus recursos de forma segura Cuentas de AWS para reducir la sobrecarga operativa y ofrecer visibilidad y auditabilidad. Cuando planifique su estrategia de segmentación de varias cuentas, considere la posibilidad de AWS RAM compartir los almacenes de datos personales que almacene en una cuenta separada y aislada. Puedes compartir esos datos personales con otras cuentas de confianza con el fin de procesarlos. En AWS RAM, puedes administrar los permisos que definen qué acciones se pueden realizar en los recursos compartidos. AWS RAM Se ha iniciado sesión en todas las llamadas a la API CloudTrail. Además, puede configurar Amazon CloudWatch Events para que le notifique automáticamente eventos específicos en AWS RAM, por ejemplo, cuando se realicen cambios en un recurso compartido.

Si bien puede compartir muchos tipos de AWS recursos con otros Cuentas de AWS mediante políticas basadas en recursos en IAM o políticas de bucket en Amazon S3, AWS RAM ofrece varios beneficios adicionales en materia de privacidad. AWS proporciona a los propietarios de los datos una visibilidad adicional sobre cómo y con quién se comparten los datos en su Cuentas de AWS empresa, lo que incluye:

-

Poder compartir un recurso con una unidad organizativa completa en lugar de actualizar manualmente las listas de cuentas IDs

-

Hacer cumplir el proceso de invitación para iniciar acciones si la cuenta de consumidor no forma parte de su organización

-

Visibilidad de los directores de IAM específicos que tienen acceso a cada recurso individual

Si ha utilizado anteriormente una política basada en recursos para gestionar un recurso compartido y desea utilizarla en AWS RAM su lugar, utilice la operación de API. PromoteResourceShareCreatedFromPolicy

Amazon SageMaker AI

Amazon SageMaker AI

Monitor de SageMaker modelos Amazon

Muchas organizaciones consideran la desviación de datos a la hora de entrenar modelos de aprendizaje automático. La desviación de datos es una variación significativa entre los datos de producción y los datos que se utilizaron para entrenar un modelo de aprendizaje automático, o un cambio significativo en los datos de entrada a lo largo del tiempo. La desviación de los datos puede reducir la calidad, la precisión y la imparcialidad generales de las predicciones de los modelos de machine learning. Si la naturaleza estadística de los datos que recibe un modelo de aprendizaje automático durante la producción se aleja de la naturaleza de los datos de referencia en los que se entrenó, la precisión de las predicciones podría disminuir. Amazon SageMaker Model Monitor puede monitorear continuamente la calidad de los modelos de aprendizaje automático de Amazon SageMaker AI en producción y monitorear la calidad de los datos. La detección temprana y proactiva de la desviación de datos puede ayudarlo a implementar acciones correctivas, como volver a capacitar los modelos, auditar los sistemas iniciales o solucionar problemas de calidad de los datos. Model Monitor puede reducir la necesidad de monitorizar manualmente los modelos o crear herramientas adicionales.

Amazon SageMaker Clarify

Amazon SageMaker Clarify proporciona información sobre el sesgo y la explicabilidad de los modelos. SageMaker Clarify se usa comúnmente durante la preparación de los datos del modelo de aprendizaje automático y la fase de desarrollo general. Los desarrolladores pueden especificar los atributos de interés, como el sexo o la edad, y SageMaker Clarify ejecuta un conjunto de algoritmos para detectar cualquier presencia de sesgo en esos atributos. Una vez ejecutado el algoritmo, SageMaker Clarify proporciona un informe visual con una descripción de las fuentes y las medidas del posible sesgo para que pueda identificar las medidas necesarias para subsanarlo. Por ejemplo, en un conjunto de datos financieros que contenga solo unos pocos ejemplos de préstamos empresariales concedidos a un grupo de edad en comparación con otros, SageMaker podría detectar desequilibrios para evitar un modelo que desfavorezca a ese grupo de edad. También puede comprobar si los modelos ya entrenados están sesgados revisando sus predicciones y supervisando continuamente esos modelos de aprendizaje automático para detectar sesgos. Por último, SageMaker Clarify está integrado con Amazon SageMaker AI Experiments para proporcionar un gráfico que explica qué características contribuyeron más al proceso general de elaboración de predicciones de un modelo. Esta información podría ser útil para obtener resultados de explicabilidad y podría ayudarle a determinar si la entrada de un modelo en particular tiene más influencia de la que debería en el comportamiento general del modelo.

Tarjeta SageMaker modelo Amazon

Amazon SageMaker Model Card puede ayudarle a documentar detalles importantes sobre sus modelos de aprendizaje automático con fines de gobernanza y elaboración de informes. Estos detalles pueden incluir el propietario del modelo, el propósito general, los casos de uso previstos, las suposiciones asumidas, la calificación de riesgo de un modelo, los detalles y métricas de la capacitación y los resultados de la evaluación. Para obtener más información, consulte Model Explainability with AWS Artificial Intelligence and Machine Learning Solutions (documentoAWS técnico).

Amazon SageMaker Data Wrangler

Amazon SageMaker Data Wrangler

El Data Wrangler se puede utilizar como parte del proceso de preparación de datos y de ingeniería de características en la AWS PRA. Admite el cifrado de datos en reposo y en tránsito mediante el uso AWS KMS, y utiliza las funciones y políticas de IAM para controlar el acceso a los datos y los recursos. Admite el enmascaramiento de datos a través de AWS Glue Amazon SageMaker Feature Store. Si integras Data Wrangler con AWS Lake Formation, puedes aplicar controles y permisos de acceso a los datos detallados. Incluso puede usar Data Wrangler con Amazon Comprehend para eliminar automáticamente los datos personales de los datos tabulares como parte de su flujo de trabajo más amplio de ML Ops. Para obtener más información, consulte Redactar automáticamente la PII para el aprendizaje automático mediante Amazon SageMaker Data Wrangler

La versatilidad de Data Wrangler le permite ocultar datos confidenciales de muchos sectores, como números de cuentas, números de tarjetas de crédito, números de seguridad social, nombres de pacientes e historiales médicos y militares. Puedes limitar el acceso a cualquier dato confidencial o elegir redactarlo.

AWS funciones que ayudan a gestionar el ciclo de vida de los datos

Cuando los datos personales ya no sean necesarios, puede utilizar el ciclo de vida y time-to-live las políticas para los datos de muchos almacenes de datos diferentes. Al configurar las políticas de retención de datos, tenga en cuenta las siguientes ubicaciones que podrían contener datos personales:

-

Bases de datos, como Amazon DynamoDB y Amazon Relational Database Service (Amazon RDS)

-

Buckets de Amazon S3

-

Inicia sesión desde y CloudWatch CloudTrail

-

Datos en caché de migraciones en AWS Database Migration Service (AWS DMS) y proyectos AWS Glue DataBrew

-

Copias de seguridad e instantáneas

Las siguientes funciones Servicios de AWS y las siguientes pueden ayudarle a configurar las políticas de retención de datos en sus AWS entornos:

-

Amazon S3 Lifecycle: conjunto de reglas que definen las acciones que Amazon S3 aplica a un grupo de objetos. En la configuración del ciclo de vida de Amazon S3, puede crear acciones de caducidad, que definen cuándo Amazon S3 elimina los objetos caducados en su nombre. Para obtener más información, consulte Administración del ciclo de vida del almacenamiento.

-

Amazon Data Lifecycle Manager: en Amazon EC2, cree una política que automatice la creación, retención y eliminación de las instantáneas de Amazon Elastic Block Store (Amazon EBS) y de las Amazon Machine Images respaldadas por EBS (). AMIs

-

Tiempo de vida (TTL) de DynamoDB: defina una marca de tiempo por elemento que determine cuándo un elemento ya no es necesario. Poco después de la fecha y hora de la marca de tiempo especificada, DynamoDB elimina el elemento de la tabla.

-

Configuración de retención de CloudWatch registros en los registros: puede ajustar la política de retención de cada grupo de registros a un valor comprendido entre 1 día y 10 años.

-

AWS Backup— Implemente políticas de protección de datos de forma centralizada para configurar, administrar y gobernar su actividad de respaldo en una variedad de AWS recursos, incluidos los buckets S3, las instancias de bases de datos de RDS, las tablas de DynamoDB, los volúmenes de EBS y muchos más. Aplique políticas de respaldo a sus AWS recursos especificando los tipos de recursos o proporcionando una granularidad adicional al aplicarlas en función de las etiquetas de recursos existentes. Audite e informe sobre la actividad de respaldo desde una consola centralizada para cumplir con los requisitos de cumplimiento de las normas de respaldo.

Servicios de AWS y funciones que ayudan a segmentar los datos

La segmentación de datos es el proceso mediante el cual se almacenan los datos en contenedores separados. Esto puede ayudarle a proporcionar medidas de seguridad y autenticación diferenciadas para cada conjunto de datos y a reducir el alcance del impacto de la exposición en todo el conjunto de datos. Por ejemplo, en lugar de almacenar todos los datos de los clientes en una base de datos grande, puede segmentar estos datos en grupos más pequeños y fáciles de administrar.

Puede utilizar la separación física y lógica para segmentar los datos personales:

-

Separación física: el acto de almacenar los datos en almacenes de datos separados o de distribuirlos en AWS recursos separados. Si bien los datos están separados físicamente, es posible que los mismos directores puedan acceder a ambos recursos. Por eso recomendamos combinar la separación física con la separación lógica.

-

Separación lógica: acto de aislar los datos mediante controles de acceso. Las diferentes funciones laborales requieren diferentes niveles de acceso a subconjuntos de datos personales. Para ver un ejemplo de política que implementa la separación lógica, consulte Otorgue acceso a atributos específicos de Amazon DynamoDB esta guía.

La combinación de una separación lógica y física proporciona flexibilidad, simplicidad y granularidad a la hora de redactar políticas basadas en la identidad y en los recursos para respaldar el acceso diferenciado entre las distintas funciones laborales. Por ejemplo, puede resultar complejo desde el punto de vista operativo crear políticas que separen de forma lógica las diferentes clasificaciones de datos en un único depósito de S3. El uso de depósitos de S3 dedicados para cada clasificación de datos simplifica la configuración y la administración de las políticas.

Servicios de AWS y funciones que ayudan a descubrir, clasificar o catalogar los datos

Algunas organizaciones no han empezado a utilizar las herramientas de extracción, carga y transformación (ELT) en su entorno para catalogar sus datos de forma proactiva. Es posible que estos clientes se encuentren en una fase temprana de descubrimiento de datos, en la que deseen comprender mejor los datos que almacenan y procesan, AWS y cómo están estructurados y clasificados. Puede utilizar Amazon Macie para comprender mejor sus datos de PII en Amazon S3. Sin embargo, Amazon Macie no puede ayudarlo a analizar otras fuentes de datos, como Amazon Relational Database Service (Amazon RDS) y Amazon Redshift. Puede utilizar dos enfoques para acelerar el descubrimiento inicial al comienzo de un ejercicio de mapeo de datos más amplio:

-

Método manual: cree una tabla con dos columnas y tantas filas como necesite. En la primera columna, escriba una descripción de los datos (como el nombre de usuario, la dirección o el sexo) que pueda estar en el encabezado o el cuerpo de un paquete de red o en cualquier servicio que proporcione. Pide a tu equipo de cumplimiento que complete la segunda columna. En la segunda columna, escriba un «sí» si los datos se consideran personales y un «no» si no lo son. Indique cualquier tipo de dato personal que se considere especialmente sensible, como la denominación religiosa o los datos de salud.

-

Enfoque automatizado: utilice las herramientas que se proporcionan a través de. AWS Marketplace Una de esas herramientas es Securiti

. Estas soluciones ofrecen integraciones que les permiten escanear y descubrir datos en varios tipos de AWS recursos, así como activos en otras plataformas de servicios en la nube. Muchas de estas mismas soluciones pueden recopilar y mantener de forma continua un inventario de activos de datos y actividades de procesamiento de datos en un catálogo de datos centralizado. Si confía en una herramienta para realizar una clasificación automatizada, es posible que sea necesario ajustar las reglas de descubrimiento y clasificación para adaptarlas a la definición de datos personales de su organización.