Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Beschleunigen Sie MLOps mit Backstage- und Self-Service-Vorlagen für Amazon AI SageMaker

Ashish Bhatt, Shashank Hirematt und Shivanshu Suryakar, Amazon Web Services

Übersicht

Organizations, die Operations (MLOps) -Systeme für maschinelles Lernen verwenden, stehen vor erheblichen Herausforderungen bei der Skalierung, Standardisierung und Sicherung ihrer ML-Infrastruktur. Dieses Muster führt einen transformativen Ansatz ein, der Backstage

Die IaC-Module für dieses Muster werden im Module-Repository bereitgestellt. GitHub AWS AIOps

Wenn Sie Backstage als Self-Service-Plattform verwenden und vorkonfigurierte SageMaker KI-Vorlagen integrieren, können Sie:

Beschleunigen Sie die Amortisierungszeit Ihrer ML-Initiativen.

Helfen Sie mit, konsistente Sicherheit und Governance durchzusetzen.

Stellen Sie Datenwissenschaftlern standardisierte, konforme Umgebungen zur Verfügung.

Reduzieren Sie den betrieblichen Aufwand und die Komplexität der Infrastruktur.

Dieses Muster bietet eine Lösung, die die kritischen Herausforderungen von bewältigt MLOps und außerdem ein skalierbares, wiederholbares Framework bietet, das Innovationen ermöglicht und gleichzeitig die Unternehmensstandards einhält.

Zielpublikum

Dieses Muster richtet sich an ein breites Publikum, das sich innerhalb eines Unternehmens mit ML, Cloud-Architektur und Plattformtechnik befasst. Dies umfasst:

ML-Ingenieure, die ML-Workflow-Implementierungen standardisieren und automatisieren möchten.

Datenwissenschaftler, die Self-Service-Zugriff auf vorkonfigurierte und konforme ML-Umgebungen wünschen.

Plattformingenieure, die für den Aufbau und die Wartung interner Entwicklerplattformen und der gemeinsamen Infrastruktur verantwortlich sind.

Cloud-Architekten, die skalierbare, sichere und kostengünstige Cloud-Lösungen für entwerfen MLOps.

DevOps Ingenieure, die daran interessiert sind, die Praktiken der kontinuierlichen Integration und kontinuierlichen Bereitstellung (CI/CD) auf die Bereitstellung und Workflows der ML-Infrastruktur auszudehnen.

Technische Leiter und Manager, die ML-Initiativen beaufsichtigen und die Teamproduktivität, die Unternehmensführung und die Markteinführungszeit verbessern möchten.

Weitere Informationen zu MLOps Herausforderungen, SageMaker MLOps KI-Modulen und dazu, wie die durch dieses Muster bereitgestellte Lösung den Bedürfnissen Ihrer ML-Teams gerecht werden kann, finden Sie im Abschnitt Zusätzliche Informationen.

Voraussetzungen und Einschränkungen

Voraussetzungen

AWS Identity and Access Management (IAM) -Rollen und Berechtigungen

für die Bereitstellung von Ressourcen in Ihrem AWS-Konto Ein Verständnis der Konzepte von Amazon SageMaker Studio, SageMaker Projects, SageMaker Pipelines und SageMaker Model Registry

Ein Verständnis der IaC-Prinzipien und Erfahrung mit Tools wie AWS Cloud Development Kit (AWS CDK)

Einschränkungen

Eingeschränkte Abdeckung der Vorlagen. Derzeit unterstützt die Lösung nur SageMaker KI-bezogene AIOps Module aus der umfassenderen AIOps Lösung

. Andere Module, wie Ray on Amazon Elastic Kubernetes Service (Amazon EKS) MLflow, Apache Airflow und Fine-Tuning für Amazon Bedrock, sind noch nicht als Backstage-Vorlagen verfügbar. Nicht konfigurierbare Standardeinstellungen. Vorlagen verwenden feste Standardkonfigurationen aus den AIOps SageMaker Modulen ohne Anpassung. Sie können Instanztypen, Speichergrößen, Netzwerkkonfigurationen oder Sicherheitsrichtlinien nicht über die Backstage-Oberfläche ändern, was die Flexibilität für bestimmte Anwendungsfälle einschränkt.

AWS-nur Unterstützung. Die Plattform ist ausschließlich für AWS Bereitstellungen konzipiert und unterstützt keine Multi-Cloud-Szenarien. Organizations, die Cloud-Dienste außerhalb von verwenden, AWS Cloud können diese Vorlagen nicht für ihre ML-Infrastrukturanforderungen verwenden.

Manuelle Verwaltung von Anmeldeinformationen. Sie müssen Ihre AWS Anmeldeinformationen für jede Bereitstellung manuell eingeben. Diese Lösung bietet weder eine Integration mit Anbietern von Unternehmensidentitäten AWS IAM Identity Center noch eine automatische Rotation von Anmeldeinformationen.

Eingeschränktes Lebenszyklusmanagement. Den Vorlagen fehlen umfassende Funktionen für das Ressourcenlebenszyklusmanagement wie automatische Bereinigungsrichtlinien, Empfehlungen zur Kostenoptimierung und Erkennung von Infrastrukturabweichungen. Sie müssen die bereitgestellten Ressourcen nach der Erstellung manuell verwalten und überwachen.

Architektur

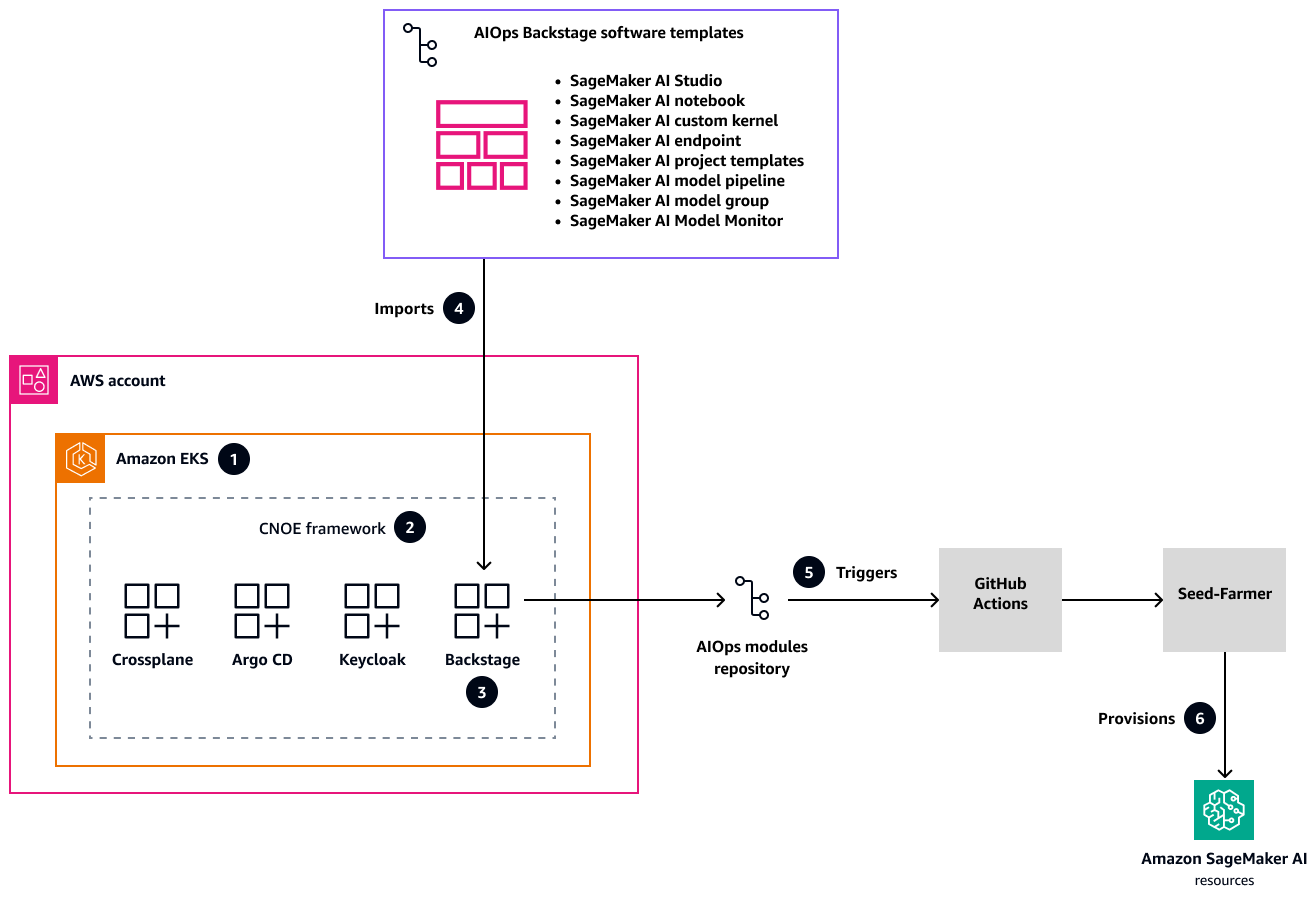

Das folgende Diagramm zeigt die Lösungsarchitektur für ein einheitliches Entwicklerportal, das die Implementierung der ML-Infrastruktur mit SageMaker KI in allen Umgebungen standardisiert und beschleunigt.

In dieser Architektur:

AWS Blueprints zur Anwendungsmodernisierung

sehen die Infrastruktureinrichtung mit einem Amazon EKS-Cluster als Basis für das Cloud Native Operational Excellence (CNOE) -Framework vor. Diese umfassende Lösung bewältigt komplexe Herausforderungen beim Cloud-nativen Infrastrukturmanagement, indem sie eine skalierbare interne Entwicklerplattform (IDP) bereitstellt. Die Blueprints bieten einen strukturierten Ansatz für den Aufbau einer robusten, flexiblen Infrastruktur, die sich an Ihre sich ändernden organisatorischen Anforderungen anpassen kann. Das CNOE-Open-Source-Framework konsolidiert DevOps Tools und löst die Fragmentierung des Ökosystems durch einen einheitlichen Plattform-Engineering-Ansatz. Durch die Zusammenführung unterschiedlicher Tools und Technologien vereinfacht es die komplexe Landschaft der cloudnativen Entwicklung, sodass sich Ihre Teams auf Innovationen statt auf das Toolchain-Management konzentrieren können. Das Framework bietet eine standardisierte Methodik für die Auswahl, Integration und Verwaltung von Entwicklungstools.

Mit CNOE wird Backstage als out-of-the-box Lösung innerhalb des Amazon EKS-Clusters bereitgestellt. Backstage ist mit einer robusten Authentifizierung über Keycloak und umfassenden Bereitstellungsworkflows

über Argo CD ausgestattet. Diese integrierte Plattform schafft eine zentrale Umgebung für die Verwaltung von Entwicklungsprozessen und bietet Teams einen zentralen Ort, an dem sie auf ihre Infrastruktur und Anwendungen in mehreren Umgebungen zugreifen, diese bereitstellen und überwachen können. Ein GitHub Repository enthält vorkonfigurierte AIOps Softwarevorlagen, die den gesamten SageMaker KI-Lebenszyklus abdecken. Diese Vorlagen richten sich an kritische ML-Infrastrukturanforderungen, einschließlich SageMaker Studio-Bereitstellung, Modelltraining, Inferenz-Pipelines und Modellüberwachung. Diese Vorlagen helfen Ihnen dabei, Ihre ML-Initiativen zu beschleunigen und die Konsistenz zwischen verschiedenen Projekten und Teams sicherzustellen.

GitHub Actions

implementiert einen automatisierten Workflow, der die Bereitstellung von Ressourcen über das Seed-Farmer-Hilfsprogramm dynamisch auslöst. Dieser Ansatz integriert den Backstage-Katalog in das AIOps Modul-Repository und sorgt für einen optimierten Infrastrukturbereitstellungsprozess. Die Automatisierung reduziert manuelle Eingriffe, minimiert menschliche Fehler und gewährleistet einen schnellen, konsistenten Aufbau einer Infrastruktur in verschiedenen Umgebungen. Dies AWS CDKhilft Ihnen dabei, Infrastruktur als Code zu definieren und bereitzustellen, und gewährleistet eine wiederholbare, sichere und konforme Bereitstellung von Ressourcen in allen angegebenen Bereichen. AWS-Konten Dieser Ansatz bietet maximale Governance bei minimalem manuellem Aufwand, sodass Sie standardisierte Infrastrukturvorlagen erstellen können, die einfach repliziert, versionsgesteuert und geprüft werden können.

Tools

AWS-Services

AWS Cloud Development Kit (AWS CDK)ist ein Softwareentwicklungs-Framework, das Ihnen hilft, Infrastruktur im Code zu definieren und bereitzustellen AWS Cloud .

Mit Amazon Elastic Kubernetes Service (Amazon EKS) können Sie Kubernetes ausführen, AWS ohne dass Sie Ihre eigene Kubernetes-Steuerebene oder Knoten installieren oder verwalten müssen.

Amazon SageMaker AI ist ein verwalteter ML-Service, der Ihnen hilft, ML-Modelle zu erstellen und zu trainieren und sie dann in einer produktionsbereiten gehosteten Umgebung bereitzustellen.

Andere Tools

Backstage

ist ein Open-Source-Framework, mit dem Sie interne Entwicklerportale erstellen können. GitHub Actions

ist eine CI/CD Plattform, die Workflows zur Softwareentwicklung automatisiert, einschließlich Aufgaben wie dem Erstellen, Testen und Bereitstellen von Code.

Code-Repositorien

Dieses Muster verwendet Code und Vorlagen aus den folgenden GitHub Repositorys:

Implementierung

Diese Implementierung verwendet ein Bereitstellungsmuster für Backstage in Produktionsqualität aus dem Repository Modern Engineering on

Im Abschnitt „Epics“ dieses Musters wird der Implementierungsansatz beschrieben. Ausführliche Anweisungen zur step-by-step Bereitstellung finden Sie im umfassenden Bereitstellungsleitfaden

Erste Bereitstellung der Backstage-Plattform

Integration von SageMaker Software-Vorlagen mit Backstage

Nutzung und Pflege von Backstage-Vorlagen

Der Bereitstellungsleitfaden enthält auch Anleitungen zur laufenden Wartung, Fehlerbehebung und Plattformskalierung.

Bewährte Methoden

Folgen Sie diesen Best Practices, um Sicherheit, Steuerung und betriebliche Exzellenz bei Ihren MLOps Infrastrukturimplementierungen zu gewährleisten.

Verwaltung von Vorlagen

Nehmen Sie niemals grundlegende Änderungen an Live-Vorlagen vor.

Testen Sie Updates immer gründlich, bevor Sie sie in der Produktion einsetzen.

Sorgen Sie für klare und gut dokumentierte Vorlagenversionen.

Sicherheit

Ordnen Sie GitHub Aktionen bestimmten Commit-Secure-Hash-Algorithmen (SHAs) zu, um Angriffe auf die Lieferkette zu verhindern.

Verwenden Sie IAM-Rollen mit geringsten Rechten und detaillierten Berechtigungen.

Speichern Sie vertrauliche Anmeldeinformationen in GitHub Secrets

und. AWS Secrets Manager Kodieren Sie niemals Anmeldeinformationen in Vorlagen fest.

Verwaltung und Nachverfolgung

Implementieren Sie umfassende Standards für die Kennzeichnung von Ressourcen.

Ermöglichen Sie eine präzise Kostenverfolgung und Compliance-Überwachung.

Sorgen Sie für klare Prüfpfade bei Infrastrukturänderungen.

Dieser Leitfaden bietet eine solide Grundlage für die Implementierung dieser Best Practices mithilfe von Backstage-, SageMaker KI- und IaC-Modulen.

Epen

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

Stellen Sie Backstage bereit. | In diesem Schritt werden die Blueprints im AWS Repository Modern Engineering on Die Infrastruktur verwendet Amazon EKS als Container-Orchestrierungsplattform für die Bereitstellung von IDP-Komponenten. Die Amazon EKS-Architektur umfasst sichere Netzwerkkonfigurationen zur strikten Netzwerkisolierung und zur Steuerung von Zugriffsmustern. Die Plattform ist in Authentifizierungsmechanismen integriert, um den Benutzerzugriff über Dienste und Umgebungen hinweg zu sichern. | Plattformingenieur |

Richten Sie Ihre SageMaker KI-Vorlagen ein. | In diesem Schritt werden die Skripts in der GitHub AIOps internen Entwicklerplattform (IDP) mit dem Backstage-Repository Durch diesen Prozess wird ein Repository erstellt, das die SageMaker AI-Vorlagen enthält, die für die Integration mit Backstage erforderlich sind. | Plattformingenieur |

Integrieren Sie die SageMaker KI-Vorlagen in Backstage. | Folgen Sie den Anweisungen im Abschnitt zur Integration von SageMaker Vorlagen In diesem Schritt werden die AIOps Module (SageMaker KI-Vorlagen aus dem letzten Schritt) in Ihre Backstage-Implementierung integriert, sodass Sie Ihre ML-Infrastrukturanforderungen selbst erfüllen können. | Plattformingenieur |

Verwenden Sie die SageMaker KI-Vorlagen von Backstage. | Folgen Sie den Anweisungen im Abschnitt SageMaker Vorlagen verwenden Im Backstage-Portal können Sie aus verfügbaren SageMaker KI-Vorlagen auswählen, darunter Optionen für SageMaker Studio-Umgebungen, SageMaker Notizbücher, benutzerdefinierte SageMaker Projektvorlagen und Modellbereitstellungspipelines. Nachdem Sie die Konfigurationsparameter angegeben haben, erstellt die Plattform automatisch spezielle Repositorys und stellt AWS Ressourcen über GitHub Actions und Seed-Farmer bereit. Sie können den Fortschritt anhand von GitHub Aktionsprotokollen und dem Backstage-Komponentenkatalog überwachen. | Datenwissenschaftler, Dateningenieur, Entwickler |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

Aktualisieren Sie SageMaker KI-Vorlagen. | Gehen Sie wie folgt vor, um eine SageMaker AI-Vorlage in Backstage zu aktualisieren.

| Plattformingenieur |

Erstellen und verwalten Sie mehrere Versionen einer Vorlage. | Für grundlegende Änderungen oder Upgrades möchten Sie möglicherweise mehrere Versionen einer SageMaker AI-Vorlage erstellen.

| Plattformingenieur |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

Erweitern Sie die Reichweite von Vorlagen über SageMaker KI hinaus. | Die aktuelle Lösung implementiert nur SageMaker KI-bezogene AIOps Vorlagen. Sie können die ML-Umgebung erweitern, indem Sie AIOps Module Sie können auch Muster der Vorlagenvererbung implementieren, um spezielle Versionen von Basisvorlagen zu erstellen. Diese Erweiterbarkeit ermöglicht es Ihnen, verschiedene AWS Ressourcen und Anwendungen über SageMaker KI hinaus zu verwalten und gleichzeitig die vereinfachte Entwicklererfahrung und die Standards Ihres Unternehmens beizubehalten. | Plattformingenieur |

Verwenden Sie die dynamische Parameterinjektion. | Die aktuellen Vorlagen verwenden Standardkonfigurationen ohne Anpassung und führen die Seed-Farmer-CLI aus, um Ressourcen mit Standardvariablen bereitzustellen. Sie können die Standardkonfiguration erweitern, indem Sie die dynamische Parameterinjektion für modulspezifische Konfigurationen verwenden. | Plattformingenieur |

Verbessern Sie Sicherheit und Compliance. | Um die Sicherheit bei der Erstellung von AWS-Ressourcen zu erhöhen, können Sie die Integration der rollenbasierten Zugriffskontrolle (RBAC) mit Single Sign-On (SSO), SAML, OpenID Connect (OIDC) und der Durchsetzung von Richtlinien als Code aktivieren. | Plattformingenieur |

Fügen Sie eine automatische Ressourcenbereinigung hinzu. | Sie können Funktionen für automatische Bereinigungsrichtlinien aktivieren und auch die Erkennung und Behebung von Infrastrukturabweichungen hinzufügen. | Plattformingenieur |

| Aufgabe | Beschreibung | Erforderliche Fähigkeiten |

|---|---|---|

Entfernen Sie die Backstage-Infrastruktur und die SageMaker KI-Ressourcen. | Wenn Sie mit der Nutzung Ihrer ML-Umgebung fertig sind, folgen Sie den Anweisungen im Abschnitt Säuberung und Ressourcenmanagement | Plattformingenieur |

Fehlersuche

| Problem | Lösung |

|---|---|

AWS CDK Bootstrap-Fehler | Überprüfen Sie die AWS Anmeldeinformationen und die Regionskonfiguration. |

Probleme beim Zugriff auf Amazon EKS-Cluster | Überprüfen Sie die Kubectl-Konfiguration und die IAM-Berechtigungen. |

Verbindungsprobleme mit dem Application Load Balancer | Stellen Sie sicher, dass Sicherheitsgruppen eingehenden Datenverkehr auf Port 80/443 zulassen. |

GitHub Probleme bei der Integration | Überprüfen Sie die GitHub Token-Berechtigungen und den Zugriff auf die Organisation. |

SageMaker Fehler bei der KI-Bereitstellung | Überprüfen Sie die AWS-Service Kontingente und IAM-Berechtigungen. |

Zugehörige Ressourcen

Plattformtechnik (im Leitfaden AWS Cloud Adoption Framework: Plattformperspektive)

Backstage-Softwarevorlagen

(Backstage-Website) AIOps Modul-Repository

(Sammlung wiederverwendbarer IaC-Module für ML) AIOps interne Entwicklerplattform (IDP) mit

Backstage-Repository Modernes Engineering

im Repository AWS

Zusätzliche Informationen

Geschäftliche Herausforderungen

Organizations, die ihre MLOps Initiativen ergreifen oder skalieren, stehen häufig vor diesen geschäftlichen und technischen Herausforderungen:

Inkonsistente Umgebungen. Das Fehlen standardisierter Entwicklungs- und Bereitstellungsumgebungen erschwert die Zusammenarbeit und erhöht die Bereitstellungsrisiken.

Mehraufwand bei der manuellen Bereitstellung. Die manuelle Einrichtung einer ML-Infrastruktur mit SageMaker Studio, Amazon Simple Storage Service (Amazon S3) -Buckets, IAM-Rollen und CI/CD Pipelines ist zeitaufwändig und fehleranfällig und lenkt Datenwissenschaftler von ihrer Kernaufgabe, der Modellentwicklung, ab.

Mangelnde Auffindbarkeit und Wiederverwendung. Das Fehlen eines zentralisierten Katalogs macht es schwierig, bestehende ML-Modelle, Datensätze und Pipelines zu finden. Dies führt zu redundanter Arbeit und verpassten Möglichkeiten zur Wiederverwendung.

Komplexe Unternehmensführung und Einhaltung von Vorschriften. Ohne automatisierte Leitplanken kann es schwierig sein, sicherzustellen, dass ML-Projekte den organisatorischen Sicherheitsrichtlinien, Datenschutzbestimmungen und Compliance-Standards wie dem Health Insurance Portability and Accountability Act (HIPAA) und der Allgemeinen Datenschutzverordnung (GDPR) entsprechen.

Langsame Amortisierung. Die kumulative Wirkung dieser Herausforderungen führt zu längeren Lebenszyklen von ML-Projekten und verzögert die Realisierung des Geschäftswerts aus ML-Investitionen.

Sicherheitsrisiken. Inkonsistente Konfigurationen und manuelle Prozesse können zu Sicherheitslücken führen, die die Durchsetzung der geringsten Rechte und die Netzwerkisolierung erschweren.

Diese Probleme verlängern die Entwicklungszyklen, erhöhen den betrieblichen Aufwand und führen zu Sicherheitsrisiken. Der iterative Charakter von ML erfordert wiederholbare Workflows und eine effiziente Zusammenarbeit.

Gartner prognostiziert, dass bis 2026 80% der Softwareentwicklungsunternehmen über Plattformteams verfügen werden. (Weitere Informationen finden Sie auf der Gartner-Website unter Platform Engineering ermöglicht Entwicklern, besser, schneller und glücklicher zu sein

MLOps SageMaker Module

Die AIOps Module

Die direkte Nutzung der AIOps Module erfordert oft, dass Plattformteams diese IaC-Vorlagen bereitstellen und verwalten, was für Datenwissenschaftler, die Self-Service-Zugriff wünschen, eine Herausforderung darstellen kann. Um die verfügbaren Vorlagen zu ermitteln und zu verstehen, die erforderlichen Parameter zu konfigurieren und ihre Bereitstellung auszulösen, müssen Sie möglicherweise in AWS-Service Konsolen navigieren oder direkt mit IaC-Tools interagieren. Dies kann zu Reibungserscheinungen führen, die kognitive Belastung für Datenwissenschaftler erhöhen, die es vorziehen, sich auf ML-Aufgaben zu konzentrieren, und möglicherweise zu inkonsistenten Parametrisierungen oder Abweichungen von Unternehmensstandards führen, wenn diese Vorlagen nicht über eine zentrale und benutzerfreundliche Oberfläche verwaltet werden. Die Integration dieser leistungsstarken AIOps Module mit einem IDP wie Backstage hilft bei der Bewältigung dieser Herausforderungen, indem sie ein optimiertes Self-Service-Erlebnis, eine verbesserte Auffindbarkeit und stärkere Governance-Kontrollen für die Verwendung dieser standardisierten Bausteine bietet. MLOps

Backstage als IDP

Eine interne Entwicklerplattform (IDP) ist eine Self-Service-Ebene, die von Plattformteams entwickelt wurde, um die Art und Weise zu vereinfachen und zu standardisieren, wie Entwickler Anwendungen erstellen, bereitstellen und verwalten. Sie abstrahiert die Komplexität der Infrastruktur und bietet Entwicklern über eine einheitliche Oberfläche einfachen Zugriff auf Tools, Umgebungen und Dienste.

Das Hauptziel eines IDP besteht darin, die Erfahrung und Produktivität der Entwickler zu verbessern, und zwar durch:

Aktivierung von Self-Service für Aufgaben wie die Erstellung und Bereitstellung von Diensten.

Förderung von Konsistenz und Konformität durch Standardvorlagen.

Integration von Tools im gesamten Entwicklungszyklus (CI/CD, Überwachung und Dokumentation).

Backstage ist ein Open-Source-Entwicklerportal, das von Spotify erstellt wurde und heute Teil der Cloud Native Computing Foundation (CNCF) ist. Es unterstützt Unternehmen beim Aufbau ihres eigenen IDP, indem es eine zentrale, erweiterbare Plattform zur Verwaltung von Softwarekomponenten, Tools und Dokumentation bereitstellt. Mit Backstage können Entwickler:

Entdecken und verwalten Sie alle internen Dienste über einen Softwarekatalog.

Erstellen Sie neue Projekte mithilfe vordefinierter Vorlagen über das Scaffolder-Plugin.

Greifen Sie von einem Standort aus auf integrierte Tools wie CI/CD Pipelines, Kubernetes-Dashboards und Überwachungssysteme zu.

Sorgen Sie durchgehend für eine konsistente, auf Markdown basierende Dokumentation. TechDocs

HÄUFIG GESTELLTE FRAGEN

Was ist der Unterschied zwischen der Verwendung dieser Backstage-Vorlage und der manuellen Bereitstellung von SageMaker Studio über die Konsole? SageMaker

Die Backstage-Vorlage bietet mehrere Vorteile gegenüber der manuellen AWS Konsolenbereitstellung, darunter standardisierte Konfigurationen, die den Best Practices der Organisation folgen, automatisierte IaC-Bereitstellung mit Seed-Farmer und dem AWS CDK, integrierte Sicherheitsrichtlinien und Compliance-Maßnahmen sowie die Integration in die Entwickler-Workflows Ihres Unternehmens durch. GitHub Die Vorlage ermöglicht außerdem reproduzierbare Bereitstellungen mit Versionskontrolle, die es einfacher machen, Umgebungen in verschiedenen Phasen (Entwicklung, Staging, Produktion) zu replizieren und die Konsistenz zwischen den Teams aufrechtzuerhalten. Darüber hinaus umfasst die Vorlage automatische Bereinigungsfunktionen und lässt sich über Backstage in das Identitätsmanagementsystem Ihres Unternehmens integrieren. Die manuelle Bereitstellung über die Konsole erfordert AWS fundiertes Fachwissen und bietet weder Versionskontrolle noch das gleiche Maß an Standardisierung und Steuerung, das die Vorlage bietet. Aus diesen Gründen eignen sich Konsolenbereitstellungen eher für einmalige Experimente als ML-Produktionsumgebungen.

Was ist Seed-Farmer und warum verwendet diese Lösung es?

Seed-Farmer ist ein Tool AWS zur Orchestrierung von Bereitstellungen, das Infrastrukturmodule mithilfe von verwaltet. AWS CDK Dieses Muster verwendet Seed-Farmer, da es standardisierte, wiederverwendbare Infrastrukturkomponenten bereitstellt, die speziell für AI/ML Workloads entwickelt wurden, komplexe Abhängigkeiten zwischen diesen Komponenten AWS-Services automatisch handhabt und konsistente Bereitstellungen in verschiedenen Umgebungen gewährleistet.

Muss ich das installieren, um diese Vorlagen verwenden AWS CLI zu können?

Nein, Sie müssen das nicht AWS CLI auf Ihrem Computer installieren. Die Vorlagen werden vollständig über GitHub Aktionen in der Cloud ausgeführt. Sie geben Ihre AWS Anmeldeinformationen (Zugriffsschlüssel, geheimer Schlüssel und Sitzungstoken) über die Backstage-Oberfläche ein, und die Bereitstellung erfolgt automatisch in der GitHub Aktionsumgebung.

Wie lange dauert die Bereitstellung einer SageMaker Studio-Umgebung?

Eine typische SageMaker Studio-Bereitstellung dauert 15 bis 25 Minuten. Dazu gehören AWS CDK Bootstrapping (2-3 Minuten), die Einrichtung der Seed-Farmer-Toolchain (3—5 Minuten) und die Erstellung von Ressourcen (10—15 Minuten). Die genaue Zeit hängt von Ihnen AWS-Region und der Komplexität Ihres Netzwerk-Setups ab.

Kann ich mehrere SageMaker Umgebungen in derselben Umgebung bereitstellen AWS-Konto?

Ja, das können Sie. Bei jeder Bereitstellung werden Ressourcen mit eindeutigen Namen erstellt, die auf dem Komponentennamen basieren, den Sie in der Vorlage angeben. Beachten Sie jedoch die AWS-Service Kontingente: Jedes Konto kann eine begrenzte Anzahl von SageMaker Domains pro Region haben. Überprüfen Sie daher Ihre Kontingente, bevor Sie mehrere Umgebungen erstellen.