Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Generative KI-Agenten: Ersetzen symbolischer Logik durch LLMs

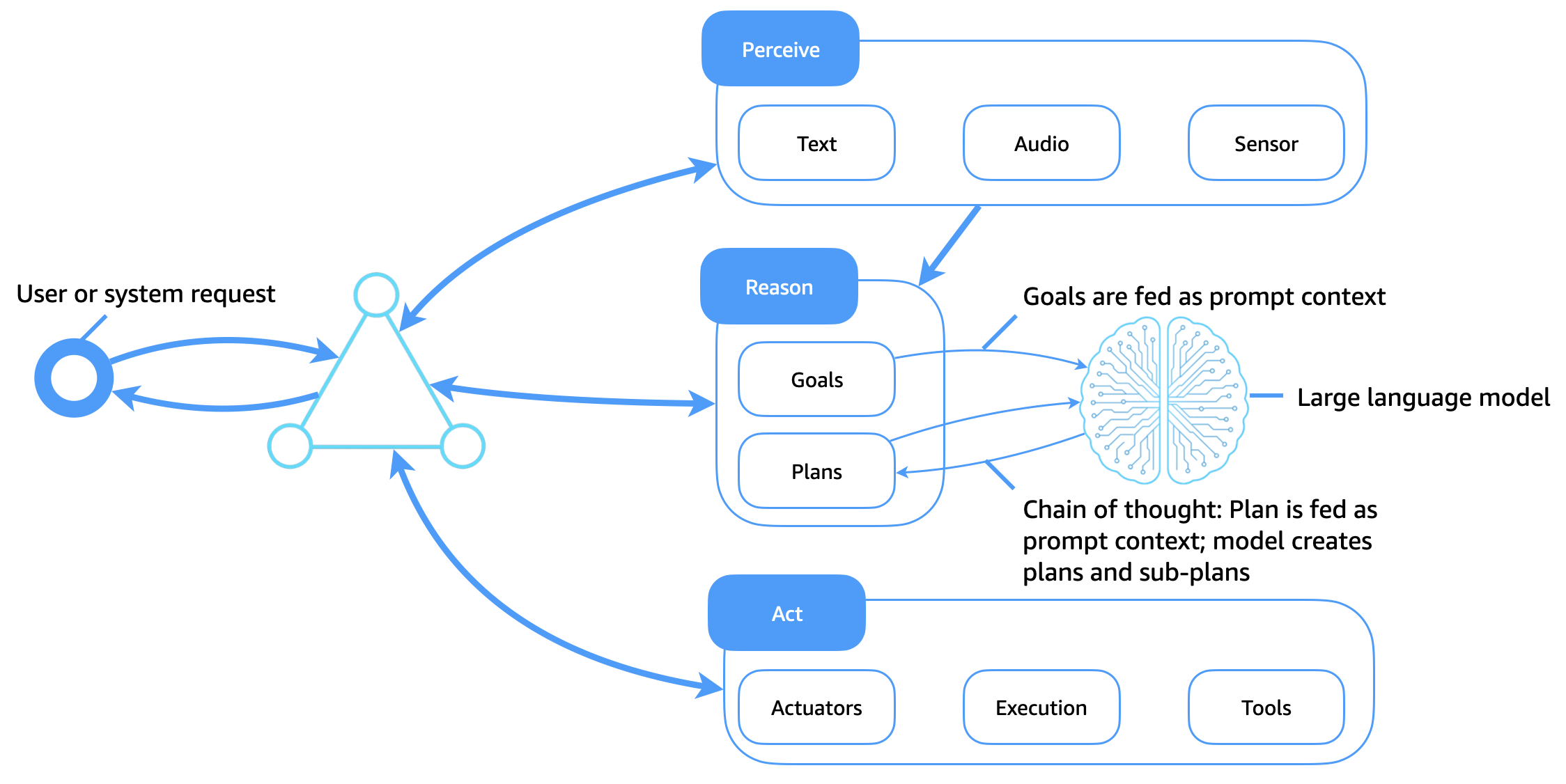

Das folgende Diagramm zeigt, wie große Sprachmodelle (LLMs) heute als flexibler und intelligenter kognitiver Kern für Softwareagenten dienen. Im Gegensatz zu herkömmlichen symbolischen Logiksystemen, die auf statischen Planbibliotheken und handcodierten Regeln basieren, LLMs ermöglichen sie adaptives Denken, kontextuelle Planung und dynamischen Einsatz von Tools, die die Art und Weise verändern, wie Agenten wahrnehmen, argumentieren und handeln.

Die wichtigsten Verbesserungen

Diese Architektur erweitert die herkömmliche Agentenarchitektur wie folgt:

-

LLMs als kognitive Engines: Ziele, Pläne und Abfragen werden als prompter Kontext an das Modell übergeben. Das LLM generiert Argumentationswege (z. B. Gedankenketten), zerlegt Aufgaben in Unterziele und entscheidet über die nächsten Maßnahmen.

-

Einsatz von Tools durch Eingabeaufforderungen: LLMs kann durch Tools oder durch Reasoning and Acting (ReAct) gesteuert werden, die dazu auffordern, Ergebnisse aufzurufen und zu suchen, abzufragen, zu berechnen APIs und zu interpretieren.

-

Kontextsensitive Planung: Agenten generieren oder überarbeiten Pläne dynamisch auf der Grundlage des aktuellen Ziels, der Eingabeumgebung und des Feedbacks des Agenten, ohne dass fest codierte Planbibliotheken erforderlich sind.

-

Prompt-Kontext als Speicher: Anstatt symbolische Wissensdatenbanken zu verwenden, kodieren Agenten Speicher, Pläne und Ziele als Eingabeaufforderungs-Token, die an das Modell übergeben werden.

-

Lernen durch gezieltes, kontextbezogenes Lernen: LLMs Passen Sie Verhaltensweisen durch promptes Engineering an, wodurch die Notwendigkeit expliziter Umschulungen oder starre Planbibliotheken reduziert wird.

Erreichen des Langzeitgedächtnisses bei auf LLM basierenden Wirkstoffen

Im Gegensatz zu herkömmlichen Agenten, die das Langzeitgedächtnis in strukturierten Wissensdatenbanken speicherten, müssen generative KI-Agenten innerhalb der Einschränkungen des Kontextfensters von arbeiten. LLMs Um das Gedächtnis zu erweitern und persistente Intelligenz zu unterstützen, verwenden generative KI-Agenten mehrere sich ergänzende Techniken: Agentenspeicher, Retrieval-Augmented Generation (RAG), kontextinternes Lernen und Prompt-Chaining sowie Vortraining.

Agentenspeicher: externes Langzeitgedächtnis

Agentenstatus, Benutzerverlauf, Entscheidungen und Ergebnisse werden in einem langfristigen Agentenspeicher (z. B. einer Vektordatenbank, einem Objektspeicher oder einem Dokumentenspeicher) gespeichert. Relevante Erinnerungen werden bei Bedarf abgerufen und zur Laufzeit in den LLM-Prompt-Kontext eingefügt. Dadurch entsteht eine persistente Speicherschleife, in der der Agent die Kontinuität zwischen Sitzungen, Aufgaben oder Interaktionen beibehält.

LAPPEN

RAG verbessert die Leistung von LLM, indem es abgerufenes Wissen mit generativen Fähigkeiten kombiniert. Wenn ein Ziel oder eine Abfrage ausgegeben wird, durchsucht der Agent einen Abrufindex (z. B. durch eine semantische Suche nach Dokumenten, früheren Konversationen oder strukturiertem Wissen). Die abgerufenen Ergebnisse werden an die LLM-Eingabeaufforderung angehängt, wodurch die Generierung auf externen Fakten oder einem personalisierten Kontext basiert. Diese Methode erweitert das effektive Gedächtnis des Agenten und verbessert die Zuverlässigkeit und sachliche Richtigkeit.

Kontextbezogenes Lernen und schnelle Verkettung

Agenten pflegen das Kurzzeitgedächtnis, indem sie den Token-Kontext der Sitzung und die strukturierte Verkettung von Eingabeaufforderungen verwenden. Kontextuelle Elemente, wie der aktuelle Plan, die Ergebnisse früherer Aktionen und der Agentenstatus, werden zwischen Aufrufen weitergegeben, um das Verhalten zu steuern.

Kontinuierliche Vorschulung und Feinabstimmung

Für domänenspezifische Agenten LLMs kann die Vorschulung mit benutzerdefinierten Sammlungen wie Protokollen, Unternehmensdaten oder Produktdokumentationen fortgesetzt werden. Alternativ kann durch Feinabstimmung von Anweisungen oder Reinforcement-Learning auf Basis von menschlichem Feedback (RLHF) agentenähnliches Verhalten direkt in das Modell integriert werden. Dadurch werden die Argumentationsmuster von der Prompt-Time-Logik in die interne Repräsentation des Modells verlagert, die Länge der Eingabeaufforderungen reduziert und die Effizienz verbessert.

Kombinierte Vorteile agentischer KI

Wenn diese Techniken zusammen verwendet werden, ermöglichen es generativen KI-Agenten:

-

Behalten Sie das kontextuelle Bewusstsein im Laufe der Zeit bei.

-

Passen Sie das Verhalten auf der Grundlage der Benutzerhistorie oder der Präferenzen an.

-

Treffen Sie Entscheidungen up-to-date, indem Sie Faktenwissen oder privates Wissen nutzen.

-

Skalieren Sie Ihr Verhalten auf Unternehmensanwendungsfälle mit beständigem, regelkonformem und erklärbarem Verhalten.

Durch die Erweiterung LLMs mit externem Speicher, Abrufebenen und kontinuierlicher Schulung können Agenten ein Maß an kognitiver Kontinuität und Zielsetzung erreichen, das zuvor mit symbolischen Systemen allein nicht erreicht werden konnte.