Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Kernbausteine von Softwareagenten

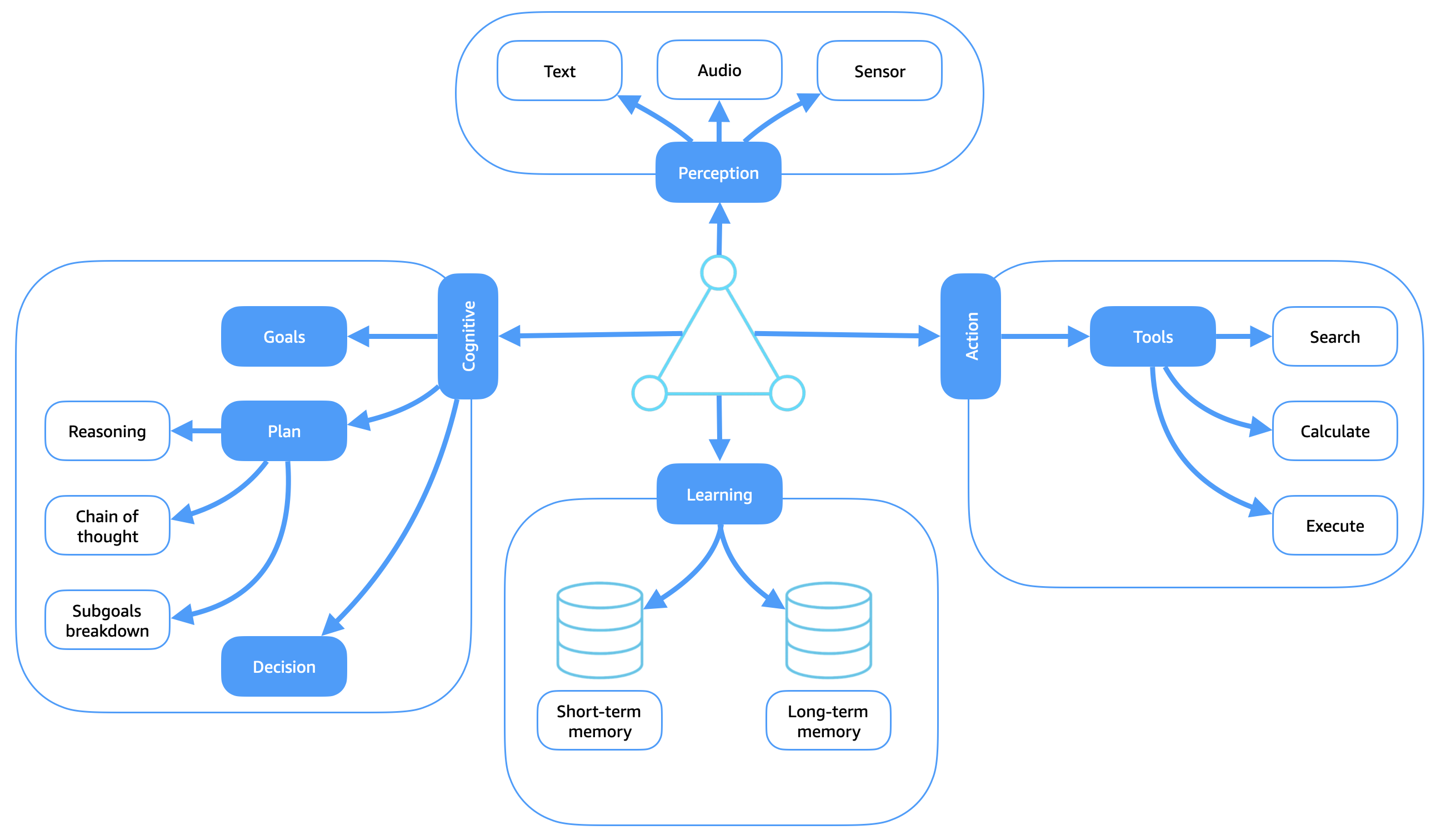

Das folgende Diagramm zeigt die wichtigsten Funktionsmodule, die in den meisten intelligenten Agenten zu finden sind. Jede Komponente trägt dazu bei, dass der Agent in komplexen Umgebungen autonom arbeiten kann.

Im Rahmen der Schleife „Wahrnehmen, Vernunft/Handeln“ verteilt sich das Denkvermögen eines Agenten sowohl auf seine kognitiven als auch auf seine Lernmodule. Durch die Integration von Gedächtnis und Lernen entwickelt der Agent adaptives Denken, das auf früheren Erfahrungen basiert. Wenn der Agent in seiner Umgebung agiert, erzeugt er eine emergente Rückkopplungsschleife: Jede Aktion beeinflusst future Wahrnehmungen, und die daraus resultierende Erfahrung wird durch das Lernmodul in das Gedächtnis und in interne Modelle aufgenommen. Diese kontinuierliche Schleife aus Wahrnehmung, Argumentation und Handlung ermöglicht es dem Agenten, sich im Laufe der Zeit zu verbessern, und schließt den gesamten Zyklus „Wahrnehmen, Denken und Handeln“ ab.

Modul „Wahrnehmung“

Das Wahrnehmungsmodul ermöglicht es dem Agenten, über verschiedene Eingabemodalitäten wie Text, Audio und Sensoren mit seiner Umgebung zu interagieren. Diese Eingaben bilden die Rohdaten, auf denen alle Überlegungen und Handlungen basieren. Texteingaben können Eingabeaufforderungen in natürlicher Sprache, strukturierte Befehle oder Dokumente beinhalten. Zu den Audioeingängen gehören gesprochene Anweisungen oder Umgebungsgeräusche. Zu den Sensoreingängen gehören physische Daten wie visuelle Feeds, Bewegungssignale oder GPS-Koordinaten. Die Kernfunktion der Wahrnehmung besteht darin, aus diesen Rohdaten aussagekräftige Merkmale und Repräsentationen zu extrahieren. Dies ermöglicht es dem Agenten, ein genaues und umsetzbares Verständnis seines aktuellen Kontextes zu entwickeln. Der Prozess kann die Extraktion von Merkmalen, die Erkennung von Objekten oder Ereignissen und die semantische Interpretation beinhalten und ist der entscheidende erste Schritt in der Schleife „Wahrnehmen, Begründen, Handeln“. Eine effektive Wahrnehmung stellt sicher, dass nachgelagerte Überlegungen und Entscheidungen auf relevantem Situationsbewusstsein beruhen. up-to-date

Kognitives Modul

Das kognitive Modul dient als beratender Kern des Softwareagenten. Es ist dafür verantwortlich, Wahrnehmungen zu interpretieren, Absichten zu entwickeln und zielgerichtetes Verhalten durch zielgerichtete Planung und Entscheidungsfindung zu lenken. Dieses Modul wandelt Eingaben in strukturierte Argumentationsprozesse um, die es dem Agenten ermöglichen, bewusst statt reaktiv zu handeln. Diese Prozesse werden über drei wichtige Untermodule gesteuert: Ziele, Planung und Entscheidungsfindung.

Untermodul „Ziele“

Das Untermodul Ziele definiert die Absicht und Richtung des Agenten. Ziele können explizit (z. B. „zu einem Standort navigieren“ oder „Bericht einreichen“) oder implizit (z. B. „Benutzerinteraktion maximieren“ oder „Latenz minimieren“) sein. Sie sind von zentraler Bedeutung für den Argumentationszyklus des Agenten und bilden die Grundlage für seine Planung und Entscheidungen.

Der Agent bewertet kontinuierlich, welche Fortschritte bei der Erreichung seiner Ziele erzielt wurden. Je nach neuen Erkenntnissen oder neuen Erkenntnissen kann er Ziele neu priorisieren oder neu definieren. Dieses Zielbewusstsein sorgt dafür, dass der Agent in dynamischen Umgebungen anpassungsfähig bleibt.

Untermodul „Planung“

Das Planungs-Submodul entwickelt Strategien, um die aktuellen Ziele des Agenten zu erreichen. Es generiert Aktionssequenzen, zerlegt Aufgaben hierarchisch und wählt aus vordefinierten oder dynamisch generierten Plänen aus.

Um in nicht deterministischen oder sich verändernden Umgebungen effektiv arbeiten zu können, ist Planung nicht statisch. Moderne Agenten können chain-of-thought Sequenzen generieren, Teilziele als Zwischenschritte einführen und Pläne in Echtzeit überarbeiten, wenn sich die Bedingungen ändern.

Dieses Untermodul ist eng mit Gedächtnis und Lernen verknüpft und ermöglicht es dem Agenten, seine Planung im Laufe der Zeit auf der Grundlage früherer Ergebnisse zu verfeinern.

Untermodul „Entscheidungsfindung“

Das Untermodul Entscheidungsfindung bewertet die verfügbaren Pläne und Maßnahmen, um den am besten geeigneten nächsten Schritt auszuwählen. Es integriert Informationen aus der Wahrnehmung, den aktuellen Plan, die Ziele des Agenten und den Umweltkontext.

Die Entscheidungsfindung berücksichtigt:

-

Kompromisse zwischen widersprüchlichen Zielen

-

Vertrauensschwellen (z. B. Unsicherheit in der Wahrnehmung)

-

Folgen von Handlungen

-

Die erlernte Erfahrung des Agenten

Je nach Architektur können sich Agenten auf symbolisches Denken, Heuristik, Reinforcement-Learning oder Sprachmodelle (LLMs) verlassen, um fundierte Entscheidungen zu treffen. Dieser Prozess stellt sicher, dass das Verhalten des Agenten kontextsensitiv, zielgerichtet und anpassungsfähig bleibt.

Aktionsmodul

Das Aktionsmodul ist dafür verantwortlich, die vom Agenten ausgewählten Entscheidungen auszuführen und sich mit der Außenwelt oder internen Systemen zu verbinden, um sinnvolle Effekte zu erzielen. Es stellt die Phase des Handelns in der Schleife „Wahrnehmen, Vernunft/Handeln“ dar, in der Absicht in Verhalten umgewandelt wird.

Wenn das kognitive Modul eine Aktion auswählt, koordiniert das Aktionsmodul die Ausführung mithilfe spezialisierter Submodule, wobei jedes Submodul auf die integrierte Umgebung des Agenten abgestimmt ist:

-

Physische Betätigung: Für Agenten, die in Robotersysteme oder IoT-Geräte eingebettet sind, übersetzt dieses Submodul Entscheidungen in reale physische Bewegungen oder Anweisungen auf Hardwareebene.

Beispiele: Steuerung eines Roboters, Auslösung eines Ventils, Einschalten eines Sensors.

-

Integrierte Interaktion: Dieses Untermodul verarbeitet nicht-physische, aber von außen sichtbare Aktionen wie die Interaktion mit Softwaresystemen, Plattformen oder. APIs

Beispiele: Senden eines Befehls an einen Cloud-Dienst, Aktualisieren einer Datenbank, Senden eines Berichts durch Aufrufen einer API.

-

Aufruf von Tools: Agenten erweitern ihre Fähigkeiten häufig, indem sie spezielle Tools verwenden, um Unteraufgaben wie die folgenden zu erledigen:

-

Suche: Abfragen strukturierter oder unstrukturierter Wissensquellen

-

Zusammenfassung: Komprimierung großer Texteingaben zu übersichtlichen Übersichten

-

Berechnung: Durchführung logischer, numerischer oder symbolischer Berechnungen

Der Aufruf von Tools ermöglicht die Zusammenstellung komplexer Verhaltensweisen durch modulare, aufrufbare Fähigkeiten.

-

Lernmodul

Das Lernmodul ermöglicht es Agenten, sich im Laufe der Zeit auf der Grundlage von Erfahrungen anzupassen, zu verallgemeinern und zu verbessern. Es unterstützt den Argumentationsprozess, indem es die internen Modelle, Strategien und Entscheidungsrichtlinien des Agenten kontinuierlich verfeinert, indem es Feedback aus Wahrnehmung und Handlung nutzt.

Dieses Modul arbeitet sowohl mit dem Kurzzeit- als auch mit dem Langzeitgedächtnis zusammen:

-

Kurzzeitgedächtnis: Speichert vorübergehenden Kontext wie den Status eines Dialogs, aktuelle Aufgabeninformationen und aktuelle Beobachtungen. Es hilft dem Agenten, die Kontinuität der Interaktionen und Aufgaben aufrechtzuerhalten.

-

Langzeitgedächtnis: Kodiert beständiges Wissen aus vergangenen Erfahrungen, einschließlich zuvor erreichter Ziele, Ergebnisse von Maßnahmen und Umweltzuständen. Das Langzeitgedächtnis ermöglicht es dem Agenten, Muster zu erkennen, Strategien wiederzuverwenden und Wiederholungen von Fehlern zu vermeiden.

Lernmodi

Das Lernmodul unterstützt eine Reihe von Paradigmen, wie z. B. überwachtes, unbeaufsichtigtes und verstärkendes Lernen, die unterschiedliche Umgebungen und Agentenrollen unterstützen:

-

Überwachtes Lernen: Aktualisiert interne Modelle auf der Grundlage beschrifteter Beispiele, die häufig auf menschlichem Feedback oder Trainingsdatensätzen basieren.

Beispiel: Lernen, Benutzerabsichten auf der Grundlage früherer Konversationen zu klassifizieren.

-

Unüberwachtes Lernen: Identifiziert versteckte Muster oder Strukturen in Daten ohne explizite Bezeichnungen.

Beispiel: Clustering von Umgebungssignalen zur Erkennung von Anomalien.

-

Reinforcement-Learning: Optimiert das Verhalten durch Versuch und Irrtum, indem die kumulative Belohnung in interaktiven Umgebungen maximiert wird.

Beispiel: Lernen, welche Strategie zur schnellsten Erledigung der Aufgabe führt.

Das Lernen ist eng mit dem kognitiven Modul des Agenten verknüpft. Es verfeinert die Planungsstrategien auf der Grundlage vergangener Ergebnisse, verbessert die Entscheidungsfindung durch die Bewertung historischer Erfolge und verbessert kontinuierlich die Zuordnung zwischen Wahrnehmung und Handlung. Durch diesen geschlossenen Lern- und Feedbackkreislauf entwickeln sich die Akteure über die reaktive Ausführung hinaus zu sich selbst verbessernden Systemen, die sich im Laufe der Zeit an neue Ziele, Bedingungen und Kontexte anpassen können.