Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Konfigurieren erweiterter Prompts

Sie können erweiterte Prompts in der AWS-Managementkonsole oder über die API konfigurieren.

- Console

-

In der Konsole können Sie erweiterte Prompts konfigurieren, nachdem Sie den Agenten erstellt haben. Diese konfigurieren Sie, während Sie den Agenten bearbeiten.

Um erweiterte Prompts für Ihren Agenten anzuzeigen oder zu bearbeiten

-

Melden Sie sich bei der AWS-Managementkonsole mit einer IAM-Identität an, die zur Verwendung der Amazon-Bedrock-Konsole berechtigt ist. Öffnen Sie dann die Amazon-Bedrock-Konsole unter https://console.aws.amazon.com/bedrock

. -

Wählen Sie im linken Navigationsbereich die Option Kundendienstmitarbeiter aus. Wählen Sie im Abschnitt Agenten einen Agenten aus.

-

Wählen Sie auf der Detailseite des Agenten im Abschnitt Arbeitsentwurf die Option Arbeitsentwurf aus.

-

Wählen Sie auf der Seite Arbeitsentwurf im Abschnitt Orchestrierungsstrategie die Option Bearbeiten aus.

-

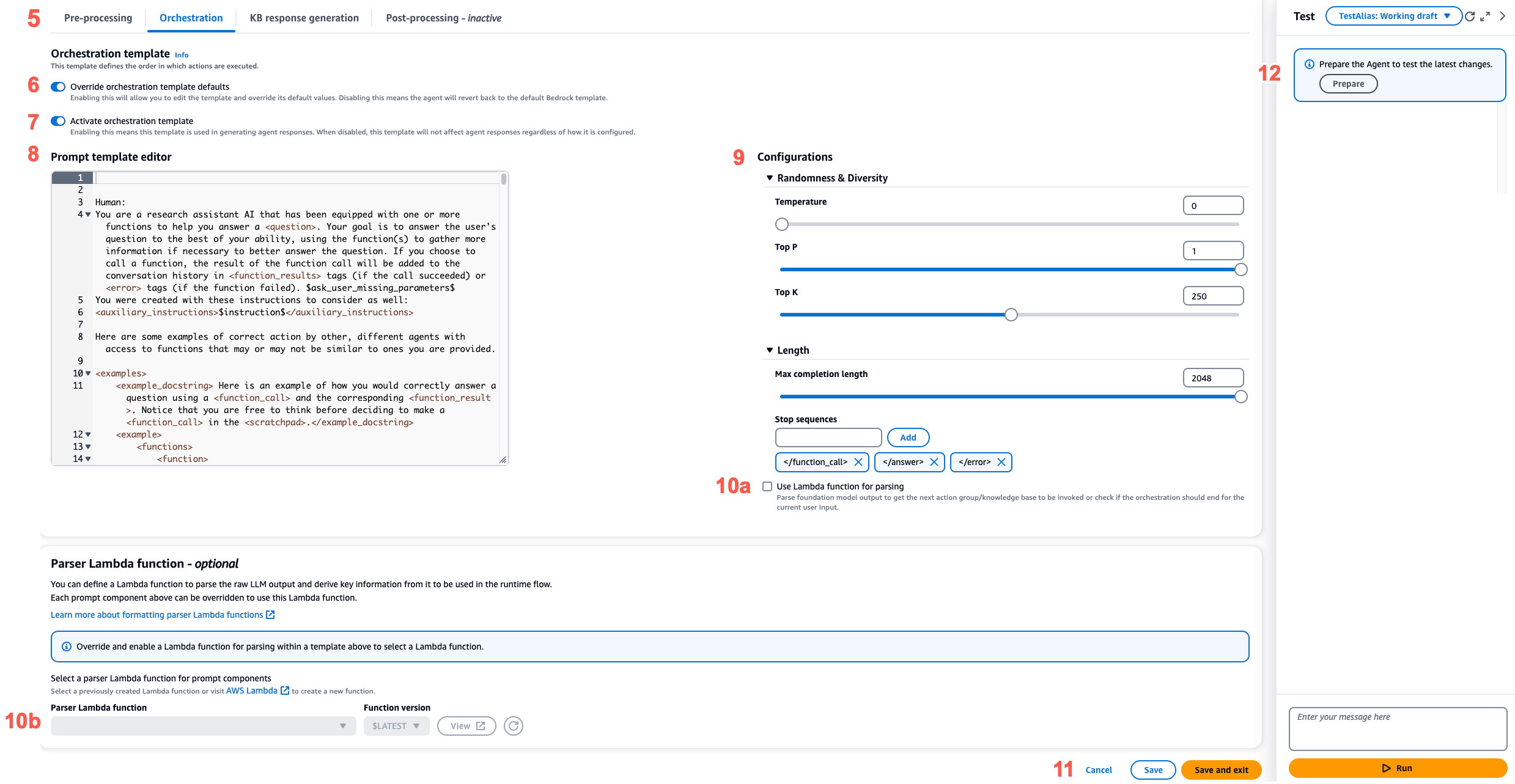

Stellen Sie auf der Seite Orchestrierungsstrategie im Abschnitt Details zur Orchestrierungsstrategie sicher, dass die Standardorchestrierung ausgewählt ist, und wählen Sie dann die Registerkarte aus, die dem Schritt der Agentensequenz entspricht, den Sie bearbeiten möchten.

-

Aktivieren Sie die Option Vorlagenstandards überschreiben, um die Bearbeitung der Vorlage zu ermöglichen. Wählen Sie im Dialogfeld Vorlagenstandardwerte überschreiben die Option Bestätigen aus.

Warnung

Wenn Sie Vorlagenstandards überschreiben deaktivieren oder das Modell ändern, wird die Standardvorlage von Amazon Bedrock verwendet und Ihre Vorlage wird gelöscht. Geben Sie zur Bestätigung

confirmin das Textfeld ein, um die angezeigte Meldung zu bestätigen. -

Aktivieren Sie die Option Vorlage aktivieren, damit sie vom Agenten beim Generieren von Antworten verwendet werden kann. Wenn diese Konfiguration deaktiviert ist, verwendet der Agent sie nicht.

-

Verwenden Sie den Prompt-Vorlagen-Editor, um die Vorlage für den Beispiel-Prompt zu ändern.

-

Unter Konfigurationen können Sie die Inferenzparameter für den Prompt ändern. Definitionen der Parameter und weitere Informationen zu den Parametern für verschiedene Modelle finden Sie unter Inferenzanforderungsparameter und Antwortfelder für Basismodelle.

-

(Optional) Führen Sie die folgenden Aktionen aus, um eine Lambda-Funktion zu verwenden, die Sie für die Analyse der Rohausgabe des Basismodells definiert haben.

Anmerkung

Eine Lambda-Funktion wird für alle Promptvorlagen verwendet.

-

Aktivieren Sie im Abschnitt Konfigurationen die Option Verwenden Sie die Lambda-Funktion zum Parsen. Wenn Sie diese Einstellung deaktivieren, verwendet der Agent den Standardparser für den Prompt.

-

Wählen Sie für die Parser-Lambda-Funktion eine Lambda-Funktion aus dem Dropdown-Menü aus.

Anmerkung

Sie müssen Berechtigungen für den Agenten anfügen, damit dieser auf die Lambda-Funktion zugreifen kann. Weitere Informationen finden Sie unter Ressourcenbasierte Richtlinie, die es Amazon Bedrock erlaubt, die Lambda-Funktion einer Aktionsgruppe aufzurufen.

-

-

Wählen Sie eine der folgenden Optionen aus, um Ihre Einstellungen zu speichern:

-

Wenn Sie im selben Fenster bleiben und die Prompt-Einstellungen dynamisch aktualisieren möchten, während Sie Ihren aktualisierten Agenten testen, wählen Sie Speichern aus.

-

Wenn Sie die Einstellungen zu speichern und zur Seite mit dem Arbeitsentwurf zurückzukehren möchten, wählen Sie Speichern und beenden aus.

-

-

Wenn Sie die aktualisierten Einstellungen testen möchten, wählen Sie im Testfenster die Option Vorbereiten aus.

-

- API

-

Senden Sie einen UpdateAgent-Aufruf und ändern Sie das folgende

promptOverrideConfiguration-Objekt, um erweiterte Prompts über die API-Operationen zu konfigurieren."promptOverrideConfiguration": { "overrideLambda": "string", "promptConfigurations": [ { "basePromptTemplate": "string", "inferenceConfiguration": { "maximumLength": int, "stopSequences": [ "string" ], "temperature": float, "topK": float, "topP": float }, "parserMode": "DEFAULT | OVERRIDDEN", "promptCreationMode": "DEFAULT | OVERRIDDEN", "promptState": "ENABLED | DISABLED", "promptType": "PRE_PROCESSING | ORCHESTRATION | KNOWLEDGE_BASE_RESPONSE_GENERATION | POST_PROCESSING | MEMORY_SUMMARIZATION" } ], promptCachingState: { cachingState: "ENABLED | DISABLED" } }-

Fügen Sie der Liste

promptConfigurationsfür jede Promptvorlage, die Sie bearbeiten möchten, einpromptConfiguration-Objekt hinzu. -

Geben Sie den zu ändernden Prompt im Feld

promptTypean. -

Ändern Sie die Prompt-Vorlage mit den folgenden Schritten:

-

Geben Sie die Felder

basePromptTemplatemit Ihrer Promptvorlage an. -

Schließen Sie Inferenzparameter in die

inferenceConfiguration-Objekte ein. Weitere Informationen zu Inferenzkonfigurationen finden Sie unter Inferenzanforderungsparameter und Antwortfelder für Basismodelle.

-

-

Um die Vorlage zu aktivieren, setzen Sie den Wert

promptCreationModeaufOVERRIDDEN. -

Ändern Sie den Wert für

promptState, damit der Agent den Schritt im FeldpromptTypeausführen oder nicht ausführen kann. Diese Einstellung kann bei der Fehlerbehebung im Hinblick auf das Verhalten des Agenten nützlich sein.-

Wenn Sie den Wert für

promptStatefür die SchrittePRE_PROCESSING,KNOWLEDGE_BASE_RESPONSE_GENERATIONoderPOST_PROCESSINGaufDISABLEDsetzen, wird dieser Schritt vom Agenten übersprungen. -

Wenn Sie den Wert

DISABLEDfür den SchrittORCHESTRATIONaufpromptStatesetzen, sendet der Agent bei der Orchestrierung nur die Benutzereingaben an das Basismodell. Darüber hinaus gibt der Agent die Antwort unverändert zurück, ohne Aufrufe zwischen API-Vorgängen und Wissensdatenbanken zu orchestrieren. -

Der Standardwert für den Schritt

POST_PROCESSINGlautetDISABLED. Standardmäßig weisen die SchrittePRE_PROCESSING,ORCHESTRATIONundKNOWLEDGE_BASE_RESPONSE_GENERATIONden StatusENABLEDauf. -

Standardmäßig weist Schritt

MEMORY_SUMMARIZATIONden StatusENABLEDauf, wenn der Arbeitsspeicher aktiviert ist, und der SchrittMEMORY_SUMMARIZATIONden StatusDISABLED, wenn der Arbeitsspeicher deaktiviert ist.

-

-

Führen Sie die folgenden Schritte aus, um eine Lambda-Funktion zu verwenden, die Sie für die Analyse der Rohausgabe des Basismodells definiert haben.

-

Setzen Sie für jede Prompt-Vorlage, für die Sie die Lambda-Funktion aktivieren möchten, den Wert für

parserModeaufOVERRIDDEN. -

Geben Sie den Amazon-Ressourcenname (ARN) der Lambda-Funktion im Feld

overrideLambdadespromptOverrideConfiguration-Objekts an.

-

-