Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Funktionsweise von Agenten für Amazon Bedrock

|

Beschleunigen Sie Agenten mit Amazon Bedrock AgentCore den Produktionsprozess. AgentCore ist eine Agentenplattform für die sichere und skalierbare Entwicklung, Bereitstellung und den Betrieb hochleistungsfähiger Agenten. Weitere Informationen finden Sie im AgentCore Entwicklerhandbuch. |

Agenten für Amazon Bedrock bestehen aus den folgenden zwei Hauptgruppen von API-Vorgängen, die Sie bei der Einrichtung und Ausführung eines Agenten unterstützen:

-

Build-time-API-Operationen, um Ihre Agenten und die zugehörigen Ressourcen zu erstellen, zu konfigurieren und zu verwalten

-

API-Operationen zur Laufzeit, um Ihren Agenten mit Benutzereingaben aufzurufen und die Orchestrierung zur Ausführung einer Aufgabe zu initiieren

Build-Time-Konfiguration

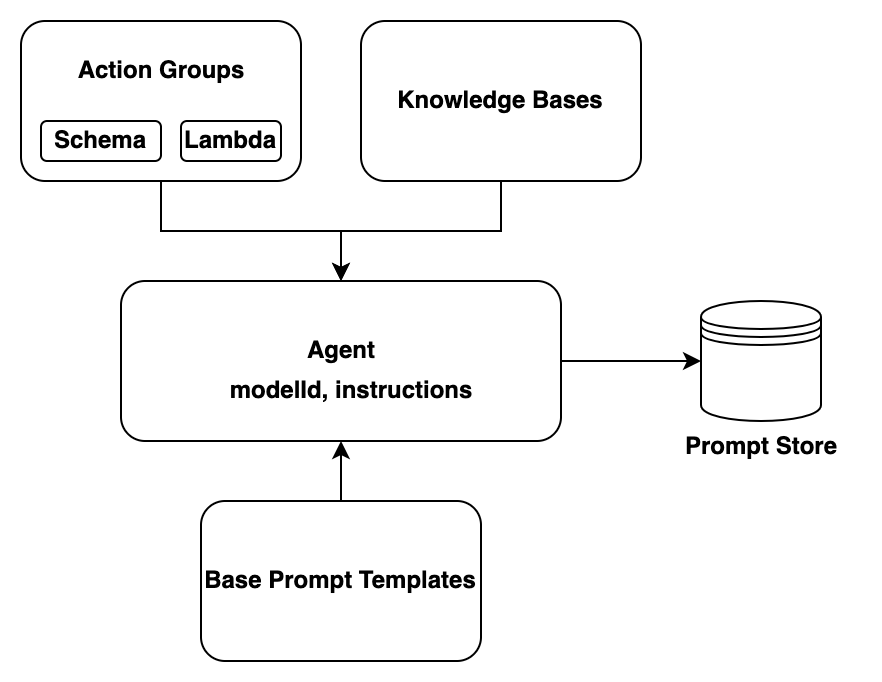

Ein Agent umfasst folgende Komponenten:

-

Basismodell – Sie wählen ein Basismodell (FM) aus, das der Agent aufruft, um Benutzereingaben und nachfolgende Prompts in seinem Orchestrierungsprozess zu interpretieren. Der Agent ruft außerdem das FM auf, um Antworten und Folgeschritte in seinem Prozess zu generieren.

-

Anweisungen – Sie verfassen Anweisungen, in denen der Zwecke des Agenten beschrieben ist. Mit erweiterten Prompts können Sie die Anweisungen für den Agenten bei jedem Orchestrierungsschritt weiter anpassen und Lambda-Funktionen einbeziehen, um die Ausgabe jedes Schritts zu analysieren.

-

Mindestens eine der folgenden Optionen:

-

Aktionsgruppen: Sie definieren die Aktionen, die der Agent für den Benutzer ausführen soll (indem Sie die folgenden Ressourcen bereitstellen):

-

Eines der folgenden Schemas zur Definition der Parameter, die der Agent vom Benutzer abrufen muss (jede Aktionsgruppe kann ein anderes Schema verwenden):

-

Ein OpenAPI-Schema zum Definieren der API-Operationen, die der Agent aufrufen kann, um seine Aufgaben auszuführen. Das OpenAPI-Schema enthält die Parameter, die vom Benutzer abgerufen werden müssen.

-

Ein Funktionsdetailschema, um die Parameter zu definieren, die der Agent beim Benutzer abfragen kann. Diese Parameter können dann für die weitere Orchestrierung durch den Agenten verwendet werden, oder Sie können festlegen, wie sie in Ihrer eigenen Anwendung verwendet werden sollen.

-

-

(Optional) Eine Lambda-Funktion mit der folgenden Eingabe und Ausgabe.

-

Eingabe — Die and/or API-Betriebsparameter, die während der Orchestrierung identifiziert wurden.

-

Ausgabe – Die Antwort des API-Aufrufs oder die Antwort des Funktionsaufrufs.

-

-

-

Wissensdatenbanken – Ordnen Sie einem Agenten Wissensdatenbanken zu. Der Agent fragt die Wissensdatenbank nach zusätzlichem Kontext ab, um die Antwortgenerierung und die Eingabe in den einzelnen Schritten des Orchestrierungsprozesses zu verbessern.

-

-

Prompt-Vorlagen – Vorlagen für Prompts sind die Grundlage für die Erstellung von Prompts, die dem FM zur Verfügung gestellt werden. Agenten für Amazon Bedrock stellen die vier standardmäßigen Basisvorlagen für Prompts zur Verfügung, die während der Vorverarbeitung, der Orchestrierung, der Generierung von Antworten in der Wissensdatenbank und der Nachbearbeitung verwendet werden. Sie können diese Basisvorlagen für Prompts bearbeiten, um das Verhalten Ihres Agenten in jedem Schritt der Sequenz anzupassen. Sie können die Schritte auch für Problembehandlungszwecke deaktivieren oder wenn Sie entscheiden, dass ein Schritt nicht erforderlich ist. Weitere Informationen finden Sie unter Verbessern der Korrektheit von Agenten mithilfe erweiterter Prompt-Vorlagen in Amazon Bedrock.

In der Build-Time werden all diese Komponenten zusammengetragen, um grundlegende Prompts für den Agenten zu erstellen und die Orchestrierung durchzuführen, bis die Benutzeranforderung abgeschlossen ist. Mit erweiterten Prompts können Sie diese grundlegenden Prompts mit zusätzlicher Logik und wenigen Beispielen modifizieren, um die Genauigkeit der einzelnen Schritte des Agentenaufrufs zu verbessern. Die Basisvorlagen für Prompts enthalten Anweisungen, Aktionsbeschreibungen, Beschreibungen von Wissensdatenbanken und den Konversationsverlauf. All diese Elemente können Sie bearbeiten, um den Agenten an Ihre Bedürfnisse anzupassen. Anschließend bereiten Sie Ihren Agenten vor, der alle Komponenten der Agenten, einschließlich der Sicherheitskonfigurationen, verpackt. Die Vorbereitung des Agenten versetzt ihn in einen Status, in dem er zur Laufzeit getestet werden kann. Die folgende Abbildung zeigt, wie Ihr Agent mithilfe von Build-Time-API-Operationen entwickelt wird.

Laufzeitprozess

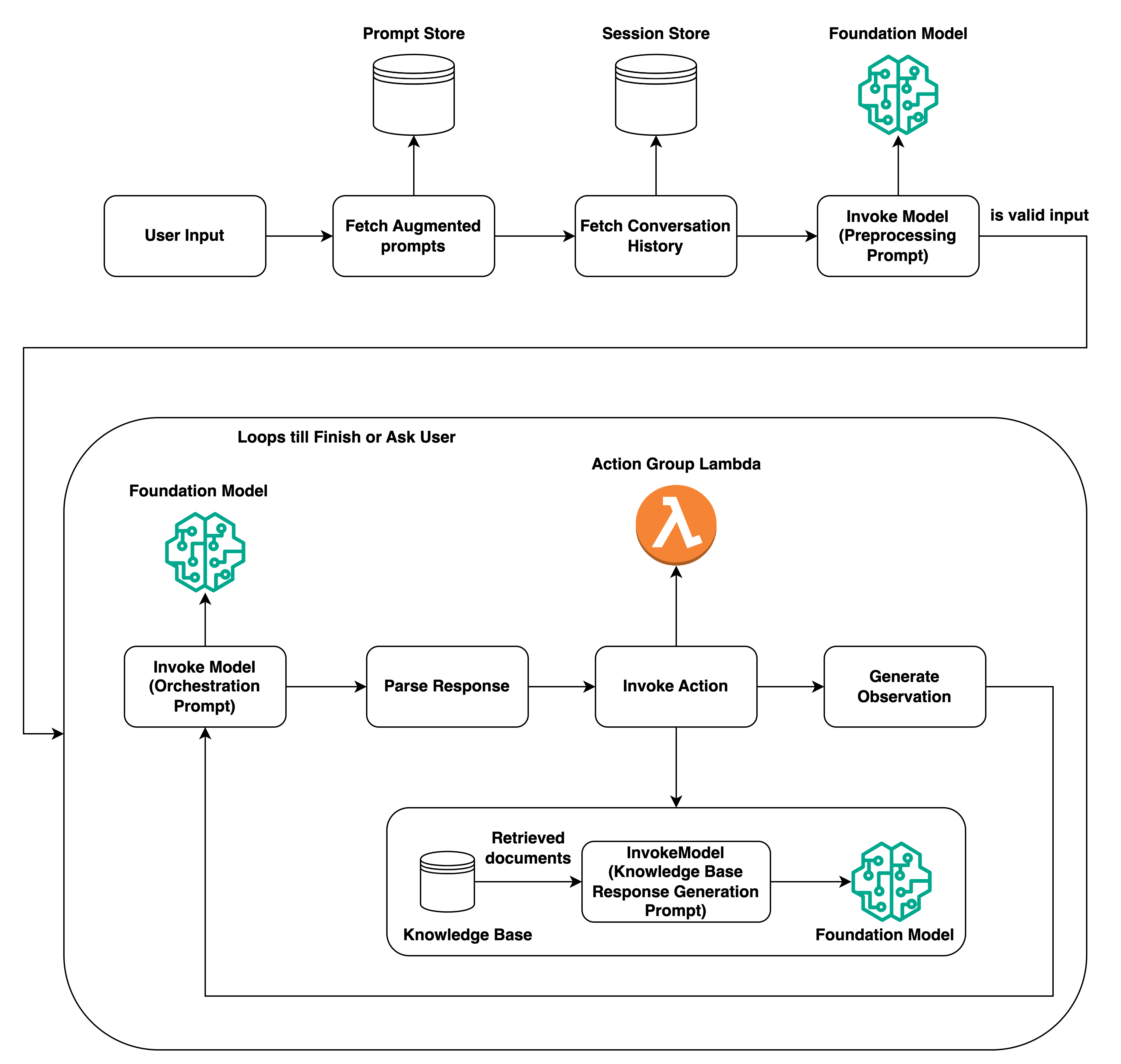

Die Laufzeit wird durch die InvokeAgent-API-Operation verwaltet. Diese Operation startet die Agentensequenz, die aus den folgenden drei Hauptschritten besteht.

-

Vorverarbeitung – Steuert, wie der Agent Benutzereingaben kontextualisiert und kategorisiert und ob die Eingabe gültig ist.

-

Orchestrierung – Interpretiert die Benutzereingaben, ruft Aktionsgruppen auf und fragt Wissensdatenbanken ab und gibt die Ausgabe an den Benutzer oder als Eingabe für die weitere Orchestrierung zurück. Die Orchestrierung besteht aus den folgenden Schritten:

-

Der Agent interpretiert die Eingabe anhand eines Basismodells und generiert eine Begründung, in der die Logik für den nächsten Schritt dargelegt wird.

-

Der Agent sagt voraus, welche Aktion in einer Aktionsgruppe er aufrufen oder welche Wissensdatenbank er abfragen soll.

-

Wenn der Agent voraussagt, dass er eine Aktion aufrufen muss, sendet er die anhand dem Benutzer-Prompt ermittelten Parameter an die für die Aktionsgruppe konfigurierte Lambda-Funktion oder gibt die Steuerung zurück, indem er die Parameter in der InvokeAgent-Antwort sendet. Wenn der Agent nicht über genügend Informationen verfügt, um die Aktion aufzurufen, kann er eine der folgenden Aktionen ausführen:

-

Fragen Sie eine zugehörige Wissensdatenbank ab (Generierung von Antworten in der Wissensdatenbank), um zusätzlichen Kontext abzurufen und die Daten zur Verbesserung ihrer ihre Generierung zusammenzufassen.

-

Fordert den Benutzer erneut auf, alle für die Aktion erforderlichen Parameter zu sammeln.

-

-

Der Agent generiert eine Ausgabe, die als Beobachtung bezeichnet wird, wenn er eine Aktion aufruft, in der die Ergebnisse aus einer and/or Wissensdatenbank zusammengefasst werden. Der Agent verwendet die Beobachtung zur Erweiterung des grundlegenden Prompts, der dann mit einem Basismodell interpretiert wird. Der Agent bestimmt dann, ob er den Orchestrierungsprozess wiederholen muss.

-

Diese Schleife wird fortgesetzt, bis der Agent eine Antwort an den Benutzer zurückgibt oder den Benutzer zur Eingabe zusätzlicher Informationen auffordern muss.

Während der Orchestrierung wird die Basisvorlage für Prompts um die Anweisungen, Aktionsgruppen und Wissensdatenbanken für den Agenten erweitert, die Sie dem Agenten hinzugefügt haben. Dann wird die FM mithilfe des erweiterten Basis-Prompts aufgerufen. Das FM sagt die bestmöglichen Schritte und den Zielpfad vorher, um die Benutzereingaben zu erfüllen. Bei jeder Iteration der Orchestrierung sagt das Basismodell vorher, welche API-Operation aufgerufen oder welche Wissensdatenbank abgefragt werden soll.

-

-

Nachbearbeitung – Der Agent formatiert die endgültige an den Benutzer zurückzusendende Antwort. Diese Option ist standardmäßig deaktiviert.

Wenn Sie Ihren Agenten aufrufen, können Sie zur Laufzeit eine Trace aktivieren. Mit der Trace können Sie die Gründe, Aktionen, Anforderungen und Beobachtungen des Agenten in jedem Schritt der Agentensequenz verfolgen. umfasst den vollständigen Prompt, der bei jedem Schritt an das Basismodell gesendet wurde, sowie die Ausgaben des Basismodells, API-Antworten und Abfragen der Wissensdatenbank. Anhand der Trace können Sie in jedem Schritt die Argumentation des Agenten nachzuvollziehen. Weitere Informationen finden Sie unter Verfolgen Sie den step-by-step Argumentationsprozess des Agenten mithilfe von Trace.

Während die Benutzersitzung mit dem Agenten weitere InvokeAgent-Anfragen bearbeitet, wird der Konversationsverlauf beibehalten. Der Konversationsverlauf erweitert den Basis-Prompt für die Orchestrierung kontinuierlich mit Kontextinformationen und trägt so zur Verbesserung der Genauigkeit und Leistung des Agenten bei. Das folgende Diagramm zeigt den Prozess des Agenten während der Laufzeit: