本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

生成式 AI 代理器:使用 LLMs 取代符號邏輯

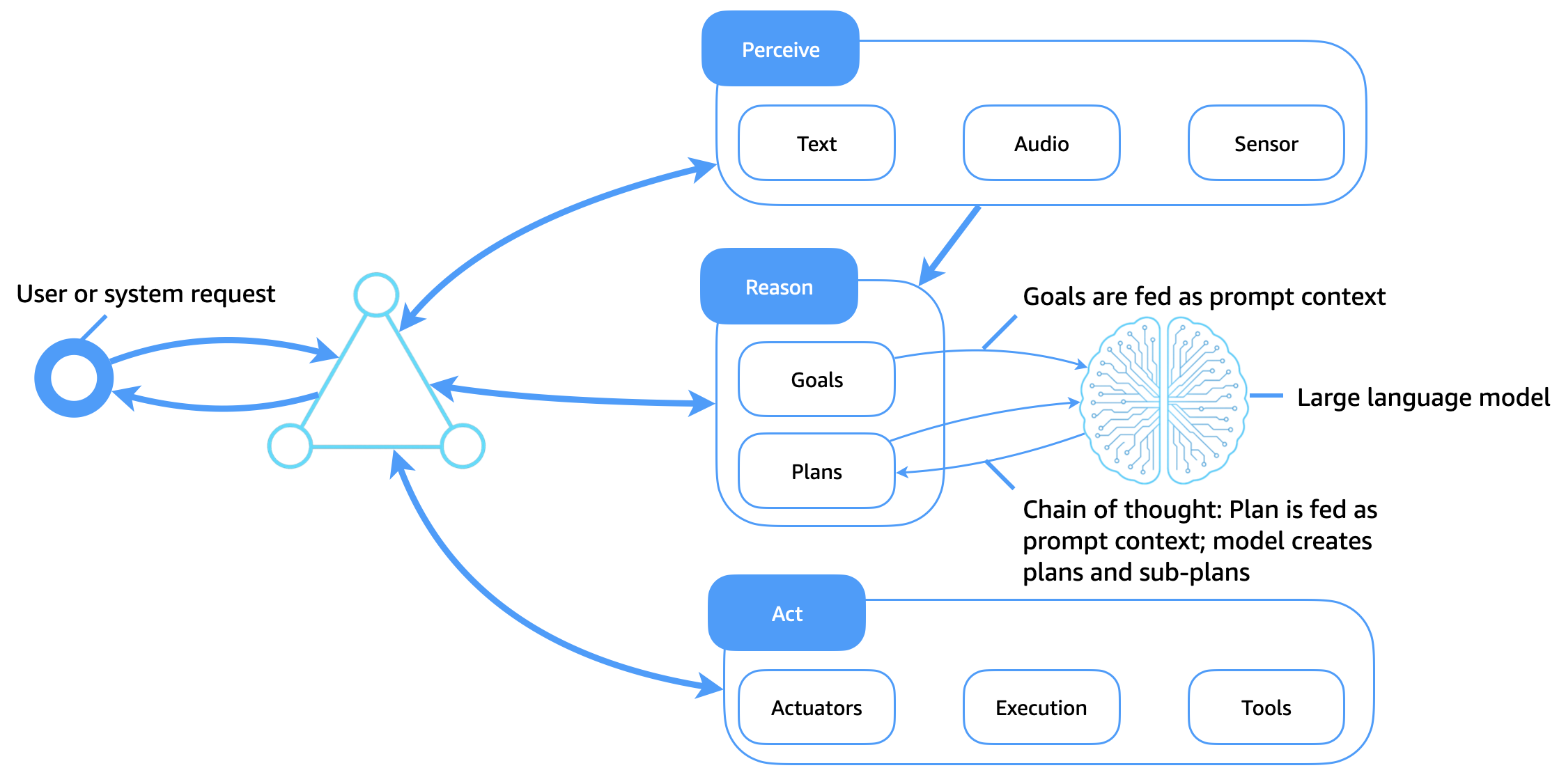

下圖說明大型語言模型 (LLMs) 現在如何做為軟體代理程式的彈性和智慧型認知核心。與依賴靜態計劃程式庫和手動編碼規則的傳統符號邏輯系統相比,LLMs 可實現適應性推理、內容規劃和動態工具使用,從而改變客服人員如何感知、推理和行動。

金鑰增強功能

此架構增強了傳統代理程式架構,如下所示:

-

LLMs做為認知引擎:目標、計劃和查詢會做為 提示內容傳遞至模型。LLM 會產生推理路徑 (例如思考鏈)、將任務分解為子目標,並決定下一個動作。

-

透過提示使用工具: LLMs 可透過工具使用代理程式或推理和動作 (ReAct) 提示來呼叫 APIs,以及搜尋、查詢、計算和解譯輸出。

-

內容感知規劃:客服人員會根據客服人員目前的目標、輸入環境和意見回饋動態產生或修改計劃,而不需要硬式編碼的計劃程式庫。

-

提示內容做為記憶體:客服人員不會使用符號知識庫,而是將記憶體、計劃和目標編碼為傳遞給模型的提示字符。

-

學習少量拍攝的內容內學習:LLMs 透過提示工程來調整行為,從而減少明確重新訓練或嚴格計劃程式庫的需求。

在 LLM 型代理程式中取得長期記憶體

與將長期記憶體存放在結構化知識庫中的傳統代理程式不同,生成式 AI 代理程式必須在 LLMs的內容時段限制內運作。為了擴展記憶體並支援持久性智慧,生成式 AI 代理器使用數種補充技術:代理程式存放區、擷取增強生成 (RAG)、內容內學習和提示鏈結,以及預先訓練。

代理程式存放區:外部長期記憶體

客服人員狀態、使用者歷史記錄、決策和結果會存放在長期客服人員記憶體存放區 (例如向量資料庫、物件存放區或文件存放區)。相關記憶體會隨需擷取,並在執行時間插入 LLM 提示內容。這會建立持久性記憶體迴圈,其中代理程式會保留跨工作階段、任務或互動的連續性。

RAG

RAG 結合擷取的知識與生成功能,增強 LLM 效能。發出目標或查詢時,客服人員會搜尋擷取索引 (例如,透過對文件的語意搜尋、先前的對話或結構化知識)。擷取的結果會附加到 LLM 提示字元,以產生外部事實或個人化內容為基礎。此方法可擴展代理程式的有效記憶體,並改善可靠性和事實正確性。

內容內學習和提示鏈結

客服人員會使用工作階段內字符內容和結構化提示鏈結來維護短期記憶體。內容元素,例如目前的計劃、先前的動作結果和客服人員狀態,會在呼叫之間傳遞,以引導行為。

持續預先訓練和微調

對於特定網域的代理程式,LLMs 可以在自訂集合上繼續預先訓練,例如日誌、企業資料或產品文件。或者,從人類意見回饋 (RLHF) 進行指令微調或強化學習,可以將類似客服人員的行為直接嵌入模型中。這會將推理模式從提示時間邏輯轉移到模型的內部表示法、減少提示長度並提高效率。

代理式 AI 的合併優勢

這些技術一起使用時,可讓生成式 AI 代理器:

-

隨著時間的推移,保持情境感知。

-

根據使用者歷史記錄或偏好設定調整行為。

-

使用up-to-date、事實或私有知識做出決策。

-

使用持久性、合規且可解釋的行為擴展到企業使用案例。

透過使用外部記憶體、擷取層和持續訓練增強 LLMs,客服人員可以達到先前無法單獨透過符號系統實現的認知持續性和目的層級。