本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

了解在 Amazon SageMaker AI 中部署模型和获取推理的选项

为帮助您开始使用 SageMaker AI 推理,请参阅以下章节,了解在 SageMaker AI 中部署模型和获取推理的选项。Amazon SageMaker AI 中的推理选项 部分可以帮助您确定哪种功能最适合您的推理使用场景。

您可以参阅资源部分,了解更多故障排除和参考信息、帮助您入门的博客和示例以及常见问题解答。

主题

开始前的准备工作

以下主题假设您已构建和训练了一个或多个机器学习模型,并已准备好部署它们。您无需在 SageMaker AI 中训练模型,即可在 SageMaker AI 中部署模型并获得推理。如果您没有自己的模型,也可以使用 SageMaker AI 的内置算法或预训练模型。

如果您是 SageMaker AI 的新用户,还没有选定要部署的模型,请按照 Amazon SageMaker AI 入门教程中的步骤进行操作。使用本教程熟悉 SageMaker AI 如何管理数据科学流程以及如何处理模型部署。有关模型训练的更多信息,请参阅训练模型。

有关更多信息、参考和其他示例,请参阅资源。

模型部署步骤

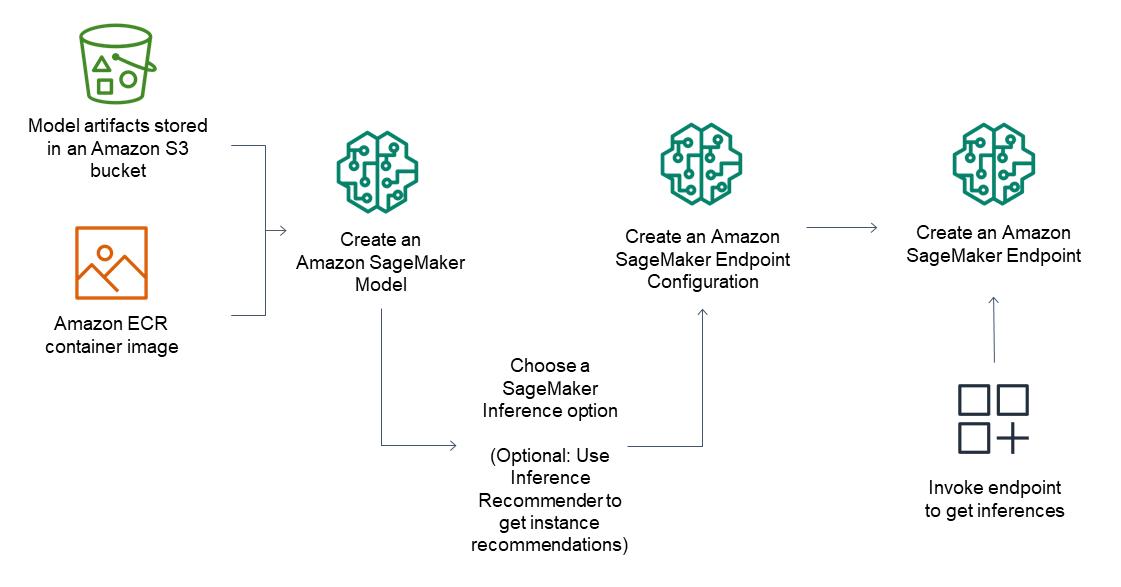

对于推理端点,常规工作流包括以下内容:

通过指向 Amazon S3 中存储的模型构件和容器映像,在 SageMaker AI Inference 中创建模型。

选择推理选项。有关更多信息,请参阅 Amazon SageMaker AI 中的推理选项。

通过选择端点后所需的实例类型和实例数量,创建 SageMaker AI Inference 端点配置。您可以使用 Amazon SageMaker Inference Recommender 来获取有关实例类型的建议。对于无服务器推理,您只需根据模型大小提供所需的内存配置。

创建 SageMaker AI Inference 端点。

调用您的端点以收到推理作为响应。

下图显示了上述工作流。

您可以使用 AWS 控制台、AWS SDK、SageMaker Python SDK、CloudFormation 或 AWS CLI 来执行这些操作。

要使用批量转换进行批量推理,请指向您的模型构件和输入数据,然后创建批量推理作业。SageMaker AI 不会托管用于推理的端点,而是将您的推理输出到您选择的 Amazon S3 所在的位置。