本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

生成式 AI 代理:将符号逻辑替换为 LLMs

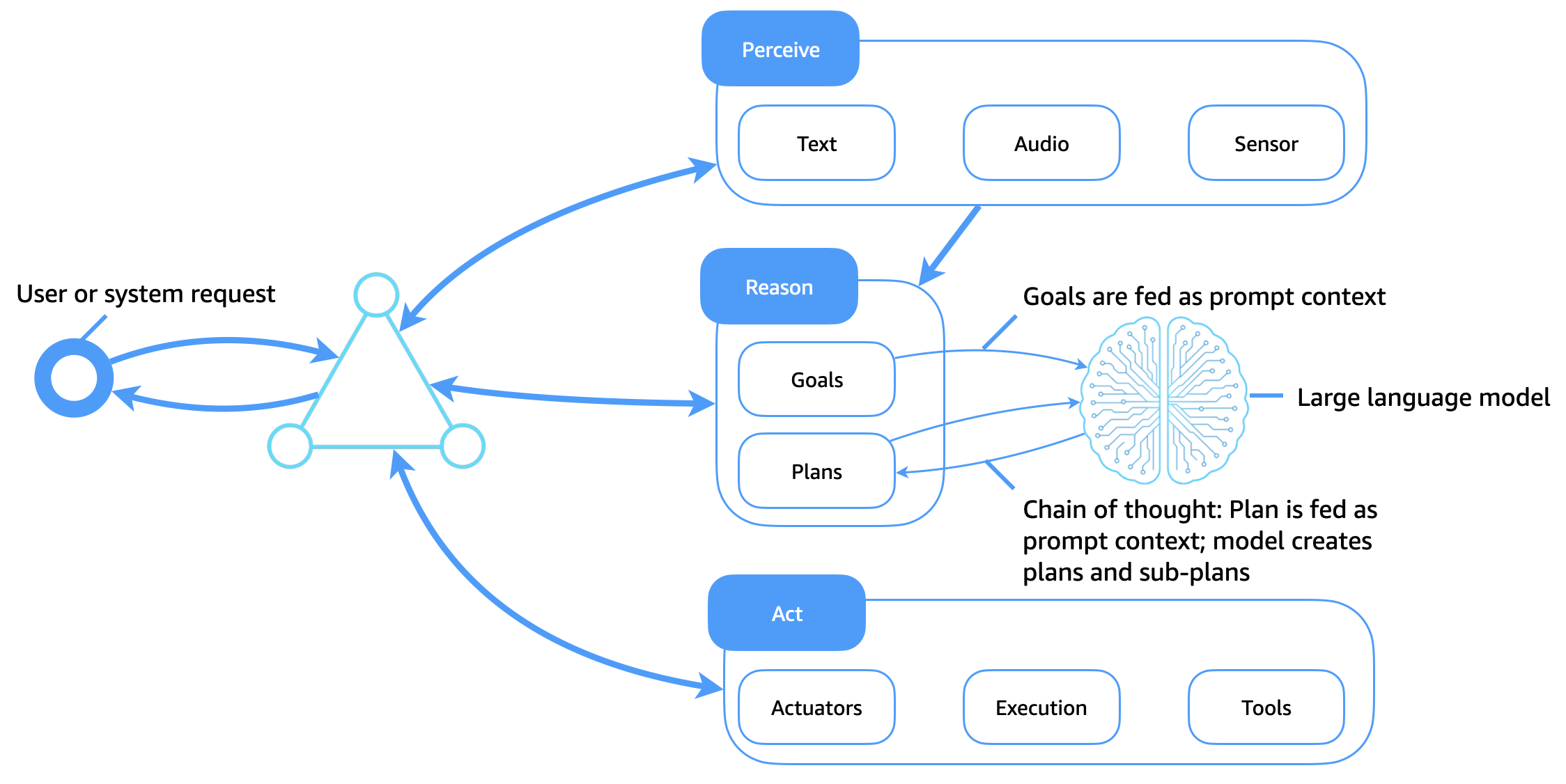

下图说明了大型语言模型 (LLMs) 现在如何作为软件代理的灵活而智能的认知核心。与依赖静态计划库和手工编码规则的传统符号逻辑系统形成鲜明对比的是,它 LLMs支持自适应推理、情境规划和动态工具使用,从而改变代理的感知、推理和行为方式。

主要增强功能

此架构增强了传统的代理架构,如下所示:

-

LLMs 作为认知引擎:目标、计划和查询作为即时上下文传递到模型中。法学硕士生成推理路径(例如思维链),将任务分解为子目标,并决定下一步行动。

-

通过提示使用工具: LLMs 可以通过工具使用代理或推理和行动 (ReAct) 提示进行引导,以呼叫 APIs 以及搜索、查询、计算和解释输出。

-

情境感知规划:代理根据代理的当前目标、输入环境和反馈动态生成或修改计划,无需硬编码的计划库。

-

提示上下文作为内存:代理不使用符号知识库,而是将内存、计划和目标编码为传递给模型的提示标记。

-

通过少量的、基于情境的学习来学习:通过及时的工程来 LLMs 调整行为,从而减少对明确的再训练或僵化的计划库的需求。

在基于 LLM 的代理中实现长期记忆

与在结构化知识库中存储长期记忆的传统代理不同,生成式 AI 代理必须在上下文窗口的限制下工作 LLMs。为了扩展内存并支持持久智能,生成式 AI 代理使用了几种补充技术:代理存储、检索增强生成 (RAG)、情境内学习和提示链以及预训练。

代理存储:外部长期存储器

代理状态、用户历史记录、决策和结果存储在长期代理内存存储中(例如矢量数据库、对象存储或文档存储)。按需检索相关内存,并在运行时将其注入到 LLM 提示上下文中。这会创建一个持久的内存循环,在该循环中,代理在会话、任务或交互之间保持连续性。

抹布

RAG 通过将检索到的知识与生成能力相结合,提高 LLM 的绩效。发布目标或查询时,代理会搜索检索索引(例如,通过对文档、之前的对话或结构化知识的语义搜索)。检索到的结果将附加到法学硕士提示中,该提示是在外部事实或个性化背景下生成的。这种方法扩展了代理的有效记忆力,提高了可靠性和事实正确性。

情境内学习和提示链接

代理通过使用会话内令牌上下文和结构化提示链来保持短期记忆。上下文元素(例如当前计划、先前的行动结果和座席状态)在两次通话之间传递以指导行为。

持续的预训练和微调

对于特定域的代理, LLMs 可以继续对自定义集合(例如日志、企业数据或产品文档)进行预训练。或者,通过人工反馈进行指令微调或强化学习 (RLHF) 可以将类似代理的行为直接嵌入到模型中。这会将推理模式从提示时间逻辑转移到模型的内部表示中,缩短了提示长度并提高了效率。

代理人工智能的综合优势

这些技术一起使用时,使生成式 AI 代理能够:

-

随着时间的推移保持情境意识。

-

根据用户历史记录或偏好调整行为。

-

利用 up-to-date事实知识或私人知识做出决定。

-

通过持久、合规且可解释的行为扩展到企业用例。

通过增强 LLMs 外部记忆、检索层和持续训练,代理可以实现以前仅通过符号系统无法实现的认知连续性和目标水平。