As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Conceitos básicos sobre opções de implantação de modelos e obtenção de inferência no Amazon SageMaker AI

Para ajudar você a começar com a usar o SageMaker AI Inference, consulte as seções a seguir, que explicam as opções para implantação de modelos no SageMaker AI e obtenção de inferência. A seção Opções de inferência no Amazon SageMaker AI pode ajudá-lo a determinar qual atributo é mais adequado ao seu caso de uso para inferência.

Você pode consultar a seção Recursos para obter mais informações de solução de problemas e referência, blogs e exemplos que o ajudarão a começar, além de perguntas frequentes comuns.

Tópicos

Antes de começar

Esses tópicos pressupõem que você tenha criado e treinado um ou mais modelos de machine learning e esteja pronto para implantá-los. Você não precisa treinar seu modelo no SageMaker AI para implantá-lo no SageMaker AI e obter inferências. Se você não tiver seu próprio modelo, também poderá usar os algoritmos integrados ou modelos pré-treinados do SageMaker AI.

Se você ainda é iniciante no SageMaker AI e não escolheu um modelo para implantar, siga as etapas no tutorial Guia para configurar o Amazon SageMaker AI. Use o tutorial para se familiarizar com a forma como o SageMaker AI gerencia o processo de ciência de dados e como processa a implantação de modelo. Para obter mais informações sobre treinar um modelo, consulte Treinar modelos.

Para informações adicionais, referência e exemplos, consulte o Recursos.

Etapas para a implantação do modelo

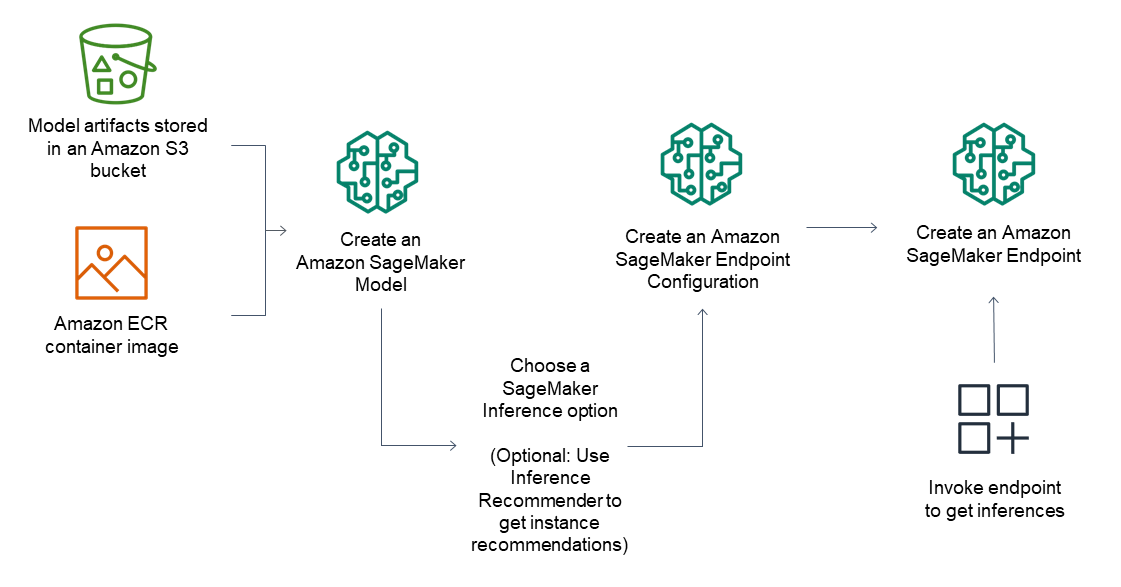

Para endpoints de inferência, o fluxo de trabalho geral consiste no seguinte:

Criar um modelo no SageMaker AI Inference apontando para artefatos do modelo armazenados no Amazon S3 e uma imagem de contêiner.

Selecionar uma opção de inferência. Para ter mais informações, consulte Opções de inferência no Amazon SageMaker AI.

Criar uma configuração do endpoint do SageMaker AI Inference escolhendo o tipo de instância e o número de instâncias necessárias para o endpoint. Você pode usar o Amazon SageMaker Inference Recommender para obter recomendações para tipos de instância. Para Inferência Serverless, você só precisa fornecer a configuração de memória necessária com base no tamanho do seu modelo.

Criar um endpoint do SageMaker Inference.

Invocar seu endpoint para receber uma inferência como resposta.

O diagrama a seguir mostra o fluxo de trabalho anterior.

Você pode realizar essas ações usando o console AWS, os SDKs AWS, o SageMaker Python SDK CloudFormation ou o AWS CLI.

Para inferência em lote com transformação em lote, aponte para os artefatos do modelo e os dados de entrada e crie um trabalho de inferência em lote. Em vez de hospedar um endpoint para inferência, o SageMaker AI direciona suas inferências para um local do Amazon S3 de sua escolha.