As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Acelere MLOps com os modelos de Backstage e de autoatendimento da Amazon AI SageMaker

Ashish Bhatt, Shashank Hirematt e Shivanshu Suryakar, da Amazon Web Services

Resumo

Organizações que usam sistemas de operações de aprendizado de máquina (MLOps) enfrentam desafios significativos para escalar, padronizar e proteger sua infraestrutura de ML. Esse padrão introduz uma abordagem transformadora que combina o Backstage

Os módulos IaC para esse padrão são fornecidos no repositório de GitHub AWS AIOps módulos

Ao usar o Backstage como uma plataforma de autoatendimento e integrar modelos de SageMaker IA pré-configurados, você pode:

Acelere o tempo de geração de valor de suas iniciativas de ML.

Ajude a impor segurança e governança consistentes.

Forneça aos cientistas de dados ambientes padronizados e compatíveis.

Reduza a sobrecarga operacional e a complexidade da infraestrutura.

Esse padrão fornece uma solução que aborda os desafios críticos MLOps e também fornece uma estrutura escalável e repetível que permite a inovação enquanto mantém os padrões organizacionais.

Público-alvo

Esse padrão é destinado a um amplo público envolvido em ML, arquitetura de nuvem e engenharia de plataforma em uma organização. Isso inclui:

Engenheiros de ML que desejam padronizar e automatizar implantações de fluxo de trabalho de ML.

Cientistas de dados que desejam acesso por autoatendimento a ambientes de ML pré-configurados e compatíveis.

Engenheiros de plataforma responsáveis por criar e manter plataformas internas para desenvolvedores e infraestrutura compartilhada.

Arquitetos de nuvem que projetam soluções de nuvem escaláveis, seguras e econômicas para. MLOps

DevOps engenheiros interessados em estender as práticas de integração contínua e entrega contínua (CI/CD) ao provisionamento e fluxos de trabalho da infraestrutura de ML.

Líderes técnicos e gerentes que supervisionam as iniciativas de ML e desejam melhorar a produtividade, a governança e o tempo de comercialização da equipe.

Para obter mais informações sobre MLOps desafios, MLOps módulos de SageMaker IA e como a solução fornecida por esse padrão pode atender às necessidades de suas equipes de ML, consulte a seção Informações adicionais.

Pré-requisitos e limitações

Pré-requisitos

AWS Identity and Access Management (IAM) funções e permissões

para provisionar recursos em seu Conta da AWS Uma compreensão dos conceitos do Amazon SageMaker Studio, SageMaker Projects, SageMaker Pipelines e SageMaker Model Registry

Uma compreensão dos princípios do IaC e experiência com ferramentas como o AWS Cloud Development Kit (AWS CDK)

Limitações

Cobertura limitada de modelos. Atualmente, a solução oferece suporte somente SageMaker aos AIOps módulos relacionados à IA da AIOps solução

mais ampla. Outros módulos, como o Ray no Amazon Elastic Kubernetes Service (Amazon EKS) MLflow, o Apache Airflow e o ajuste fino do Amazon Bedrock, ainda não estão disponíveis como modelos do Backstage. Configurações padrão não configuráveis. Os modelos usam configurações padrão fixas dos AIOps SageMaker módulos sem personalização. Você não pode modificar tipos de instância, tamanhos de armazenamento, configurações de rede ou políticas de segurança por meio da interface Backstage, o que limita a flexibilidade para casos de uso específicos.

AWS-somente suporte. A plataforma foi projetada exclusivamente para AWS implantações e não oferece suporte a cenários de várias nuvens. Organizações que usam serviços de nuvem fora do país Nuvem AWS não podem usar esses modelos para suas necessidades de infraestrutura de ML.

Gerenciamento manual de credenciais. Você deve fornecer manualmente suas AWS credenciais para cada implantação. Essa solução não fornece integração com provedores de identidade corporativa nem rotação automática de credenciais. AWS IAM Identity Center

Gerenciamento limitado do ciclo de vida. Os modelos carecem de recursos abrangentes de gerenciamento do ciclo de vida dos recursos, como políticas de limpeza automatizadas, recomendações de otimização de custos e detecção de desvios na infraestrutura. Você deve gerenciar e monitorar manualmente os recursos implantados após a criação.

Arquitetura

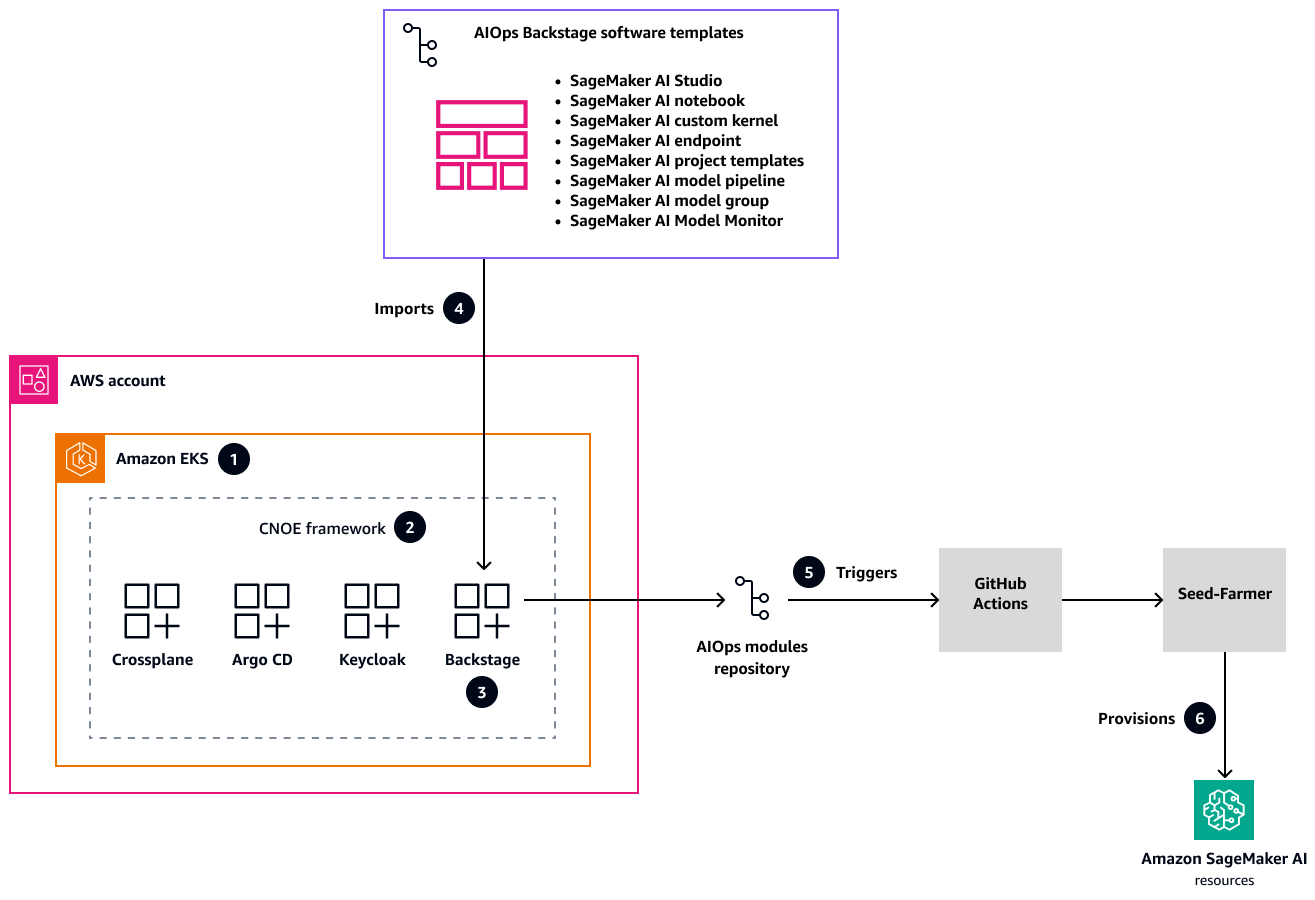

O diagrama a seguir mostra a arquitetura da solução para um portal unificado do desenvolvedor que padroniza e acelera a implantação da infraestrutura de ML com SageMaker IA em todos os ambientes.

Nesta arquitetura:

AWS Os planos de modernização de aplicativos

provisionam a configuração da infraestrutura com um cluster Amazon EKS como base para a estrutura Cloud Native Operational Excellence (CNOE ). Essa solução abrangente aborda desafios complexos de gerenciamento de infraestrutura nativa da nuvem, fornecendo uma plataforma interna de desenvolvedor (IDP) escalável. Os planos oferecem uma abordagem estruturada para configurar uma infraestrutura robusta e flexível que pode se adaptar às suas necessidades organizacionais em evolução. A estrutura de código aberto CNOE consolida DevOps ferramentas e resolve a fragmentação do ecossistema por meio de uma abordagem unificada de engenharia de plataforma. Ao reunir ferramentas e tecnologias diferentes, ele simplifica o cenário complexo do desenvolvimento nativo em nuvem, para que suas equipes possam se concentrar na inovação em vez do gerenciamento da cadeia de ferramentas. A estrutura fornece uma metodologia padronizada para selecionar, integrar e gerenciar ferramentas de desenvolvimento.

Com o CNOE, o Backstage é implantado como uma out-of-the-box solução dentro do cluster Amazon EKS. O Backstage vem com autenticação robusta por meio do Keycloak

e fluxos de trabalho de implantação abrangentes por meio do Argo CD. Essa plataforma integrada cria um ambiente centralizado para gerenciar processos de desenvolvimento e fornece um único local para as equipes acessarem, implantarem e monitorarem sua infraestrutura e aplicativos em vários ambientes. Um GitHub repositório contém modelos de AIOps software pré-configurados que abrangem todo o ciclo de vida da SageMaker IA. Esses modelos atendem às necessidades críticas de infraestrutura de ML, incluindo provisionamento de SageMaker estúdio, treinamento de modelos, pipelines de inferência e monitoramento de modelos. Esses modelos ajudam você a acelerar suas iniciativas de ML e garantir a consistência em diferentes projetos e equipes.

GitHub O Actions

implementa um fluxo de trabalho automatizado que aciona dinamicamente o provisionamento de recursos por meio do utilitário Seed-Farmer. Essa abordagem integra o catálogo do Backstage com o repositório de AIOps módulos e cria um processo simplificado de implantação de infraestrutura. A automação reduz a intervenção manual, minimiza o erro humano e garante a criação de infraestrutura rápida e consistente em diferentes ambientes. AWS CDKIsso ajuda você a definir e provisionar a infraestrutura como código e garante a implantação de recursos repetível, segura e compatível em todas as especificações. Contas da AWS Essa abordagem fornece o máximo de governança com o mínimo de intervenção manual, para que você possa criar modelos de infraestrutura padronizados que podem ser facilmente replicados, controlados por versão e auditados.

Ferramentas

Serviços da AWS

AWS Cloud Development Kit (AWS CDK)é uma estrutura de desenvolvimento de software que ajuda você a definir e provisionar Nuvem AWS infraestrutura em código.

O Amazon Elastic Kubernetes Service (Amazon EKS) ajuda você a executar o AWS Kubernetes sem precisar instalar ou manter seu próprio plano de controle ou nós do Kubernetes.

O Amazon SageMaker AI é um serviço gerenciado de ML que ajuda você a criar e treinar modelos de ML e depois implantá-los em um ambiente hospedado pronto para produção.

Outras ferramentas

Repositórios de códigos

Esse padrão usa código e modelos dos seguintes GitHub repositórios:

AIOps plataforma interna de desenvolvedores (IDP) com repositório Backstage

SageMaker Módulos relacionados à IA do repositório de AWS AIOps módulos

Engenharia moderna no AWS

repositório

Implementação

Essa implementação usa um padrão de implantação de nível de produção para o Backstage da engenharia moderna

A seção Epics desse padrão descreve a abordagem de implementação. Para obter instruções detalhadas de step-by-step implantação, consulte o guia abrangente de implantação

Implantação inicial da plataforma Backstage

Integração de modelos de SageMaker software com o Backstage

Consumindo e mantendo modelos do Backstage

O guia de implantação também inclui orientações para manutenção contínua, solução de problemas e escalabilidade da plataforma.

Práticas recomendadas

Siga essas melhores práticas para ajudar a garantir segurança, governança e excelência operacional em suas implementações de MLOps infraestrutura.

Gerenciamento de modelos

Nunca faça alterações significativas nos modelos ativos.

Sempre teste minuciosamente as atualizações antes da implantação na produção.

Mantenha versões de modelos claras e bem documentadas.

Segurança

Fixe GitHub ações em algoritmos de hash seguros de confirmação específicos (SHAs) para ajudar a evitar ataques à cadeia de suprimentos.

Use papéis do IAM com privilégios mínimos com permissões granulares.

Armazene credenciais confidenciais em GitHub Segredos

e. AWS Secrets Manager Nunca codifique credenciais em modelos.

Governança e rastreamento

Implemente padrões abrangentes de marcação de recursos.

Permita o controle preciso dos custos e o monitoramento da conformidade.

Mantenha trilhas de auditoria claras para mudanças na infraestrutura.

Este guia fornece uma base sólida para implementar essas melhores práticas usando os módulos Backstage, SageMaker AI e IaC.

Épicos

| Tarefa | Descrição | Habilidades necessárias |

|---|---|---|

Implemente o Backstage. | Essa etapa usa os esquemas da engenharia moderna no AWS A infraestrutura usa o Amazon EKS como uma plataforma de orquestração de contêineres para implantar componentes de IDP. A arquitetura do Amazon EKS inclui configurações de rede seguras para estabelecer padrões rígidos de isolamento e controle de acesso à rede. A plataforma se integra aos mecanismos de autenticação para ajudar a proteger o acesso do usuário em todos os serviços e ambientes. | Engenheiro de plataforma |

Configure seus modelos de SageMaker IA. | Essa etapa usa os scripts na plataforma GitHub AIOps interna do desenvolvedor (IDP) com o repositório Backstage Esse processo cria um repositório que contém os modelos de SageMaker IA necessários para a integração com o Backstage. | Engenheiro de plataforma |

Integre os modelos de SageMaker IA com o Backstage. | Siga as instruções na seção SageMaker de integração de modelos Essa etapa integra os AIOps módulos (modelos de SageMaker IA da última etapa) à sua implantação do Backstage para que você possa autoatender às suas necessidades de infraestrutura de ML. | Engenheiro de plataforma |

Use os modelos de SageMaker IA do Backstage. | Siga as instruções na seção Usando SageMaker modelos No portal Backstage, você pode selecionar entre os modelos de SageMaker IA disponíveis, incluindo opções para ambientes SageMaker Studio, SageMaker cadernos, modelos de SageMaker projetos personalizados e pipelines de implantação de modelos. Depois de fornecer os parâmetros de configuração, a plataforma cria repositórios dedicados automaticamente e provisiona AWS recursos por meio do GitHub Actions e do Seed-Farmer. Você pode monitorar o progresso por meio dos registros de GitHub ações e do catálogo de componentes do Backstage. | Cientista de dados, Engenheiro de dados, Desenvolvedor |

| Tarefa | Descrição | Habilidades necessárias |

|---|---|---|

Atualize os modelos de SageMaker IA. | Para atualizar um modelo de SageMaker IA no Backstage, siga estas etapas.

| Engenheiro de plataforma |

Crie e gerencie várias versões de um modelo. | Para alterações ou atualizações significativas, talvez você queira criar várias versões de um modelo de SageMaker IA.

| Engenheiro de plataforma |

| Tarefa | Descrição | Habilidades necessárias |

|---|---|---|

Expanda a cobertura de modelos além da SageMaker IA. | A solução atual implementa somente modelos SageMaker relacionados à IA AIOps . Você pode estender o ambiente de ML adicionando AIOps módulos Você também pode implementar padrões de herança de modelos para criar versões especializadas de modelos básicos. Essa extensibilidade permite que você gerencie diversos AWS recursos e aplicativos além da SageMaker IA, preservando a experiência simplificada do desenvolvedor e mantendo os padrões da sua organização. | Engenheiro de plataforma |

Use injeção dinâmica de parâmetros. | Os modelos atuais usam configurações padrão sem personalização e executam a CLI do Seed-Farmer para implantar recursos com variáveis padrão. Você pode estender a configuração padrão usando a injeção dinâmica de parâmetros para configurações específicas do módulo. | Engenheiro de plataforma |

Melhore a segurança e a conformidade. | Para aumentar a segurança na criação de recursos da AWS, você pode habilitar a integração do controle de acesso baseado em funções (RBAC) com login único (SSO), SAML, OpenID Connect (OIDC) e políticas como imposição de código. | Engenheiro de plataforma |

Adicione limpeza automatizada de recursos. | Você pode ativar recursos para políticas de limpeza automatizadas e também adicionar detecção e remediação de desvios na infraestrutura. | Engenheiro de plataforma |

| Tarefa | Descrição | Habilidades necessárias |

|---|---|---|

Remova a infraestrutura do Backstage e os recursos de SageMaker IA. | Ao terminar de usar seu ambiente de ML, siga as instruções na seção Limpeza e gerenciamento de recursos | Engenheiro de plataforma |

Solução de problemas

| Problema | Solução |

|---|---|

AWS CDK falhas de bootstrap | Verifique AWS as credenciais e a configuração da região. |

Problemas de acesso ao cluster Amazon EKS | Verifique a configuração do kubectl e as permissões do IAM. |

Problemas de conectividade do Application Load Balancer | Certifique-se de que os grupos de segurança permitam tráfego de entrada na porta 80/443. |

GitHub problemas de integração | Verifique as permissões GitHub do token e o acesso à organização. |

SageMaker Falhas na implantação de IA | Verifique as AWS service (Serviço da AWS) cotas e as permissões do IAM. |

Recursos relacionados

Engenharia de plataforma (no guia Estrutura de adoção de AWS nuvem: perspectiva da plataforma)

Modelos de software Backstage (site

do Backstage) AIOps repositório de módulos

(coleção de módulos IaC reutilizáveis para ML) AIOps plataforma interna de desenvolvedores (IDP) com repositório Backstage

Engenharia moderna no AWS

repositório

Mais informações

Desafios de negócios

Organizações que iniciam ou expandem suas MLOps iniciativas frequentemente enfrentam os seguintes desafios comerciais e técnicos:

Ambientes inconsistentes. A falta de ambientes padronizados de desenvolvimento e implantação dificulta a colaboração e aumenta os riscos de implantação.

Sobrecarga de provisionamento manual. Configurar manualmente uma infraestrutura de ML com o SageMaker Studio, buckets do Amazon Simple Storage Service (Amazon S3), funções do IAM CI/CD e pipelines é demorado e propenso a erros, além de desviar os cientistas de dados de sua tarefa principal de desenvolvimento de modelos.

Falta de descoberta e reutilização. A falta de um catálogo centralizado dificulta a localização de modelos, conjuntos de dados e pipelines de ML existentes. Isso leva ao trabalho redundante e à perda de oportunidades de reutilização.

Governança e conformidade complexas. Garantir que os projetos de ML cumpram as políticas de segurança organizacional, os regulamentos de privacidade de dados e os padrões de conformidade, como a Lei de Portabilidade e Responsabilidade de Seguros de Saúde (HIPAA) e o Regulamento Geral de Proteção de Dados (GDPR), pode ser um desafio sem barreiras automatizadas.

Diminua o tempo de valorização. O efeito cumulativo desses desafios resulta em ciclos de vida prolongados do projeto de ML e atrasa a obtenção do valor comercial dos investimentos em ML.

Riscos de segurança. Configurações inconsistentes e processos manuais podem introduzir vulnerabilidades de segurança que dificultam a aplicação de privilégios mínimos e o isolamento da rede.

Esses problemas prolongam os ciclos de desenvolvimento, aumentam a sobrecarga operacional e introduzem riscos de segurança. A natureza iterativa do ML exige fluxos de trabalho repetíveis e colaboração eficiente.

O Gartner prevê que até 2026, 80% das organizações de engenharia de software terão equipes de plataforma. (Consulte Engenharia de plataforma capacita os desenvolvedores a serem melhores, mais rápidos e mais felizes no site

MLOps SageMaker módulos

Os AIOps módulos

O uso direto dos AIOps módulos geralmente exige que as equipes da plataforma implantem e gerenciem esses modelos de IaC, o que pode representar desafios para cientistas de dados que desejam acesso por autoatendimento. Descobrir e entender os modelos disponíveis, configurar os parâmetros necessários e acionar sua implantação pode exigir a navegação nos AWS service (Serviço da AWS) consoles ou a interação direta com as ferramentas de IaC. Isso pode criar atrito, aumentar a carga cognitiva para cientistas de dados que preferem se concentrar em tarefas de ML e, potencialmente, levar a parametrização inconsistente ou desvios dos padrões organizacionais se esses modelos não forem gerenciados por meio de uma interface centralizada e fácil de usar. A integração desses AIOps módulos poderosos com um IDP, como o Backstage, ajuda a enfrentar esses desafios, fornecendo uma experiência simplificada de autoatendimento, maior capacidade de descoberta e controles de governança mais fortes para o uso desses componentes padronizados. MLOps

Nos bastidores como IDP

Uma plataforma interna para desenvolvedores (IDP) é uma camada de autoatendimento criada por equipes de plataforma para simplificar e padronizar a forma como os desenvolvedores criam, implantam e gerenciam aplicativos. Ele abstrai a complexidade da infraestrutura e fornece aos desenvolvedores acesso fácil a ferramentas, ambientes e serviços por meio de uma interface unificada.

O objetivo principal de um IDP é aprimorar a experiência e a produtividade do desenvolvedor por meio de:

Habilitando o autoatendimento para tarefas como criação e implantação de serviços.

Promover a consistência e a conformidade por meio de modelos padrão.

Integrando ferramentas em todo o ciclo de vida do desenvolvimento (CI/CD, monitoramento e documentação).

O Backstage é um portal de desenvolvedores de código aberto que foi criado pelo Spotify e agora faz parte da Cloud Native Computing Foundation (CNCF). Ele ajuda as organizações a criar seu próprio IDP fornecendo uma plataforma centralizada e extensível para gerenciar componentes de software, ferramentas e documentação. Com o Backstage, os desenvolvedores podem:

Descubra e gerencie todos os serviços internos por meio de um catálogo de software.

Crie novos projetos usando modelos predefinidos por meio do plug-in scaffolder.

Acesse ferramentas integradas, como CI/CD pipelines, painéis do Kubernetes e sistemas de monitoramento em um único local.

Mantenha uma documentação consistente e baseada em remarcações por meio de. TechDocs

PERGUNTAS FREQUENTES

Qual é a diferença entre usar esse modelo do Backstage e implantar o SageMaker Studio manualmente por meio do SageMaker console?

O modelo Backstage oferece várias vantagens em relação à implantação manual do AWS console, incluindo configurações padronizadas que seguem as melhores práticas organizacionais, implantação automatizada de IaC usando o Seed-Farmer e o AWS CDK, políticas de segurança e medidas de conformidade integradas e integração com os fluxos de trabalho de desenvolvedores de sua organização. GitHub O modelo também cria implantações reproduzíveis com controle de versão, o que facilita a replicação de ambientes em diferentes estágios (desenvolvimento, preparação, produção) e mantém a consistência entre as equipes. Além disso, o modelo inclui recursos de limpeza automatizados e se integra ao sistema de gerenciamento de identidade da sua organização por meio do Backstage. A implantação manual por meio do console exige profundo AWS conhecimento e não fornece controle de versão ou o mesmo nível de padronização e governança que o modelo oferece. Por esses motivos, as implantações de console são mais adequadas para experimentos únicos do que ambientes de ML de produção.

O que é o Seed-Farmer e por que essa solução o usa?

O Seed-Farmer é uma ferramenta de orquestração de AWS implantação que gerencia módulos de infraestrutura usando o. AWS CDK Esse padrão usa o Seed-Farmer porque fornece componentes de infraestrutura padronizados e reutilizáveis que são projetados especificamente para AI/ML cargas de trabalho, manipula dependências complexas entre si Serviços da AWS automaticamente e garante implantações consistentes em diferentes ambientes.

Preciso instalar o AWS CLI para usar esses modelos?

Não, você não precisa instalar o AWS CLI no seu computador. Os modelos são executados inteiramente por meio de GitHub ações na nuvem. Você fornece suas AWS credenciais (chave de acesso, chave secreta e token de sessão) por meio da interface do Backstage, e a implantação acontece automaticamente no ambiente GitHub Actions.

Quanto tempo é necessário para implantar um ambiente SageMaker Studio?

Uma implantação típica do SageMaker Studio leva de 15 a 25 minutos para ser concluída. Isso inclui AWS CDK inicialização (2 a 3 minutos), configuração do conjunto de ferramentas Seed-Farmer (3 a 5 minutos) e criação de recursos (10 a 15 minutos). O tempo exato depende de você Região da AWS e da complexidade de sua configuração de rede.

Posso implantar vários SageMaker ambientes no mesmo ambiente Conta da AWS?

Sim. Cada implantação cria recursos com nomes exclusivos com base no nome do componente que você fornece no modelo. No entanto, esteja ciente das AWS service (Serviço da AWS) cotas: cada conta pode ter um número limitado de SageMaker domínios por região, portanto, verifique suas cotas antes de criar vários ambientes.