As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Agentes generativos de IA: substituindo a lógica simbólica por LLMs

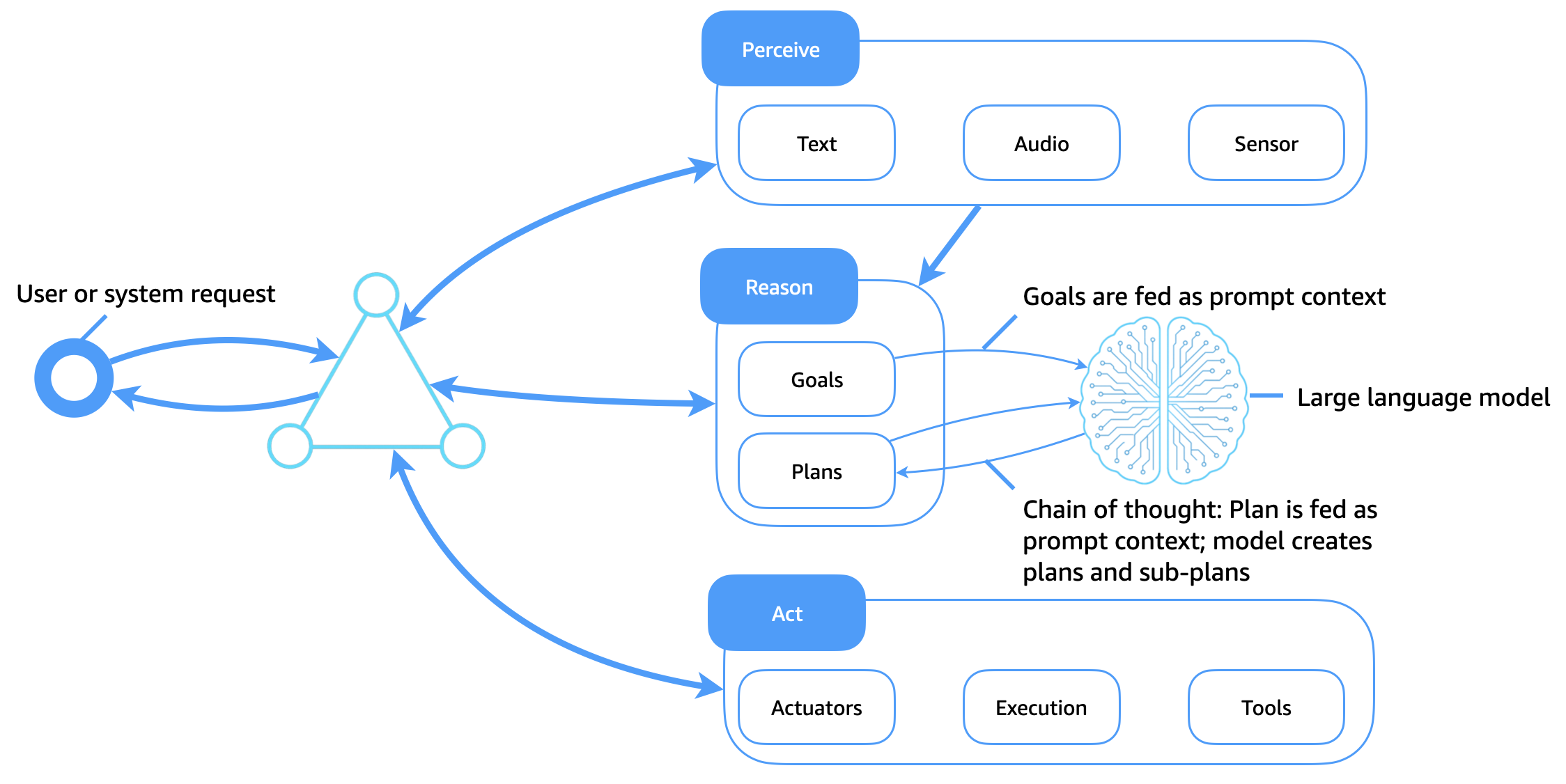

O diagrama a seguir ilustra como grandes modelos de linguagem (LLMs) agora servem como um núcleo cognitivo flexível e inteligente para agentes de software. Em contraste com os sistemas lógicos simbólicos tradicionais, que dependem de bibliotecas de planos estáticos e regras codificadas manualmente, LLMs permitem o raciocínio adaptativo, o planejamento contextual e o uso dinâmico de ferramentas, que transformam a forma como os agentes percebem, raciocinam e agem.

Principais aprimoramentos

Essa arquitetura aprimora a arquitetura tradicional do agente da seguinte forma:

-

LLMs como mecanismos cognitivos: metas, planos e consultas são passados para o modelo como contexto imediato. O LLM gera caminhos de raciocínio (como cadeia de pensamento), decompõe tarefas em sub-metas e decide sobre as próximas ações.

-

Uso da ferramenta por meio de solicitação: LLMs pode ser direcionado por meio de agentes de uso de ferramentas ou de raciocínio e ação (ReAct) solicitando a chamada APIs e a pesquisa, consulta, cálculo e interpretação de saídas.

-

Planejamento sensível ao contexto: os agentes geram ou revisam planos dinamicamente com base na meta atual, no ambiente de entrada e no feedback do agente, sem exigir bibliotecas de planos codificadas.

-

Contexto imediato como memória: em vez de usar bases de conhecimento simbólicas, os agentes codificam memória, planos e metas como tokens imediatos que são passados para o modelo.

-

Aprendizagem por meio de aprendizado rápido e contextual: LLMs adapte comportamentos por meio de engenharia rápida, o que reduz a necessidade de reciclagem explícita ou bibliotecas de planos rígidas.

Obtendo memória de longo prazo em agentes baseados em LLM

Ao contrário dos agentes tradicionais, que armazenavam memória de longo prazo em bases de conhecimento estruturadas, os agentes generativos de IA devem trabalhar dentro das limitações da janela de contexto do LLMs. Para ampliar a memória e apoiar a inteligência persistente, os agentes generativos de IA usam várias técnicas complementares: armazenamento de agentes, geração aumentada de recuperação (RAG), aprendizado contextual e encadeamento imediato e pré-treinamento.

Armazenamento de agentes: memória externa de longo prazo

O estado do agente, o histórico do usuário, as decisões e os resultados são armazenados em um armazenamento de memória do agente de longo prazo (como um banco de dados vetorial, armazenamento de objetos ou armazenamento de documentos). Memórias relevantes são recuperadas sob demanda e injetadas no contexto do prompt do LLM em tempo de execução. Isso cria um loop de memória persistente, em que o agente mantém a continuidade entre sessões, tarefas ou interações.

PANO

O RAG aprimora o desempenho do LLM combinando o conhecimento recuperado com os recursos generativos. Quando uma meta ou consulta é emitida, o agente pesquisa um índice de recuperação (por exemplo, por meio de uma pesquisa semântica de documentos, conversas anteriores ou conhecimento estruturado). Os resultados recuperados são anexados ao prompt do LLM, que fundamenta a geração em fatos externos ou contexto personalizado. Esse método amplia a memória efetiva do agente e melhora a confiabilidade e a exatidão factual.

Aprendizagem contextualizada e encadeamento imediato

Os agentes mantêm a memória de curto prazo usando o contexto de token na sessão e o encadeamento estruturado de prompts. Elementos contextuais, como o plano atual, os resultados das ações anteriores e o status do agente, são transmitidos entre as chamadas para orientar o comportamento.

Pré-treinamento contínuo e ajuste fino

Para agentes específicos de domínio, LLMs podem ser continuados pré-treinados em coleções personalizadas, como registros, dados corporativos ou documentação do produto. Como alternativa, o ajuste fino de instruções ou o aprendizado por reforço a partir do feedback humano (RLHF) podem incorporar um comportamento semelhante ao de um agente diretamente no modelo. Isso muda os padrões de raciocínio da lógica do pronto-tempo para a representação interna do modelo, reduz o tamanho do prompt e melhora a eficiência.

Benefícios combinados em IA agêntica

Essas técnicas, quando usadas em conjunto, permitem que agentes generativos de IA:

-

Mantenha a consciência contextual ao longo do tempo.

-

Adapte o comportamento com base no histórico ou nas preferências do usuário.

-

Tome decisões usando up-to-date conhecimento factual ou privado.

-

Dimensione para casos de uso corporativos com comportamentos persistentes, compatíveis e explicáveis.

Ao aumentar a LLMs memória externa, as camadas de recuperação e o treinamento contínuo, os agentes podem atingir um nível de continuidade e propósito cognitivos que não poderiam ser alcançados anteriormente apenas por meio de sistemas simbólicos.