기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

SageMaker HyperPod 레시피

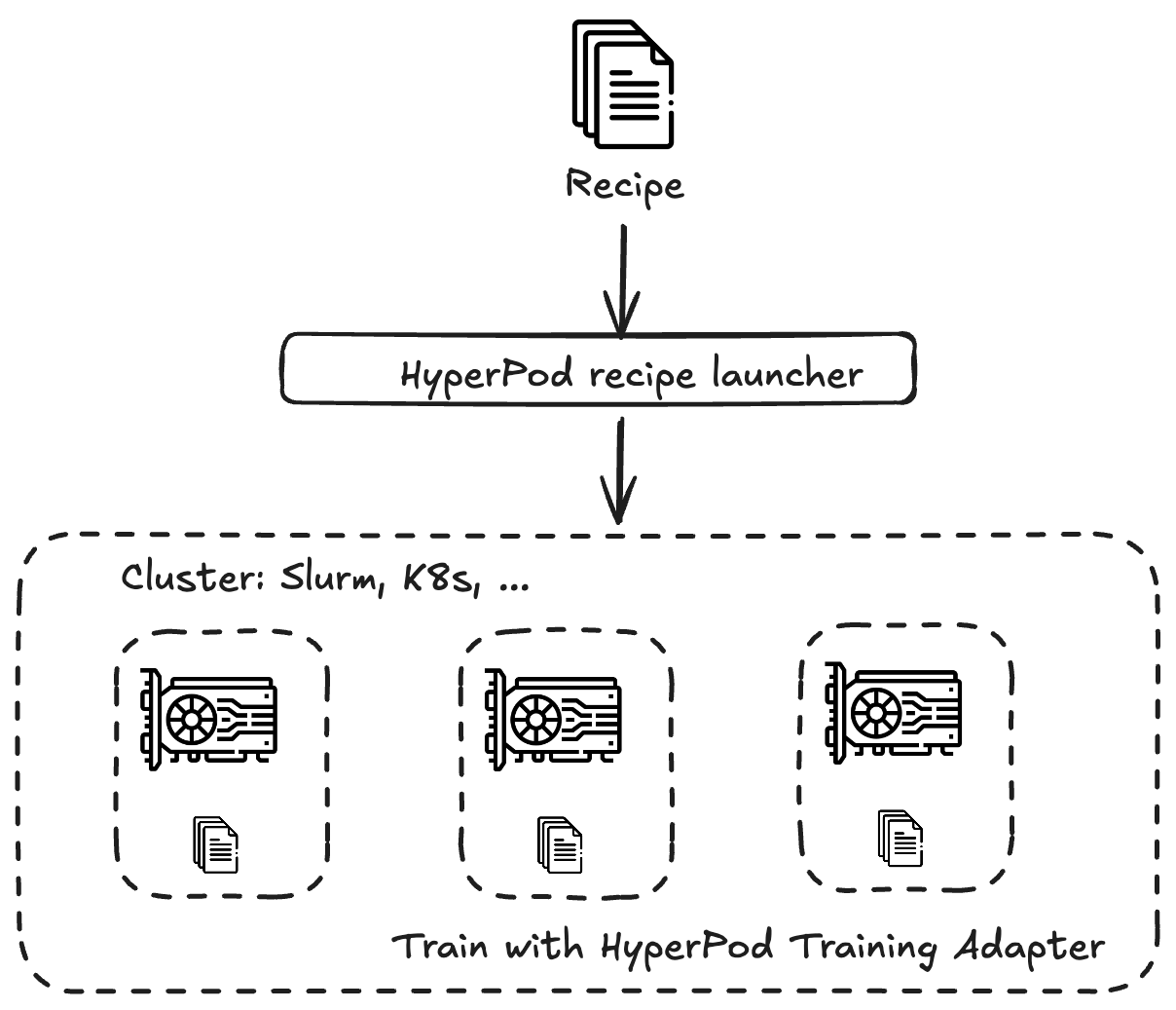

Amazon SageMaker HyperPod 레시피는 Llama, Mistral, Mixtral 또는 DeepSeek와 같은 다양한 모델 패밀리에서 공개적으로 사용 가능한 파운데이션 모델(FMs)을 빠르게 훈련하고 미세 조정할 수 AWS있도록에서 제공하는 사전 구성된 훈련 스택입니다. 레시피는 데이터세트 로드, 분산 훈련 기법 적용, 장애 복구 속도를 높이기 위한 체크포인트 관리 등 엔드투엔드 훈련 루프를 자동화합니다.

SageMaker HyperPod 레시피는 대규모 모델 훈련과 관련된 많은 복잡성을 추상화하므로 기계 학습에 대한 깊이 있는 전문성이 없는 사용자에게 특히 유용합니다.

SageMaker HyperPod 내에서 또는 SageMaker 훈련 작업으로 레시피를 실행할 수 있습니다.

다음 표는 SageMaker HyperPod GitHub 리포지토리에서 유지 관리되며 사전 훈련 및 미세 조정에 지원되는 모델, 해당 레시피 및 시작 스크립트, 지원되는 인스턴스 유형 등에 대한 최신 정보를 제공합니다.

-

사전 훈련에 지원되는 모델, 레시피 및 시작 스크립트의 최신 목록은 pre-training table

을 참조하세요. -

미세 조정 지원되는 모델, 레시피 및 시작 스크립트의 최신 목록은 fine-tuning table

을 참조하세요.

SageMaker HyperPod 사용자의 경우 엔드투엔드 훈련 워크플로의 자동화는 훈련 어댑터를 SageMaker HyperPod 레시피와 통합하여 이루어집니다. 훈련 어댑터는 NVIDIA NeMo 프레임워크

자체 사용자 지정 레시피를 정의하여 자체 모델을 훈련할 수도 있습니다.

자습서를 시작하려면 자습서 섹션을 참조하세요.