Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Integrazione con server MCP

Se hai distribuito il componente server MCP opzionale durante l'implementazione della soluzione, puoi integrare la soluzione Distributed Load Testing con strumenti di sviluppo AI che supportano il Model Context Protocol. Il server MCP fornisce l'accesso programmatico per recuperare, gestire e analizzare i test di carico tramite assistenti AI.

I clienti possono connettersi al server MCP DLT utilizzando il client di loro scelta (Amazon Q, Claude, ecc.), ognuno con istruzioni di configurazione leggermente diverse. Questa sezione fornisce istruzioni di configurazione per MCP Inspector, Amazon Q CLI, Cline e Amazon Q Suite.

Fase 1: Ottieni l'endpoint MCP e il token di accesso

Prima di configurare qualsiasi client MCP, è necessario recuperare l'endpoint del server MCP e il token di accesso dalla console web DLT.

-

Vai alla pagina MCP Server nella console web Distributed Load Testing.

-

Individuate la sezione MCP Server Endpoint.

-

Copia l'URL dell'endpoint utilizzando il pulsante Copia URL dell'endpoint. L'URL dell'endpoint segue il formato:

https://{gateway-id}.gateway.bedrock-agentcore.{region}.amazonaws.com/mcp -

Individua la sezione Access Token.

-

Copia il token di accesso utilizzando il pulsante Copia token di accesso.

Importante

Mantieni sicuro il tuo token di accesso e non condividerlo pubblicamente. Il token fornisce l'accesso in sola lettura alla soluzione Distributed Load Testing tramite l'interfaccia MCP.

Fase 2: Test con MCP Inspector

Il Model Context Protocol offre MCP Inspector

Nota

MCP Inspector richiede la versione 0.17 o successiva. Tutte le richieste possono essere effettuate anche direttamente con JSON RPC, ma MCP Inspector offre un'interfaccia più intuitiva.

Installa e avvia MCP Inspector

-

Installa npm se necessario.

-

Eseguite il seguente comando per avviare MCP Inspector:

npx @modelcontextprotocol/inspector

Configura la connessione

-

Nell'interfaccia MCP Inspector, inserite l'URL dell'endpoint del server MCP.

-

Aggiungi un'intestazione di autorizzazione con il tuo token di accesso.

-

Fate clic su Connect per stabilire la connessione.

Invoca strumenti

Una volta connesso, puoi testare gli strumenti MCP disponibili:

-

Sfoglia l'elenco degli strumenti disponibili nel pannello di sinistra.

-

Seleziona uno strumento (ad esempio,

list_scenarios). -

Fornite tutti i parametri richiesti.

-

Fate clic su Invoke per eseguire lo strumento e visualizzare la risposta.

Fase 3: Configurazione dei client di sviluppo AI

Dopo aver verificato la connessione al server MCP con MCP Inspector, puoi configurare il tuo client di sviluppo AI preferito.

CLI di Amazon Q

La CLI di Amazon Q fornisce l'accesso da riga di comando allo sviluppo assistito dall'intelligenza artificiale con l'integrazione di server MCP.

Fasi di configurazione

-

Modifica il file

mcp.jsondi configurazione. Per ulteriori informazioni sulla posizione dei file di configurazione, consulta la sezione Configurazione dei server MCP remoti nella Amazon Q Developer User Guide. -

Aggiungi la configurazione del tuo server DLT MCP:

{ "mcpServers": { "dlt-mcp": { "type": "http", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } }

Verifica la configurazione

-

In un terminale, digita

qper avviare Amazon Q CLI. -

Digita

/mcpper vedere tutti i server MCP disponibili. -

Digita

/toolsper visualizzare gli strumenti disponibili forniti dadlt-mcpe altri server MCP configurati. -

Verificate che l'inizializzazione sia

dlt-mcpavvenuta correttamente.

Cline

Cline è un assistente di codifica AI che supporta l'integrazione del server MCP.

Fasi di configurazione

-

In Cline, vai a Gestisci server MCP > Configura > Configura server MCP.

-

Aggiorna il file:

cline_mcp_settings.json{ "mcpServers": { "dlt-mcp": { "type": "streamableHttp", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } } -

Salva il file di configurazione.

-

Riavvia Cline per applicare le modifiche.

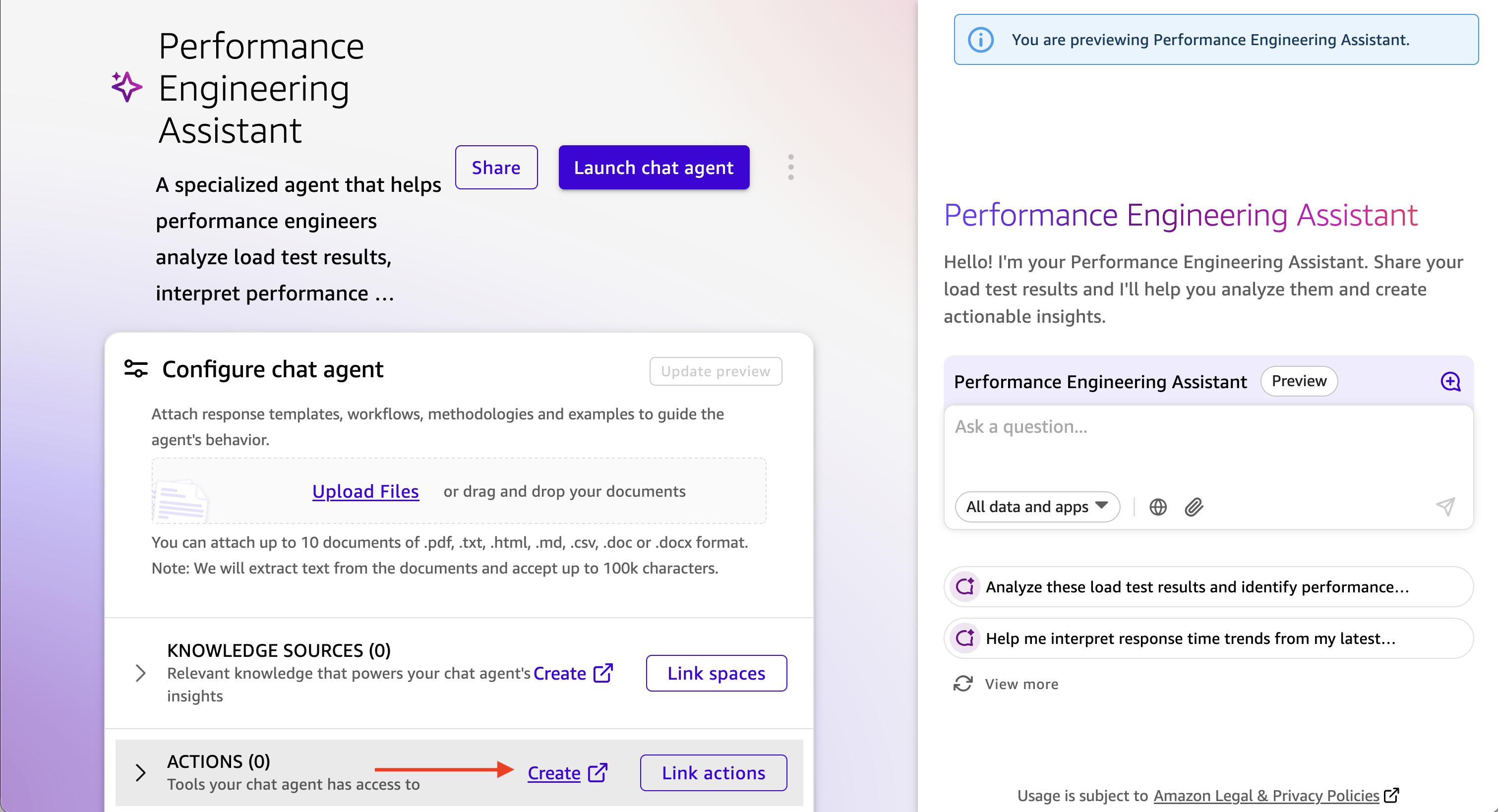

Amazon Q Suite

Amazon Q Suite offre una piattaforma di assistenza AI completa con supporto per le azioni del server MCP.

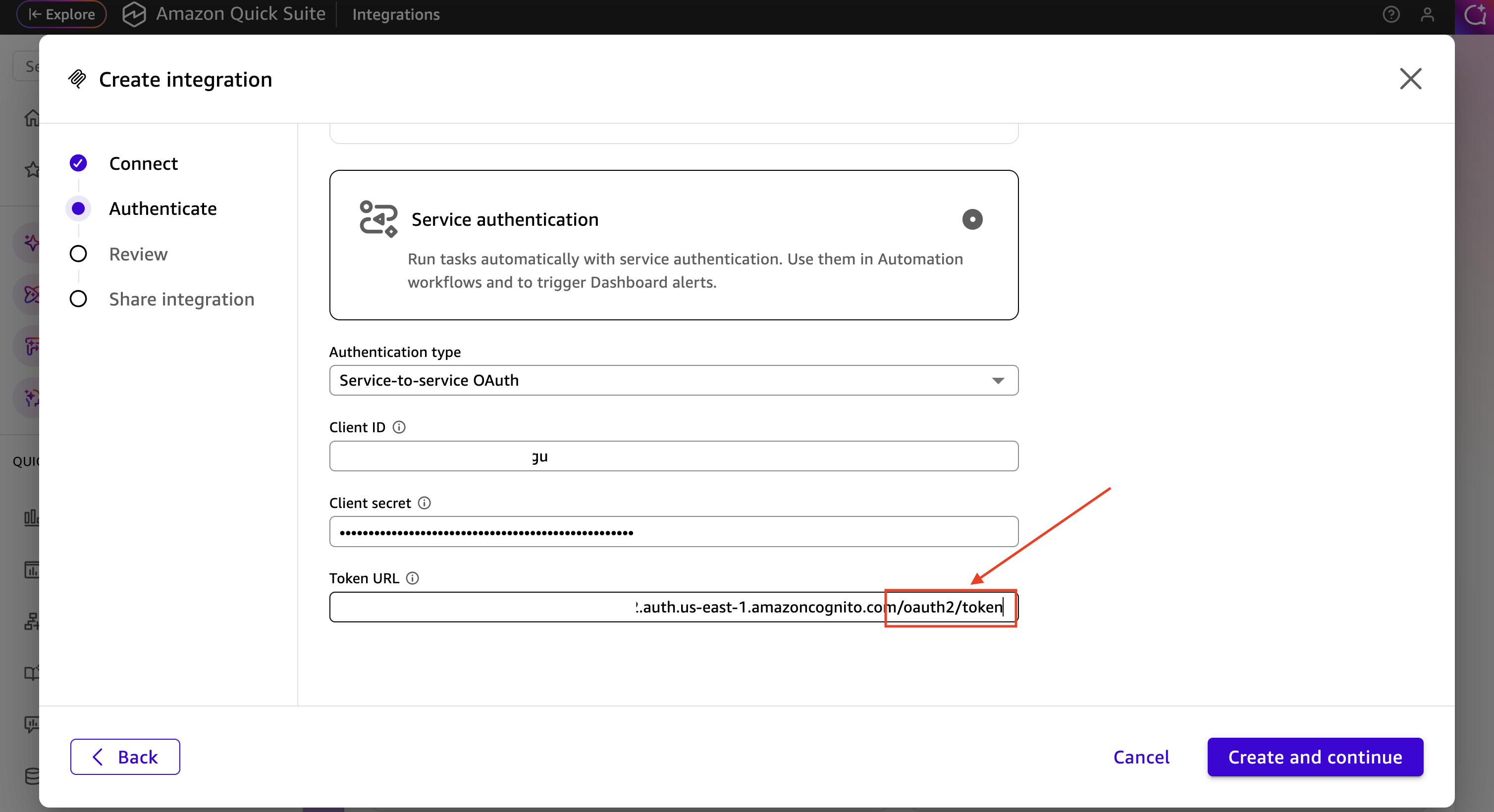

Prerequisiti

Prima di configurare il server MCP in Amazon Q Suite, devi recuperare OAuth le credenziali dal pool di utenti Cognito della distribuzione DLT:

-

Accedi alla CloudFormation console AWS

. -

Seleziona lo stack Distributed Load Testing.

-

Nella scheda Output, individua e copia l'ID del pool di utenti Cognito associato alla distribuzione DLT.

-

Passa alla console di Amazon Cognito

. -

Seleziona il pool di utenti utilizzando l'ID del pool di utenti dagli CloudFormation output.

-

Nella barra di navigazione a sinistra, seleziona App integration > App client.

-

Individua il client dell'app con il nome che termina con

m2m(machine-to-machine). -

Copia l'ID client e il segreto del cliente.

-

Ottieni il dominio del pool di utenti dalla scheda Dominio.

-

Costruisci l'URL dell'endpoint del token aggiungendolo

/oauth2/tokenalla fine del dominio.

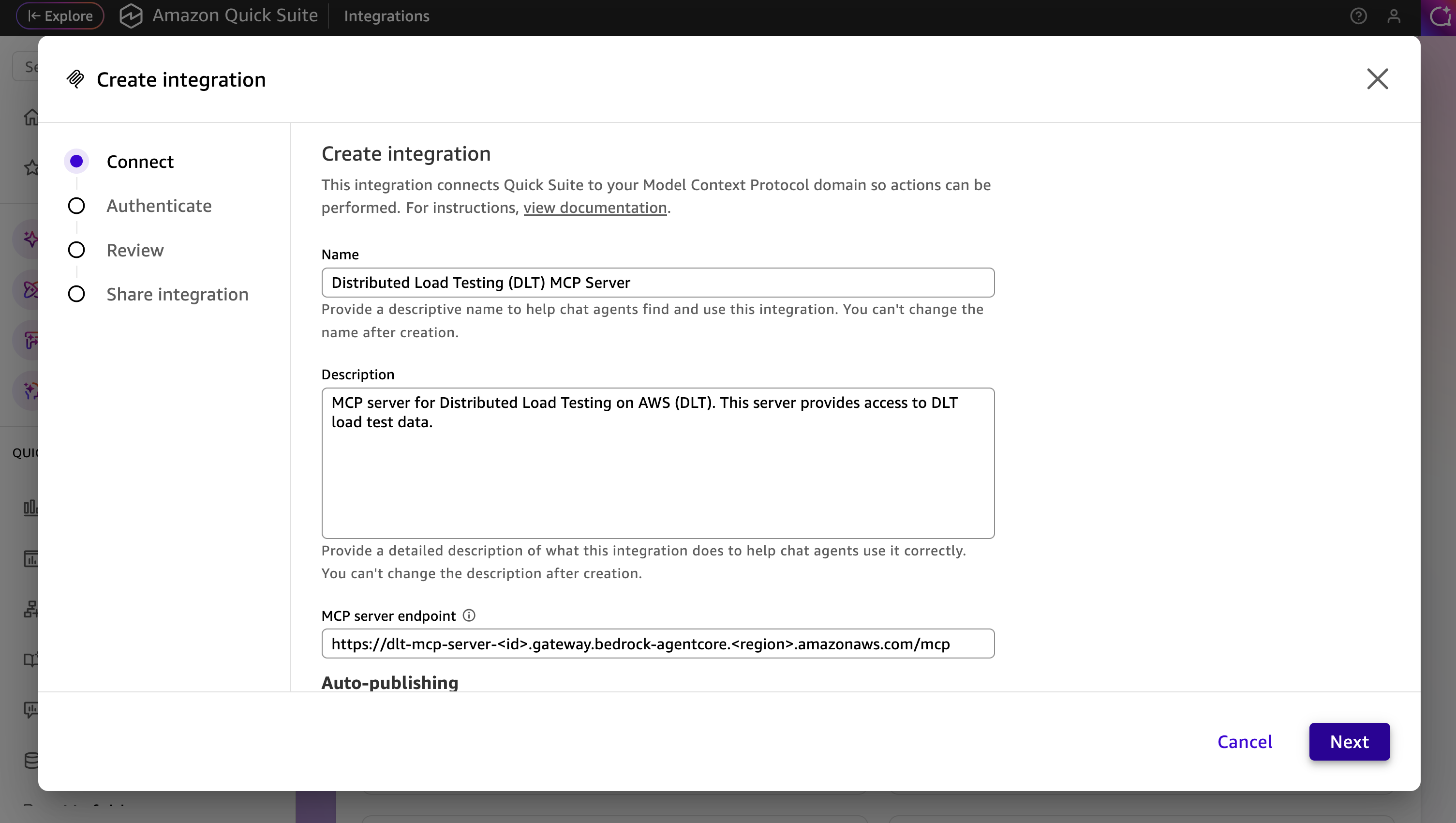

Fasi di configurazione

-

In Amazon Q Suite, crea un nuovo agente o seleziona un agente esistente.

-

Aggiungi un prompt all'agente che descrive come interagire con il server DLT MCP.

-

Aggiungi una nuova azione e seleziona l'azione del server MCP.

-

Configura i dettagli del server MCP:

-

URL del server MCP: l'endpoint DLT MCP

-

Tipo di autenticazione: autenticazione basata sui servizi

-

Token Endpoint: l'URL dell'endpoint del token Cognito

-

ID client: l'ID client del client dell'app m2m

-

Client Secret: il client secret del client dell'app m2m

-

-

Salva la configurazione dell'azione del server MCP.

-

Aggiungi la nuova azione del server MCP al tuo agente.

Avvia e testa l'agente

-

Avvia l'agente in Amazon Q Suite.

-

Inizia una conversazione con l'agente utilizzando istruzioni in linguaggio naturale.

-

L'agente utilizzerà gli strumenti MCP per recuperare e analizzare i dati dei test di carico.

Prompt di esempio

Gli esempi seguenti mostrano come interagire con l'assistente AI per analizzare i dati dei test di carico tramite l'interfaccia MCP. Personalizza il test IDs, gli intervalli di date e i criteri per soddisfare le tue esigenze di test specifiche.

Per informazioni dettagliate sugli strumenti MCP disponibili e sui relativi parametri, fate riferimento alle specifiche degli strumenti MCP nella Developer Guide.

Semplice interrogazione dei risultati dei test

L'interazione del linguaggio naturale con il server MCP può essere tanto semplice quanto Show me the load tests that have completed in the last 24 hours with their associated completion status più descrittiva, ad esempio

Use list_scenarios to find my load tests. Then use get_latest_test_run to show me the basic execution data and performance metrics for the most recent test. If the results look concerning, also get the detailed performance metrics using get_test_run.

Analisi interattiva delle prestazioni con divulgazione progressiva

I need to analyze my load test performance, but I'm not sure which specific tests to focus on. Please help me by: 1. First, use list_scenarios to show me available test scenarios 2. Ask me which tests I want to analyze based on the list you show me 3. For my selected tests, use list_test_runs to get the test run history 4. Then use get_test_run with the test_run_id to get detailed response times, throughput, and error rates 5. If I want to compare tests, use get_baseline_test_run to compare against the baseline 6. If there are any issues, use get_test_run_artifacts to help me understand what went wrong Please guide me through this step by step, asking for clarification whenever you need more specific information.

Convalida della prontezza di produzione

Help me validate if my API is ready for production deployment: 1. Use list_scenarios to find recent test scenarios 2. For the most recent test scenario, use get_latest_test_run to get basic execution data 3. Use get_test_run with that test_run_id to get detailed response times, error rates, and throughput 4. Use get_scenario_details with the test_id to show me what load patterns and endpoints were tested 5. If I have a baseline, use get_baseline_test_run to compare current results with the baseline 6. Provide a clear go/no-go recommendation based on the performance data 7. If there are any concerns, use get_test_run_artifacts to help identify potential issues My SLA requirements are: response time under [X]ms, error rate under [Y]%.

Analisi delle tendenze delle prestazioni

Analyze the performance trend for my load tests over the past [TIME_PERIOD]: 1. Use list_scenarios to get all test scenarios 2. For each scenario, use list_test_runs with start_date and end_date to get tests from that period 3. Use get_test_run for the key test runs to get detailed metrics 4. Use get_baseline_test_run to compare against the baseline 5. Identify any significant changes in response times, error rates, or throughput 6. If you detect performance degradation, use get_test_run_artifacts on the problematic tests to help identify causes 7. Present the trend analysis in a clear format showing whether performance is improving, stable, or degrading Focus on completed tests and limit results to [N] tests if there are too many.

Risoluzione dei problemi dei test falliti

Help me troubleshoot my failed load tests: 1. Use list_scenarios to find test scenarios 2. For each scenario, use list_test_runs to find recent test runs 3. Use get_test_run with the test_run_id to get the basic execution data and failure information 4. Use get_test_run_artifacts to get detailed error messages and logs 5. Use get_scenario_details to understand what was being tested when it failed 6. If I have a similar test that passed, use get_baseline_test_run to identify differences 7. Summarize the causes of failure and suggest next steps for resolution Show me the most recent [N] failed tests from the past [TIME_PERIOD].