Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Comprensione delle opzioni per implementare i modelli e ottenere inferenze in Amazon SageMaker AI

Per aiutarti a iniziare a utilizzare l’inferenza di SageMaker AI, consulta le seguenti sezioni in cui vengono illustrate le opzioni per implementare il tuo modello in SageMaker AI e ottenere inferenze. La sezione Opzioni di inferenza in Amazon SageMaker AI può aiutarti a determinare quale funzionalità è più adatta al tuo caso d’uso per l’inferenza.

È possibile fare riferimento alla sezione Risorse per ulteriori informazioni sulla risoluzione dei problemi e per riferimento, blog ed esempi per aiutarti a iniziare e per domande frequenti comuni.

Argomenti

Prima di iniziare

Questi argomenti presuppongono che tu abbia creato e preparato uno o più modelli di machine learning e che siano pronti per la distribuzione. Non è necessario addestrare il modello in SageMaker AI per implementarlo in SageMaker AI e ottenere inferenze. Se non disponi di un modello personale, puoi anche utilizzare gli algoritmi integrati o i modelli preaddestrati di SageMaker AI.

Se non conosci SageMaker AI e non hai ancora scelto un modello da implementare, segui le fasi indicati nel tutorial Nozioni di base su Amazon SageMaker AI. Utilizza il tutorial per acquisire familiarità con il modo in cui SageMaker AI gestisce il processo di data science e l’implementazione dei modelli. Per ulteriori informazioni sull'addestramento di un modello, consulta Addestramento di modelli.

Per ulteriori informazioni, riferimenti ed esempi, consulta Risorse.

Fasi per l’implementazione di un modello

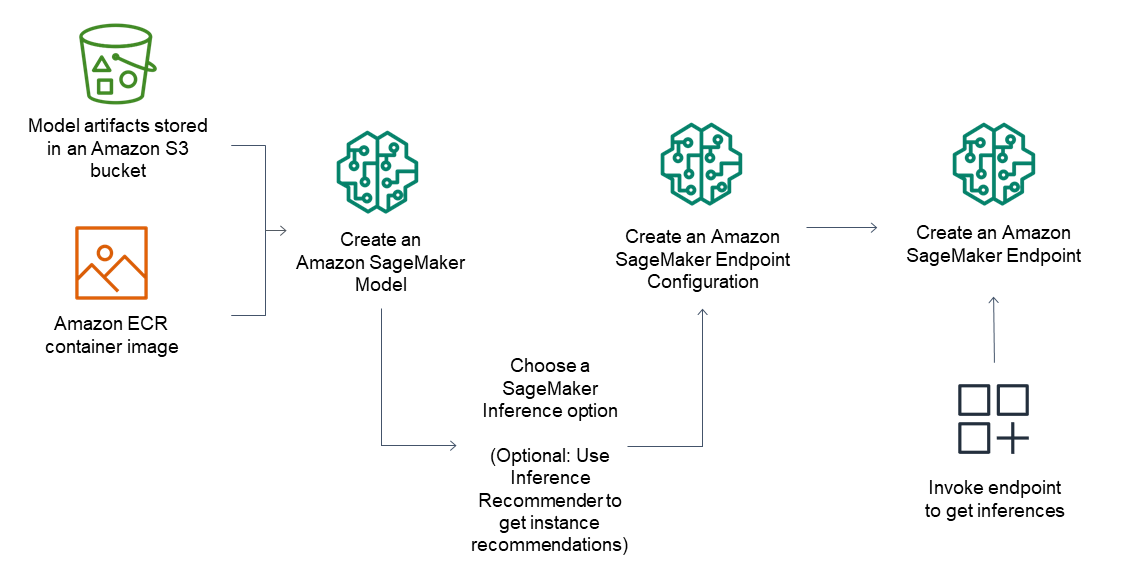

Per gli endpoint di inferenza, il flusso di lavoro generale comprende:

Crea un modello in SageMaker AI Inference indicando gli artefatti del modello archiviati in Amazon S3 e un’immagine del container.

Selezionare un'opzione di inferenza. Per ulteriori informazioni, consulta Opzioni di inferenza in Amazon SageMaker AI.

Crea una configurazione dell’endpoint in SageMaker AI Inference scegliendo il tipo di istanza e il numero di istanze necessarie sull’endpoint. È possibile usare Inferenza con funzione di suggerimento Amazon SageMaker per ottenere suggerimenti sui tipi di istanze. Per inferenza serverless, devi solo fornire la configurazione di memoria necessaria in base alle dimensioni del modello.

Crea un endpoint in SageMaker AI Inference.

Richiama il tuo endpoint per ricevere come risposta un'inferenza.

Il diagramma mostra il precedente flusso di lavoro:

È possibile eseguire queste azioni utilizzando la console AWS, gli SDK AWS, l'SDK Python SageMaker, CloudFormation o il AWS CLI.

Per l'inferenza in batch con la trasformazione in batch, punti agli artefatti del modello e ai dati di input e crei un processo di inferenza in batch. Anziché ospitare un endpoint per l’inferenza, SageMaker AI invia le inferenze a una posizione Amazon S3 di tua scelta.