Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Dati personali OU — Account dell'applicazione PD

Sondaggio

Ci piacerebbe sentire la tua opinione. Fornisci un feedback sul AWS PRA rispondendo a un breve sondaggio

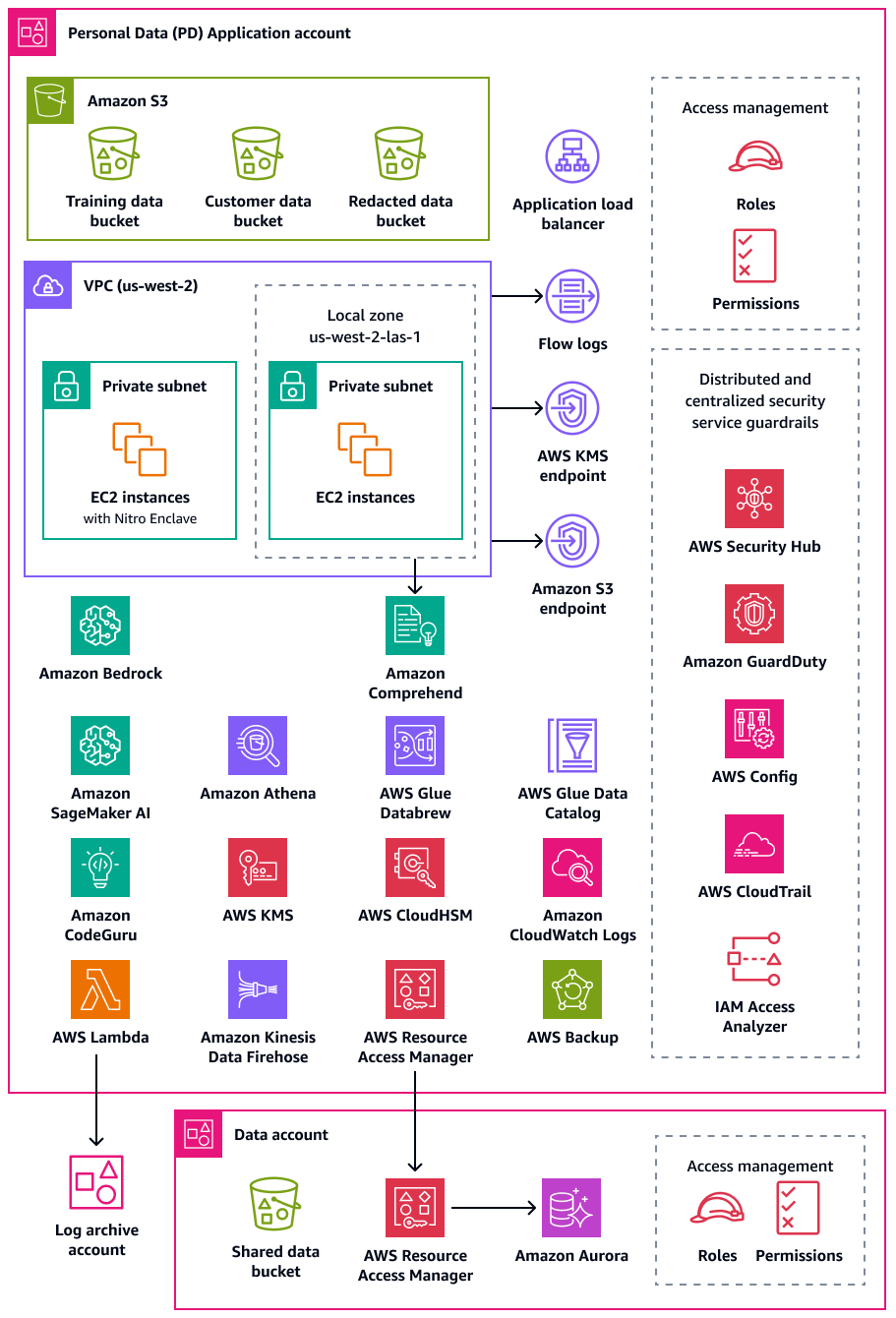

L'account dell'applicazione per i dati personali (PD) è il luogo in cui la tua organizzazione ospita servizi che raccolgono ed elaborano dati personali. In particolare, potresti archiviare quelli che definisci come dati personali in questo account. Il AWS PRA illustra una serie di esempi di configurazioni di privacy attraverso un'architettura web serverless a più livelli. Quando si tratta di gestire carichi di lavoro in una AWS landing zone, le configurazioni di privacy non dovrebbero essere considerate one-size-fits-all soluzioni. Ad esempio, l'obiettivo potrebbe essere quello di comprendere i concetti di base, come possono migliorare la privacy e come l'organizzazione può applicare soluzioni a casi d'uso e architetture particolari.

Account AWS Nell'organizzazione che raccoglie, archivia o elabora dati personali, è possibile utilizzare AWS Organizations e AWS Control Tower implementare barriere di base e ripetibili. La creazione di un'unità organizzativa (OU) dedicata per questi account è fondamentale. Ad esempio, potresti voler applicare i limiti di residenza dei dati solo a un sottoinsieme di account in cui la residenza dei dati è una considerazione di progettazione fondamentale. Per molte organizzazioni, questi sono gli account che archiviano ed elaborano i dati personali.

La tua organizzazione potrebbe prendere in considerazione la possibilità di supportare un account Data dedicato, che è il luogo in cui archivi la fonte autorevole dei tuoi set di dati personali. Una fonte di dati autorevole è un luogo in cui è archiviata la versione principale dei dati, che potrebbe essere considerata la versione più affidabile e accurata dei dati. Ad esempio, puoi copiare i dati dalla fonte di dati autorevole in altre posizioni, come i bucket Amazon Simple Storage Service (Amazon S3) nell'account PD Application, utilizzati per archiviare dati di formazione, un sottoinsieme di dati dei clienti e dati oscurati. Adottando questo approccio multi-account per separare i set di dati personali completi e definitivi nell'account Data dai carichi di lavoro dei consumatori a valle nell'account PD Application, puoi ridurre l'ambito di impatto in caso di accesso non autorizzato ai tuoi account.

Il diagramma seguente illustra i servizi di AWS sicurezza e privacy configurati negli account PD Application and Data.

Questa sezione fornisce informazioni più dettagliate sui seguenti elementi Servizi AWS utilizzati in questi account:

Amazon Athena

Puoi prendere in considerazione i controlli di limitazione delle interrogazioni sui dati per raggiungere i tuoi obiettivi di privacy. Amazon Athena è un servizio di query interattivo che ti aiuta ad analizzare i dati direttamente in Amazon S3 utilizzando SQL standard. Non è necessario caricare i dati in Athena; funziona direttamente con i dati archiviati nei bucket S3.

Un caso d'uso comune per Athena è fornire ai team di analisi dei dati set di dati personalizzati e sanificati. Se i set di dati contengono dati personali, puoi disinfettare il set di dati mascherando intere colonne di dati personali che forniscono poco valore ai team di analisi dei dati. Per ulteriori informazioni, consulta Rendere anonimi e gestire i dati nel tuo data lake con Amazon Athena AWS Lake Formation

Se il tuo approccio alla trasformazione dei dati richiede una flessibilità aggiuntiva oltre alle funzioni supportate in Athena, puoi definire funzioni personalizzate, chiamate funzioni definite dall'utente (UDF). È possibile richiamarle UDFs in una query SQL inviata ad Athena ed eseguirle. AWS LambdaÈ possibile utilizzare UDFs le FILTER

SQL query SELECT e richiamarne più di una UDFs nella stessa query. Per motivi di privacy, è possibile creare UDFs sistemi che eseguano tipi specifici di mascheramento dei dati, ad esempio mostrando solo gli ultimi quattro caratteri di ogni valore in una colonna.

Amazon Bedrock

Amazon Bedrock è un servizio completamente gestito che fornisce l'accesso ai modelli di base delle principali aziende di intelligenza artificiale come AI21 Labs, Anthropic, Meta, Mistral AI e Amazon. Aiuta le organizzazioni a creare e scalare applicazioni di intelligenza artificiale generativa. Indipendentemente dalla piattaforma utilizzata, quando si utilizza l'intelligenza artificiale generativa, le organizzazioni potrebbero affrontare rischi per la privacy, tra cui la potenziale esposizione di dati personali, l'accesso non autorizzato ai dati e altre violazioni della conformità.

Amazon Bedrock Guardrails è progettato per aiutare a mitigare questi rischi applicando le migliori pratiche di sicurezza e conformità nei carichi di lavoro di intelligenza artificiale generativa in Amazon Bedrock. L'implementazione e l'uso delle risorse di intelligenza artificiale potrebbero non essere sempre in linea con i requisiti di privacy e conformità di un'organizzazione. Organizations può avere difficoltà a mantenere la privacy dei dati quando utilizzano modelli di intelligenza artificiale generativa perché questi modelli possono potenzialmente memorizzare o riprodurre informazioni sensibili. Amazon Bedrock Guardrails aiuta a proteggere la privacy valutando gli input degli utenti e modellando le risposte. Nel complesso, se i dati di input contengono dati personali, può esserci il rischio che queste informazioni vengano esposte nell'output del modello.

Amazon Bedrock Guardrails fornisce meccanismi per applicare le politiche di protezione dei dati e aiuta a prevenire l'esposizione non autorizzata dei dati. Offre funzionalità di filtraggio dei contenuti per rilevare e bloccare i dati personali negli input, restrizioni tematiche per impedire l'accesso ad argomenti inappropriati o rischiosi e filtri testuali per mascherare o oscurare i termini sensibili nei prompt e nelle risposte del modello. Queste funzionalità aiutano a prevenire eventi che potrebbero portare a violazioni della privacy, come risposte distorte o erosione della fiducia dei clienti. Queste funzionalità possono aiutarti a garantire che i dati personali non vengano elaborati o divulgati inavvertitamente dai tuoi modelli di intelligenza artificiale. Amazon Bedrock Guardrails supporta la valutazione di input e risposte anche al di fuori di Amazon Bedrock. Per ulteriori informazioni, consulta Implementazione di misure di sicurezza indipendenti dal modello con Amazon Bedrock Guardrails

Con Amazon Bedrock Guardrails, puoi limitare il rischio di allucinazioni modello utilizzando controlli contestuali di base, che valutano il fondamento fattuale e la pertinenza delle risposte. Un esempio è l'implementazione di un'applicazione di intelligenza artificiale generativa rivolta ai clienti che utilizza fonti di dati di terze parti in un'applicazione Retrieval Augmented Generation (RAG).

AWS Clean Rooms

Poiché le organizzazioni cercano modi per collaborare tra loro attraverso l'analisi di set di dati sensibili che si intersecano o si sovrappongono, è importante mantenere la sicurezza e la privacy di tali dati condivisi. AWS Clean Roomsti aiuta a implementare camere pulite per i dati, che sono ambienti sicuri e neutri in cui le organizzazioni possono analizzare set di dati combinati senza condividere i dati grezzi stessi. Inoltre, può generare informazioni uniche fornendo l'accesso ad altre organizzazioni AWS senza spostare o copiare i dati dai propri account e senza rivelare il set di dati sottostante. Tutti i dati rimangono nella posizione di origine. Le regole di analisi integrate limitano l'output e limitano le query SQL. Tutte le interrogazioni vengono registrate e i membri della collaborazione possono visualizzare in che modo vengono interrogati i propri dati.

È possibile creare una AWS Clean Rooms collaborazione e invitare altri AWS clienti a diventare membri di tale collaborazione. Si concede a un membro la possibilità di interrogare i set di dati dei membri e si possono scegliere altri membri per ricevere i risultati di tali interrogazioni. Se più di un membro deve interrogare i set di dati, puoi creare collaborazioni aggiuntive con le stesse fonti di dati e diverse impostazioni dei membri. Ogni membro può filtrare i dati condivisi con i membri della collaborazione ed è possibile utilizzare regole di analisi personalizzate per impostare limitazioni al modo in cui possono essere analizzati i dati che fornisce alla collaborazione.

Oltre a limitare i dati presentati alla collaborazione e il modo in cui possono essere utilizzati dagli altri membri, AWS Clean Rooms offre le seguenti funzionalità che possono aiutarti a proteggere la privacy:

-

La privacy differenziale è una tecnica matematica che migliora la privacy degli utenti aggiungendo una quantità di rumore accuratamente calibrata ai dati. Ciò aiuta a ridurre il rischio di reidentificazione dei singoli utenti all'interno del set di dati senza oscurare i valori di interesse. L'utilizzo della privacy AWS Clean Rooms differenziale non richiede competenze in materia di privacy differenziale.

-

AWS Clean Rooms Il machine learning consente a due o più parti di identificare utenti simili nei propri dati senza condividerli direttamente tra loro. Ciò riduce il rischio di attacchi di inferenza dei membri, in cui un membro della collaborazione può identificare le persone nel set di dati dell'altro membro. Creando un modello simile e generando un segmento simile, il machine learning consente di confrontare i set di dati AWS Clean Rooms senza esporre i dati originali. Ciò non richiede che nessuno dei membri abbia esperienza nel machine learning o svolga alcun lavoro al di fuori di. AWS Clean Rooms Mantieni il pieno controllo e la proprietà del modello addestrato.

-

Cryptographic Computing for Clean Rooms (C3R) può essere utilizzato con regole di analisi per ricavare informazioni da dati sensibili. Limita crittograficamente ciò che qualsiasi altra parte coinvolta nella collaborazione può apprendere. Utilizzando il client di crittografia C3R, i dati vengono crittografati sul client prima di essere forniti. AWS Clean Rooms Poiché le tabelle di dati vengono crittografate utilizzando uno strumento di crittografia lato client prima di essere caricate su Amazon S3, i dati rimangono crittografati e persistono durante l'elaborazione.

Nel AWS PRA, ti consigliamo di creare AWS Clean Rooms collaborazioni nell'account Data. Puoi usarli per condividere i dati crittografati dei clienti con terze parti. Utilizzali solo quando c'è una sovrapposizione nei set di dati forniti. Per ulteriori informazioni su come determinare la sovrapposizione, consulta la regola di analisi delle liste nella documentazione. AWS Clean Rooms

CloudWatch Registri Amazon

Amazon CloudWatch Logs ti aiuta a centralizzare i log di tutti i tuoi sistemi e applicazioni, Servizi AWS così puoi monitorarli e archiviarli in modo sicuro. In CloudWatch Logs, puoi utilizzare una politica di protezione dei dati per gruppi di log nuovi o esistenti per ridurre al minimo il rischio di divulgazione di dati personali. Le politiche di protezione dei dati possono rilevare dati sensibili, come i dati personali, nei registri. La politica di protezione dei dati può mascherare tali dati quando gli utenti accedono ai registri tramite. Console di gestione AWS Quando gli utenti richiedono l'accesso diretto ai dati personali, in base alle specifiche generali dello scopo del carico di lavoro, è possibile assegnare logs:Unmask le autorizzazioni a tali utenti. Puoi anche creare una politica di protezione dei dati a livello di account e applicarla in modo coerente a tutti gli account della tua organizzazione. Questo configura il mascheramento per impostazione predefinita per tutti i gruppi di log attuali e futuri in CloudWatch Logs. Ti consigliamo inoltre di abilitare i report di controllo e di inviarli a un altro gruppo di log, a un bucket Amazon S3 o Amazon Data Firehose. Questi report contengono un registro dettagliato dei risultati sulla protezione dei dati in ogni gruppo di log.

CodeGuru Revisore Amazon

Sia per la privacy che per la sicurezza, è fondamentale per molte organizzazioni supportare la conformità continua durante le fasi di implementazione e post-implementazione. Il AWS PRA include controlli proattivi nelle pipeline di implementazione per le applicazioni che elaborano dati personali. Amazon CodeGuru Reviewer è in grado di rilevare potenziali difetti che potrebbero esporre i dati personali nel codice Java e Python. JavaScript Offre suggerimenti agli sviluppatori per migliorare il codice. CodeGuru Reviewer è in grado di identificare i difetti relativi a un'ampia gamma di procedure di sicurezza, privacy e raccomandazioni generali. È progettato per funzionare con più provider di sorgenti AWS CodeCommit, tra cui Bitbucket e Amazon GitHub S3. Alcuni dei difetti relativi alla privacy che Reviewer è in grado di rilevare includono: CodeGuru

-

iniezione SQL

-

Cookie non protetti

-

Autorizzazione mancante

-

Ricrittografia lato client AWS KMS

Per un elenco completo di ciò che CodeGuru Reviewer è in grado di rilevare, consulta Amazon CodeGuru Detector Library.

Amazon Comprehend

Amazon Comprehend è un servizio di elaborazione del linguaggio naturale (NLP) che utilizza l'apprendimento automatico per scoprire informazioni e connessioni preziose nei documenti di testo in inglese. Amazon Comprehend è in grado di rilevare e redigere dati personali in documenti di testo strutturati, semistrutturati o non strutturati. Per ulteriori informazioni, consulta Informazioni di identificazione personale (PII) nella documentazione di Amazon Comprehend.

Puoi utilizzare l'API AWS SDKs e Amazon Comprehend per integrare Amazon Comprehend con molte applicazioni. Un esempio è l'utilizzo di Amazon Comprehend per rilevare e redigere dati personali con Amazon S3 Object Lambda. Le organizzazioni possono utilizzare S3 Object Lambda per aggiungere codice personalizzato alle richieste Amazon S3 GET per modificare ed elaborare i dati non appena vengono restituiti a un'applicazione. S3 Object Lambda può filtrare le righe, ridimensionare dinamicamente le immagini, oscurare i dati personali e altro ancora. Basato sulle AWS Lambda funzioni, il codice viene eseguito su un'infrastruttura completamente gestita da AWS, il che elimina la necessità di creare e archiviare copie derivate dei dati o di eseguire proxy. Non è necessario modificare le applicazioni per trasformare gli oggetti con S3 Object Lambda. Puoi utilizzare la funzione ComprehendPiiRedactionS3Object Lambda per AWS Serverless Application Repository oscurare i dati personali. Questa funzione utilizza Amazon Comprehend per rilevare le entità di dati personali e oscura tali entità sostituendole con asterischi. Per ulteriori informazioni, consulta Rilevamento e redazione dei dati PII con S3 Object Lambda e Amazon Comprehend nella documentazione di Amazon S3.

Poiché Amazon Comprehend offre molte opzioni per l'integrazione delle applicazioni tramite AWS SDKs, puoi utilizzare Amazon Comprehend per identificare i dati personali in molti luoghi diversi in cui li raccogli, archivia ed elabora. Puoi utilizzare le funzionalità di Amazon Comprehend ML per rilevare e redigere i dati personali nei log delle applicazioni

-

REPLACE_WITH_PII_ENTITY_TYPEsostituisce ogni entità PII con i relativi tipi. Ad esempio, Jane Doe verrebbe sostituita da NAME. -

MASKsostituisce i caratteri delle entità PII con un carattere a tua scelta (! , #, $,%, &, o @). Ad esempio, Jane Doe potrebbe essere sostituita con **** ***.

Amazon Data Firehose

Amazon Data Firehose può essere utilizzato per acquisire, trasformare e caricare dati di streaming in servizi downstream, come Amazon Managed Service per Apache Flink o Amazon S3. Firehose viene spesso utilizzato per trasportare grandi quantità di dati in streaming, come i log delle applicazioni, senza dover creare pipeline di elaborazione da zero.

È possibile utilizzare le funzioni Lambda per eseguire elaborazioni personalizzate o integrate prima che i dati vengano inviati a valle. Per quanto riguarda la privacy, questa funzionalità supporta la riduzione al minimo dei dati e i requisiti di trasferimento transfrontaliero dei dati. Ad esempio, è possibile utilizzare Lambda e Firehose per trasformare i dati di registro multiregione prima che siano centralizzati nell'account Log Archive. Per ulteriori informazioni, vedete Biogen: soluzione di registrazione centralizzata per più account (video

Amazon DataZone

Man mano che le organizzazioni ampliano il loro approccio alla condivisione dei dati tramite AWS Lake Formation, ad Servizi AWS esempio, vogliono assicurarsi che l'accesso differenziale sia controllato da coloro che hanno più familiarità con i dati: i proprietari dei dati. Tuttavia, questi proprietari dei dati potrebbero essere a conoscenza dei requisiti di privacy, come il consenso o le considerazioni relative al trasferimento transfrontaliero dei dati. Amazon DataZone aiuta i proprietari dei dati e il team di governance dei dati a condividere e utilizzare i dati all'interno dell'organizzazione in base alle tue politiche di governance dei dati. In Amazon DataZone, le linee di business (LOBs) gestiscono i propri dati e un catalogo tiene traccia di questa proprietà. Le parti interessate possono trovare e richiedere l'accesso ai dati nell'ambito delle loro attività aziendali. Purché rispetti le politiche stabilite dagli editori dei dati, il proprietario dei dati può concedere l'accesso alle tabelle sottostanti, senza un amministratore o senza spostare i dati.

In un contesto di privacy, Amazon DataZone può essere utile nei seguenti casi d'uso di esempio:

-

Un'applicazione rivolta ai clienti genera dati di utilizzo che possono essere condivisi con un LOB di marketing separato. È necessario assicurarsi che nel catalogo vengano pubblicati solo i dati relativi ai clienti che hanno aderito al marketing.

-

I dati dei clienti europei vengono pubblicati, ma possono essere sottoscritti solo dagli utenti LOBs locali dello Spazio economico europeo (SEE). Per ulteriori informazioni, consulta Migliora la sicurezza dei dati con controlli di accesso granulari in Amazon

. DataZone

Nel AWS PRA, puoi connettere i dati nel bucket Amazon S3 condiviso ad Amazon DataZone come produttore di dati.

AWS Glue

La manutenzione di set di dati che contengono dati personali è un componente chiave di Privacy

AWS Glue Data Catalog

AWS Glue Data Catalogti aiuta a stabilire set di dati gestibili. Il Data Catalog contiene riferimenti ai dati utilizzati come fonti e destinazioni per i processi di estrazione, trasformazione e caricamento (ETL). AWS Glue Le informazioni nel Data Catalog vengono archiviate come tabelle di metadati e ogni tabella specifica un singolo archivio dati. Esegui un AWS Glue

crawler per fare l'inventario dei dati in una varietà di tipi di data store. Si aggiungono classificatori incorporati e personalizzati al crawler e questi classificatori deducono il formato e lo schema dei dati personali. Il crawler scrive quindi i metadati nel Data Catalog. Una tabella di metadati centralizzata può semplificare la risposta alle richieste degli interessati (ad esempio il diritto alla cancellazione) perché aggiunge struttura e prevedibilità tra le diverse fonti di dati personali presenti nell'ambiente. AWS Per un esempio completo di come utilizzare Data Catalog per rispondere automaticamente a queste richieste, consulta Gestione delle richieste di cancellazione dei dati nel tuo data lake con Amazon S3 Find and

AWS Glue DataBrew

AWS Glue DataBrewconsente di pulire e normalizzare i dati e può eseguire trasformazioni sui dati, ad esempio rimuovere o mascherare informazioni di identificazione personale e crittografare i campi di dati sensibili nelle pipeline di dati. Puoi anche mappare visivamente la provenienza dei tuoi dati per comprendere le varie fonti di dati e le fasi di trasformazione che i dati hanno subito. Questa funzionalità diventa sempre più importante man mano che l'organizzazione lavora per comprendere e tracciare meglio la provenienza dei dati personali. DataBrew ti aiuta a mascherare i dati personali durante la preparazione dei dati. È possibile rilevare i dati personali nell'ambito di un processo di profilazione dei dati e raccogliere statistiche, come il numero di colonne che potrebbero contenere dati personali e potenziali categorie. È quindi possibile utilizzare le tecniche integrate di trasformazione dei dati reversibili o irreversibili, tra cui la sostituzione, l'hashing, la crittografia e la decrittografia, il tutto senza scrivere alcun codice. È quindi possibile utilizzare i set di dati puliti e mascherati a valle per attività di analisi, reportistica e apprendimento automatico. Alcune delle tecniche di mascheramento dei dati disponibili includono: DataBrew

-

Hashing: applica le funzioni di hash ai valori delle colonne.

-

Sostituzione: sostituisci i dati personali con altri valori dall'aspetto autentico.

-

Annullamento o eliminazione: sostituisci un campo particolare con un valore nullo o elimina la colonna.

-

Mascheratura: usa il rimescolamento dei caratteri o maschera determinate parti delle colonne.

Le seguenti sono le tecniche di crittografia disponibili:

-

Crittografia deterministica: applica algoritmi di crittografia deterministica ai valori delle colonne. La crittografia deterministica produce sempre lo stesso testo cifrato per un valore.

-

Crittografia probabilistica: applica algoritmi di crittografia probabilistica ai valori delle colonne. La crittografia probabilistica produce un testo cifrato diverso ogni volta che viene applicata.

Per un elenco completo delle ricette di trasformazione dei dati personali fornite in DataBrew, consulta Procedure introduttive relative alle informazioni di identificazione personale (PII).

AWS Glue Qualità dei dati

AWS Glue Data Quality ti aiuta ad automatizzare e rendere operativa la distribuzione di dati di alta qualità attraverso le pipeline di dati, in modo proattivo, prima che vengano consegnati ai tuoi consumatori di dati. AWS Glue Data Quality fornisce un'analisi statistica dei problemi di qualità dei dati nelle tue pipeline di dati, può attivare avvisi in Amazon EventBridge e può formulare raccomandazioni sulle regole di qualità per la correzione. AWS Glue Data Quality supporta anche la creazione di regole con un linguaggio specifico del dominio in modo da poter creare regole di qualità dei dati personalizzate.

AWS Key Management Service

AWS Key Management Service (AWS KMS) consente di creare e controllare chiavi crittografiche per proteggere i dati. AWS KMS utilizza moduli di sicurezza hardware per proteggere e convalidare AWS KMS keys nell'ambito del programma di convalida dei moduli crittografici FIPS 140-2. Per ulteriori informazioni su come questo servizio viene utilizzato in un contesto di sicurezza, vedere Security Reference Architecture.AWS

AWS KMS si integra con la maggior parte delle aziende Servizi AWS che offrono la crittografia e consente di utilizzare le chiavi KMS nelle applicazioni che elaborano e archiviano dati personali. Puoi utilizzarle AWS KMS per supportare una serie di requisiti di privacy e salvaguardare i dati personali, tra cui:

-

Utilizzo di chiavi gestite dal cliente per un maggiore controllo su forza, rotazione, scadenza e altre opzioni.

-

Utilizzo di chiavi dedicate gestite dal cliente per proteggere i dati personali e i segreti che consentono l'accesso ai dati personali.

-

Definizione dei livelli di classificazione dei dati e designazione di almeno una chiave dedicata gestita dal cliente per livello. Ad esempio, potresti avere una chiave per crittografare i dati operativi e un'altra per crittografare i dati personali.

-

Impedire l'accesso involontario tra account alle chiavi KMS.

-

Archiviazione delle chiavi KMS all'interno della Account AWS stessa risorsa da crittografare.

-

Implementazione della separazione dei compiti per l'amministrazione e l'utilizzo delle chiavi KMS. Per ulteriori informazioni, consulta Come utilizzare KMS e IAM per abilitare controlli di sicurezza indipendenti per i dati crittografati in S3

(AWS post del blog). -

Imposizione della rotazione automatica delle chiavi attraverso barriere preventive e reattive.

Per impostazione predefinita, le chiavi KMS vengono archiviate e possono essere utilizzate solo nella regione in cui sono state create. Se la tua organizzazione ha requisiti specifici per la residenza e la sovranità dei dati, valuta se le chiavi KMS multiregionali sono appropriate per il tuo caso d'uso. Le chiavi multiregionali sono chiavi KMS per scopi speciali, diverse tra loro, che possono essere utilizzate in modo intercambiabile. Regioni AWS Il processo di creazione di una chiave multiregionale sposta il materiale chiave oltre Regione AWS i confini interni AWS KMS, quindi questa mancanza di isolamento regionale potrebbe non essere compatibile con gli obiettivi di sovranità e residenza dell'organizzazione. Un modo per risolvere questo problema consiste nell'utilizzare un tipo diverso di chiave KMS, ad esempio una chiave gestita dal cliente specifica per una regione.

Archivi delle chiavi esterne

Per molte organizzazioni, l'archivio di AWS KMS chiavi predefinito in è in Cloud AWS grado di soddisfare la sovranità dei dati e i requisiti normativi generali. Tuttavia, alcune potrebbero richiedere che le chiavi di crittografia vengano create e gestite al di fuori di un ambiente cloud e che siano disponibili percorsi di autorizzazione e controllo indipendenti. Grazie all'archiviazione di chiavi esterne AWS KMS, puoi crittografare i dati personali con materiale chiave che la tua organizzazione possiede e controlla all' Cloud AWS esterno. Continuate a interagire con l' AWS KMS API come al solito, ma AWS KMS interagite solo con il software proxy di archiviazione chiavi esterno (proxy XKS) fornito dall'utente. Il proxy dell'archivio chiavi esterno funge quindi da intermediario per tutte le comunicazioni tra AWS KMS e il gestore delle chiavi esterno.

Quando si utilizza un archivio di chiavi esterno per la crittografia dei dati, è importante considerare il sovraccarico operativo aggiuntivo rispetto al mantenimento delle chiavi interne. AWS KMS Con un archivio chiavi esterno, è necessario creare, configurare e gestire l'archivio chiavi esterno. Inoltre, se si verificano errori nell'infrastruttura aggiuntiva da gestire, ad esempio il proxy XKS, e la connettività viene persa, gli utenti potrebbero essere temporaneamente impossibilitati a decrittografare e accedere ai dati. Collaborate a stretto contatto con le parti interessate alla conformità e alle normative per comprendere gli obblighi legali e contrattuali per la crittografia dei dati personali e gli accordi sui livelli di servizio in materia di disponibilità e resilienza.

AWS Lake Formation

Molte organizzazioni che catalogano e classificano i propri set di dati tramite cataloghi di metadati strutturati desiderano condividere tali set di dati all'interno dell'organizzazione. È possibile utilizzare policy di autorizzazione AWS Identity and Access Management (IAM) per controllare l'accesso a interi set di dati, ma spesso è necessario un controllo più granulare per i set di dati che contengono dati personali di diversa sensibilità. Ad esempio, la specificazione dello scopo e la limitazione dell'uso

Esistono anche problemi di privacy associati ai data lake

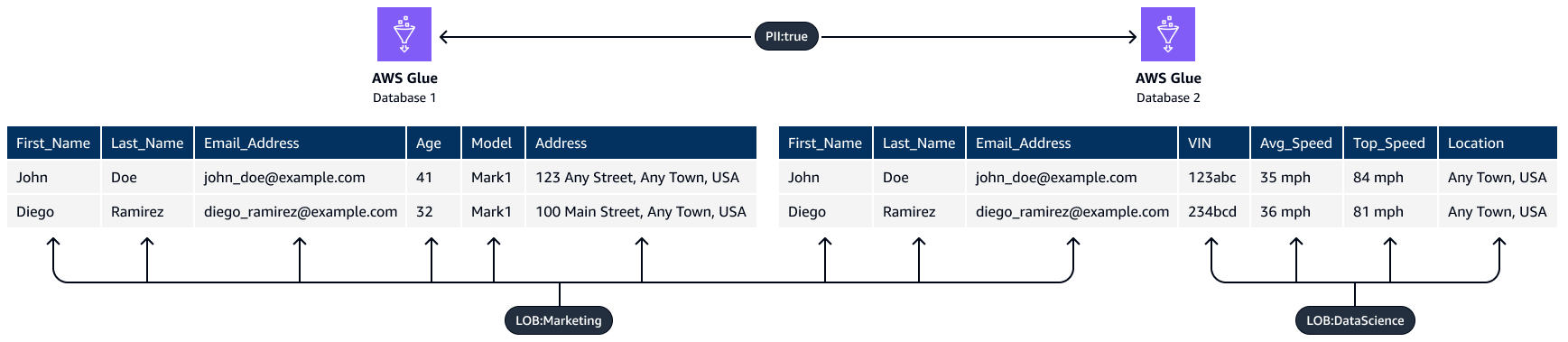

Puoi utilizzare la funzionalità di controllo degli accessi basata su tag in Lake Formation. Il controllo degli accessi basato su tag è una strategia di autorizzazione che definisce le autorizzazioni in base agli attributi. In Lake Formation, questi attributi sono chiamati LF-tag. Utilizzando un tag LF, puoi allegare questi tag a database, tabelle e colonne di Data Catalog e concedere gli stessi tag ai principali IAM. Lake Formation consente operazioni su tali risorse quando al principale è stato concesso l'accesso a un valore di tag che corrisponde al valore del tag della risorsa. L'immagine seguente mostra come assegnare tag LF e autorizzazioni per fornire un accesso differenziato ai dati personali.

Questo esempio utilizza la natura gerarchica dei tag. Entrambi i database contengono informazioni di identificazione personale (PII:true), ma i tag a livello di colonna limitano le colonne specifiche a team diversi. In questo esempio, i dirigenti IAM che dispongono del tag PII:true LF possono accedere alle risorse del AWS Glue database che dispongono di questo tag. I principali con il LOB:DataScience tag LF possono accedere a colonne specifiche che hanno questo tag e i principali con il tag LOB:Marketing LF possono accedere solo alle colonne che hanno questo tag. Il marketing può accedere solo alle informazioni personali pertinenti ai casi d'uso di marketing e il team di data science può accedere solo alle informazioni personali pertinenti ai propri casi d'uso.

Zone locali AWS

Se è necessario rispettare i requisiti di residenza dei dati, è possibile implementare risorse che archiviano ed elaborano i dati personali specificamente Regioni AWS per supportare tali requisiti. È inoltre possibile utilizzare Zone locali AWS, che consente di collocare risorse di elaborazione, archiviazione, database e altre AWS risorse selezionate vicino a grandi centri abitati e industriali. Una zona locale è un'estensione di un paese Regione AWS che si trova in prossimità geografica di una grande area metropolitana. È possibile collocare tipi specifici di risorse all'interno di una zona locale, vicino alla regione a cui corrisponde la zona locale. Le Local Zones possono aiutarti a soddisfare i requisiti di residenza dei dati quando una regione non è disponibile all'interno della stessa giurisdizione legale. Quando utilizzi Local Zones, prendi in considerazione i controlli di residenza dei dati implementati all'interno della tua organizzazione. Ad esempio, potrebbe essere necessario un controllo per impedire il trasferimento di dati da una zona locale specifica a un'altra regione. Per ulteriori informazioni su come utilizzare SCPs i controlli per il trasferimento transfrontaliero dei dati, consulta Best practice per la gestione della residenza dei dati nell'utilizzo dei controlli delle landing Zone locali AWS zone

AWS Enclavi Nitro

Considera la tua strategia di segmentazione dei dati dal punto di vista dell'elaborazione, ad esempio l'elaborazione dei dati personali con un servizio di elaborazione come Amazon Elastic Compute Cloud (Amazon). EC2 L'elaborazione riservata come parte di una strategia di architettura più ampia può aiutarti a isolare l'elaborazione dei dati personali in un'enclave di CPU isolata, protetta e affidabile. Le enclavi sono macchine virtuali separate, rinforzate e altamente vincolate. AWS Nitro Enclaves è una EC2 funzionalità di Amazon che può aiutarti a creare questi ambienti di elaborazione isolati. Per ulteriori informazioni, consulta La progettazione della sicurezza del sistema AWS Nitro (white paper).AWS

Nitro Enclaves distribuisce un kernel separato dal kernel dell'istanza principale. Il kernel dell'istanza principale non ha accesso all'enclave. Gli utenti non possono utilizzare SSH o accedere in remoto ai dati e alle applicazioni nell'enclave. Le applicazioni che elaborano dati personali possono essere incorporate nell'enclave e configurate per utilizzare il Vsock dell'enclave, il socket che facilita la comunicazione tra l'enclave e l'istanza principale.

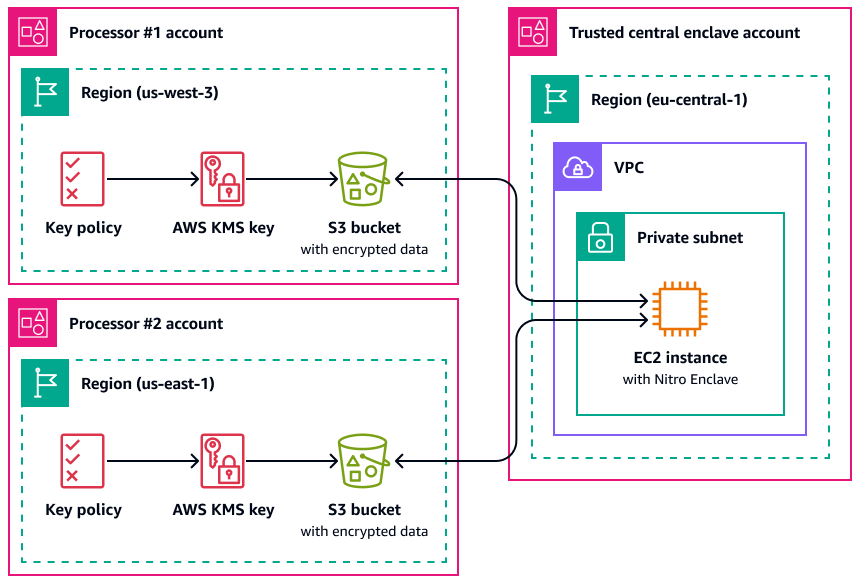

Un caso d'uso in cui Nitro Enclaves può essere utile è l'elaborazione congiunta tra due processori di dati separati e che potrebbero non fidarsi l'uno dell'altro. Regioni AWS L'immagine seguente mostra come utilizzare un'enclave per l'elaborazione centralizzata, una chiave KMS per crittografare i dati personali prima che vengano inviati all'enclave e una AWS KMS key politica che verifica che l'enclave che richiede la decrittografia abbia le misure uniche nel documento di attestazione. Per AWS KMS ulteriori informazioni e istruzioni, consulta Utilizzo dell'attestazione crittografica con. Per un esempio di policy chiave, consulta questa Richiedi l'attestazione per utilizzare una chiave AWS KMS guida.

Con questa implementazione, solo i rispettivi processori di dati e l'enclave sottostante hanno accesso ai dati personali in chiaro. L'unico luogo in cui i dati sono esposti, al di fuori degli ambienti dei rispettivi processori di dati, è nell'enclave stessa, progettata per impedire l'accesso e la manomissione.

AWS PrivateLink

Molte organizzazioni vogliono limitare l'esposizione dei dati personali a reti non affidabili. Ad esempio, se si desidera migliorare la privacy della progettazione complessiva dell'architettura applicativa, è possibile segmentare le reti in base alla sensibilità dei dati (in modo analogo alla separazione logica e fisica dei set di dati descritta nella Servizi AWS e funzionalità che aiutano a segmentare i dati sezione). AWS PrivateLinkti aiuta a creare connessioni private unidirezionali dai tuoi cloud privati virtuali (VPCs) a servizi esterni al VPC. Utilizzando AWS PrivateLink, è possibile configurare connessioni private dedicate ai servizi che archiviano o elaborano dati personali nel proprio ambiente; non è necessario connettersi a endpoint pubblici e trasferire questi dati su reti pubbliche non affidabili. Quando si abilitano gli endpoint di AWS PrivateLink servizio per i servizi inclusi, non è necessario un gateway Internet, un dispositivo NAT, un indirizzo IP pubblico, una connessione o AWS Direct Connect AWS Site-to-Site VPN una connessione per comunicare. Quando si utilizza AWS PrivateLink per connettersi a un servizio che fornisce l'accesso ai dati personali, è possibile utilizzare le policy degli endpoint VPC e i gruppi di sicurezza per controllare l'accesso, in base alla definizione del perimetro dei dati

AWS Resource Access Manager

AWS Resource Access Manager (AWS RAM) ti aiuta a condividere in modo sicuro le tue risorse Account AWS per ridurre il sovraccarico operativo e fornire visibilità e verificabilità. Mentre pianifichi la tua strategia di segmentazione multi-account, valuta la possibilità di AWS RAM condividere gli archivi di dati personali archiviati in un account separato e isolato. Puoi condividere tali dati personali con altri account affidabili ai fini del trattamento. In AWS RAM, puoi gestire le autorizzazioni che definiscono quali azioni possono essere eseguite su risorse condivise. Tutte le chiamate API a AWS RAM sono registrate. CloudTrail Inoltre, puoi configurare Amazon CloudWatch Events in modo che ti invii automaticamente notifiche per eventi specifici in AWS RAM, ad esempio quando vengono apportate modifiche a una condivisione di risorse.

Sebbene sia possibile condividere molti tipi di AWS risorse con altri utenti Account AWS utilizzando policy basate su risorse in IAM o bucket policy in Amazon S3, AWS RAM offre diversi vantaggi aggiuntivi per la privacy. AWS offre ai proprietari dei dati una visibilità aggiuntiva su come e con chi i dati vengono condivisi tra di loro, tra cui: Account AWS

-

Poter condividere una risorsa con un'intera unità organizzativa anziché aggiornare manualmente gli elenchi di account IDs

-

Applicazione della procedura di invito per l'avvio della condivisione se l'account consumatore non fa parte dell'organizzazione

-

Visibilità su quali responsabili IAM specifici hanno accesso a ogni singola risorsa

Se in precedenza hai utilizzato una policy basata sulle risorse per gestire una condivisione di risorse e desideri utilizzarla al suo AWS RAM posto, utilizza l'operazione API. PromoteResourceShareCreatedFromPolicy

Amazon SageMaker AI

Amazon SageMaker AI

Amazon SageMaker Model Monitor

Molte organizzazioni considerano la deriva dei dati durante l'addestramento dei modelli di machine learning. La deriva dei dati è una variazione significativa tra i dati di produzione e i dati utilizzati per addestrare un modello di machine learning o una modifica significativa dei dati di input nel tempo. La deriva dei dati può ridurre la qualità, l'accuratezza e l'equità complessive nelle previsioni dei modelli ML. Se la natura statistica dei dati che un modello di machine learning riceve durante la produzione si discosta dalla natura dei dati di base su cui è stato addestrato, l'accuratezza delle previsioni potrebbe diminuire. Amazon SageMaker Model Monitor può monitorare continuamente la qualità dei modelli di machine learning di Amazon SageMaker AI in produzione e monitorare la qualità dei dati. Il rilevamento precoce e proattivo della deriva dei dati può aiutarti a implementare azioni correttive, come la riqualificazione dei modelli, l'audit dei sistemi a monte o la risoluzione di problemi di qualità dei dati. Model Monitor può ridurre la necessità di monitorare manualmente i modelli o creare strumenti aggiuntivi.

Amazon SageMaker Clarify

Amazon SageMaker Clarify fornisce informazioni sulla distorsione e sulla spiegabilità del modello. SageMaker Clarify è comunemente usato durante la preparazione dei dati del modello ML e la fase di sviluppo complessiva. Gli sviluppatori possono specificare gli attributi di interesse, come il sesso o l'età, e SageMaker Clarify esegue una serie di algoritmi per rilevare qualsiasi presenza di distorsioni in tali attributi. Dopo l'esecuzione dell'algoritmo, SageMaker Clarify fornisce un rapporto visivo con una descrizione delle fonti e delle misurazioni delle possibili distorsioni, in modo da poter identificare i passaggi per rimediare a tali distorsioni. Ad esempio, in un set di dati finanziari che contiene solo pochi esempi di prestiti commerciali concessi a una fascia di età rispetto ad altre, è SageMaker possibile segnalare gli squilibri in modo da evitare un modello che sfavorisce quella fascia di età. È inoltre possibile verificare la presenza di pregiudizi nei modelli già addestrati esaminandone le previsioni e monitorando continuamente l'eventuale presenza di pregiudizi nei modelli di machine learning. Infine, SageMaker Clarify è integrato con Amazon SageMaker AI Experiments per fornire un grafico che spiega quali funzionalità hanno contribuito maggiormente al processo di previsione complessivo di un modello. Queste informazioni potrebbero essere utili per raggiungere i risultati di spiegabilità e potrebbero aiutarti a determinare se un particolare input del modello ha più influenza di quanto dovrebbe sul comportamento generale del modello.

SageMaker Scheda modello Amazon

Amazon SageMaker Model Card può aiutarti a documentare dettagli critici sui tuoi modelli di machine learning per scopi di governance e reporting. Questi dettagli possono includere il proprietario del modello, lo scopo generale, i casi d'uso previsti, le ipotesi formulate, la valutazione del rischio di un modello, i dettagli e le metriche della formazione e i risultati della valutazione. Per ulteriori informazioni, vedere Model Explainability with AWS Artificial Intelligence and Machine Learning Solutions (AWS white paper).

Amazon SageMaker Data Wrangler

Amazon SageMaker Data Wrangler

Data Wrangler può essere utilizzato come parte del processo di preparazione dei dati e progettazione delle funzionalità nel PRA. AWS Supporta la crittografia dei dati inattivi e in transito utilizzando AWS KMS e utilizza ruoli e policy IAM per controllare l'accesso a dati e risorse. Supporta il mascheramento dei dati AWS Glue tramite Amazon SageMaker Feature Store. Se integri Data Wrangler con AWS Lake Formation, puoi applicare controlli e autorizzazioni granulari per l'accesso ai dati. Puoi persino utilizzare Data Wrangler con Amazon Comprehend per redigere automaticamente i dati personali dai dati tabulari come parte del tuo più ampio flusso di lavoro ML Ops. Per ulteriori informazioni, consulta Redazione automatica delle informazioni personali per l'apprendimento automatico con Amazon SageMaker Data Wrangler

La versatilità di Data Wrangler ti aiuta a mascherare i dati sensibili per molti settori, come numeri di conto, numeri di carte di credito, numeri di previdenza sociale, nomi dei pazienti e cartelle cliniche e militari. Puoi limitare l'accesso a qualsiasi dato sensibile o scegliere di oscurarlo.

AWS funzionalità che aiutano a gestire il ciclo di vita dei dati

Quando i dati personali non sono più necessari, puoi utilizzare il ciclo di vita e le time-to-live policy per i dati in molti archivi di dati diversi. Quando configuri le politiche di conservazione dei dati, considera le seguenti posizioni che potrebbero contenere dati personali:

-

Database, come Amazon DynamoDB e Amazon Relational Database Service (Amazon RDS)

-

Bucket Amazon S3

-

Registri da e CloudWatch CloudTrail

-

Dati memorizzati nella cache provenienti da migrazioni in AWS Database Migration Service ()AWS DMS e progetti AWS Glue DataBrew

-

Backup e istantanee

Le seguenti Servizi AWS funzionalità possono aiutarti a configurare le politiche di conservazione dei dati nei tuoi AWS ambienti:

-

Ciclo di vita di Amazon S3: un insieme di regole che definiscono le azioni che Amazon S3 applica a un gruppo di oggetti. Nella configurazione Amazon S3 Lifecyle, puoi creare azioni di scadenza, che definiscono quando Amazon S3 elimina gli oggetti scaduti per tuo conto. Per ulteriori informazioni, consulta Gestione del ciclo di vita dell’archiviazione.

-

Amazon Data Lifecycle Manager: in Amazon EC2, crea una policy che automatizzi la creazione, la conservazione e l'eliminazione di snapshot di Amazon Elastic Block Store (Amazon EBS) e Amazon Machine Images () supportate da EBS. AMIs

-

DynamoDB Time to Live (TTL): definisce un timestamp per elemento che determina quando un elemento non è più necessario. Poco dopo la data e l'ora del timestamp specificato, DynamoDB elimina l'elemento dalla tabella.

-

Impostazioni di conservazione dei log nei CloudWatch log: è possibile regolare la politica di conservazione per ogni gruppo di log su un valore compreso tra 1 giorno e 10 anni.

-

AWS Backup— Implementazione centralizzata di policy di protezione dei dati per configurare, gestire e governare l'attività di backup su una varietà di AWS risorse, tra cui bucket S3, istanze di database RDS, tabelle DynamoDB, volumi EBS e molte altre. Applica le policy di backup alle tue AWS risorse specificando i tipi di risorse o fornisci ulteriore granularità applicando in base ai tag di risorsa esistenti. Verifica e crea report sulle attività di backup da una console centralizzata per contribuire a soddisfare i requisiti di conformità del backup.

Servizi AWS e funzionalità che aiutano a segmentare i dati

La segmentazione dei dati è il processo mediante il quale i dati vengono archiviati in contenitori separati. Questo può aiutarvi a fornire misure di sicurezza e autenticazione differenziate per ogni set di dati e a ridurre l'ambito di impatto dell'esposizione per l'intero set di dati. Ad esempio, anziché archiviare tutti i dati dei clienti in un unico database di grandi dimensioni, è possibile segmentarli in gruppi più piccoli e più gestibili.

Puoi utilizzare la separazione fisica e logica per segmentare i dati personali:

-

Separazione fisica: l'atto di archiviare i dati in archivi di dati separati o di distribuirli in AWS risorse separate. Sebbene i dati siano fisicamente separati, entrambe le risorse potrebbero essere accessibili agli stessi responsabili. Questo è il motivo per cui consigliamo di combinare la separazione fisica con la separazione logica.

-

Separazione logica: l'atto di isolare i dati utilizzando i controlli di accesso. Diverse funzioni lavorative richiedono diversi livelli di accesso a sottoinsiemi di dati personali. Per un esempio di policy che implementa la separazione logica, consulta questa Concedi l'accesso a specifici attributi di Amazon DynamoDB guida.

La combinazione di separazione logica e fisica offre flessibilità, semplicità e granularità nella stesura di politiche basate sull'identità e sulle risorse per supportare l'accesso differenziato tra le funzioni lavorative. Ad esempio, può essere complesso dal punto di vista operativo creare le policy che separano logicamente diverse classificazioni dei dati in un unico bucket S3. L'utilizzo di bucket S3 dedicati per ogni classificazione dei dati semplifica la configurazione e la gestione delle policy.

Servizi AWS e funzionalità che aiutano a scoprire, classificare o catalogare i dati

Alcune organizzazioni non hanno ancora iniziato a utilizzare strumenti di estrazione, caricamento e trasformazione (ELT) nel proprio ambiente per catalogare in modo proattivo i propri dati. Questi clienti potrebbero trovarsi in una fase iniziale di scoperta dei dati, in cui desiderano comprendere meglio i dati che archiviano ed elaborano AWS e come sono strutturati e classificati. Puoi usare Amazon Macie per comprendere meglio i tuoi dati PII in Amazon S3. Tuttavia, Amazon Macie non può aiutarti ad analizzare altre fonti di dati, come Amazon Relational Database Service (Amazon RDS) e Amazon Redshift. È possibile utilizzare due approcci per accelerare la scoperta iniziale all'inizio di un esercizio di mappatura dei dati più ampio:

-

Approccio manuale: crea una tabella con due colonne e tutte le righe di cui hai bisogno. Nella prima colonna, scrivi una caratterizzazione dei dati (ad esempio nome utente, indirizzo o sesso) che potrebbe trovarsi nell'intestazione o nel corpo di un pacchetto di rete o in qualsiasi servizio fornito. Chiedi al tuo team addetto alla conformità di compilare la seconda colonna. Nella seconda colonna, inserisci un «sì» se i dati sono considerati personali e un «no» se non lo sono. Indica qualsiasi tipo di dato personale considerato particolarmente sensibile, ad esempio dati relativi alla confessione religiosa o alla salute.

-

Approccio automatizzato: utilizza gli strumenti forniti da. Marketplace AWS Uno di questi strumenti è Securiti

. Queste soluzioni offrono integrazioni che consentono loro di scansionare e scoprire dati su più tipi di AWS risorse, nonché risorse in altre piattaforme di servizi cloud. Molte di queste stesse soluzioni possono raccogliere e mantenere continuamente un inventario degli asset di dati e delle attività di elaborazione dei dati in un catalogo di dati centralizzato. Se ci si affida a uno strumento per eseguire la classificazione automatizzata, potrebbe essere necessario ottimizzare le regole di scoperta e classificazione per allinearle alla definizione di dati personali dell'organizzazione.