Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Accelera MLOps con Backstage e modelli Amazon SageMaker AI self-service

Ashish Bhatt, Shashank Hirematt e Shivanshu Suryakar, Amazon Web Services

Riepilogo

Organizations che utilizzano sistemi di machine learning operations (MLOps) affrontano sfide significative in termini di scalabilità, standardizzazione e protezione della propria infrastruttura ML. Questo modello introduce un approccio trasformativo che combina Backstage

I moduli IAc per questo pattern sono disponibili nell'archivio dei moduli. GitHub AWS AIOps

Utilizzando Backstage come piattaforma self-service e integrando modelli di intelligenza artificiale preconfigurati, puoi: SageMaker

Accelera il time-to-value delle tue iniziative di machine learning.

Contribuisci a rafforzare la sicurezza e la governance coerenti.

Fornisci ai data scientist ambienti standardizzati e conformi.

Riduci il sovraccarico operativo e la complessità dell'infrastruttura.

Questo modello fornisce una soluzione che affronta le sfide critiche di MLOps e fornisce anche un framework scalabile e ripetibile che consente l'innovazione mantenendo al contempo gli standard organizzativi.

Destinatari

Questo modello è destinato a un vasto pubblico coinvolto nel machine learning, nell'architettura cloud e nell'ingegneria delle piattaforme all'interno di un'organizzazione. Questo include:

Ingegneri ML che desiderano standardizzare e automatizzare le implementazioni dei flussi di lavoro ML.

Scienziati dei dati che desiderano accedere in modalità self-service ad ambienti ML preconfigurati e conformi.

Ingegneri di piattaforma responsabili della creazione e della manutenzione di piattaforme di sviluppo interne e dell'infrastruttura condivisa.

Architetti del cloud che progettano soluzioni cloud scalabili, sicure ed economiche per. MLOps

DevOps ingegneri interessati a estendere le pratiche di integrazione continua e distribuzione continua (CI/CD) al provisioning e ai flussi di lavoro dell'infrastruttura ML.

Responsabili tecnici e manager che supervisionano le iniziative di machine learning e desiderano migliorare la produttività, la governance e il time-to-market dei team.

Per ulteriori informazioni sulle MLOps sfide, sui MLOps moduli di SageMaker intelligenza artificiale e su come la soluzione fornita da questo modello può soddisfare le esigenze dei team di machine learning, consulta la sezione Informazioni aggiuntive.

Prerequisiti e limitazioni

Prerequisiti

AWS Identity and Access Management (IAM) ruoli e autorizzazioni

per il provisioning di risorse nel Account AWS Comprensione dei concetti di Amazon SageMaker Studio, SageMaker Projects, SageMaker Pipelines e SageMaker Model Registry

Comprensione dei principi IaC ed esperienza con strumenti come AWS Cloud Development Kit (AWS CDK)

Limitazioni

Copertura limitata dei modelli. Attualmente, la soluzione supporta solo i AIOps moduli SageMaker relativi all'intelligenza artificiale della soluzione più ampiaAIOps .

Altri moduli, come Ray on Amazon Elastic Kubernetes Service (Amazon EKS), MLflow Apache Airflow e il fine-tuning per Amazon Bedrock, non sono ancora disponibili come modelli di Backstage. Impostazioni predefinite non configurabili. I modelli utilizzano configurazioni predefinite fisse dei AIOps SageMaker moduli senza alcuna personalizzazione. Non è possibile modificare i tipi di istanze, le dimensioni di archiviazione, le configurazioni di rete o le politiche di sicurezza tramite l'interfaccia Backstage, il che limita la flessibilità per casi d'uso specifici.

AWS-solo supporto. La piattaforma è progettata esclusivamente per le AWS implementazioni e non supporta scenari multicloud. Organizations che utilizzano servizi cloud esterni Cloud AWS non possono utilizzare questi modelli per le proprie esigenze di infrastruttura ML.

Gestione manuale delle credenziali. È necessario fornire manualmente le AWS credenziali per ogni distribuzione. Questa soluzione non fornisce l'integrazione con i provider di identità aziendali o la rotazione AWS IAM Identity Center automatica delle credenziali.

Gestione limitata del ciclo di vita. I modelli non dispongono di funzionalità complete per la gestione del ciclo di vita delle risorse, come politiche di pulizia automatizzate, consigli per l'ottimizzazione dei costi e rilevamento delle deviazioni dell'infrastruttura. È necessario gestire e monitorare manualmente le risorse distribuite dopo la creazione.

Architettura

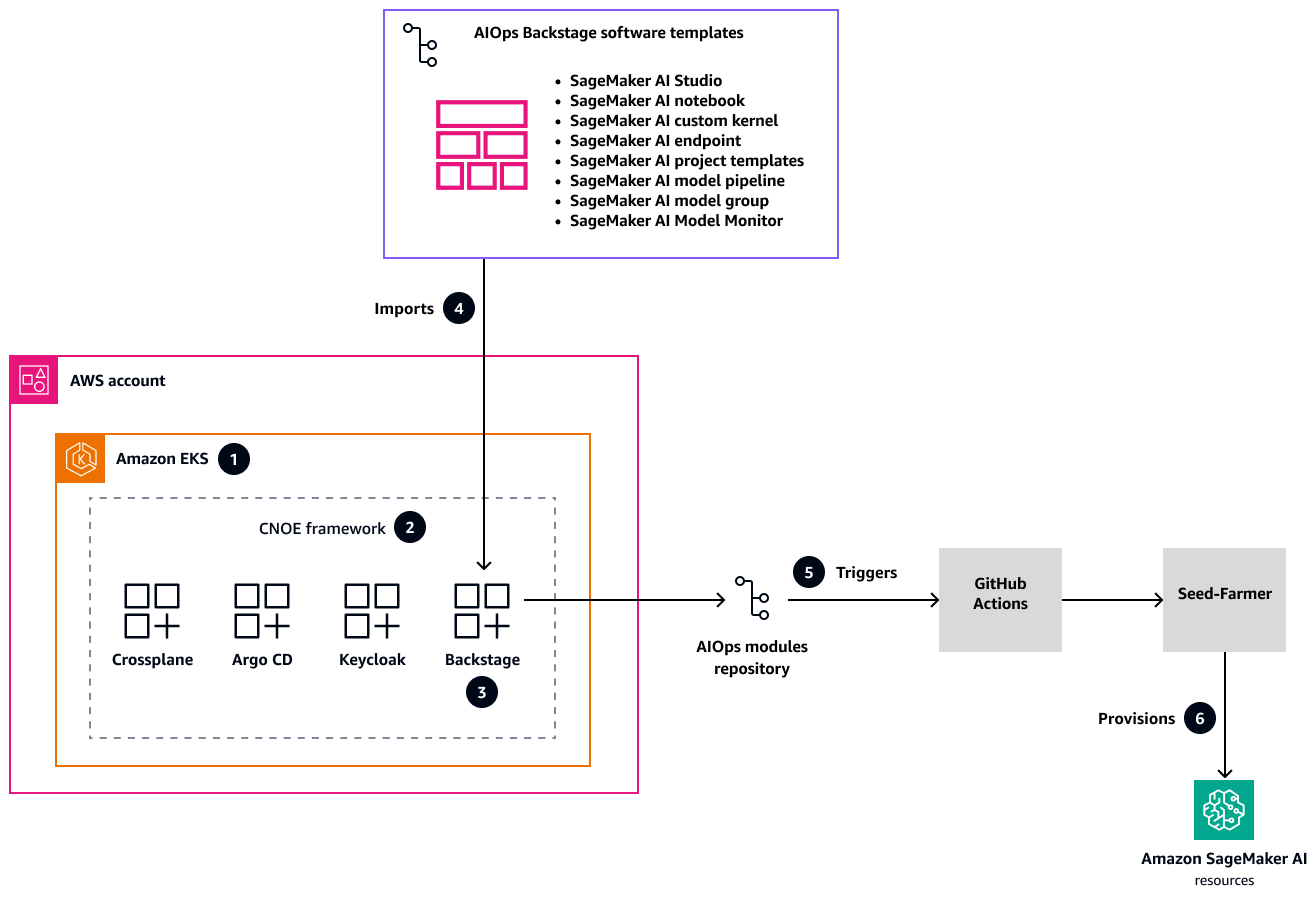

Il diagramma seguente mostra l'architettura della soluzione per un portale per sviluppatori unificato che standardizza e accelera l'implementazione dell'infrastruttura ML con l'intelligenza artificiale in tutti gli ambienti. SageMaker

In questa architettura:

AWS i progetti di modernizzazione delle applicazioni

forniscono la configurazione dell'infrastruttura con un cluster Amazon EKS come base per il framework Cloud Native Operational Excellence (CNOE ). Questa soluzione completa affronta le complesse sfide di gestione dell'infrastruttura nativa del cloud fornendo una piattaforma di sviluppo interna scalabile (IDP). I progetti offrono un approccio strutturato alla configurazione di un'infrastruttura solida e flessibile in grado di adattarsi alle esigenze organizzative in evoluzione. Il framework open source CNOE consolida DevOps gli strumenti e risolve la frammentazione dell'ecosistema attraverso un approccio ingegneristico di piattaforma unificato. Riunendo strumenti e tecnologie diversi, semplifica il complesso panorama dello sviluppo nativo del cloud, in modo che i team possano concentrarsi sull'innovazione anziché sulla gestione della toolchain. Il framework fornisce una metodologia standardizzata per la selezione, l'integrazione e la gestione degli strumenti di sviluppo.

Con CNOE, Backstage viene distribuito come out-of-the-box soluzione all'interno del cluster Amazon EKS. Backstage include una solida autenticazione tramite Keycloak e flussi di lavoro di implementazione completi

tramite Argo CD. Questa piattaforma integrata crea un ambiente centralizzato per la gestione dei processi di sviluppo e fornisce ai team un unico posto per accedere, implementare e monitorare la propria infrastruttura e le proprie applicazioni in più ambienti. Un GitHub repository contiene modelli AIOps software preconfigurati che coprono l'intero ciclo di vita dell'IA. SageMaker Questi modelli soddisfano le esigenze critiche dell'infrastruttura ML, tra cui il provisioning di SageMaker Studio, la formazione dei modelli, le pipeline di inferenza e il monitoraggio dei modelli. Questi modelli ti aiutano ad accelerare le tue iniziative di machine learning e a garantire la coerenza tra diversi progetti e team.

GitHub Actions

implementa un flusso di lavoro automatizzato che attiva dinamicamente l'approvvigionamento delle risorse tramite l'utilità Seed-Farmer. Questo approccio integra il catalogo Backstage con il repository dei AIOps moduli e crea un processo di implementazione dell'infrastruttura semplificato. L'automazione riduce l'intervento manuale, minimizza l'errore umano e garantisce una creazione di infrastrutture rapida e coerente in diversi ambienti. Ti AWS CDKaiuta a definire e fornire l'infrastruttura sotto forma di codice e garantisce l'implementazione ripetibile, sicura e conforme delle risorse su determinate aree. Account AWS Questo approccio offre la massima governance con un intervento manuale minimo, in modo da poter creare modelli di infrastruttura standardizzati che possono essere facilmente replicati, controllati in base alla versione e verificati.

Strumenti

Servizi AWS

AWS Cloud Development Kit (AWS CDK)è un framework di sviluppo software che consente di definire e fornire l'infrastruttura nel codice. Cloud AWS

Amazon Elastic Kubernetes Service (Amazon EKS) ti aiuta a eseguire AWS Kubernetes senza dover installare o gestire il tuo piano di controllo o i tuoi nodi Kubernetes.

Amazon SageMaker AI è un servizio di machine learning gestito che ti aiuta a creare e addestrare modelli di machine learning per poi distribuirli in un ambiente ospitato pronto per la produzione.

Altri strumenti

Backstage

è un framework open source che ti aiuta a creare portali interni per sviluppatori. GitHub Actions

è una CI/CD piattaforma che automatizza i flussi di lavoro di sviluppo software, comprese attività come la creazione, il test e la distribuzione del codice.

Archivi di codice

Questo modello utilizza codice e modelli dai seguenti GitHub repository:

AIOps piattaforma di sviluppo interna (IDP) con

repository Backstage SageMaker Moduli relativi all'intelligenza artificiale dal repository dei moduli AWS AIOps

Ingegneria moderna

sul repository AWS

Implementazione

Questa implementazione utilizza un modello di implementazione di livello di produzione per Backstage tratto dal Modern

La sezione Epics di questo modello delinea l'approccio di implementazione. Per istruzioni dettagliate sull' step-by-stepimplementazione, consulta la guida completa all'implementazione

Implementazione iniziale della piattaforma Backstage

Integrazione di modelli SageMaker software con Backstage

Utilizzo e manutenzione dei modelli di Backstage

La guida all'implementazione include anche indicazioni per la manutenzione continua, la risoluzione dei problemi e la scalabilità della piattaforma.

Best practice

Segui queste best practice per contribuire a garantire la sicurezza, la governance e l'eccellenza operativa nelle implementazioni MLOps dell'infrastruttura.

Gestione dei modelli

Non apportare mai modifiche sostanziali ai modelli attivi.

Verifica sempre accuratamente gli aggiornamenti prima di distribuirli in produzione.

Mantieni versioni dei modelli chiare e ben documentate.

Sicurezza

Associa GitHub le azioni a specifici algoritmi di commit secure hash (SHAs) per aiutare a prevenire gli attacchi alla catena di approvvigionamento.

Utilizza ruoli IAM con privilegi minimi con autorizzazioni granulari.

Archivia le credenziali sensibili in Secrets e. GitHub Gestione dei segreti AWS

Non codificare mai le credenziali nei modelli.

Governance e tracciamento

Implementa standard completi di etichettatura delle risorse.

Abilita il monitoraggio preciso dei costi e la conformità.

Mantieni percorsi di controllo chiari per le modifiche all'infrastruttura.

Questa guida fornisce una solida base per l'implementazione di queste best practice utilizzando i moduli Backstage, SageMaker AI e IaC.

Epiche

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Implementa Backstage. | Questa fase utilizza i progetti del Modern Engineering on AWS L'infrastruttura utilizza Amazon EKS come piattaforma di orchestrazione dei container per la distribuzione di componenti IDP. L'architettura Amazon EKS include configurazioni di rete sicure per stabilire un rigoroso isolamento della rete e controllare i modelli di accesso. La piattaforma si integra con i meccanismi di autenticazione per aiutare a proteggere l'accesso degli utenti a tutti i servizi e gli ambienti. | Ingegnere della piattaforma |

Configura i tuoi modelli di SageMaker intelligenza artificiale. | Questo passaggio utilizza gli script nella piattaforma di sviluppo GitHub AIOps interna (IDP) con repository Backstage Questo processo crea un repository che contiene i modelli di SageMaker intelligenza artificiale necessari per l'integrazione con Backstage. | Ingegnere della piattaforma |

Integra i modelli di SageMaker intelligenza artificiale con Backstage. | Segui le istruzioni nella sezione sull'integrazione dei SageMaker modelli Questo passaggio integra i AIOps moduli (modelli SageMaker AI dell'ultimo passaggio) nella distribuzione Backstage in modo da poter soddisfare in autonomia le esigenze dell'infrastruttura ML. | Ingegnere della piattaforma |

Usa i modelli di SageMaker intelligenza artificiale di Backstage. | Segui le istruzioni nella sezione Utilizzo dei SageMaker modelli Nel portale Backstage, puoi scegliere tra i modelli di SageMaker intelligenza artificiale disponibili, incluse opzioni per ambienti SageMaker Studio, SageMaker notebook, modelli di SageMaker progetto personalizzati e pipeline di distribuzione dei modelli. Dopo aver fornito i parametri di configurazione, la piattaforma crea automaticamente repository dedicati e fornisce risorse tramite Actions e Seed-Farmer. AWS GitHub È possibile monitorare i progressi tramite i registri GitHub delle azioni e il catalogo dei componenti Backstage. | Scienziato dei dati, ingegnere dei dati, sviluppatore |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Aggiorna i modelli di SageMaker intelligenza artificiale. | Per aggiornare un modello di SageMaker intelligenza artificiale in Backstage, segui questi passaggi.

| Ingegnere della piattaforma |

Crea e gestisci più versioni di un modello. | Per modificare o aggiornare rapidamente, potresti voler creare più versioni di un modello di SageMaker intelligenza artificiale.

| Ingegnere della piattaforma |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Espandi la copertura dei modelli oltre l' SageMaker IA. | La soluzione attuale implementa solo modelli relativi all' SageMaker intelligenza artificiale AIOps . È possibile estendere l'ambiente ML aggiungendo AIOps moduli Puoi anche implementare modelli di ereditarietà dei modelli per creare versioni specializzate dei modelli di base. Questa estensibilità consente di gestire diverse AWS risorse e applicazioni oltre all' SageMaker intelligenza artificiale, preservando al contempo l'esperienza semplificata degli sviluppatori e mantenendo gli standard dell'organizzazione. | Ingegnere della piattaforma |

Usa l'iniezione dinamica dei parametri. | I modelli attuali utilizzano configurazioni predefinite senza personalizzazione ed eseguono la CLI Seed-Farmer per distribuire risorse con variabili predefinite. È possibile estendere la configurazione predefinita utilizzando l'iniezione dinamica dei parametri per configurazioni specifiche del modulo. | Ingegnere della piattaforma |

Migliora la sicurezza e la conformità. | Per migliorare la sicurezza nella creazione di risorse AWS, puoi abilitare l'integrazione del controllo degli accessi basato sul ruolo (RBAC) con single sign-on (SSO), SAML, OpenID Connect (OIDC) e policy come applicazione del codice. | Ingegnere della piattaforma |

Aggiungi la pulizia automatica delle risorse. | È possibile abilitare funzionalità per le politiche di pulizia automatizzate e aggiungere anche il rilevamento e la correzione delle deviazioni dell'infrastruttura. | Ingegnere della piattaforma |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Rimuovi l'infrastruttura Backstage e le risorse SageMaker AI. | Quando hai finito di utilizzare l'ambiente ML, segui le istruzioni nella sezione Pulizia e gestione delle risorse | Ingegnere della piattaforma |

Risoluzione dei problemi

| Problema | Soluzione |

|---|---|

AWS CDK errori di bootstrap | Verifica AWS le credenziali e la configurazione della regione. |

Problemi di accesso al cluster Amazon EKS | Controlla la configurazione di kubectl e le autorizzazioni IAM. |

Problemi di connettività con Application Load Balancer | Assicurati che i gruppi di sicurezza consentano il traffico in entrata sulla porta 80/443. |

GitHub problemi di integrazione | Verifica le autorizzazioni dei GitHub token e l'accesso all'organizzazione. |

SageMaker Errori di implementazione dell'IA | Controlla le Servizio AWS quote e le autorizzazioni IAM. |

Risorse correlate

Ingegneria della piattaforma (nella guida AWS Cloud Adoption Framework: Platform perspective)

Modelli di software Backstage (sito

Web Backstage) AIOps repository di moduli

(raccolta di moduli IAc riutilizzabili per ML) AIOps piattaforma di sviluppo interna (IDP

) con repository Backstage Ingegneria moderna

sul repository AWS

Informazioni aggiuntive

Sfide aziendali

Organizations che intraprendono o ampliano le proprie MLOps iniziative spesso incontrano queste sfide aziendali e tecniche:

Ambienti incoerenti. La mancanza di ambienti di sviluppo e implementazione standardizzati rende difficile la collaborazione e aumenta i rischi di implementazione.

Sovraccarico di approvvigionamento manuale. La configurazione manuale di un'infrastruttura ML con SageMaker Studio, bucket Amazon Simple Storage Service (Amazon S3), ruoli IAM CI/CD e pipeline richiede molto tempo ed è soggetta a errori e distoglie i data scientist dal loro compito principale di sviluppo di modelli.

Mancanza di reperibilità e riutilizzo. La mancanza di un catalogo centralizzato rende difficile trovare modelli ML, set di dati e pipeline esistenti. Ciò comporta un lavoro ridondante e la perdita di opportunità di riutilizzo.

Governance e conformità complesse. Garantire che i progetti di machine learning aderiscano alle politiche di sicurezza organizzative, alle normative sulla privacy dei dati e agli standard di conformità come l'Health Insurance Portability and Accountability Act (HIPAA) e il Regolamento generale sulla protezione dei dati (GDPR) può essere difficile senza barriere automatizzate.

Tempi di valorizzazione lenti. L'effetto cumulativo di queste sfide si traduce in un prolungamento dei cicli di vita dei progetti di machine learning e ritarda la realizzazione del valore aziendale derivante dagli investimenti in machine learning.

Rischi per la sicurezza. Configurazioni incoerenti e processi manuali possono introdurre vulnerabilità di sicurezza che rendono difficile l'applicazione dei privilegi minimi e l'isolamento della rete.

Questi problemi prolungano i cicli di sviluppo, aumentano il sovraccarico operativo e introducono rischi per la sicurezza. La natura iterativa del machine learning richiede flussi di lavoro ripetibili e una collaborazione efficiente.

Gartner prevede che entro il 2026, l'80% delle organizzazioni di ingegneria del software disporrà di team di piattaforma. (Vedi Platform Engineering consente agli sviluppatori di essere migliori, più veloci e più felici sul sito Web di Gartner

MLOps SageMaker moduli

I AIOps moduli

L'utilizzo diretto AIOps dei moduli spesso richiede ai team della piattaforma di implementare e gestire questi modelli IaC, il che può rappresentare una sfida per i data scientist che desiderano un accesso self-service. La scoperta e la comprensione dei modelli disponibili, la configurazione dei parametri necessari e l'attivazione della loro implementazione potrebbero richiedere l'utilizzo di Servizio AWS console di navigazione o l'interazione diretta con gli strumenti IaC. Ciò può creare attriti, aumentare il carico cognitivo per i data scientist che preferiscono concentrarsi sulle attività di machine learning e potenzialmente portare a parametrizzazioni incoerenti o deviazioni dagli standard organizzativi se questi modelli non sono gestiti tramite un'interfaccia centralizzata e intuitiva. L'integrazione di questi potenti AIOps moduli con un IDP come Backstage aiuta ad affrontare queste sfide fornendo un'esperienza self-service semplificata, una maggiore reperibilità e controlli di governance più solidi per l'utilizzo di questi elementi costitutivi standardizzati. MLOps

Backstage come IDP

Una piattaforma di sviluppo interna (IDP) è un livello self-service creato dai team di piattaforma per semplificare e standardizzare il modo in cui gli sviluppatori creano, distribuiscono e gestiscono le applicazioni. Riduce la complessità dell'infrastruttura e offre agli sviluppatori un facile accesso a strumenti, ambienti e servizi tramite un'interfaccia unificata.

L'obiettivo principale di un IDP è migliorare l'esperienza e la produttività degli sviluppatori mediante:

Abilitare il self-service per attività come la creazione e l'implementazione di servizi.

Promuovere la coerenza e la conformità tramite modelli standard.

Integrazione degli strumenti durante l'intero ciclo di vita dello sviluppo (CI/CD, monitoraggio e documentazione).

Backstage è un portale per sviluppatori open source creato da Spotify e ora parte della Cloud Native Computing Foundation (CNCF). Aiuta le organizzazioni a creare il proprio IDP fornendo una piattaforma centralizzata ed estensibile per gestire componenti software, strumenti e documentazione. Con Backstage, gli sviluppatori possono:

Scopri e gestisci tutti i servizi interni tramite un catalogo software.

Crea nuovi progetti utilizzando modelli predefiniti tramite il plug-in scaffolder.

Accedi a strumenti integrati come CI/CD pipeline, dashboard Kubernetes e sistemi di monitoraggio da un'unica posizione.

Mantieni una documentazione coerente e basata su markdown tramite. TechDocs

DOMANDE FREQUENTI

Qual è la differenza tra l'utilizzo di questo modello di Backstage e la distribuzione manuale di SageMaker Studio tramite la console? SageMaker

Il modello Backstage offre diversi vantaggi rispetto all'implementazione manuale della AWS console, tra cui configurazioni standardizzate che seguono le migliori pratiche organizzative, l'implementazione automatizzata di IaC tramite Seed-Farmer e le politiche di sicurezza e misure di conformità integrate e l' AWS CDK integrazione con i flussi di lavoro degli sviluppatori dell'organizzazione. GitHub Il modello crea anche implementazioni riproducibili con controllo delle versioni, che semplificano la replica degli ambienti nelle diverse fasi (sviluppo, gestione temporanea, produzione) e mantengono la coerenza tra i team. Inoltre, il modello include funzionalità di pulizia automatizzate e si integra con il sistema di gestione delle identità dell'organizzazione tramite Backstage. L'implementazione manuale tramite la console richiede AWS competenze approfondite e non fornisce il controllo della versione o lo stesso livello di standardizzazione e governance offerto dal modello. Per questi motivi, le implementazioni su console sono più adatte per esperimenti una tantum rispetto agli ambienti ML di produzione.

Cos'è Seed-Farmer e perché questa soluzione lo utilizza?

Seed-Farmer è uno strumento di orchestrazione AWS dell'implementazione che gestisce i moduli dell'infrastruttura utilizzando il. AWS CDK Questo modello utilizza Seed-Farmer perché fornisce componenti di infrastruttura standardizzati e riutilizzabili progettati specificamente per i AI/ML carichi di lavoro, gestisce automaticamente dipendenze complesse tra loro e garantisce implementazioni coerenti in diversi ambienti. Servizi AWS

Devo installare il per utilizzare questi modelli? AWS CLI

No, non è necessario installarli AWS CLI sul computer. I modelli funzionano interamente tramite GitHub Actions nel cloud. Fornisci AWS le tue credenziali (chiave di accesso, chiave segreta e token di sessione) tramite l'interfaccia Backstage e la distribuzione avviene automaticamente nell'ambiente GitHub Actions.

Quanto tempo è necessario per implementare un SageMaker ambiente Studio?

Il completamento di una tipica implementazione di SageMaker Studio richiede 15-25 minuti. Ciò include il AWS CDK bootstrap (2-3 minuti), la configurazione della toolchain Seed-Farmer (3-5 minuti) e la creazione di risorse (10-15 minuti). L'ora esatta dipende dalla vostra configurazione Regione AWS e dalla complessità della vostra configurazione di rete.

Posso implementare più SageMaker ambienti nello stesso Account AWS ambiente?

Sì, è possibile. Ogni distribuzione crea risorse con nomi univoci in base al nome del componente fornito nel modello. Tuttavia, fai attenzione alle Servizio AWS quote: ogni account può avere un numero limitato di SageMaker domini per regione, quindi controlla le quote prima di creare più ambienti.