Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Caching dei prompt per un’inferenza del modello più rapida

Il caching dei prompt è una funzionalità facoltativa che si può utilizzare con i modelli supportati in Amazon Bedrock per ridurre la latenza di risposta all’inferenza e i costi dei token di input. Aggiungendo parti del contesto a una cache, il modello può sfruttarla per evitare il ricalcolo degli input, permettendo a Bedrock di condividere i risparmi in termini di calcolo e di ridurre le latenze di risposta.

Il caching dei prompt può essere utile quando sono presenti carichi di lavoro con contesti lunghi e ripetuti spesso riutilizzati per più query. Ad esempio, se si dispone di un chatbot in cui gli utenti possono caricare documenti e successivamente porre domande sui documenti stessi, il modello può richiedere molto tempo per elaborare il documento ogni volta che l’utente fornisce un input. Con il caching dei prompt, è possibile memorizzare nella cache il documento in modo che le future query contenenti il documento non debbano elaborarlo nuovamente.

Quando si utilizza il caching dei prompt, viene addebitata una tariffa ridotta per i token letti dalla cache. In base al modello, i token scritti nella cache possono essere addebitati a una tariffa superiore a quella dei token di input non memorizzati nella cache. Tutti i token non letti da o scritti nella cache vengono addebitati alla tariffa standard dei token di input per il modello specifico. Per ulteriori informazioni, consulta la pagina Prezzi di Amazon Bedrock

Come funziona

Se si sceglie di utilizzare il caching dei prompt, Amazon Bedrock creare una cache composta di punti di controllo della cache. Si tratta di indicatori che definiscono la sottosezione contigua del prompt da memorizzare nella cache (spesso denominata prefisso del prompt). Tali prefissi devono essere statici tra le richieste e le modifiche al prefisso del prompt nelle richieste successive comportano errori nella cache.

I punti di controllo della cache hanno un numero minimo e massimo di token, in base al modello specifico in uso. Si può creare un punto di controllo della cache solo se il prefisso totale del prompt soddisfa il numero minimo di token. Ad esempio, il modello Anthropic Claude 3.7 Sonnet richiede almeno 1.024 token per punto di controllo della cache. Ciò significa che il primo punto di controllo della cache può essere definito dopo 1.024 token, mentre il secondo può essere definito dopo 2.048 token. Se si prova ad aggiungere un punto di controllo della cache prima di raggiungere il numero minimo di token, l’inferenza ha comunque esito positivo, ma il prefisso non viene memorizzato nella cache. La cache ha un Time To Live (TTL), che si ripristina a ogni accesso riuscito alla cache. Durante questo periodo, il contesto nella cache viene mantenuto. Se non si verificano accessi alla cache nell’intervallo TTL, la cache scade. La maggior parte dei modelli supporta un TTL di 5 minuti, mentre il formato Claude Opus 4.5Claude Haiku 4.5, e supporta Claude Sonnet 4.5 anche un'opzione TTL estesa di 1 ora.

È possibile utilizzare il caching dei prompt ogni volta che si ottiene l’inferenza del modello in Amazon Bedrock per i modelli supportati. Il caching dei prompt è supportato dalle seguenti funzionalità di Amazon Bedrock:

- Converse e ConverseStream APIs

-

È possibile continuare una conversazione con un modello in cui si specificano i punti di controllo della cache nei prompt.

- InvokeModel e InvokeModelWithResponseStream APIs

-

È possibile inviare richieste di prompt singole in cui si può abilitare il caching dei prompt e specificare i punti di controllo della cache.

- Caching dei prompt con inferenza tra Regioni

-

Il caching dei prompt può essere utilizzato con l’inferenza tra Regioni. L'inferenza interregionale seleziona automaticamente la AWS regione ottimale all'interno dell'area geografica per soddisfare la richiesta di inferenza, massimizzando così le risorse disponibili e la disponibilità del modello. Nei momenti di maggiore richiesta, tali ottimizzazioni possono comportare un aumento delle scritture nella cache.

- Gestione prompt di Amazon Bedrock

-

Quando si crea o si modifica un prompt, è possibile scegliere di abilitare il caching dei prompt. In base al modello, è possibile memorizzare nella cache i prompt e le istruzioni di sistema e i messaggi (di utente e assistente). È inoltre possibile scegliere di disattivare il caching dei prompt.

APIs Forniscono la massima flessibilità e il controllo granulare sulla cache dei prompt. È possibile impostare un punto di controllo della cache individuale all’interno dei prompt nonché aggiungere punti di controllo alla cache creandone altri, fino al numero massimo di punti di controllo consentito per il modello specifico. Per ulteriori informazioni, consulta Modelli supportati, Regioni e limiti.

Modelli supportati, Regioni e limiti

Nella tabella seguente sono elencati i modelli supportati, i token minimi e il numero massimo di punti di controllo della cache relativi e i campi che consentono questi ultimi.

| Nome modello | ID modello | Tipi di rilascio | Numero minimo di token per punto di controllo della cache | Numero massimo di punti di controllo della cache per richiesta | TTL supportato | Campi che accettano punti di controllo per il caching dei prompt |

|---|---|---|---|---|---|---|

Claude Opus4.5 |

anthropic.claude-opus-4-5-20251101-v 1:0 |

Disponibilità generale |

4,096 |

4 |

5 minuti, 1 ora |

`system`, `messages` e `tools` |

Claude Opus4.1 |

anthropic.claude-opus-4-1-20250805-v1:0 |

Disponibilità generale |

1,024 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Claude Opus 4 |

anthropic.claude-opus-4-20250514-v1:0 |

Disponibilità generale |

1,024 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Claude Sonnet 4.5 |

anthropic.claude-sonnet-4-5-20250929-v1:0 |

Disponibilità generale |

1,024 |

4 |

5 minuti, 1 ora |

`system`, `messages` e `tools` |

Claude Haiku 4.5 |

anthropic.claude-haiku-4-5-20251001-v1:0 |

Disponibilità generale |

4,096 |

4 |

5 minuti, 1 ora |

`system`, `messages` e `tools` |

Claude Sonnet 4 |

anthropic.claude-sonnet-4-20250514-v1:0 |

Disponibilità generale |

1,024 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Claude 3.7 Sonnet |

anthropic.claude-3-7-sonnet-20250219-v1:0 |

Disponibilità generale |

1,024 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Claude 3.5 Haiku |

anthropic.claude-3-5-haiku-20241022-v1:0 |

Disponibilità generale |

2.048 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Claude 3.5 Sonnet v2 |

anthropic.claude-3-5-sonnet-20241022-v2:0 |

Anteprima |

1,024 |

4 |

5 minuti |

`system`, `messages` e `tools` |

Amazon Nova Micro |

Amazon. nova-micro-v1:0 |

Disponibilità generale |

1.0001 |

4 |

5 minuti |

`system` e `messages` |

Amazon Nova Lite |

amazzone. nova-lite-v1:0 |

Disponibilità generale |

1.0001 |

4 |

5 minuti |

`system` e `messages`2 |

Amazon Nova Pro |

amazzone. nova-pro-v1:0 |

Disponibilità generale |

1.0001 |

4 |

5 minuti |

`system` e `messages`2 |

Amazon Nova Premier |

amazzone. nova-premier-v1:0 |

Disponibilità generale |

1.0001 |

4 |

5 minuti |

`system` e `messages`2 |

Amazon Nova 2 Lite |

amazon.nova-2-lite-v1:0 |

Disponibilità generale |

1.0001 |

4 |

5 minuti |

`system` e `messages`2 |

1: i modelli Amazon Nova supportano un numero massimo di 20.000 token per il caching dei prompt.

2: il caching dei prompt è principalmente destinato ai prompt di testo.

Per utilizzare l'opzione TTL di 1 ora con i modelli supportati (Claude Opus4.5, e)Claude Haiku 4.5, specifica il campo nel checkpoint della cache. Claude Sonnet 4.5 ttl Nell'API Converse, aggiungi "ttl": "1h" al tuo oggetto. cachePoint Nell' InvokeModel API per i modelli Claude, aggiungi "ttl": "1h" al tuo cache_control oggetto. Se non viene fornito alcun ttl valore, si applica il comportamento predefinito di memorizzazione nella cache di 5 minuti. Il TTL di 1 ora è utile per sessioni di lunga durata o scenari di elaborazione in batch in cui si desidera mantenere la cache per periodi prolungati.

In Amazon Nova è disponibile il caching dei prompt automatico per tutti prompt di testo, inclusi i messaggi User e System. Questo meccanismo può offrire vantaggi in termini di latenza quando i prompt iniziano con parti ripetitive, anche senza una configurazione esplicita. Per ottenere risparmi sui costi e garantire vantaggi più costanti in termini di prestazioni, si consiglia di scegliere Caching dei prompt esplicito.

Gestione semplificata della cache per i modelli Claude

Per i modelli Claude, Amazon Bedrock offre un approccio semplificato alla gestione della cache che riduce la complessità del posizionamento manuale dei punti di controllo della cache. Anziché richiedere di specificare le posizioni esatte dei punti di controllo della cache, è possibile utilizzare la gestione automatica della cache con un singolo punto di interruzione al termine del contenuto statico.

Quando si abilita la gestione semplificata della cache, il sistema verifica automaticamente gli accessi alla cache in base ai limiti dei blocchi di contenuto precedenti, analizzando fino a circa 20 blocchi di contenuto dal punto di interruzione specificato. Ciò consente al modello di trovare il prefisso corrispondente più lungo nella cache senza la necessità di prevedere le posizioni ottimali dei punti di controllo. A tale scopo, posizionare un singolo punto di controllo della cache al termine del contenuto statico, prima di qualsiasi contenuto dinamico o variabile. Il sistema trova automaticamente la migliore corrispondenza nella cache.

Per un controllo più granulare, è comunque possibile utilizzare più punti di controllo della cache (fino a 4 per i modelli Claude) per specificare i limiti esatti della cache. È necessario utilizzare più punti di controllo della se si memorizzano nella cache sezioni che cambiano con frequenze diverse o se si desidera un maggiore controllo su ciò che viene esattamente memorizzato nella cache.

Importante

Il controllo automatico del prefisso analizza solo circa 20 blocchi di contenuto dal punto di controllo della cache. Se il contenuto statico si estende oltre questo intervallo, prendere in considerazione l’utilizzo di più punti di controllo della cache o la nuova creazione di del prompt per inserire i contenuti riutilizzati più frequentemente all’interno dell’intervallo.

Come utilizzare efficacemente il prompt caching

Se hai prompt che vengono utilizzati a cadenza regolare (ad esempio, prompt di sistema che vengono utilizzati più frequentemente di ogni 5 minuti), continua a utilizzare la cache da 5 minuti, poiché questa continuerà ad essere aggiornata senza costi aggiuntivi.

La cache da 1 ora viene utilizzata al meglio nei seguenti scenari:

-

Quando vengono visualizzati prompt che probabilmente vengono utilizzati meno frequentemente di 5 minuti, ma più frequentemente di ogni ora. Ad esempio, quando un agente secondario agentico impiega più di 5 minuti o quando memorizza una lunga conversazione in chat con un utente e generalmente ti aspetti che quell'utente non risponda nei prossimi 5 minuti.

-

Quando la latenza è importante e le richieste di follow-up possono essere inviate per più di 5 minuti.

-

Quando si desidera migliorare l'utilizzo del limite di frequenza, poiché gli accessi alla cache non vengono detratti dal limite di frequenza.

È possibile utilizzare i controlli della cache da 1 ora e da 5 minuti nella stessa richiesta, ma con un vincolo importante: le voci della cache con TTL più lungo devono apparire prima delle voci di cache più corte TTLs (ad esempio, una voce della cache di 1 ora deve apparire prima di qualsiasi voce della cache di 5 minuti).

Nozioni di base

Le sezioni seguenti mostrano una breve panoramica su come utilizzare la funzionalità di caching dei prompt per ogni metodo di interazione con i modelli tramite Amazon Bedrock.

L’API Converse offre opzioni avanzate e flessibili per implementare il caching dei prompt conversazioni a più turni. Per ulteriori informazioni sui requisiti dei prompt per ogni modello, consulta la sezione Modelli supportati, Regioni e limiti precedente.

Richiesta di esempio

Gli esempi seguenti mostrano un punto di controllo della cache impostato nel campo messages, system o tools di una richiesta all’API Converse. È possibile posizionare punti di controllo in una qualsiasi di queste posizioni per una determinata richiesta. Ad esempio, se si invia una richiesta al modello Claude 3.5 Sonnet v2, è possibile inserire due punti di controllo della cache inmessages, uno in system e uno in tools. Per ulteriori informazioni e per esempi di strutturazione e invio di richieste API Converse, consulta Avvio di una conversazione con le operazioni dell’API Converse.

Specificate il valore ttl desiderato come di seguito, quando il valore ttl non è specificato, si applica il comportamento predefinito di 5 minuti di memorizzazione nella cache.

"cachePoint" : { "type": "default", "ttl" : "5m | 1h" }

Il modello di risposta dell'ConverseAPI include tre nuovi campi specifici per il prompt caching. I valori CacheReadInputTokens e CacheWriteInputTokens indicano quanti token sono stati letti e scritti dalla e nella cache a causa della richiesta precedente. I CacheDetails valori indicano il ttl usato per il numero di token scritti nella cache. Si tratta dei valori che vengono addebitati da Amazon Bedrock, a una tariffa inferiore al costo dell’inferenza del modello completa.

Il prompt caching è abilitato per impostazione predefinita quando si chiama l'InvokeModelAPI. È possibile impostare i punti di controllo della cache in qualsiasi punto del corpo della richiesta, in modo analogo all’esempio precedente per l’API Converse.

Per ulteriori informazioni sull'invio di una InvokeModel richiesta, vedereInvia una sola richiesta con InvokeModel.

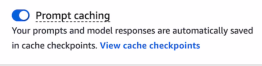

In un playground di chat nella console Amazon Bedrock, è possibile attivare l’opzione di caching dei prompt in modo che Amazon Bedrock crei automaticamente i punti di controllo della cache.

Per iniziare a utilizzare prompt in un playground Amazon Bedrock, segui le istruzioni presenti in Generare risposte nella console utilizzando i playground. Per i modelli supportati, il caching dei prompt viene attivato automaticamente nel playground. In caso contrario, segui questa procedura per attivare il caching dei prompt:

-

Nel pannello laterale sinistro, apri il menu Configurazioni.

-

Attiva l’interruttore Caching dei prompt.

-

Esegui i prompt.

Dopo che le risposte combinate di input e del modello hanno raggiunto il numero minimo richiesto di token per un punto di controllo (che varia in base al modello), Amazon Bedrock crea automaticamente il primo punto di controllo della cache. Man mano che continui a chattare, ogni volta che si raggiunge il numero minimo di token viene creato un nuovo punto di controllo, fino al numero massimo di punti di controllo consentito per il modello. Per visualizzare i punti di controllo della cache, in qualsiasi momento seleziona Visualizza i punti di controllo della cache accanto all’interruttore Caching dei prompt, come mostrato nella schermata seguente.

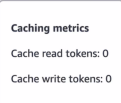

Per visualizzare il numero di token letti e scritti dalla e nella cache a causa di ogni interazione con il modello, apri la finestra popup Parametri di caching (

![]() ) nelle risposte del playground.

) nelle risposte del playground.

Se disattivi l’interruttore di caching dei prompt durante una conversazione, puoi continuare a chattare con il modello.