Inizia a usare Apache Spark su Amazon Athena

Per iniziare a utilizzare Apache Spark su Amazon Athena, devi prima di tutto creare un gruppo di lavoro abilitato a Spark. Dopo il passaggio al gruppo di lavoro, è possibile creare un notebook o aprirne uno esistente. Quando apri un notebook in Athena, viene avviata automaticamente una nuova sessione ed è possibile utilizzare il notebook direttamente nell'editor notebook Athena.

Nota

Assicurati di creare un gruppo di lavoro abilitato a Spark prima di tentare di creare un notebook.

Passaggio 1: creare un gruppo di lavoro abilitato a Spark in Athena

Puoi utilizzare i gruppi di lavoro in Athena per raggruppare utenti, team, applicazioni o carichi di lavoro e per tenere traccia dei costi. Per utilizzare Apache Spark in Amazon Athena, crei un gruppo di lavoro Amazon Athena che utilizza un motore Spark.

Nota

I gruppi di lavoro compatibili con Apache Spark possono utilizzare l'editor di notebook Athena, ma non l'editor di query Athena. Solo i gruppi di lavoro Athena SQL possono utilizzare l'editor di query Athena.

Creazione di un gruppo di lavoro abilitato a Spark in Athena

-

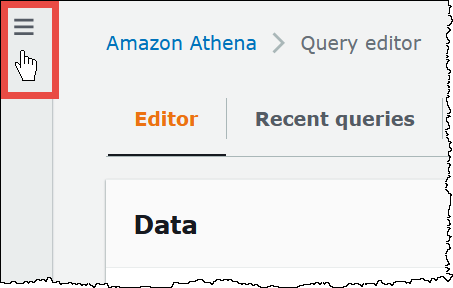

Apri la console Athena all'indirizzo https://console.aws.amazon.com/athena/

. Se il pannello di navigazione della console non è visibile, scegli il menu di espansione a sinistra.

-

Nel pannello di navigazione, seleziona Workgroups (Gruppi di lavoro).

-

Nella pagina Gruppi di lavoro scegli Crea gruppo di lavoro.

-

In Workgroup name (Nome del gruppo di lavoro), inserisci un nome per il tuo gruppo di lavoro Apache Spark.

-

(Facoltativo) Per Description (Descrizione), inserisci una descrizione per il livello.

-

In Analytics engine (Motore di analisi), scegli Apache Spark.

Nota

Dopo avere creato un gruppo di lavoro, il tipo di motore di analisi del gruppo di lavoro non può essere modificato. Ad esempio, un gruppo di lavoro con versione 3 del motore Athena non può essere modificato in un gruppo di lavoro con versione 3 del motore PySpark.

-

Ai fini di questo tutorial, seleziona Turn on example notebook (Attiva il notebook di esempio). Questa funzionalità opzionale aggiunge un notebook di esempio denominato

example-notebook-al gruppo di lavoro e aggiunge le autorizzazioni relative a AWS Glue che il notebook utilizza per creare, mostrare ed eliminare database e tabelle specifici nel tuo account e le autorizzazioni di lettura in Amazon S3 per il set di dati di esempio. Per visualizzare le autorizzazioni aggiunte, scegli View additional permissions details (Visualizza dettagli aggiuntivi sulle autorizzazioni).random_stringNota

L'esecuzione del notebook di esempio potrebbe comportare dei costi aggiuntivi.

-

Perle impostazioni dei risultati di calcolo, scegliere una delle seguenti opzioni:

-

Create a new S3 bucket (Crea un nuovo bucket S3): questa opzione crea un bucket Amazon S3 nel tuo account per i risultati dei calcoli. Il nome del bucket ha il formato

account_id-region-athena-results-bucket-alphanumeric_id -

Choose an existing S3 location (Scegli una posizione S3 esistente): per questa opzione, procedi come segue:

-

Inserisci il percorso S3 di una posizione esistente nella casella di ricerca o scegli Browse S3 (Sfoglia S3) per selezionare un bucket da un elenco.

Nota

Quando selezioni una posizione esistente in Amazon S3, non aggiungere una barra (

/) alla posizione. In questo modo, il collegamento alla posizione dei risultati del calcolo nella pagina dei dettagli del calcolo punta alla directory errata. In tal caso, modifica la posizione dei risultati del gruppo di lavoro rimuovendo la barra finale. -

(Facoltativo) Scegli View (Visualizza) per aprire la pagina Buckets (Bucket) della console Amazon S3, dove puoi trovare ulteriori informazioni sul bucket esistente che hai scelto.

-

(Facoltativo) Per Expected bucket owner (Proprietario del bucket previsto), inserisci l'ID dell'account AWS che ti aspetti che sia il proprietario del bucket della posizione di output dei risultati della query. Ti consigliamo di scegliere questa opzione come ulteriore misura di sicurezza. Se l'ID account del proprietario del bucket non corrisponde all'ID specificato, i tentativi di output nel bucket avranno esito negativo. Per informazioni dettagliate, consulta Verifica della proprietà del bucket con condizione del proprietario del bucket nella Guida per l'utente di Amazon S3.

-

(Facoltativo) Seleziona Assign bucket owner full control over query results (Assegna al proprietario del bucket il controllo completo dei risultati delle query) se la posizione dei risultati dei calcoli è di proprietà di un altro account e desideri concedere a tale altro account il controllo completo dei risultati delle tue query.

-

-

-

(Facoltativo) Scegliere Encrypt query results se si desidera crittografare i risultati delle query.

-

In Encryption type, scegliere una delle seguenti opzioni:

-

SSE_S3: questa opzione utilizza la crittografia lato server (SSE) con chiavi crittografia gestite da Amazon S3.

-

SSE_KMS: questa opzione utilizza la crittografia lato server (SSE) con chiavi gestite AWS KMS.

Alla voce Choose an AWS KMS key, è possibile selezionare una delle seguenti opzioni.

-

Use AWS owned key: la chiave AWS KMS è di proprietà di e gestita da AWS. Non ti viene addebitato alcun costo aggiuntivo per l'utilizzo di questa chiave.

-

Choose a different AWS KMS key (advanced): per questa opzione, eseguire una delle seguenti operazioni:

-

Per utilizzare una chiave esistente, utilizza la casella di ricerca per scegliere una chiave AWS KMS o inserisci l'ARN di una chiave.

-

Per creare una chiave nella console AWS KMS, seleziona Crea una chiave AWS KMS. Il ruolo di esecuzione deve disporre dell'autorizzazione a utilizzare la chiave che crei. Dopo avere completato la creazione della chiave nella console KMS, torna alla pagina Crea gruppo di lavoro nella console Athena, quindi utilizza la casella di ricerca Scegli una chiave AWS KMS o inserisci un ARN per scegliere la chiave appena creata.

-

-

Importante

Quando modifichi la AWS KMS key per un gruppo di lavoro, i notebook gestiti prima dell'aggiornamento continuano a fare riferimento alla vecchia chiave KMS. I notebook gestiti dopo l'aggiornamento utilizzano la nuova chiave KMS. Per aggiornare i vecchi notebook in modo che facciano riferimento alla nuova chiave KMS, esporta e quindi importa ciascuno dei vecchi notebook. Se elimini la vecchia chiave KMS prima di aggiornare i riferimenti dei vecchi notebook alla nuova chiave KMS, i vecchi notebook non saranno più decifrabili e non potranno essere recuperati.

Questo comportamento si applica anche agli aggiornamenti degli alias, che sono nomi semplici per le chiavi KMS. Quando si aggiorna un alias di chiave KMS in modo che punti a una nuova chiave KMS, i notebook gestiti prima dell'aggiornamento dell'alias fanno ancora riferimento alla vecchia chiave KMS, mentre i notebook gestiti dopo l'aggiornamento dell'alias utilizzano la nuova chiave KMS. Tieni a mente questi aspetti prima di aggiornare le chiavi o gli alias KMS.

-

-

-

Per Additional configurations, scegliere Use defaults. Questa opzione aiuta a iniziare a utilizzare il proprio gruppo di lavoro abilitato per Spark. Quando si utilizzano i predefiniti, Athena crea per tuo conto un ruolo IAM e una posizione dei risultati di calcolo in Amazon S3. Il nome del ruolo IAM e la posizione del bucket S3 da creare sono visualizzati nella casella sotto l'intestazione Additional configurations (Configurazioni aggiuntive).

Se non si vogliono utilizzare i valori predefiniti, continuare con i passaggi nella sezione (Facoltativo) Definire configurazioni personalizzate per il gruppo di lavoro per configurare manualmente il gruppo di lavoro.

-

(Facoltativo) Tags (Tag): utilizza questa opzione per aggiungere tag al gruppo di lavoro. Per ulteriori informazioni, consulta Assegnare tag alle risorse di Athena.

-

Selezionare Create workgroup (Crea gruppo di lavoro). Un messaggio informa che il gruppo di lavoro è stato creato correttamente e il gruppo di lavoro viene visualizzato nell'elenco dei gruppi di lavoro.

(Facoltativo) Definire configurazioni personalizzate per il gruppo di lavoro

Se desideri specificare un ruolo IAM e una posizione dei risultati del calcolo personalizzati per il notebook, segui i passaggi illustrati in questa sezione. Se hai scelto Use defaults (Utilizza valori predefiniti) per l'opzione Additional configurations (Configurazioni aggiuntive), salta questa sezione e vai direttamente alla sezione Passaggio 2: aprire Notebook explorer e cambio del gruppo di lavoro .

La procedura seguente presuppone che siano stati completati i passaggi da 1 a 9 della procedura Creazione di un gruppo di lavoro abilitato a Spark in Athena della sezione precedente.

Definizione di configurazioni personalizzate per il gruppo di lavoro

-

Se desideri creare o utilizzare un ruolo IAM personalizzato o configurare la crittografia dei notebook, espandi IAM role configuration (Configurazione del ruolo IAM).

-

Per Service Role to authorize Athena scegliere una delle seguenti opzioni:

-

Create and use a new service role: scegliere questa opzione affinché Athena crei un ruolo di servizio per tuo conto. Per visualizzare le autorizzazioni concesse dal ruolo, scegli View permission details (Visualizza i dettagli delle autorizzazioni).

-

Choose an existing service role: dall'elenco a discesa, scegliere un ruolo esistente. Il ruolo scelto deve includere le autorizzazioni nella prima opzione. Per ulteriori informazioni sulle autorizzazioni per i gruppi di lavoro abilitati per i notebook, consulta la pagina Risolvere problemi relativi ai gruppi di lavoro abilitati per Spark.

-

-

In Notebook and calculation code encryption key management (Gestione delle chiavi di crittografia del codice di calcolo), scegli una delle opzioni seguenti:

-

Encrypt using AWS owned key (Default): la chiave AWS KMS è di proprietà e gestita da AWS. Non ti viene addebitato alcun costo aggiuntivo per l'utilizzo di questa chiave.

-

Encrypt using your own AWS KMS key: per questa opzione, eseguire una delle seguenti operazioni:

-

Per utilizzare una chiave esistente, utilizza la casella di ricerca per scegliere una chiave AWS KMS o inserisci l'ARN di una chiave.

-

Per creare una chiave nella console AWS KMS, seleziona Crea una chiave AWS KMS. Il ruolo di esecuzione deve disporre dell'autorizzazione a utilizzare la chiave che crei. Dopo avere completato la creazione della chiave nella console KMS, torna alla pagina Crea gruppo di lavoro nella console Athena, quindi utilizza la casella di ricerca Scegli una chiave AWS KMS o inserisci un ARN per scegliere la chiave appena creata.

-

Importante

Quando modifichi la AWS KMS key per un gruppo di lavoro, i notebook gestiti prima dell'aggiornamento continuano a fare riferimento alla vecchia chiave KMS. I notebook gestiti dopo l'aggiornamento utilizzano la nuova chiave KMS. Per aggiornare i vecchi notebook in modo che facciano riferimento alla nuova chiave KMS, esporta e quindi importa ciascuno dei vecchi notebook. Se elimini la vecchia chiave KMS prima di aggiornare i riferimenti dei vecchi notebook alla nuova chiave KMS, i vecchi notebook non saranno più decifrabili e non potranno essere recuperati.

Questo comportamento si applica anche agli aggiornamenti degli alias, che sono nomi semplici per le chiavi KMS. Quando si aggiorna un alias di chiave KMS in modo che punti a una nuova chiave KMS, i notebook gestiti prima dell'aggiornamento dell'alias fanno ancora riferimento alla vecchia chiave KMS, mentre i notebook gestiti dopo l'aggiornamento dell'alias utilizzano la nuova chiave KMS. Tieni a mente questi aspetti prima di aggiornare le chiavi o gli alias KMS.

-

-

-

(Facoltativo) Other settings (Altre impostazioni): espandi questa opzione per abilitare o disabilitare l'opzione Publish CloudWatch metrics (Pubblica parametri di CloudWatch) per il gruppo di lavoro. Questo campo è selezionato per impostazione predefinita. Per ulteriori informazioni, consulta Monitorare i calcoli di Apache Spark in Athena con i parametri di CloudWatch.

-

(Facoltativo) Tags (Tag): utilizza questa opzione per aggiungere tag al gruppo di lavoro. Per ulteriori informazioni, consulta Assegnare tag alle risorse di Athena.

-

Selezionare Create workgroup (Crea gruppo di lavoro). Un messaggio informa che il gruppo di lavoro è stato creato correttamente e il gruppo di lavoro viene visualizzato nell'elenco dei gruppi di lavoro.

Passaggio 2: aprire Notebook explorer e cambio del gruppo di lavoro

Prima di poter utilizzare il gruppo di lavoro abilitato a Spark che hai appena creato, devi passare a tale gruppo di lavoro. Per passare da un gruppo di lavoro abilitato a Spark a un altro, puoi utilizzare l'opzione Workgroup (Gruppo di lavoro) in Notebook explorer o Notebook editor (Editor notebook).

Nota

Apertura di Notebook explorer e cambio del gruppo di lavoro

-

Nel pannello di navigazione, scegli Notebook explorer.

-

Usa l'opzione Workgroup (Gruppo di lavoro) nell'angolo in alto a destra della console per scegliere il gruppo di lavoro abilitato a Spark che hai creato. Il notebook di esempio è mostrato nell'elenco dei notebook.

Puoi utilizzare Notebook explorer nei modi seguenti:

-

Scegli il nome con collegamento di un notebook per aprirlo in una nuova sessione.

-

Per rinominare, eliminare o esportare il tuo notebook, utilizza il menu Actions (Operazioni).

-

Per importare un file del notebook, scegli Import file (Importa file).

-

Per creare un notebook, scegli Create notebook (Crea notebook).

-

Passaggio 3: eseguire il notebook di esempio

Il notebook di esempio richiama i dati da un set di dati di viaggi in taxi a New York City disponibile al pubblico. Il notebook contiene esempi che mostrano come lavorare con Spark DataFrames, Spark SQL e AWS Glue Data Catalog.

Esecuzione del notebook di esempio

-

In Notebook explorer, scegli il nome collegato del notebook di esempio.

Questo avvia una sessione del notebook con i parametri predefiniti e apre il notebook nell'editor notebook. Un messaggio informa che è stata avviata una nuova sessione di Apache Spark utilizzando i parametri predefiniti (massimo 20 DPU).

-

Per eseguire le celle in ordine e visualizzare i risultati, premi il pulsante Run (Esegui) una volta per ogni cella del notebook.

-

Scorri verso il basso per vedere i risultati e visualizzare nuove celle.

-

Per le celle che contengono un calcolo, una barra di avanzamento mostra la percentuale di completamento, il tempo trascorso e il tempo rimanente.

-

Il notebook di esempio crea un database e una tabella nell'account. La cella finale li rimuove come fase di pulizia.

-

Nota

Se modifichi i nomi di cartelle, tabelle o database nel notebook di esempio, assicurati che tali modifiche si riflettano nei ruoli IAM che utilizzi. In caso contrario, il notebook potrebbe non funzionare a causa di autorizzazioni insufficienti.

Passaggio 4: modificare i dettagli della sessione

Dopo avere avviato una sessione di notebook, puoi modificare dettagli della sessione come, il formato delle tabelle, il timeout di inattività della sessione e il numero massimo di unità di elaborazione dati (DPU) simultanee che intendi utilizzare. Una DPU è una misura relativa della potenza di elaborazione ed è costituita da 4 vCPU di capacità di elaborazione e 16 GB di memoria.

Modifica dei dettagli della sessione

-

Nell'editor notebook, nel menu Session (Sessione) in alto a destra, scegli Edit session (Modifica sessione).

-

Nella finestra di dialogo Modifica dettagli sessione, nella sezione Proprietà Spark, scegli o inserisci i valori per le seguenti opzioni:

-

Formato di tabella aggiuntivo: seleziona Linux Foundation Delta Lake, Apache Hudi, Apache Iceberg oppure Personalizzato.

-

Per le opzioni di tabella Delta, Hudi o Iceberg, le proprietà di tabella richieste per il formato di tabella corrispondente vengono fornite automaticamente nelle opzioni Modifica nella tabella e Modifica in JSON. Per ulteriori informazioni sull'utilizzo di queste tabelle, consulta Utilizzare formati di tabella non Hive in Athena per Spark.

-

Per aggiungere o rimuovere proprietà di tabella per i tipi di tabella Personalizzata o di altro tipo, utilizzate le opzioni Modifica nella tabella e Modifica in JSON.

-

Per l'opzione Modifica nella tabella, seleziona Aggiungi proprietà per aggiungere una proprietà o Rimuovi per rimuovere una proprietà. Per immettere i nomi delle proprietà e i relativi valori, utilizzate le caselle Chiave e Valore.

-

Per l'opzione Modifica in JSON, utilizzate l'editor di testo JSON per modificare direttamente la configurazione.

-

Per copiare il testo JSON negli appunti, seleziona Copia.

-

Per rimuovere tutto il testo dall'editor JSON, scegli Cancella.

-

Per configurare la disposizione delle linee o scegliere un tema di colore per l'editor JSON, scegli l'icona delle impostazioni (a forma di ingranaggio).

-

-

-

Attiva la crittografia Spark -: seleziona questa opzione per crittografare i dati scritti su disco e inviati tramite i nodi di rete Spark. Per ulteriori informazioni, consulta Abilitare la crittografia Apache Spark.

-

-

Nella sezione Parametri sessione scegli o inserisci i valori per le seguenti opzioni:

-

Session idle timeout (Timeout di inattività della sessione): scegli o inserisci un valore compreso tra 1 e 480 minuti. Il valore di default è 20.

-

Coordinator size (Dimensione del coordinatore): un coordinatore è un esecutore speciale che orchestra il lavoro di elaborazione e gestisce altri esecutori in una sessione di notebook. Attualmente, 1 DPU è il valore predefinito nonché l'unico possibile.

-

Executor size (Dimensioni dell'esecutore): un esecutore è l'unità di calcolo più piccola che una sessione di notebook può richiedere ad Athena. Attualmente, 1 DPU è il valore predefinito nonché l'unico possibile.

-

Max concurrent value (Valore simultaneo massimo): il numero massimo di DPU che possono essere eseguite contemporaneamente. Il valore predefinito 20, il valore minimo è 3 e il valore massimo è 60. L'aumento di questo valore non alloca automaticamente risorse aggiuntive, ma Athena tenterà di allocare fino al massimo specificato quando il carico di elaborazione lo richiede e quando le risorse sono disponibili.

-

-

Selezionare Salva.

-

Alla richiesta Confirm edit (Conferma modifica), scegli Confirm (Conferma).

Athena salva il notebook e avvia una nuova sessione con i parametri specificati. Un banner nell'editor notebook informa che è iniziata una nuova sessione con i parametri modificati.

Nota

Athena ricorda le impostazioni della sessione per il notebook. Se modifichi i parametri di una sessione e poi la termini, Athena utilizza i parametri di sessione che hai configurato la volta successiva che avvii una sessione del notebook.

Passaggio 5: visualizzare i dettagli della sessione e del calcolo

Dopo avere eseguito il notebook, è possibile visualizzare i dettagli della sessione e del calcolo.

Visualizzazione dei dettagli della sessione e del calcolo

-

Dal menu Session (Sessione) in alto a destra, scegli View details (Visualizza dettagli).

-

La scheda Current session (Sessione corrente) mostra informazioni sulla sessione corrente, tra cui l'ID della sessione, l'ora di creazione, lo stato e il gruppo di lavoro.

-

La scheda History (Cronologia) elenca gli ID delle sessioni precedenti. Per visualizzare i dettagli di una sessione precedente, scegli la scheda History (Cronologia), quindi scegli un ID di sessione nell'elenco.

-

La sezione Calculations (Calcoli) mostra un elenco dei calcoli eseguiti durante la sessione.

-

-

Per visualizzare i dettagli di un calcolo, scegli l'ID del calcolo.

-

Nella pagina Calculation details (Dettagli del calcolo), è possibile eseguire le seguenti operazioni:

-

Per visualizzare il codice per il calcolo, consulta la sezione Code (Codice).

-

Per visualizzare i risultati del calcolo, scegli la scheda Results (Risultati).

-

Per scaricare i risultati visualizzati in formato di testo, scegli Download results (Scarica risultati).

-

Per visualizzare informazioni sui risultati del calcolo in Amazon S3, scegli View in S3 (Visualizza in S3).

-

Passaggio 6: terminare la sessione

Per terminare una sessione del notebook

-

Nell'editor notebook, nel menu Session (Sessione) in alto a destra, scegli Terminate (Termina).

-

Alla richiesta Confirm session termination (Conferma chiusura della sessione), scegli Confirm (Conferma). Il notebook viene salvato e si torna all'editor notebook.

Nota

La chiusura di una scheda del notebook nell'editor notebook non interrompe la sessione di un notebook attivo. Se vuoi assicurarti che la sessione venga terminata, utilizza l'opzione Session (Sessione), Terminate (Termina).

Passaggio 7: creare il proprio notebook

Dopo avere creato un gruppo di lavoro Athena, puoi creare il tuo notebook.

Creazione di un notebook

-

Se il pannello di navigazione della console non è visibile, scegli il menu di espansione a sinistra.

-

Nel pannello di navigazione della console Athena, scegli Notebook explorer o Notebook editor (Editor notebook).

-

Esegui una di queste operazioni:

-

In Notebook explorer, scegli Create notebook (Crea notebook).

-

In Notebook editor (Editor notebook), scegli Create notebook (Crea notebook) oppure seleziona l'icona con il segno più (+) per aggiungere un notebook.

-

-

Nella finestra di dialogo Create notebook (Crea notebook), per Notebook name (Nome del notebook) inserisci un nome.

-

(Facoltativo) Espandi Proprietà Spark, quindi scegli o inserisci i valori per le seguenti opzioni:

-

Formato di tabella aggiuntivo: seleziona Linux Foundation Delta Lake, Apache Hudi, Apache Iceberg, oppure Personalizzato.

-

Per le opzioni di tabella Delta, Hudi o Iceberg, le proprietà di tabella richieste per il formato di tabella corrispondente vengono fornite automaticamente nelle opzioni Edit in table e Edit in JSON. Per ulteriori informazioni sull'utilizzo di queste tabelle, consulta Utilizzare formati di tabella non Hive in Athena per Spark.

-

Per aggiungere o rimuovere proprietà di tabella per i tipi di tabella Personalizzata o di altro tipo, utilizzate le opzioni Modifica nella tabella e Modifica in JSON.

-

Per l'opzione Modifica nella tabella, seleziona Aggiungi proprietà per aggiungere una proprietà o Rimuovi per rimuovere una proprietà. Per immettere i nomi delle proprietà e i relativi valori, utilizzate le caselle Chiave e Valore.

-

Per l'opzione Modifica in JSON, utilizzate l'editor di testo JSON per modificare direttamente la configurazione.

-

Per copiare il testo JSON negli appunti, seleziona Copia.

-

Per rimuovere tutto il testo dall'editor JSON, scegli Cancella.

-

Per configurare la disposizione delle linee o scegliere un tema di colore per l'editor JSON, scegli l'icona delle impostazioni (a forma di ingranaggio).

-

-

-

Attiva la crittografia Spark -: seleziona questa opzione per crittografare i dati scritti su disco e inviati tramite i nodi di rete Spark. Per ulteriori informazioni, consulta Abilitare la crittografia Apache Spark.

-

-

(Facoltativo) Espandi Session parameters (Parametri della sessione), quindi scegli o inserisci i valori per le seguenti opzioni:

-

Session idle timeout (Timeout di inattività della sessione): scegli o inserisci un valore compreso tra 1 e 480 minuti. Il valore di default è 20.

-

Coordinator size (Dimensione del coordinatore): un coordinatore è un esecutore speciale che orchestra il lavoro di elaborazione e gestisce altri esecutori in una sessione di notebook. Attualmente, 1 DPU è il valore predefinito nonché l'unico possibile. Una DPU (data processing unit, ossia unità di elaborazione dati) è una misura relativa della potenza di elaborazione ed è costituita da 4 vCPU di capacità di elaborazione e 16 GB di memoria.

-

Executor size (Dimensioni dell'esecutore): un esecutore è l'unità di calcolo più piccola che una sessione di notebook può richiedere ad Athena. Attualmente, 1 DPU è il valore predefinito nonché l'unico possibile.

-

Max concurrent value (Valore simultaneo massimo): il numero massimo di DPU che possono essere eseguite contemporaneamente. Il valore predefinito è 20 e il valore massimo è 60. L'aumento di questo valore non alloca automaticamente risorse aggiuntive, ma Athena tenterà di allocare fino al massimo specificato quando il carico di elaborazione lo richiede e quando le risorse sono disponibili.

-

-

Seleziona Create (Crea). Il notebook si apre in una nuova sessione nell'editor di notebook.

Per informazioni sulla gestione dei file di notebook, consulta la pagina Gestire i file del notebook.