Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Memigrasi dan mereplikasi file VSAM ke Amazon RDS atau Amazon MSK menggunakan Connect from Excently

Prachi Khanna dan Boopathy GOPALSAMY, Amazon Web Services

Ringkasan

Pola ini menunjukkan kepada Anda cara memigrasi dan mereplikasi file Metode Akses Penyimpanan Virtual (VSAM) dari mainframe ke lingkungan target di AWS Cloud dengan menggunakan Connect from Accurly.

Prasyarat dan batasan

Prasyarat

IBM z/OS V2R1

atau yang lebih baru Server Transaksi CICS untuk z/OS (CICS TS) V5.1 atau yang lebih baru (pengambilan data CICS/VSAM

) IBM MQ 8.0

atau yang lebih baru Kepatuhan dengan persyaratan keamanan z/OS

(misalnya, otorisasi APF untuk pustaka pemuatan) SQData Log pemulihan VSAM dihidupkan

(Opsional) Versi Pemulihan CICS VSAM (CICS VR) untuk secara otomatis menangkap log CDC

Akun AWS yang aktif

Amazon Virtual Private Cloud (VPC) dengan subnet yang dapat dijangkau oleh platform lama Anda

Lisensi VSAM Connect dari Tepatnya

Batasan

Connect tidak mendukung pembuatan tabel target otomatis berdasarkan skema atau copybook sumber VSAM. Anda harus menentukan struktur tabel target untuk pertama kalinya.

Untuk target non-streaming seperti Amazon RDS, Anda harus menentukan sumber konversi ke pemetaan target dalam skrip konfigurasi Apply Engine.

Fungsi pencatatan, pemantauan, dan peringatan diimplementasikan melalui APIs dan memerlukan komponen eksternal (seperti Amazon CloudWatch) untuk beroperasi penuh.

Versi produk

SQData 40134 untuk z/OS

SQData 4.0.43 untuk Amazon Linux Amazon Machine Image (AMI) di Amazon Elastic Compute Cloud (Amazon) EC2

Arsitektur

Tumpukan teknologi sumber

Bahasa Kontrol Pekerjaan (JCL)

z/OS Unix shell dan Fasilitas Produktivitas Sistem Interaktif (ISPF)

Utilitas VSAM (IDCAMS)

Tumpukan teknologi target

Amazon EC2

Amazon MSK

Amazon RDS

Amazon VPC

Arsitektur target

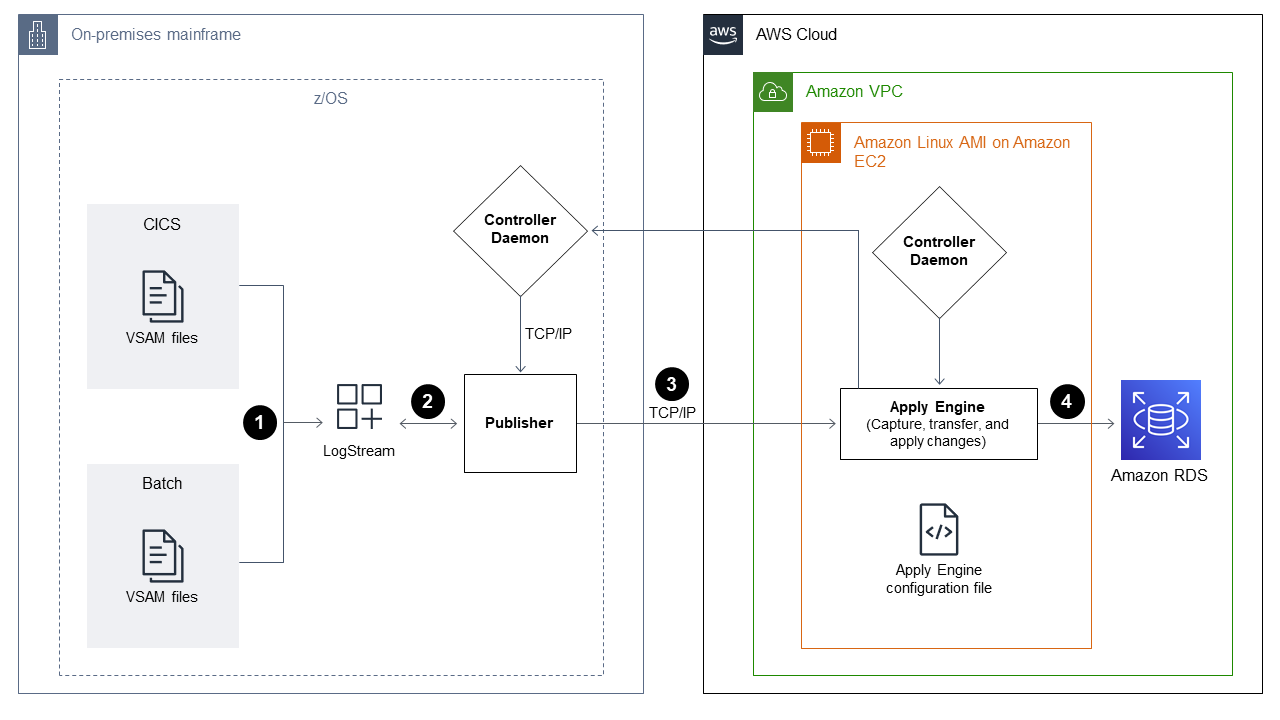

Memigrasi file VSAM ke Amazon RDS

Diagram berikut menunjukkan cara memigrasikan file VSAM ke database relasional, seperti Amazon RDS, secara real time atau mendekati waktu nyata dengan menggunakan CDC agent/publisher di lingkungan sumber (mainframe lokal) dan Apply Engine di

Diagram menunjukkan alur kerja batch berikut:

Connect menangkap perubahan ke file dengan membandingkan file VSAM dari file cadangan untuk mengidentifikasi perubahan dan kemudian mengirimkan perubahan ke logstream.

Penerbit mengkonsumsi data dari logstream sistem.

Publisher mengkomunikasikan perubahan data yang ditangkap ke mesin target melalui TCP/IP. Controller Daemon mengotentikasi komunikasi antara sumber dan lingkungan target.

Apply Engine di lingkungan target menerima perubahan dari agen Publisher dan menerapkannya ke database relasional atau non-relasional.

Diagram menunjukkan alur kerja online berikut:

Connect menangkap perubahan dalam file online dengan menggunakan replika log dan kemudian mengalirkan perubahan yang ditangkap ke logstream.

Penerbit mengkonsumsi data dari logstream sistem.

Publisher mengkomunikasikan perubahan data yang ditangkap ke mesin target melalui TCP/IP. Controller Daemon mengotentikasi komunikasi antara sumber dan lingkungan target.

Apply Engine di lingkungan target menerima perubahan dari agen Publisher dan kemudian menerapkannya ke database relasional atau non-relasional.

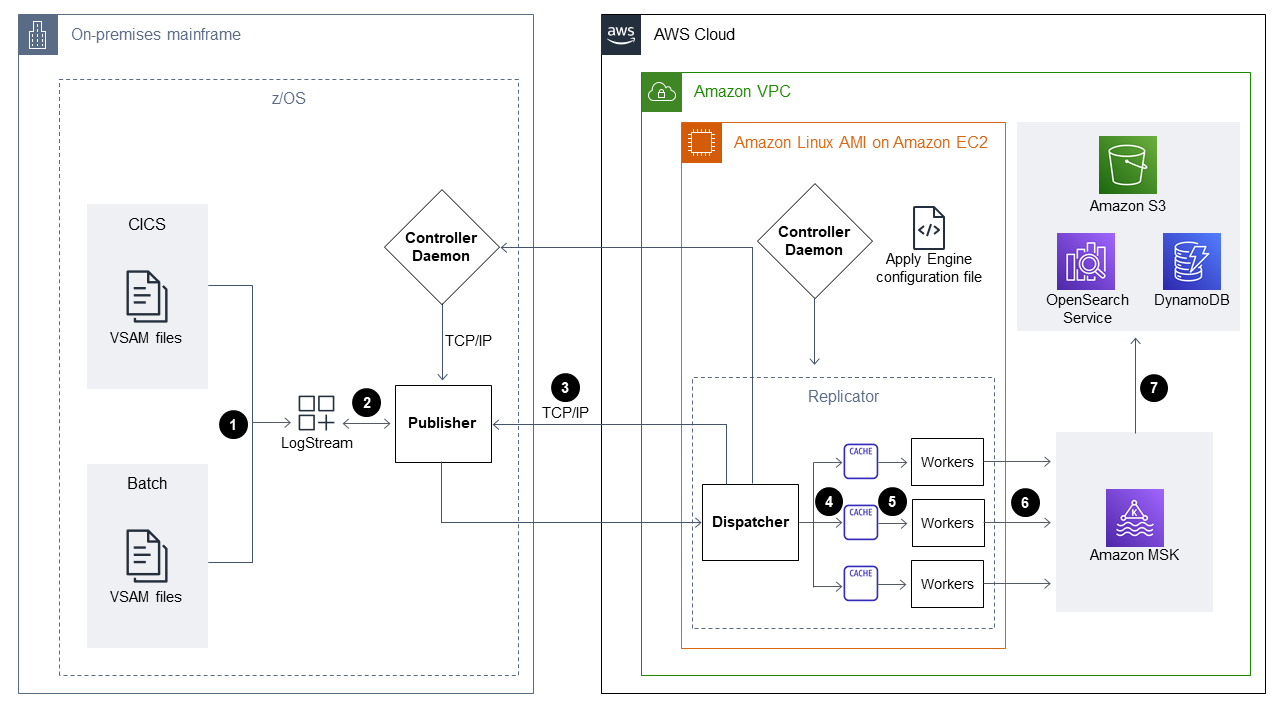

Migrasi file VSAM ke Amazon MSK

Diagram berikut menunjukkan cara mengalirkan struktur data VSAM dari mainframe ke Amazon MSK dalam mode kinerja tinggi dan secara otomatis menghasilkan konversi skema JSON atau AVRO yang terintegrasi dengan Amazon MSK.

Diagram menunjukkan alur kerja batch berikut:

Connect menangkap perubahan ke file dengan menggunakan CICS VR atau dengan membandingkan file VSAM dari file cadangan untuk mengidentifikasi perubahan. Perubahan yang diambil dikirim ke logstream.

Penerbit mengkonsumsi data dari logstream sistem.

Publisher mengkomunikasikan perubahan data yang ditangkap ke mesin target melalui TCP/IP. Controller Daemon mengotentikasi komunikasi antara sumber dan lingkungan target.

Mesin Replicator yang beroperasi dalam mode pemrosesan paralel membagi data ke unit cache kerja.

Thread pekerja menangkap data dari cache.

Data dipublikasikan ke topik MSK Amazon dari utas pekerja.

Diagram menunjukkan alur kerja online berikut:

Perubahan dalam file online ditangkap dengan menggunakan replika log. Perubahan yang ditangkap dialirkan ke logstream.

Penerbit mengkonsumsi data dari logstream sistem.

Publisher mengkomunikasikan perubahan data yang ditangkap ke mesin target melalui TCP/IP. Controller Daemon mengotentikasi komunikasi antara sumber dan lingkungan target.

Mesin Replicator yang beroperasi dalam mode pemrosesan paralel membagi data ke unit cache kerja.

Thread pekerja menangkap data dari cache.

Data dipublikasikan ke topik MSK Amazon dari utas pekerja.

Alat

Amazon Managed Streaming for Apache Kafka (Amazon MSK) adalah layanan yang dikelola sepenuhnya yang membantu Anda membangun dan menjalankan aplikasi yang menggunakan Apache Kafka untuk memproses data streaming.

Amazon Relational Database Service (Amazon RDS) membantu Anda menyiapkan, mengoperasikan, dan menskalakan database relasional di AWS Cloud.

Epik

| Tugas | Deskripsi | Keterampilan yang dibutuhkan |

|---|---|---|

Instal Connect CDC 4.1. |

| Pengembang/Admin Mainframe IBM |

Siapkan direktori ZFs. | Untuk menyiapkan direktori ZFs, ikuti instruksi dari direktori variabel ZFs catatanKonfigurasi Daemon dan Capture/Publisher agen pengontrol disimpan dalam sistem file z/OS UNIX Systems Services (disebut sebagai ZFs). Agen Controller Daemon, Capture, Storage, dan Publisher memerlukan struktur direktori ZFs yang telah ditentukan untuk menyimpan sejumlah kecil file. | Pengembang/Admin Mainframe IBM |

Konfigurasikan TCP/IP port. | Untuk mengkonfigurasi TCP/IP port, ikuti instruksi dari port TCP/IP catatanDaemon Controller membutuhkan TCP/IP port pada sistem sumber. Port direferensikan oleh mesin pada sistem target (di mana data perubahan yang ditangkap diproses). | Pengembang/Admin Mainframe IBM |

Buat z/OS logstream. | Untuk membuat logstream z/OS catatanConnect menggunakan logstream untuk menangkap dan mengalirkan data antara lingkungan sumber dan lingkungan target selama migrasi. Untuk contoh JCL yang membuat z/OS LogStream, lihat Membuat z/OS sistem LogStreams | Pengembang Mainframe IBM |

Identifikasi dan otorisasi IDs untuk pengguna ZF dan mulai tugas. | Gunakan RACF untuk memberikan akses ke sistem file OMVS ZFS. Untuk contoh JCL, lihat Mengidentifikasi dan mengotorisasi pengguna ZFs dan memulai tugas IDs dalam dokumentasi Tepatnya | Pengembang/Admin Mainframe IBM |

Hasilkan kunci z/OS publik/pribadi dan file kunci resmi. | Jalankan JCL untuk menghasilkan key pair. Sebagai contoh, lihat Contoh pasangan kunci di bagian Informasi tambahan dari pola ini. Untuk petunjuk, lihat Menghasilkan kunci z/OS publik dan pribadi serta file kunci resmi | Pengembang/Admin Mainframe IBM |

Aktifkan Replikasi Log CICS VSAM dan lampirkan ke logstream. | Jalankan skrip JCL berikut:

| Pengembang/Admin Mainframe IBM |

Aktifkan Log Pemulihan File VSAM melalui FCT. | Ubah File Control Table (FCT) untuk mencerminkan perubahan parameter berikut:

| Pengembang/Admin Mainframe IBM |

Siapkan CDCz Log untuk agen Penerbit. |

| Pengembang/Admin Mainframe IBM |

Aktifkan Daemon Pengontrol. |

| Pengembang/Admin Mainframe IBM |

Aktifkan penerbit. |

| Pengembang/Admin Mainframe IBM |

Aktifkan logstream. |

| Pengembang/Admin Mainframe IBM |

| Tugas | Deskripsi | Keterampilan yang dibutuhkan |

|---|---|---|

Instal Tepat pada sebuah EC2 instance. | Untuk menginstal Connect from Tepat di Amazon Linux AMI untuk Amazon EC2, ikuti petunjuk dari Install Connect CDC (SQData) pada UNIX dalam dokumentasi | AWS Umum |

Buka TCP/IP port. | Untuk memodifikasi grup keamanan untuk menyertakan port Daemon Pengontrol untuk akses masuk dan keluar, ikuti instruksi dari TCP/IP | AWS Umum |

Buat direktori file. | Untuk membuat direktori file, ikuti petunjuk dari Siapkan lingkungan penerapan target | AWS Umum |

Buat file konfigurasi Apply Engine. | Buat file konfigurasi Apply Engine di direktori kerja Apply Engine. Contoh file konfigurasi berikut menunjukkan Apache Kafka sebagai target:

catatanUntuk informasi selengkapnya, lihat Keamanan | AWS Umum |

Buat skrip untuk pemrosesan Apply Engine. | Buat skrip untuk Apply Engine untuk memproses data sumber dan mereplikasi data sumber ke target. Untuk informasi selengkapnya, lihat Membuat skrip mesin terapkan | AWS Umum |

Jalankan skrip. | Gunakan | AWS Umum |

| Tugas | Deskripsi | Keterampilan yang dibutuhkan |

|---|---|---|

Validasi daftar file VSAM dan tabel target untuk pemrosesan CDC. |

| AWS Umum, Mainframe |

Verifikasi bahwa SQData produk Connect CDC ditautkan. | Jalankan pekerjaan pengujian dan verifikasi bahwa kode pengembalian dari pekerjaan ini adalah 0 (Berhasil). catatanConnect CDC SQData Apply Engine pesan status harus menampilkan pesan koneksi aktif. | AWS Umum, Mainframe |

| Tugas | Deskripsi | Keterampilan yang dibutuhkan |

|---|---|---|

Jalankan pekerjaan batch di mainframe. | Jalankan pekerjaan aplikasi batch menggunakan JCL yang dimodifikasi. Sertakan langkah-langkah dalam JCL yang dimodifikasi yang melakukan hal berikut:

| AWS Umum, Mainframe |

Periksa logstream. | Periksa logstream untuk mengonfirmasi bahwa Anda dapat melihat data perubahan untuk pekerjaan batch mainframe yang telah selesai. | AWS Umum, Mainframe |

Validasi jumlah untuk perubahan delta sumber dan tabel target. | Untuk mengonfirmasi bahwa catatan dihitung, lakukan hal berikut:

| AWS Umum, Mainframe |

| Tugas | Deskripsi | Keterampilan yang dibutuhkan |

|---|---|---|

Jalankan transaksi online di wilayah CICS. |

| Pengembang Mainframe IBM |

Periksa logstream. | Konfirmasikan bahwa logstream diisi dengan perubahan tingkat catatan tertentu. | Pengembang AWS Mainframe |

Validasi hitungan dalam database target. | Pantau Apply Engine untuk mencatat jumlah level. | Tepatnya, Linux |

Validasi jumlah catatan dan catatan data dalam database target. | Kueri database target untuk memvalidasi jumlah catatan dan catatan data. | AWS Umum |

Sumber daya terkait

Terapkan mesin

(Tepatnya dokumentasi) Mesin replikator

(Dokumentasi tepatnya) Aliran log

(dokumentasi IBM)

Informasi tambahan

Contoh file konfigurasi

Ini adalah contoh file konfigurasi untuk logstream di mana lingkungan sumber adalah mainframe dan lingkungan target adalah Amazon MSK:

-- JOBNAME -- PASS THE SUBSCRIBER NAME -- REPORT progress report will be produced after "n" (number) of Source records processed. JOBNAME VSMTOKFK; --REPORT EVERY 100; -- Change Op has been ‘I’ for insert, ‘D’ for delete , and ‘R’ for Replace. For RDS it is 'U' for update -- Character Encoding on z/OS is Code Page 1047, on Linux and UNIX it is Code Page 819 and on Windows, Code Page 1252 OPTIONS CDCOP('I', 'U', 'D'), PSEUDO NULL = NO, USE AVRO COMPATIBLE NAMES, APPLICATION ENCODING SCHEME = 1208; -- SOURCE DESCRIPTIONS BEGIN GROUP VSAM_SRC; DESCRIPTION COBOL ../copybk/ACCOUNT AS account_file; END GROUP; -- TARGET DESCRIPTIONS BEGIN GROUP VSAM_TGT; DESCRIPTION COBOL ../copybk/ACCOUNT AS account_file; END GROUP; -- SOURCE DATASTORE (IP & Publisher name) DATASTORE cdc://10.81.148.4:2626/vsmcdct/VSMTOKFK OF VSAMCDC AS CDCIN DESCRIBED BY GROUP VSAM_SRC ACCEPT ALL; -- TARGET DATASTORE(s) - Kafka and topic name DATASTORE 'kafka:///MSKTutorialTopic/key' OF JSON AS CDCOUT DESCRIBED BY GROUP VSAM_TGT FOR INSERT; -- MAIN SECTION PROCESS INTO CDCOUT SELECT { SETURL(CDCOUT, 'kafka:///MSKTutorialTopic/key') REMAP(CDCIN, account_file, GET_RAW_RECORD(CDCIN, AFTER), GET_RAW_RECORD(CDCIN, BEFORE)) REPLICATE(CDCOUT, account_file) } FROM CDCIN;

Contoh pasangan kunci

Ini adalah contoh bagaimana menjalankan JCL untuk menghasilkan key pair:

//SQDUTIL EXEC PGM=SQDUTIL //SQDPUBL DD DSN=&USER..NACL.PUBLIC, // DCB=(RECFM=FB,LRECL=80,BLKSIZE=21200), // DISP=(,CATLG,DELETE),UNIT=SYSDA, // SPACE=(TRK,(1,1)) //SQDPKEY DD DSN=&USER..NACL.PRIVATE, // DCB=(RECFM=FB,LRECL=80,BLKSIZE=21200), // DISP=(,CATLG,DELETE),UNIT=SYSDA, // SPACE=(TRK,(1,1)) //SQDPARMS DD keygen //SYSPRINT DD SYSOUT= //SYSOUT DD SYSOUT=* //SQDLOG DD SYSOUT=* //*SQDLOG8 DD DUMMY