Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Intégration au serveur MCP

Si vous avez déployé le composant serveur MCP optionnel lors du déploiement de la solution, vous pouvez intégrer la solution de test de charge distribué aux outils de développement d'intelligence artificielle qui prennent en charge le protocole Model Context. Le serveur MCP fournit un accès programmatique pour récupérer, gérer et analyser les tests de charge par le biais d'assistants IA.

Les clients peuvent se connecter au serveur DLT MCP en utilisant le client de leur choix (Amazon Q, Claude, etc.), dont les instructions de configuration sont légèrement différentes. Cette section fournit des instructions de configuration pour MCP Inspector, Amazon Q CLI, Cline et Amazon Q Suite.

Étape 1 : Obtenir le point de terminaison et le jeton d'accès MCP

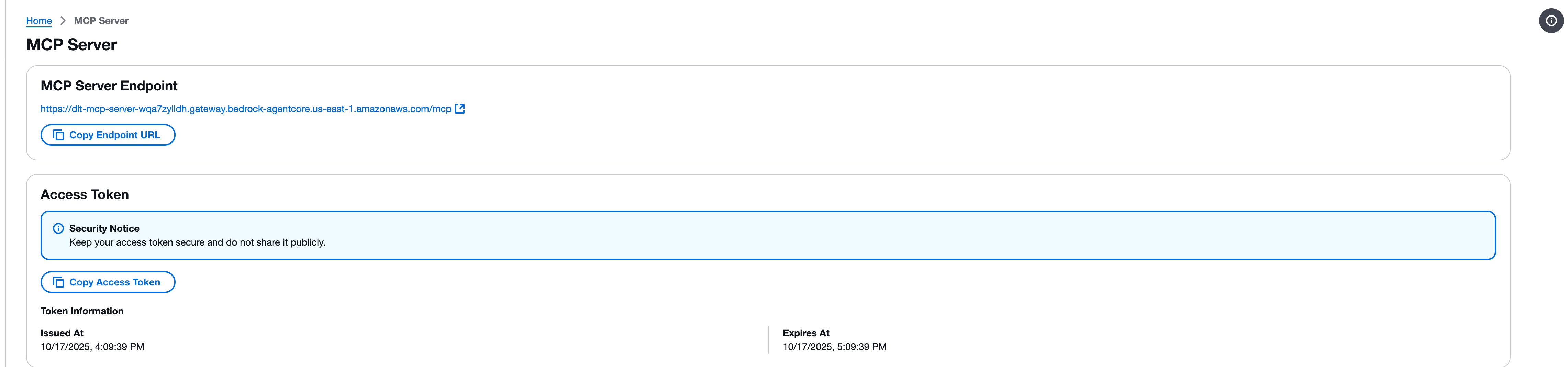

Avant de configurer un client MCP, vous devez récupérer le point de terminaison et le jeton d'accès de votre serveur MCP depuis la console Web DLT.

-

Accédez à la page du serveur MCP dans la console Web de test de charge distribué.

-

Localisez la section MCP Server Endpoint.

-

Copiez l'URL du point de terminaison en utilisant le bouton Copier l'URL du point de terminaison. L'URL du point de terminaison suit le format suivant :

https://{gateway-id}.gateway.bedrock-agentcore.{region}.amazonaws.com/mcp -

Localisez la section Jeton d'accès.

-

Copiez le jeton d'accès à l'aide du bouton Copier le jeton d'accès.

Important

Protégez votre jeton d'accès et ne le partagez pas publiquement. Le jeton fournit un accès en lecture seule à votre solution de test de charge distribué via l'interface MCP.

Étape 2 : Test avec MCP Inspector

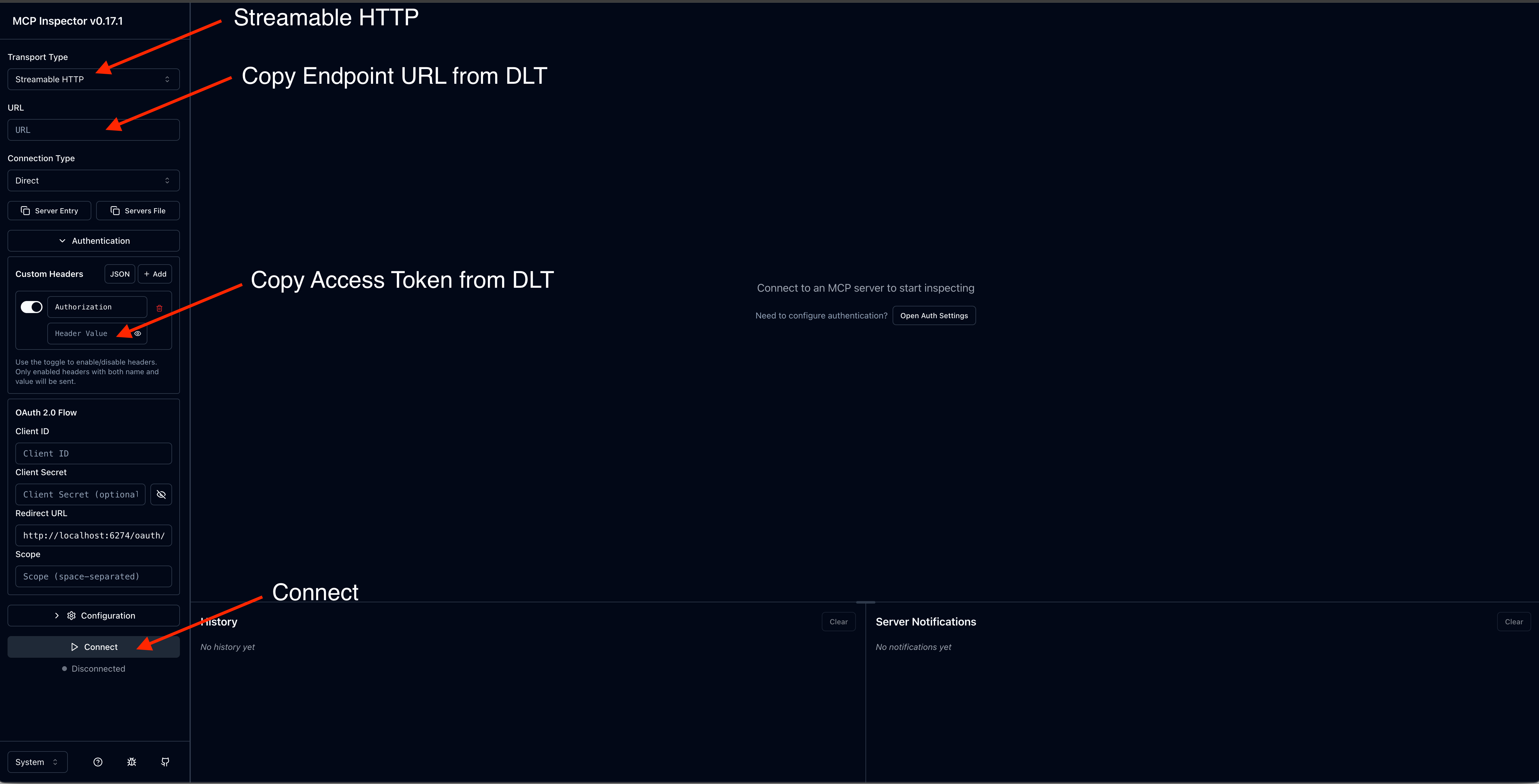

Le Model Context Protocol propose MCP Inspector

Note

MCP Inspector nécessite la version 0.17 ou ultérieure. Toutes les demandes peuvent également être effectuées directement avec JSON RPC, mais MCP Inspector fournit une interface plus conviviale.

Installez et lancez MCP Inspector

-

Installez npm si nécessaire.

-

Exécutez la commande suivante pour lancer MCP Inspector :

npx @modelcontextprotocol/inspector

Configuration de la connexion

-

Dans l'interface MCP Inspector, entrez l'URL de votre point de terminaison du serveur MCP.

-

Ajoutez un en-tête d'autorisation avec votre jeton d'accès.

-

Cliquez sur Connect pour établir la connexion.

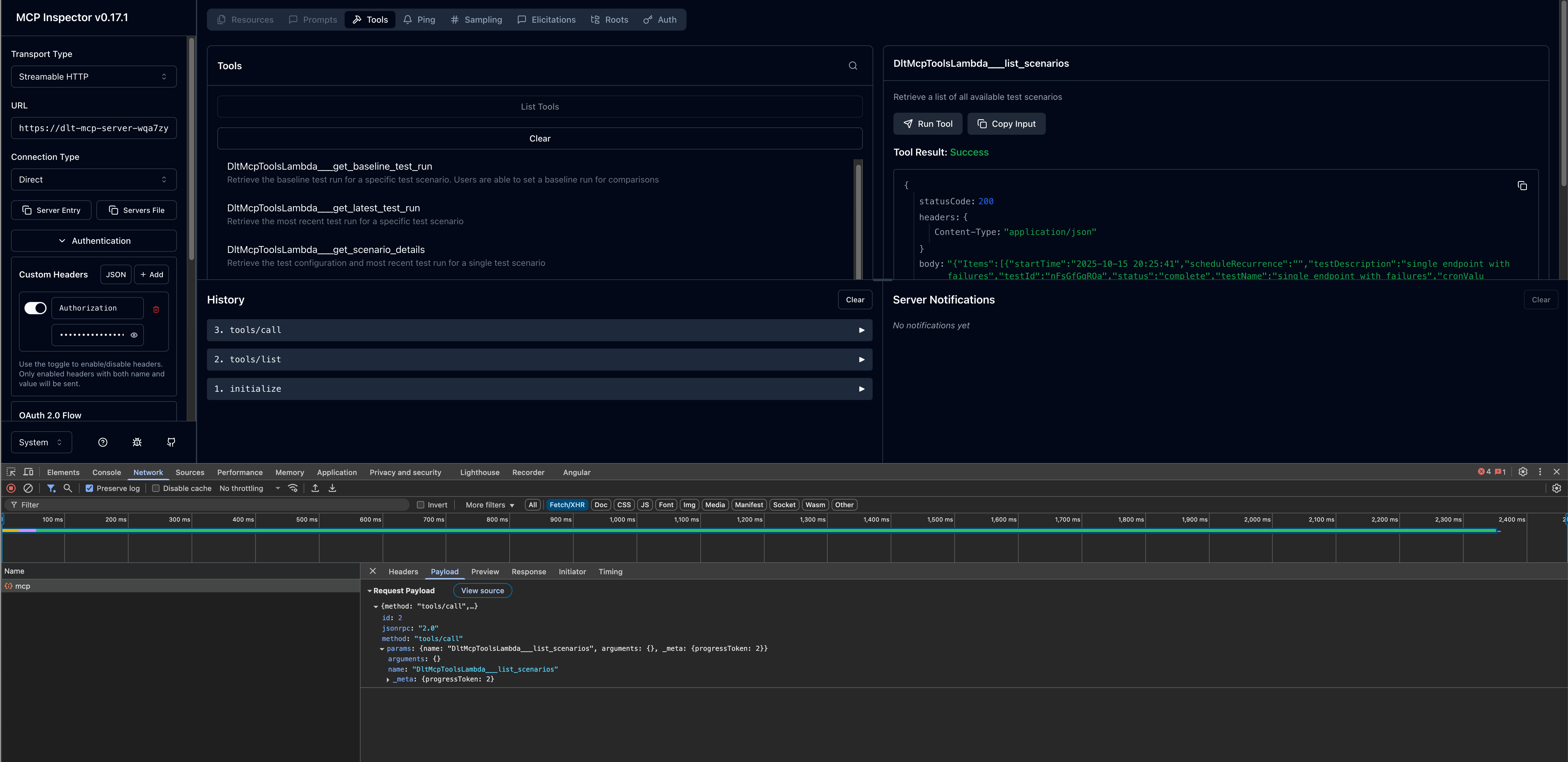

Outils d'appel

Une fois connecté, vous pouvez tester les outils MCP disponibles :

-

Parcourez la liste des outils disponibles dans le panneau de gauche.

-

Sélectionnez un outil (par exemple,

list_scenarios). -

Fournissez tous les paramètres requis.

-

Cliquez sur Invoke pour exécuter l'outil et afficher la réponse.

Étape 3 : Configuration des clients de développement AI

Après avoir vérifié votre connexion au serveur MCP avec MCP Inspector, vous pouvez configurer votre client de développement AI préféré.

interface de ligne de commande d’Amazon Q

La CLI Amazon Q fournit un accès en ligne de commande au développement assisté par l'IA avec intégration au serveur MCP.

Étapes de configuration

-

Modifiez le fichier

mcp.jsonde configuration. Pour plus d'informations sur l'emplacement du fichier de configuration, reportez-vous à la section Configuration de serveurs MCP distants dans le manuel Amazon Q Developer User Guide. -

Ajoutez la configuration de votre serveur DLT MCP :

{ "mcpServers": { "dlt-mcp": { "type": "http", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } }

Vérifiez la configuration

-

Dans un terminal, tapez

qpour lancer Amazon Q CLI. -

Tapez

/mcppour voir tous les serveurs MCP disponibles. -

Tapez

/toolspour voir les outils disponibles fournis par les serveurs MCP configurésdlt-mcpet les autres serveurs MCP configurés. -

Vérifiez que l'initialisation est

dlt-mcpréussie.

Cline

Cline est un assistant de codage AI qui prend en charge l'intégration des serveurs MCP.

Étapes de configuration

-

Dans Cline, accédez à Gérer les serveurs MCP > Configurer > Configurer les serveurs MCP.

-

Mettez à jour le

cline_mcp_settings.jsonfichier :{ "mcpServers": { "dlt-mcp": { "type": "streamableHttp", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } } -

Enregistrez le fichier de configuration.

-

Redémarrez Cline pour appliquer les modifications.

Suite Amazon Q

Amazon Q Suite fournit une plate-forme d'assistant d'intelligence artificielle complète prenant en charge les actions du serveur MCP.

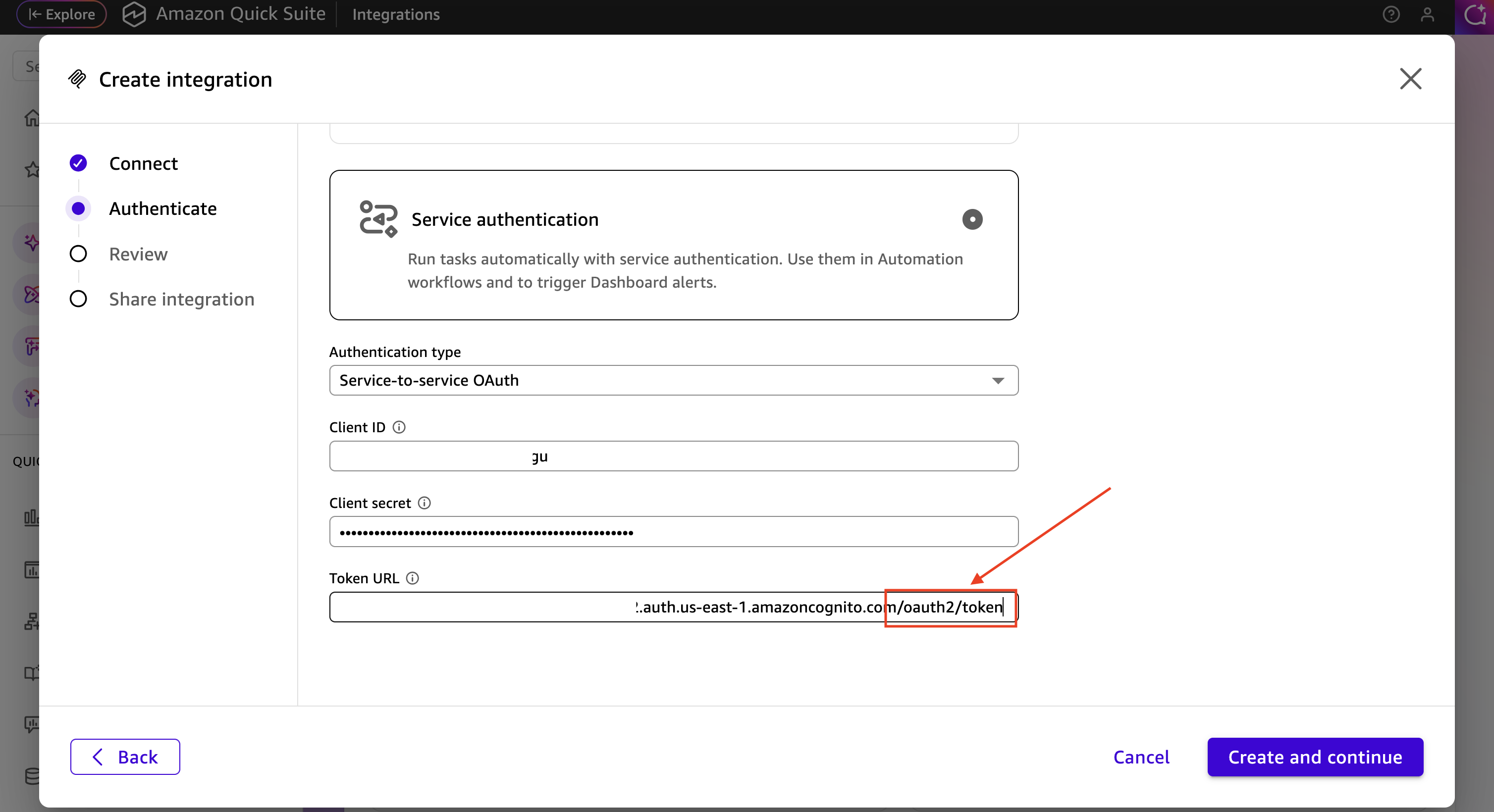

Conditions préalables

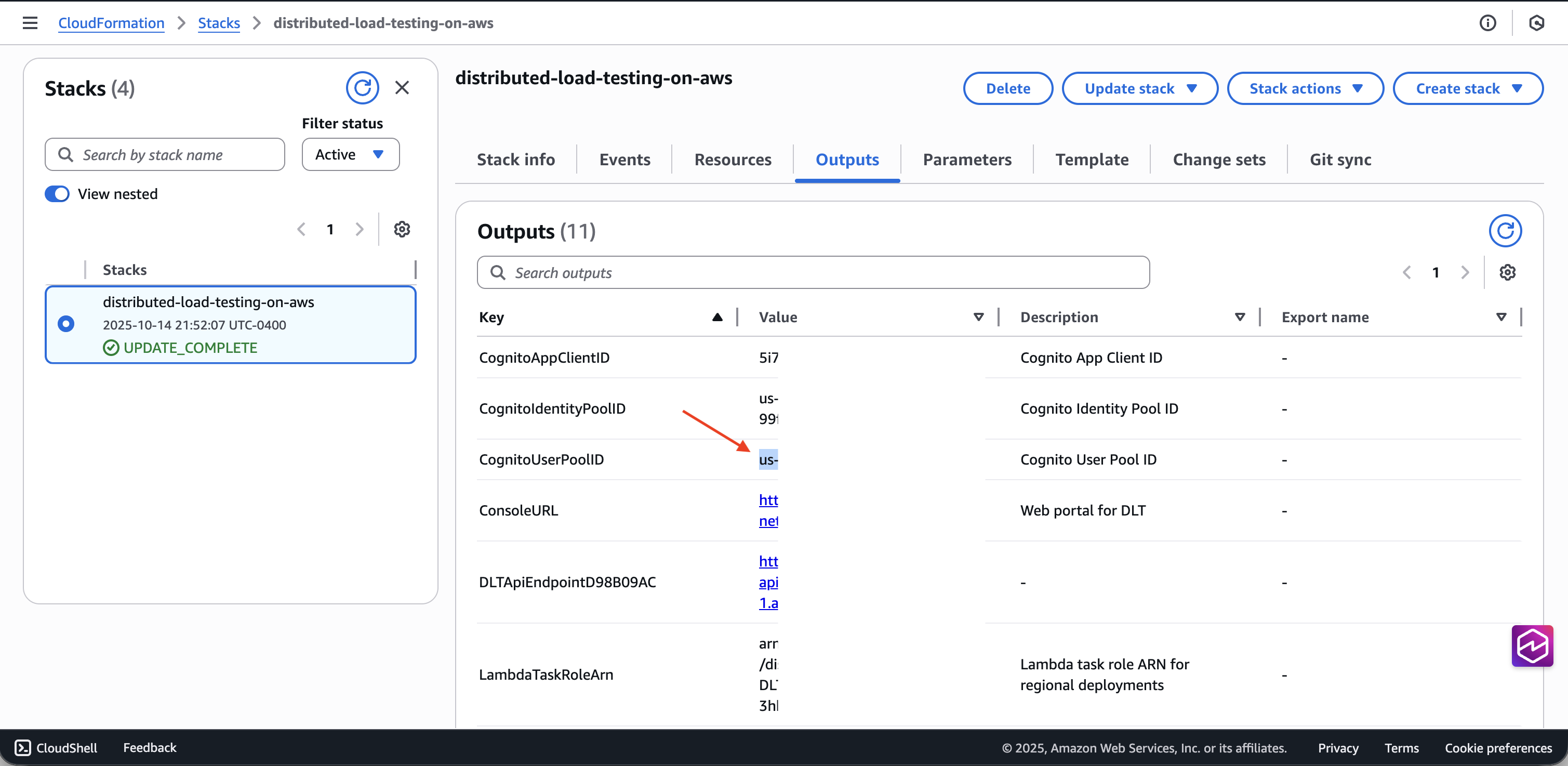

Avant de configurer le serveur MCP dans Amazon Q Suite, vous devez récupérer les informations d' OAuth identification du groupe d'utilisateurs Cognito de votre déploiement DLT :

-

Accédez à la CloudFormation console AWS

. -

Sélectionnez la pile de tests de charge distribués.

-

Dans l'onglet Sorties, recherchez et copiez l'ID du groupe d'utilisateurs Cognito associé à votre déploiement DLT.

-

Accédez à la console Amazon Cognito

. -

Sélectionnez le groupe d'utilisateurs à l'aide de l'ID du groupe d'utilisateurs dans les CloudFormation sorties.

-

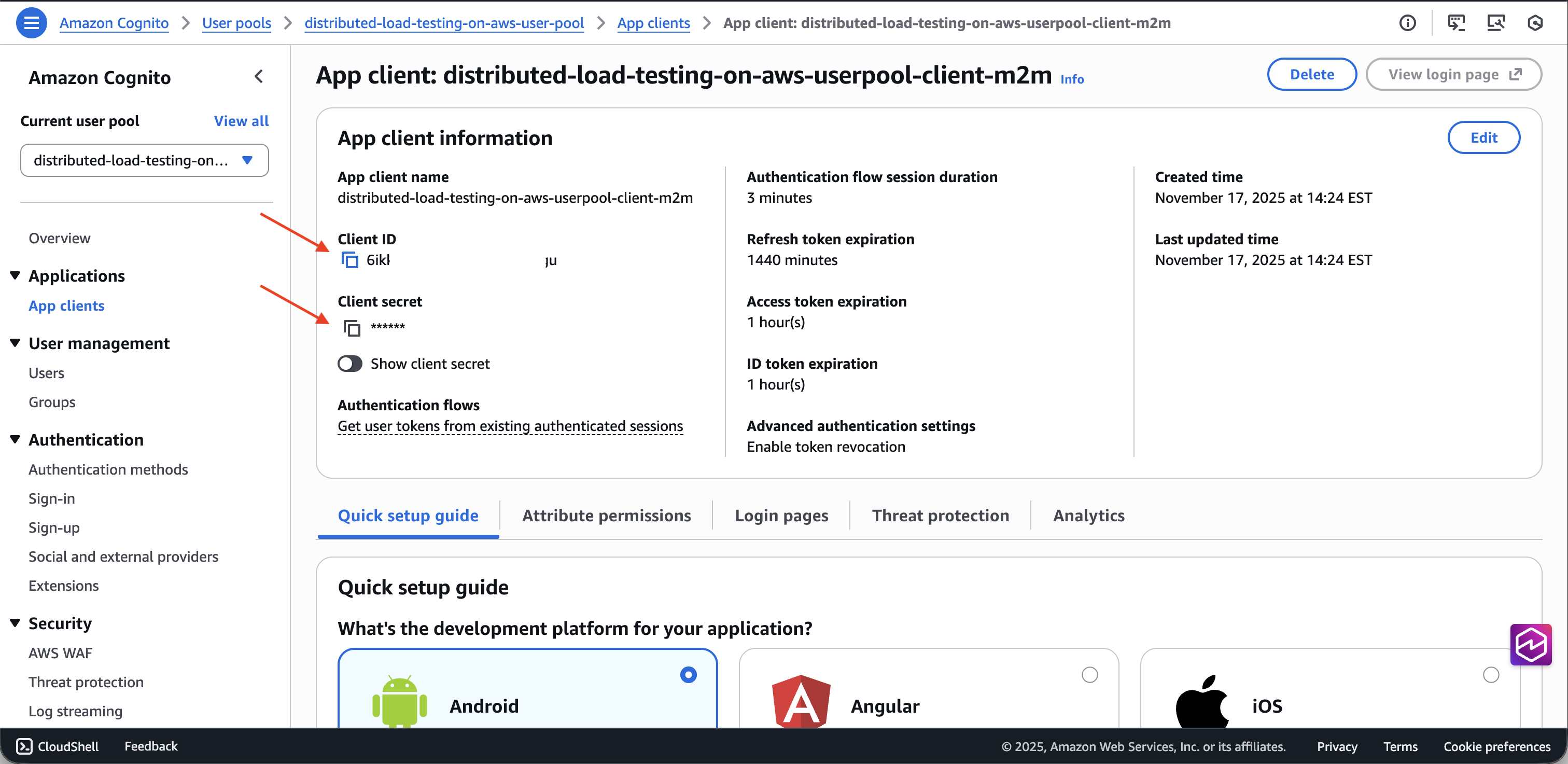

Dans le volet de navigation de gauche, sélectionnez Intégration des applications > Clients des applications.

-

Localisez le client de l'application dont le nom se termine par

m2m(machine-to-machine). -

Copiez l'ID client et le secret du client.

-

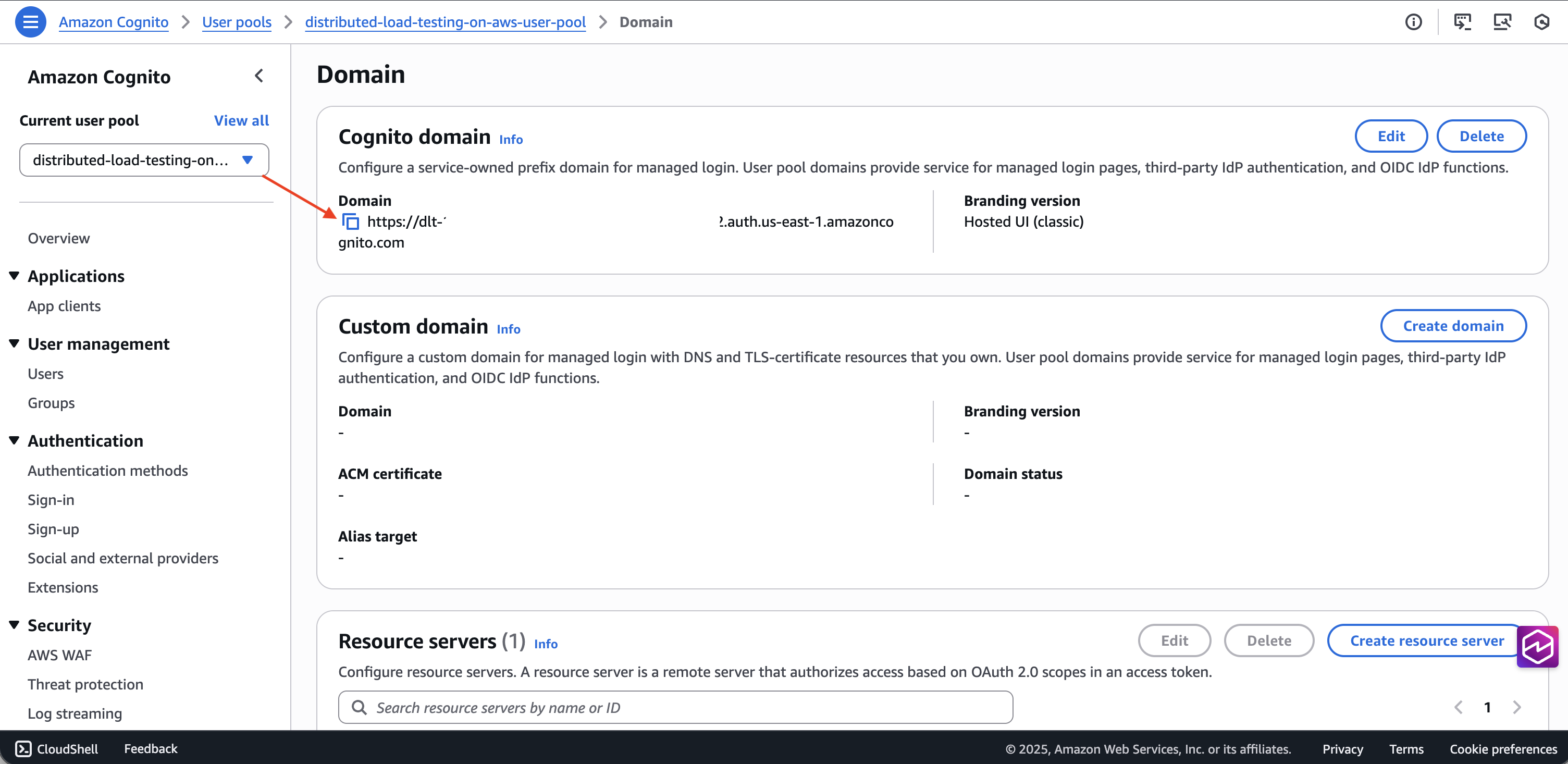

Obtenez le domaine du groupe d'utilisateurs dans l'onglet Domaine.

-

Créez l'URL du point de terminaison du jeton en l'ajoutant

/oauth2/tokenà la fin du domaine.

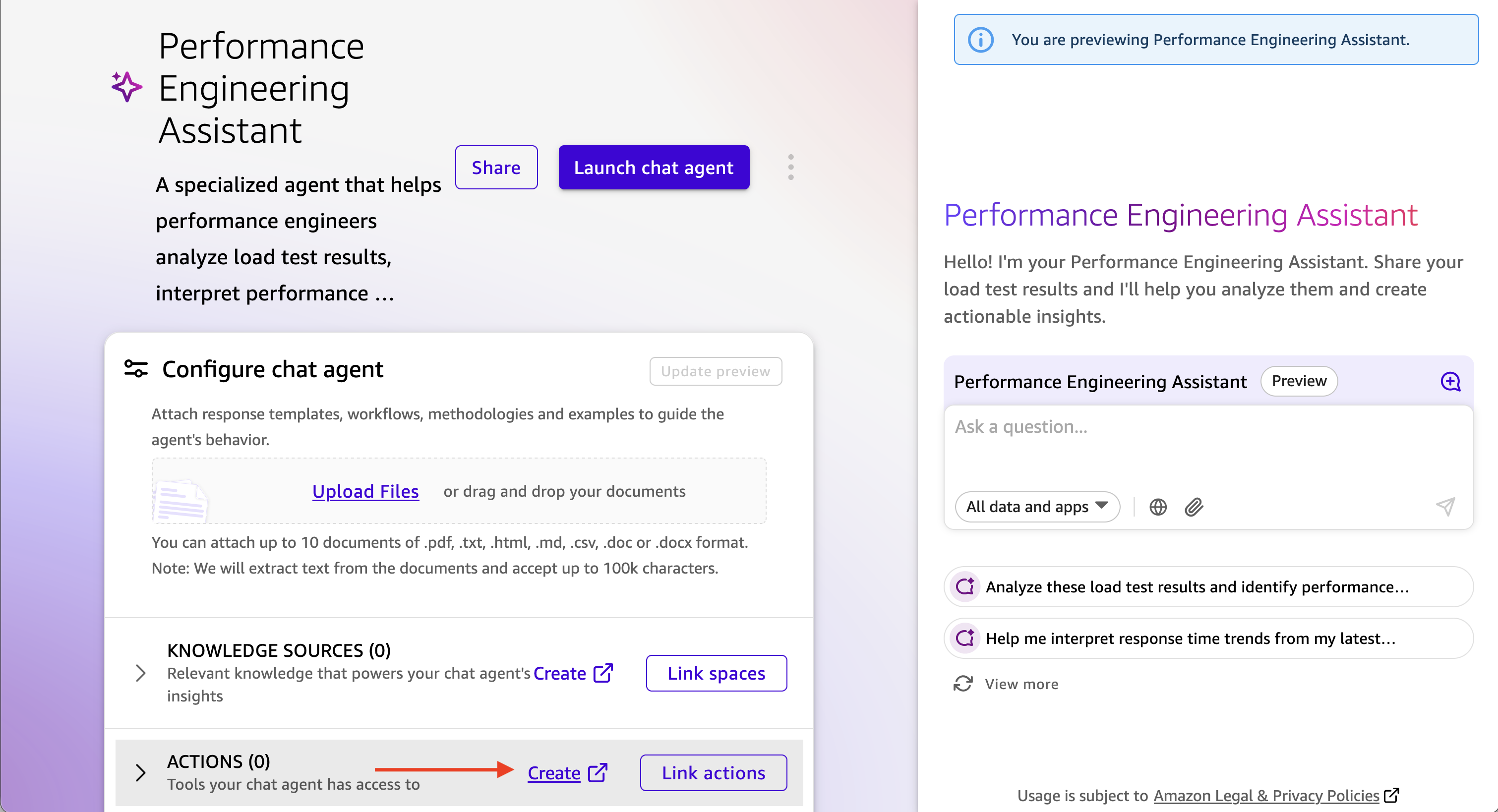

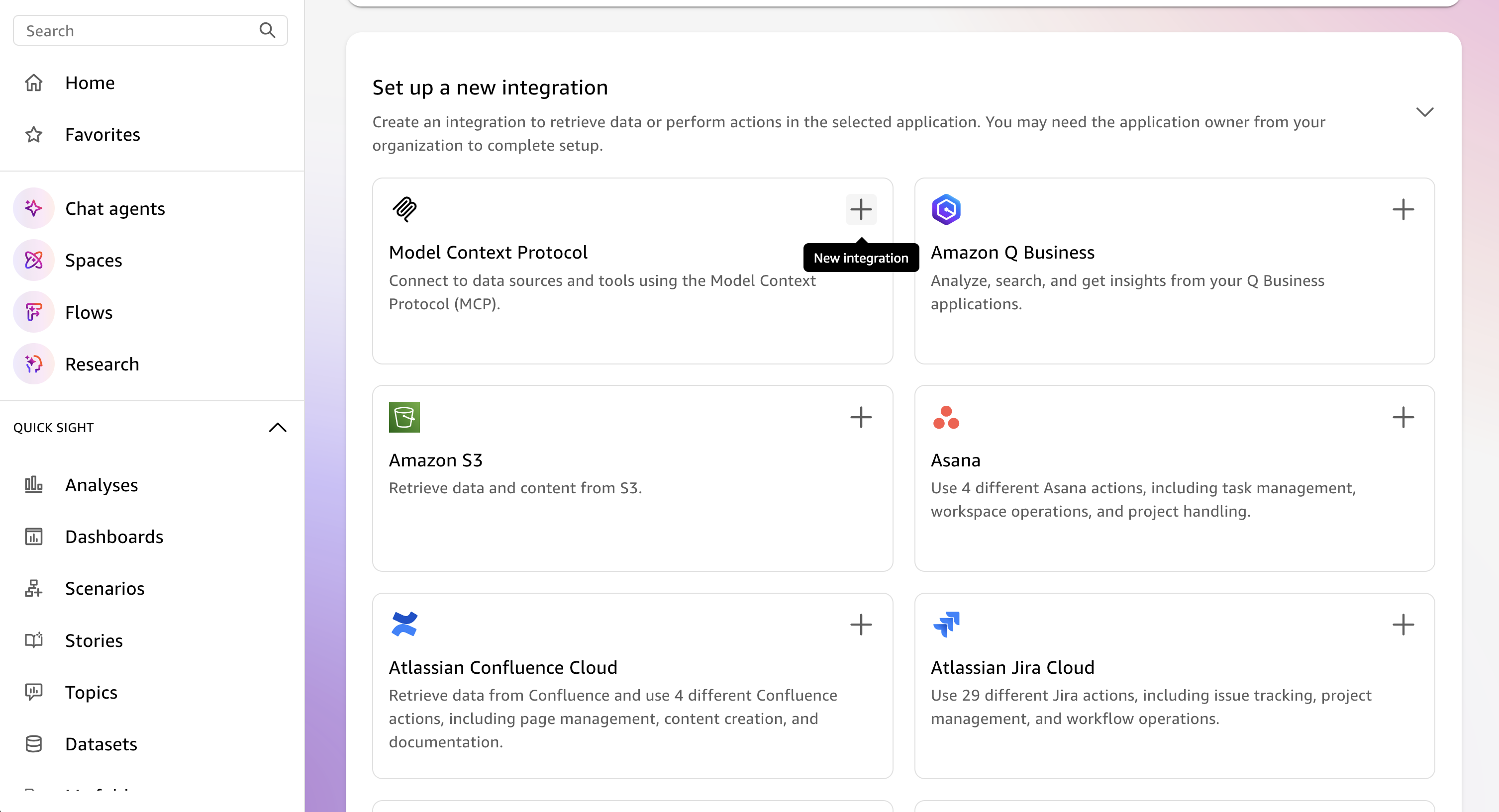

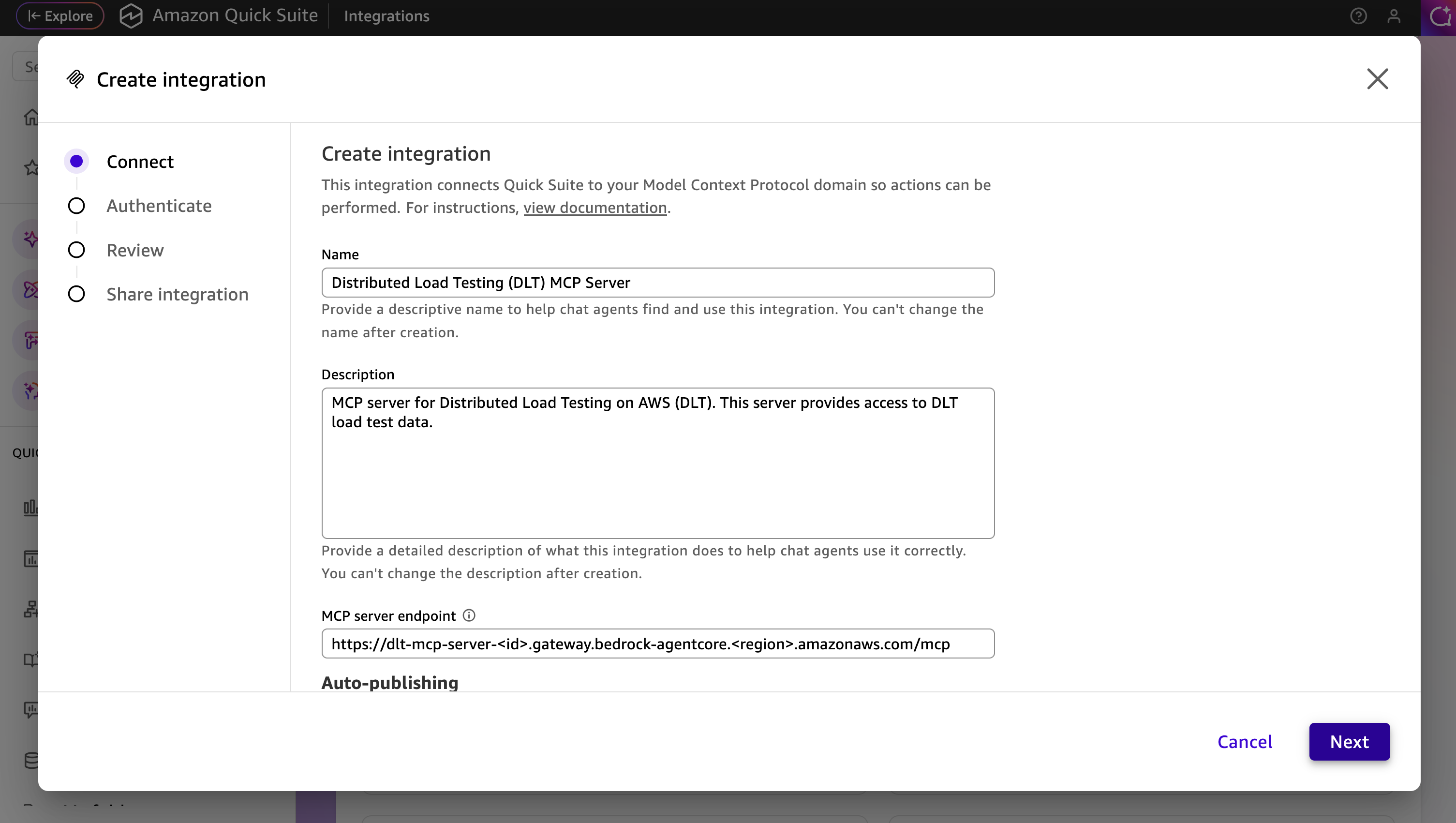

Étapes de configuration

-

Dans Amazon Q Suite, créez un nouvel agent ou sélectionnez un agent existant.

-

Ajoutez une invite d'agent qui décrit comment interagir avec le serveur DLT MCP.

-

Ajoutez une nouvelle action et sélectionnez l'action du serveur MCP.

-

Configurez les détails du serveur MCP :

-

URL du serveur MCP : votre point de terminaison DLT MCP

-

Type d'authentification : Authentification basée sur le service

-

Point de terminaison du jeton : URL du point de terminaison de votre jeton Cognito

-

ID client : ID client du client de l'application m2m

-

Secret du client : le secret du client de l'application m2m

-

-

Enregistrez la configuration des actions du serveur MCP.

-

Ajoutez la nouvelle action du serveur MCP à votre agent.

Lancez et testez l'agent

-

Lancez l'agent dans Amazon Q Suite.

-

Entamez une conversation avec l'agent à l'aide d'instructions en langage naturel.

-

L'agent utilisera les outils MCP pour récupérer et analyser vos données de test de charge.

Exemples d’invites

Les exemples suivants montrent comment interagir avec votre assistant AI pour analyser les données de test de charge via l'interface MCP. Personnalisez le test IDs, les plages de dates et les critères en fonction de vos besoins de test spécifiques.

Pour des informations détaillées sur les outils MCP disponibles et leurs paramètres, reportez-vous aux spécifications des outils MCP dans le manuel du développeur.

Demande simple de résultats de test

L'interaction en langage naturel avec le serveur MCP peut être aussi simple Show me the load tests that have completed in the last 24 hours with their associated completion status ou plus descriptive, comme

Use list_scenarios to find my load tests. Then use get_latest_test_run to show me the basic execution data and performance metrics for the most recent test. If the results look concerning, also get the detailed performance metrics using get_test_run.

Analyse de performance interactive avec divulgation progressive

I need to analyze my load test performance, but I'm not sure which specific tests to focus on. Please help me by: 1. First, use list_scenarios to show me available test scenarios 2. Ask me which tests I want to analyze based on the list you show me 3. For my selected tests, use list_test_runs to get the test run history 4. Then use get_test_run with the test_run_id to get detailed response times, throughput, and error rates 5. If I want to compare tests, use get_baseline_test_run to compare against the baseline 6. If there are any issues, use get_test_run_artifacts to help me understand what went wrong Please guide me through this step by step, asking for clarification whenever you need more specific information.

Validation du niveau de préparation

Help me validate if my API is ready for production deployment: 1. Use list_scenarios to find recent test scenarios 2. For the most recent test scenario, use get_latest_test_run to get basic execution data 3. Use get_test_run with that test_run_id to get detailed response times, error rates, and throughput 4. Use get_scenario_details with the test_id to show me what load patterns and endpoints were tested 5. If I have a baseline, use get_baseline_test_run to compare current results with the baseline 6. Provide a clear go/no-go recommendation based on the performance data 7. If there are any concerns, use get_test_run_artifacts to help identify potential issues My SLA requirements are: response time under [X]ms, error rate under [Y]%.

Analyse des tendances de performance

Analyze the performance trend for my load tests over the past [TIME_PERIOD]: 1. Use list_scenarios to get all test scenarios 2. For each scenario, use list_test_runs with start_date and end_date to get tests from that period 3. Use get_test_run for the key test runs to get detailed metrics 4. Use get_baseline_test_run to compare against the baseline 5. Identify any significant changes in response times, error rates, or throughput 6. If you detect performance degradation, use get_test_run_artifacts on the problematic tests to help identify causes 7. Present the trend analysis in a clear format showing whether performance is improving, stable, or degrading Focus on completed tests and limit results to [N] tests if there are too many.

Dépannage des tests ayant échoué

Help me troubleshoot my failed load tests: 1. Use list_scenarios to find test scenarios 2. For each scenario, use list_test_runs to find recent test runs 3. Use get_test_run with the test_run_id to get the basic execution data and failure information 4. Use get_test_run_artifacts to get detailed error messages and logs 5. Use get_scenario_details to understand what was being tested when it failed 6. If I have a similar test that passed, use get_baseline_test_run to identify differences 7. Summarize the causes of failure and suggest next steps for resolution Show me the most recent [N] failed tests from the past [TIME_PERIOD].