Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Compréhension des options de déploiement de modèles et d’obtention d’inférences dans Amazon SageMaker AI

Pour vous aider à démarrer avec SageMaker AI Inference, consultez les sections suivantes qui expliquent les options disponibles pour déployer un modèle dans SageMaker AI et obtenir des inférences. La section Options d’inférence dans Amazon SageMaker AI peut vous aider à déterminer quelle caractéristique correspond le mieux à votre cas d’utilisation pour l’inférence.

Vous pouvez vous reporter à la section Ressources pour obtenir plus d'informations de dépannage et de référence, des blogs et des exemples pour vous aider à bien démarrer, ainsi que des questions fréquentes (FAQ).

Rubriques

Avant de commencer

Ces rubriques supposent que vous avez créé et entraîné un modèle de machine learning, et que vous êtes prêt à le déployer. Vous n’avez pas besoin d’entraîner votre modèle dans SageMaker AI pour le déployer dans SageMaker AI et obtenir des inférences. Si vous ne disposez pas de votre propre modèle, vous pouvez également utiliser les algorithmes intégrés ou les modèles pré-entraînés SageMaker AI.

Si vous êtes un nouvel utilisateur de SageMaker AI et que vous n’avez pas choisi de modèle à déployer, parcourez les étapes du didacticiel Guide de démarrage Amazon SageMaker AI. Utilisez le didacticiel pour vous familiariser avec la façon dont SageMaker AI gère le processus de science des données et le déploiement des modèles. Pour plus d'informations sur l'entraînement d'un modèle, consultez Entraîner des modèles.

Pour obtenir des informations, des références et des exemples supplémentaires, consultez Ressources.

Étapes du déploiement d'un modèle

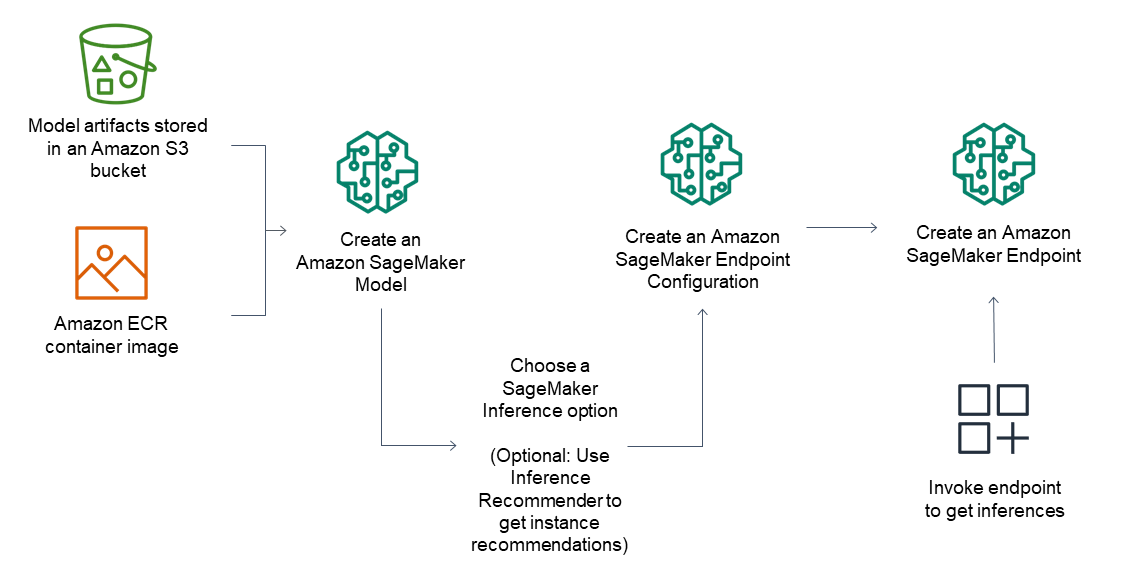

Pour les points de terminaison d'inférence, le flux de travail général se compose des opérations suivantes :

Créez un modèle dans SageMaker AI Inference en pointant vers des artefacts de modèle stockés dans Amazon S3 et une image de conteneur.

Sélectionnez une option d'inférence. Pour plus d’informations, consultez Options d’inférence dans Amazon SageMaker AI.

Créez une configuration de point de terminaison SageMaker AI Inference en choisissant le type d’instance et le nombre d’instances dont vous avez besoin derrière le point de terminaison. Vous pouvez utiliser Amazon SageMaker Inference Recommender pour obtenir des recommandations pour les types d'instances. Pour l'inférence sans serveur, il vous suffit de fournir la configuration de mémoire dont vous avez besoin en fonction de la taille de votre modèle.

Créez un point de terminaison SageMaker AI Inference.

Invoquez votre point de terminaison pour recevoir une inférence en tant que réponse.

Le schéma suivant illustre le flux de travail précédent.

Vous pouvez effectuer ces actions à l'aide de la console AWS, des kits AWS SDK, du kit SDK Python SageMaker, d'CloudFormation ou d'AWS CLI.

Pour l'inférence par lots avec transformation par lots, pointez sur les artefacts de votre modèle et les données d'entrée, puis créez une tâche d'inférence par lots. Au lieu d’héberger un point de terminaison pour l’inférence, SageMaker AI génère vos inférences dans l’emplacement Amazon S3 de votre choix.