Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Configuration des invites avancées

Vous pouvez configurer des invites avancées dans la AWS Management Console ou via l’API.

- Console

-

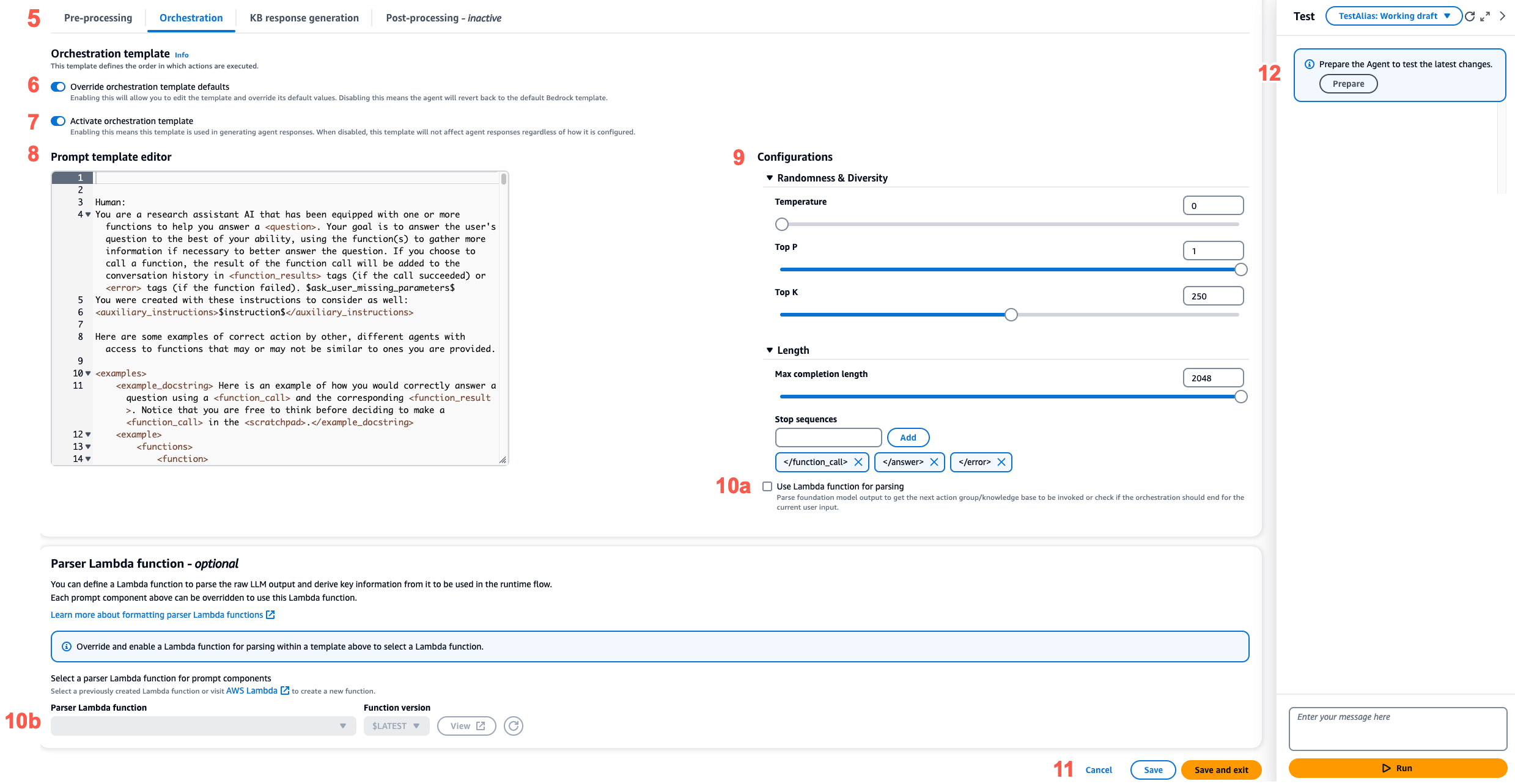

Dans la console, vous pouvez configurer des invites avancées après avoir créé l’agent. Vous les configurerez lors de la modification de l’agent.

Pour afficher ou modifier les invites avancées destinées à l’agent

-

Connectez-vous à la AWS Management Console avec une identité IAM autorisée à utiliser la console Amazon Bedrock. Ensuite, ouvrez la console Amazon Bedrock à l’adresse https://console.aws.amazon.com/bedrock

. -

Dans le panneau de navigation de gauche, choisissez Agents. Choisissez ensuite un agent dans la section Agents.

-

Sur la page des détails de l’agent, dans la section Version préliminaire, sélectionnez Version préliminaire.

-

Sur la page Version préliminaire, dans la section Stratégie d’orchestration, choisissez Modifier.

-

Sur la page Stratégie d’orchestration, dans la section Détails de la stratégie d’orchestration, assurez-vous que l’orchestration par défaut est sélectionnée, puis choisissez l’onglet correspondant à l’étape de la séquence d’agents que vous souhaitez modifier.

-

Pour permettre la modification du modèle, activez l’option Remplacer les paramètres par défaut du modèle. Dans la boîte de dialogue Remplacer les paramètres par défaut du modèle, choisissez Confirmer.

Avertissement

Si vous désactivez l’option Remplacer les paramètres par défaut du modèle ou si vous modifiez le modèle, le modèle Amazon Bedrock par défaut est utilisé, et votre modèle sera immédiatement supprimé. Entrez

confirmdans la zone de texte pour confirmer le message qui apparaît. -

Pour permettre à l’agent d’utiliser le modèle lors de la génération de réponses, activez l’option Activer le modèle. Si cette configuration est désactivée, l’agent n’utilisera pas le modèle.

-

Pour modifier l’exemple de modèle d’invite, utilisez l’éditeur de modèle d’invite.

-

Dans Configurations, vous pouvez modifier les paramètres d’inférence pour l’invite. Pour les définitions des paramètres et pour plus d’informations sur les paramètres des différents modèles, consultez Paramètres de demande d’inférence et champs de réponse pour les modèles de fondation.

-

(Facultatif) Afin d’utiliser une fonction Lambda que vous avez définie pour analyser la sortie brute du modèle de fondation, effectuez les actions suivantes :

Note

Une seule fonction Lambda est utilisée pour tous les modèles d’invite.

-

Dans la section Configurations, activez l’option Utiliser la fonction Lambda pour l’analyse. Si vous désactivez ce paramètre, l’agent utilisera l’analyseur par défaut pour l’invite.

-

Pour la Fonction Lambda d’analyseur, sélectionnez une fonction Lambda dans le menu déroulant.

Note

Vous devez associer les autorisations requises pour que l’agent puisse accéder à la fonction Lambda. Pour plus d’informations, consultez Politique basée sur les ressources permettant à Amazon Bedrock d’invoquer une fonction Lambda de groupe d’actions.

-

-

Pour enregistrer les paramètres, choisissez l’une des options suivantes :

-

Pour rester dans la même fenêtre afin de pouvoir mettre à jour de manière dynamique les paramètres de l’invite tout en testant votre agent mis à jour, choisissez Enregistrer.

-

Pour enregistrer vos paramètres et revenir à la page Version préliminaire, choisissez Enregistrer et quitter.

-

-

Pour tester les paramètres mis à jour, choisissez Préparer dans la fenêtre Test.

-

- API

-

Pour configurer des invites avancées en utilisant les opérations d’API, vous devez envoyer un appel UpdateAgent et modifier l’objet

promptOverrideConfigurationsuivant."promptOverrideConfiguration": { "overrideLambda": "string", "promptConfigurations": [ { "basePromptTemplate": "string", "inferenceConfiguration": { "maximumLength": int, "stopSequences": [ "string" ], "temperature": float, "topK": float, "topP": float }, "parserMode": "DEFAULT | OVERRIDDEN", "promptCreationMode": "DEFAULT | OVERRIDDEN", "promptState": "ENABLED | DISABLED", "promptType": "PRE_PROCESSING | ORCHESTRATION | KNOWLEDGE_BASE_RESPONSE_GENERATION | POST_PROCESSING | MEMORY_SUMMARIZATION" } ], promptCachingState: { cachingState: "ENABLED | DISABLED" } }-

Dans la liste

promptConfigurations, incluez un objetpromptConfigurationpour chaque modèle d’invite que vous souhaitez modifier. -

Spécifiez l’invite à modifier dans le champ

promptType. -

Modifiez le modèle d’invite en procédant comme suit :

-

Spécifiez les champs

basePromptTemplateavec votre modèle d’invite. -

Incluez des paramètres d’inférence dans les objets

inferenceConfiguration. Pour plus d’informations sur les configurations d’inférence, consultez Paramètres de demande d’inférence et champs de réponse pour les modèles de fondation.

-

-

Pour activer le modèle d’invite, définissez

promptCreationModesurOVERRIDDEN. -

Pour autoriser l’agent à effectuer l’étape indiquée dans le champ

promptTypeou pour l’en empêcher, modifiez la valeurpromptState. Ce paramètre peut être utile pour résoudre les problèmes de comportement de l’agent.-

Si vous définissez

promptStatesurDISABLEDpour les étapesPRE_PROCESSING,KNOWLEDGE_BASE_RESPONSE_GENERATIONouPOST_PROCESSING, cette étape est ignorée par l’agent. -

Si vous définissez

promptStatesurDISABLEDpour l’étapeORCHESTRATION, l’agent envoie uniquement les entrées utilisateur au modèle de fondation lors de l’orchestration. En outre, l’agent renvoie la réponse telle quelle sans orchestrer les appels entre les opérations d’API et les bases de connaissances. -

Par défaut, l’étape

POST_PROCESSINGestDISABLED. Par défaut, les étapesPRE_PROCESSING,ORCHESTRATIONetKNOWLEDGE_BASE_RESPONSE_GENERATIONsontENABLED. -

Par défaut, l’étape

MEMORY_SUMMARIZATIONestENABLEDsi la mémoire est activée et l’étapeMEMORY_SUMMARIZATIONestDISABLEDsi la mémoire est désactivée.

-

-

Pour utiliser une fonction Lambda que vous avez définie pour analyser la sortie brute du modèle de fondation, effectuez les étapes suivantes.

-

Pour chaque modèle d’invite pour lequel vous souhaitez activer la fonction Lambda, définissez la valeur

parserModesurOVERRIDDEN. -

Spécifiez l’Amazon Resource Name (ARN) de la fonction Lambda dans le champ

overrideLambdade l’objetpromptOverrideConfiguration.

-

-