Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Integración de servidores MCP

Si implementó el componente de servidor MCP opcional durante la implementación de la solución, puede integrar la solución de pruebas de carga distribuidas con herramientas de desarrollo de IA compatibles con el protocolo Model Context. El servidor MCP proporciona acceso programático para recuperar, gestionar y analizar las pruebas de carga mediante asistentes de IA.

Los clientes pueden conectarse al servidor MCP DLT mediante el cliente que elijan (Amazon Q, Claude, etc.), cada uno con instrucciones de configuración ligeramente diferentes. En esta sección se proporcionan instrucciones de configuración para MCP Inspector, Amazon Q CLI, Cline y Amazon Q Suite.

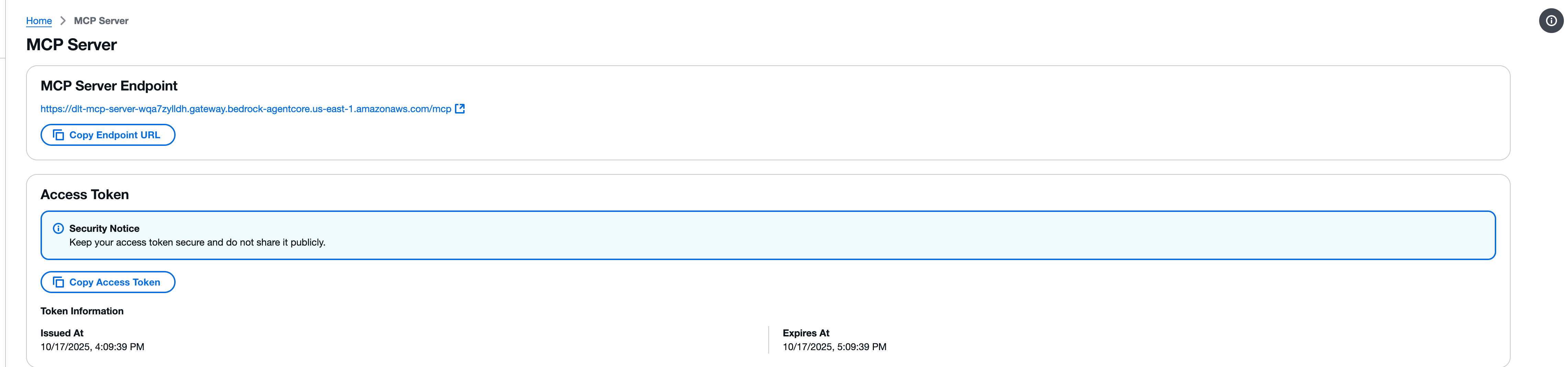

Paso 1: Obtenga el punto final y el token de acceso de MCP

Antes de configurar cualquier cliente MCP, debe recuperar el punto final del servidor MCP y el token de acceso de la consola web DLT.

-

Navegue a la página del servidor MCP en la consola web de pruebas de carga distribuidas.

-

Localice la sección Punto final del servidor MCP.

-

Copie la URL del punto final con el botón Copiar la URL del punto final. La URL del punto final tiene el siguiente formato:

https://{gateway-id}.gateway.bedrock-agentcore.{region}.amazonaws.com/mcp -

Localice la sección del token de acceso.

-

Copie el token de acceso con el botón Copiar el token de acceso.

importante

Mantén tu token de acceso seguro y no lo compartas públicamente. El token proporciona acceso de solo lectura a su solución de pruebas de carga distribuidas a través de la interfaz MCP.

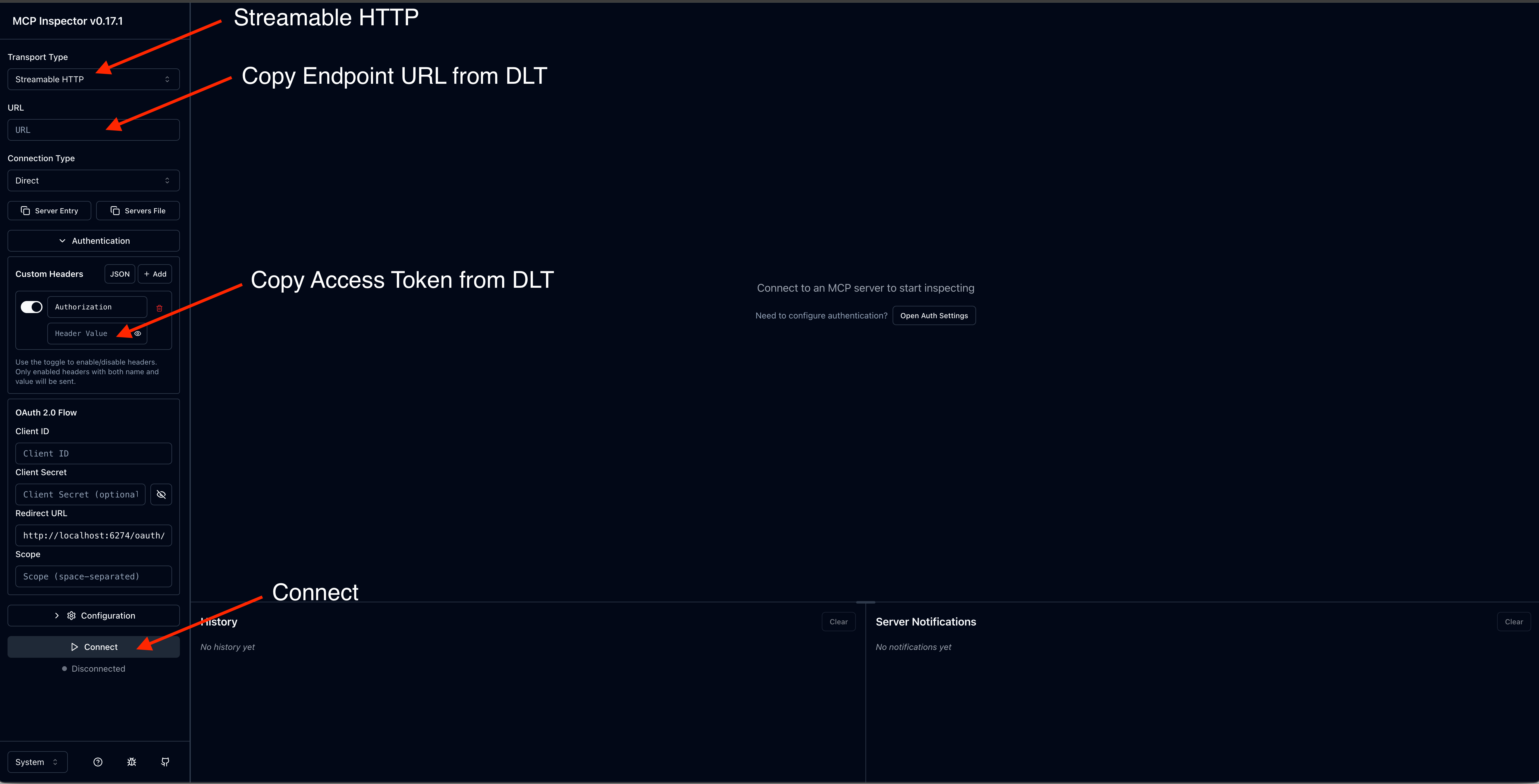

Paso 2: Probar con el Inspector MCP

El Model Context Protocol ofrece el Inspector MCP

nota

El Inspector MCP requiere la versión 0.17 o posterior. Todas las solicitudes también se pueden realizar directamente con JSON RPC, pero MCP Inspector proporciona una interfaz más fácil de usar.

Instalar e iniciar MCP Inspector

-

Instale npm si es necesario.

-

Ejecute el siguiente comando para iniciar el Inspector MCP:

npx @modelcontextprotocol/inspector

Configure la conexión

-

En la interfaz del Inspector MCP, introduzca la URL del punto final del servidor MCP.

-

Agregue un encabezado de autorización con su token de acceso.

-

Haga clic en Conectar para establecer la conexión.

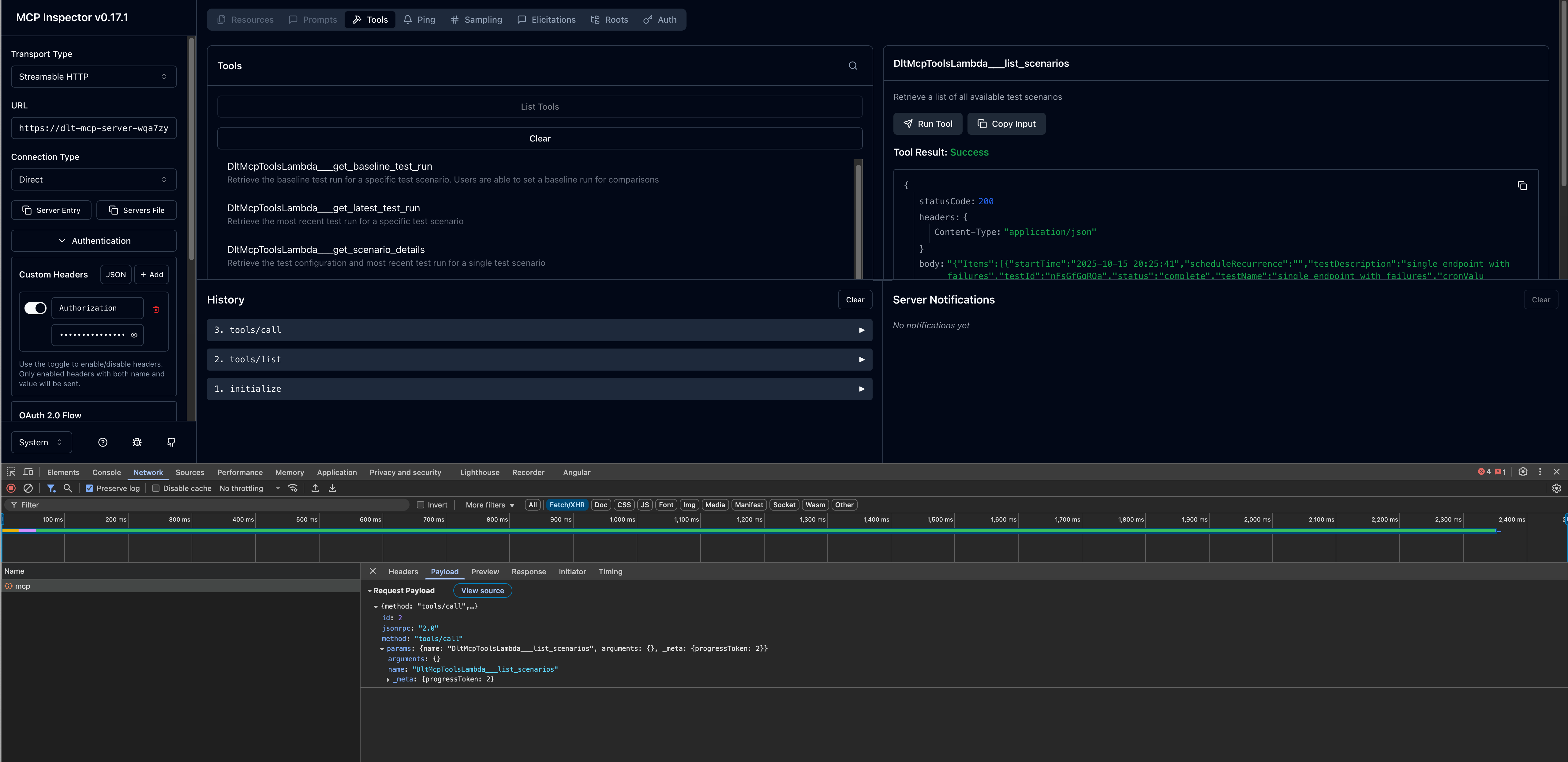

Invoca herramientas

Una vez conectado, puede probar las herramientas MCP disponibles:

-

Examine la lista de herramientas disponibles en el panel izquierdo.

-

Seleccione una herramienta (por ejemplo,

list_scenarios). -

Proporcione los parámetros necesarios.

-

Haga clic en Invocar para ejecutar la herramienta y ver la respuesta.

Paso 3: Configurar los clientes de desarrollo de IA

Después de verificar la conexión de su servidor MCP con el Inspector MCP, puede configurar su cliente de desarrollo de IA preferido.

CLI de Amazon Q

Amazon Q CLI proporciona acceso desde la línea de comandos al desarrollo asistido por IA con integración de servidores MCP.

Pasos de configuración

-

Edite el archivo de configuración

mcp.json. Para obtener más información sobre la ubicación del archivo de configuración, consulte Configuración de servidores MCP remotos en la Guía del usuario para desarrolladores de Amazon Q. -

Añada la configuración de su servidor MCP DLT:

{ "mcpServers": { "dlt-mcp": { "type": "http", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } }

Compruebe la configuración

-

En una terminal, escriba

qpara iniciar Amazon Q CLI. -

Escriba

/mcppara ver todos los servidores MCP disponibles. -

Escriba

/toolspara ver las herramientas disponibles proporcionadas pordlt-mcpy otros servidores MCP configurados. -

Compruebe que se inicializa

dlt-mcpcorrectamente.

Cline

Cline es un asistente de codificación de IA que admite la integración del servidor MCP.

Pasos de configuración

-

En Cline, vaya a Administrar servidores MCP > Configurar > Configurar servidores MCP.

-

Actualice el archivo

cline_mcp_settings.json:{ "mcpServers": { "dlt-mcp": { "type": "streamableHttp", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } } -

Guarde el archivo de configuración.

-

Reinicie Cline para aplicar los cambios.

Amazon Q Suite

Amazon Q Suite proporciona una plataforma integral de asistente de IA compatible con las acciones del servidor MCP.

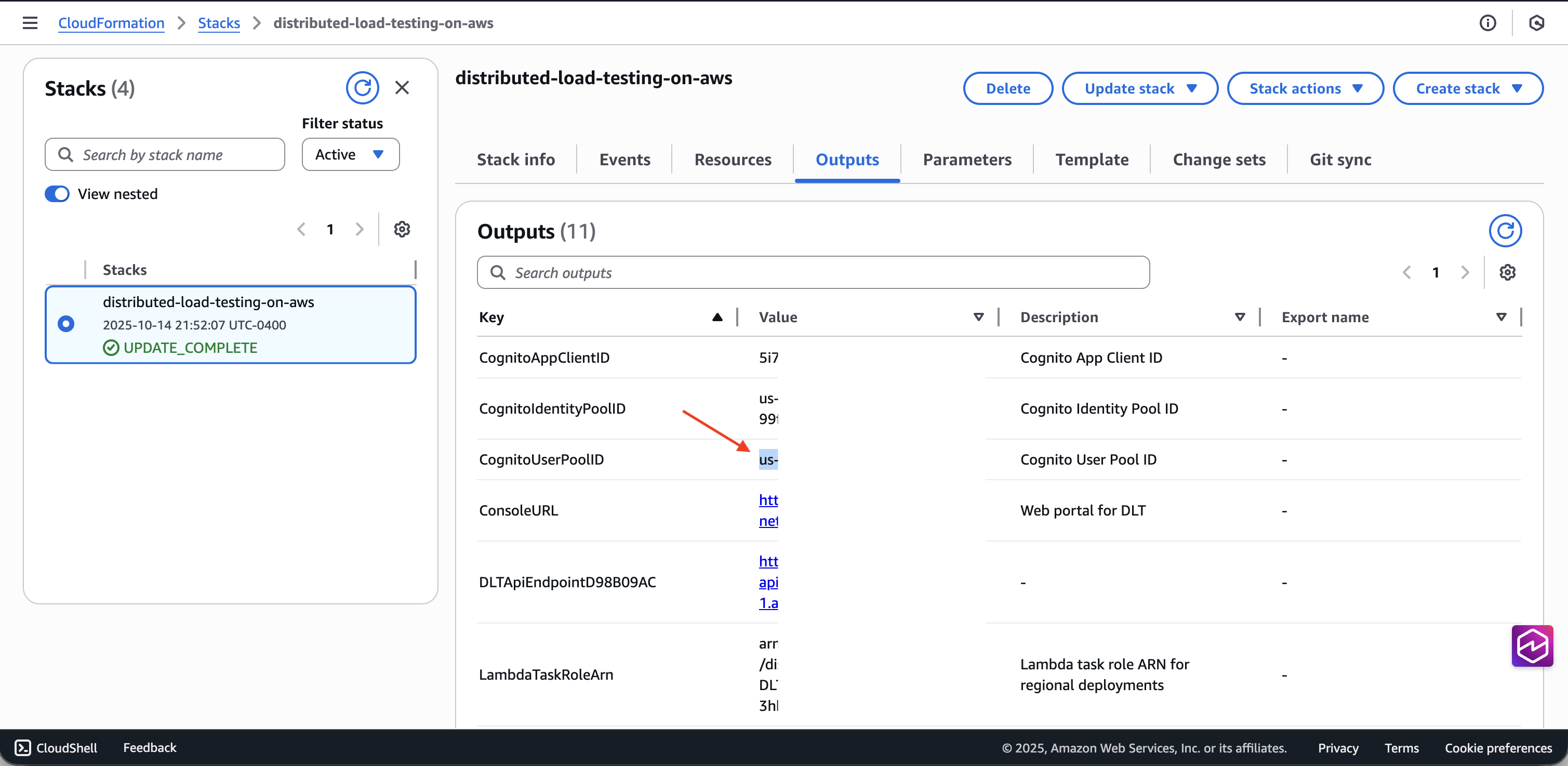

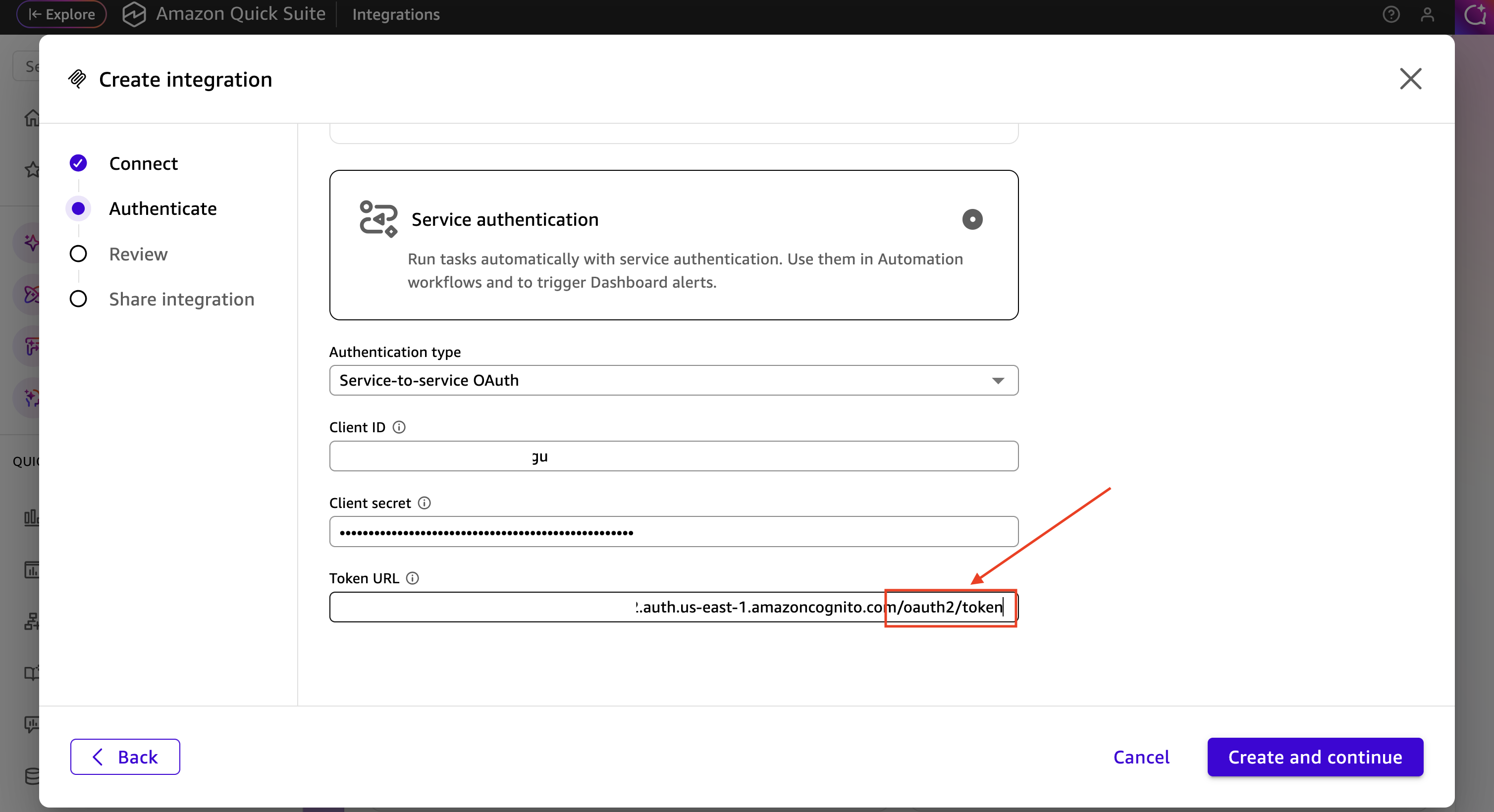

Requisitos previos

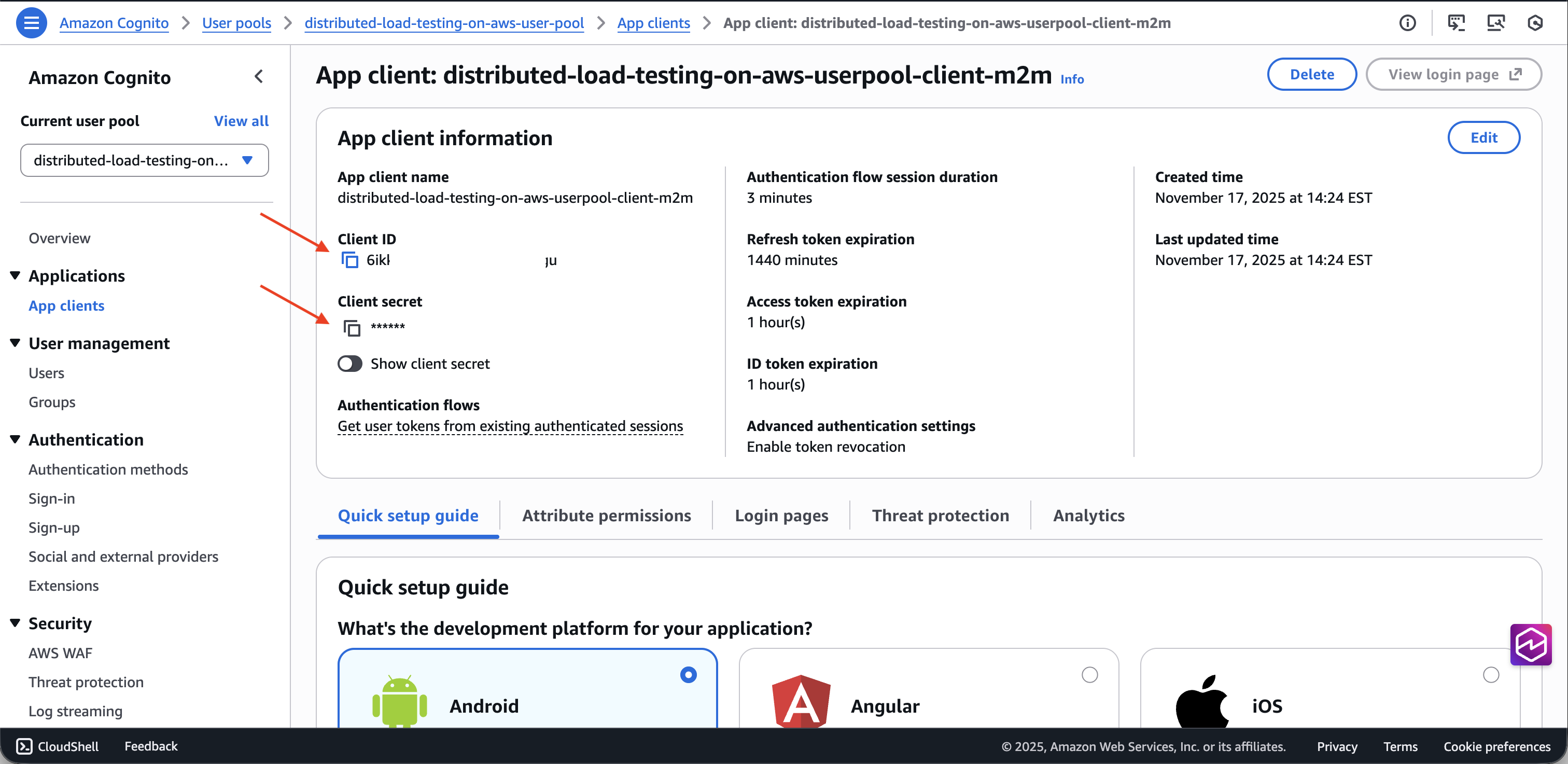

Antes de configurar el servidor MCP en Amazon Q Suite, debe recuperar OAuth las credenciales del grupo de usuarios de Cognito de la implementación de DLT:

-

Navegue hasta la CloudFormation consola de AWS

. -

Seleccione la pila de pruebas de carga distribuidas.

-

En la pestaña Salidas, localice y copie el ID del grupo de usuarios de Cognito asociado a su implementación de DLT.

-

Vaya a la consola de Amazon Cognito

. -

Seleccione el grupo de usuarios mediante el ID del grupo de usuarios de los CloudFormation resultados.

-

En el menú de navegación de la izquierda, selecciona Integración de aplicaciones > Clientes de aplicaciones.

-

Localice el cliente de la aplicación cuyo nombre termine en

m2m(machine-to-machine). -

Copie el ID del cliente y el secreto del cliente.

-

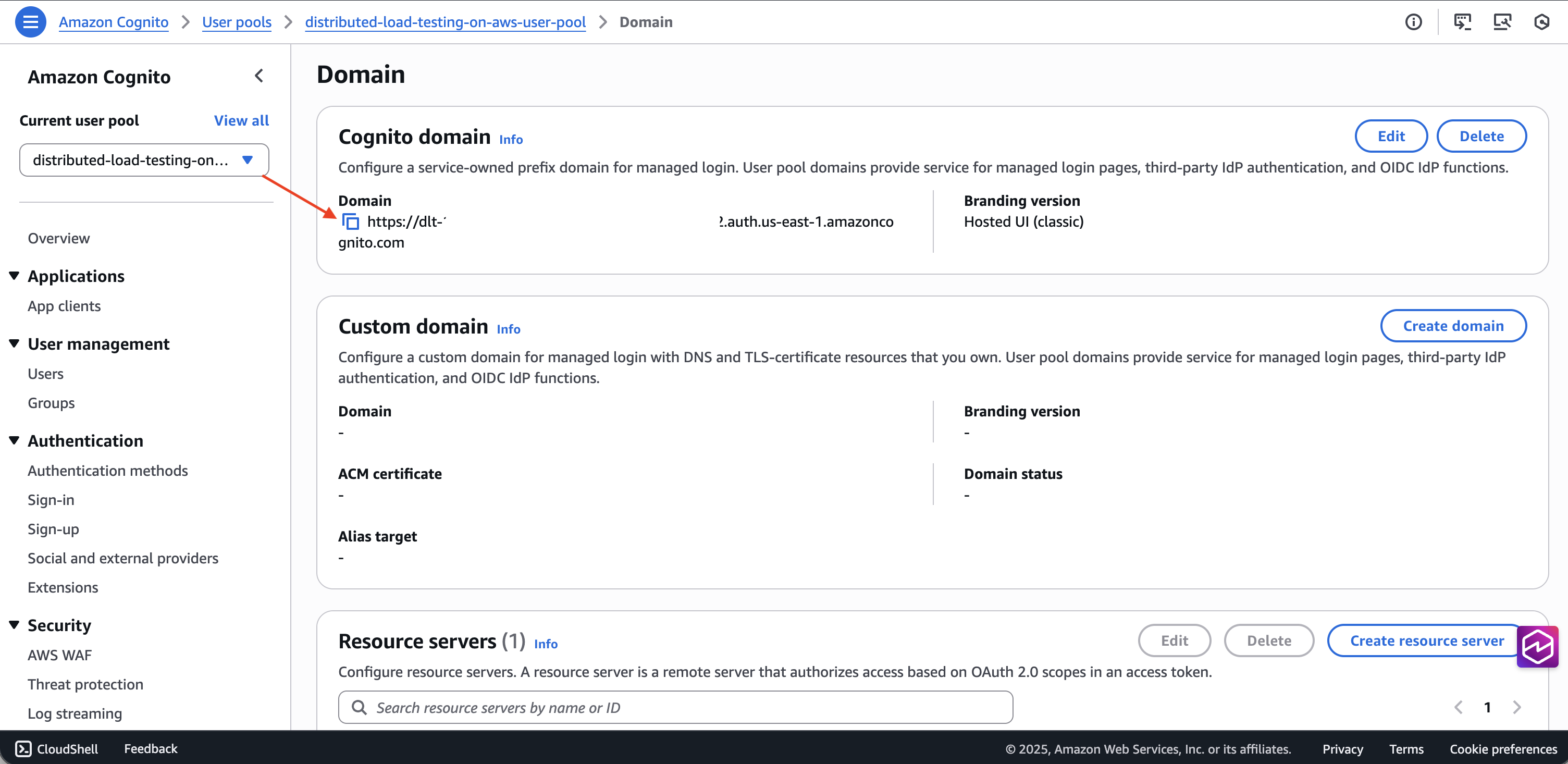

Obtenga el dominio del grupo de usuarios en la pestaña Dominio.

-

Cree la URL del punto final del token

/oauth2/tokenagregándola al final del dominio.

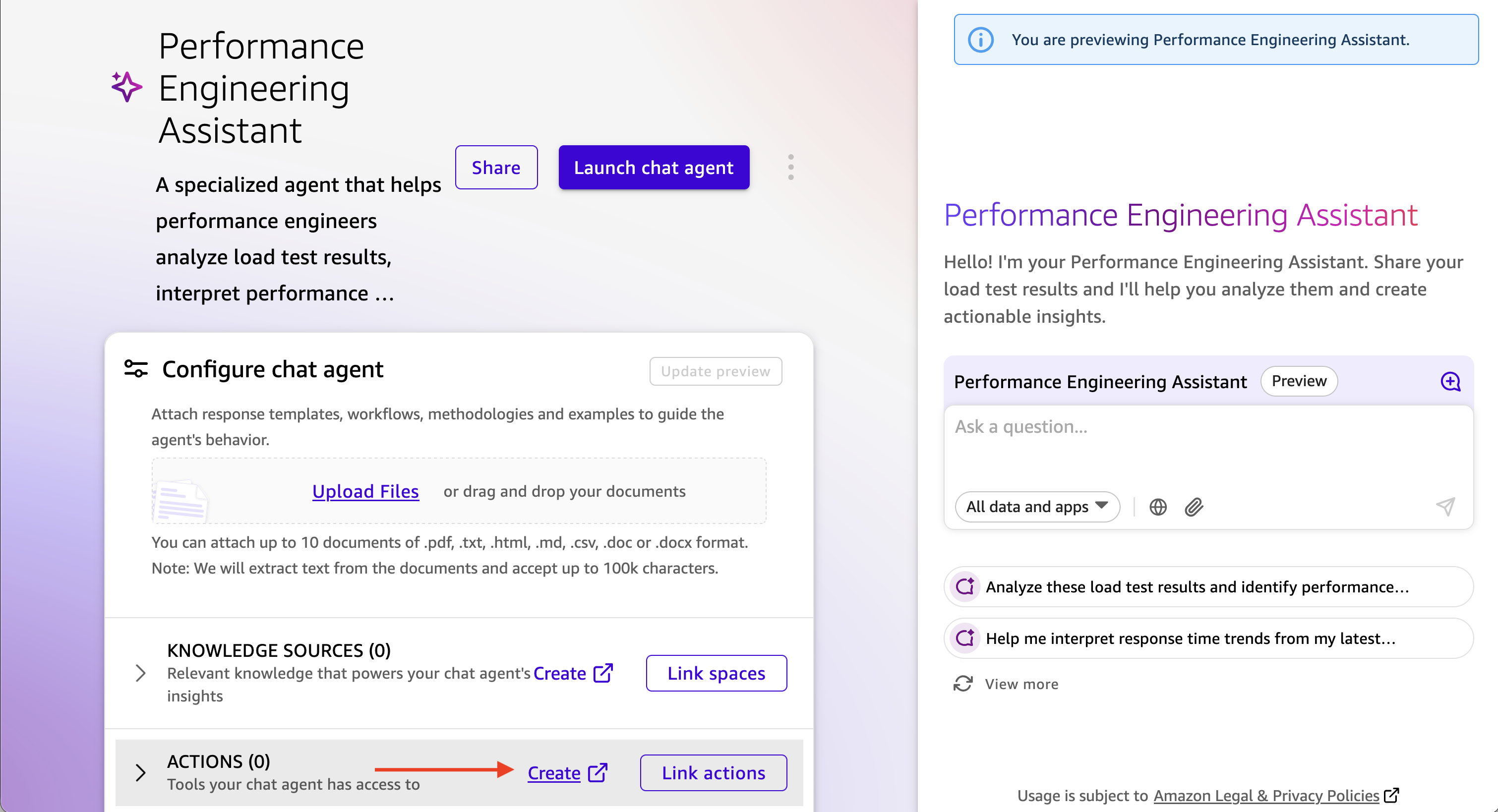

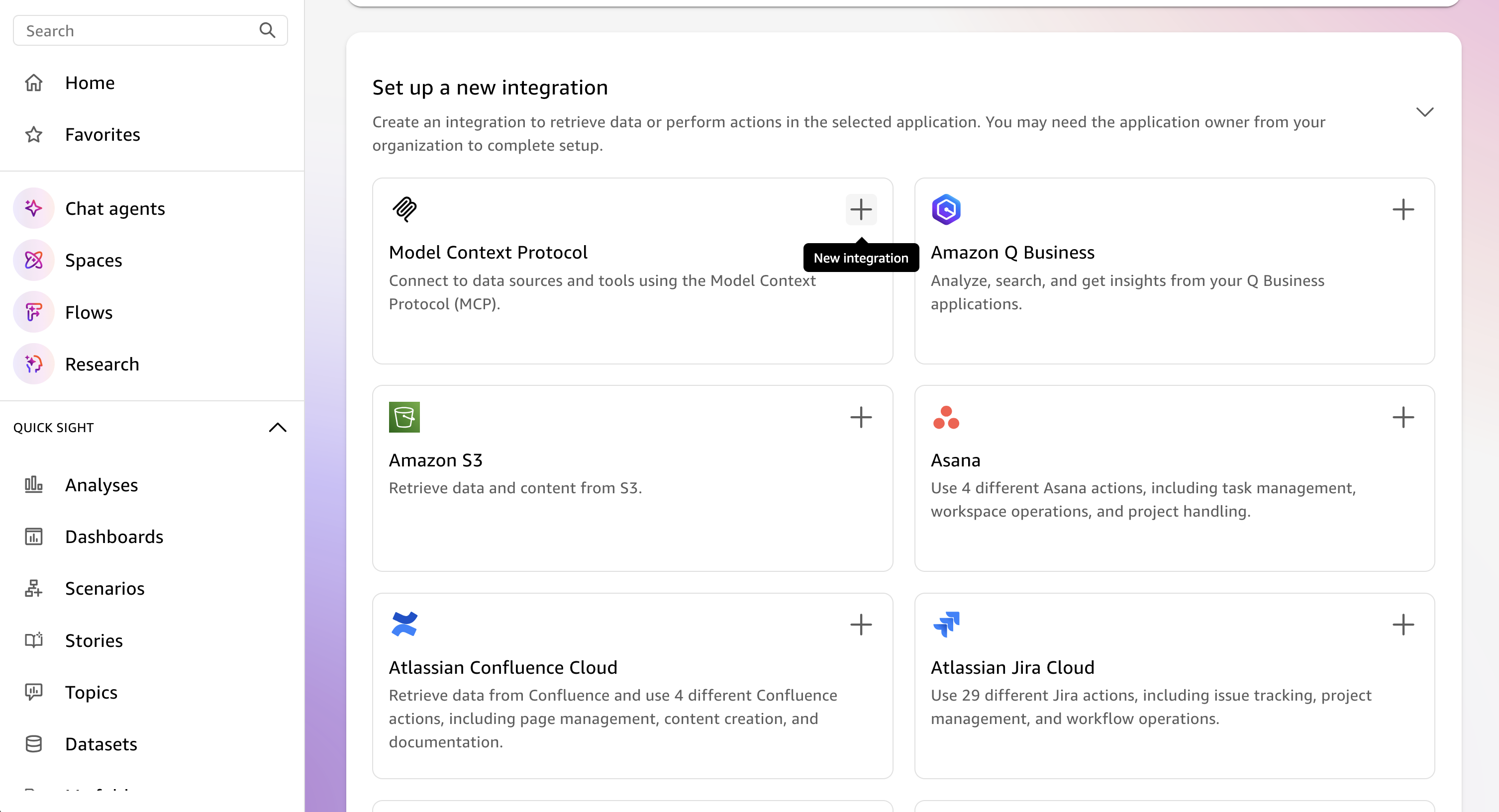

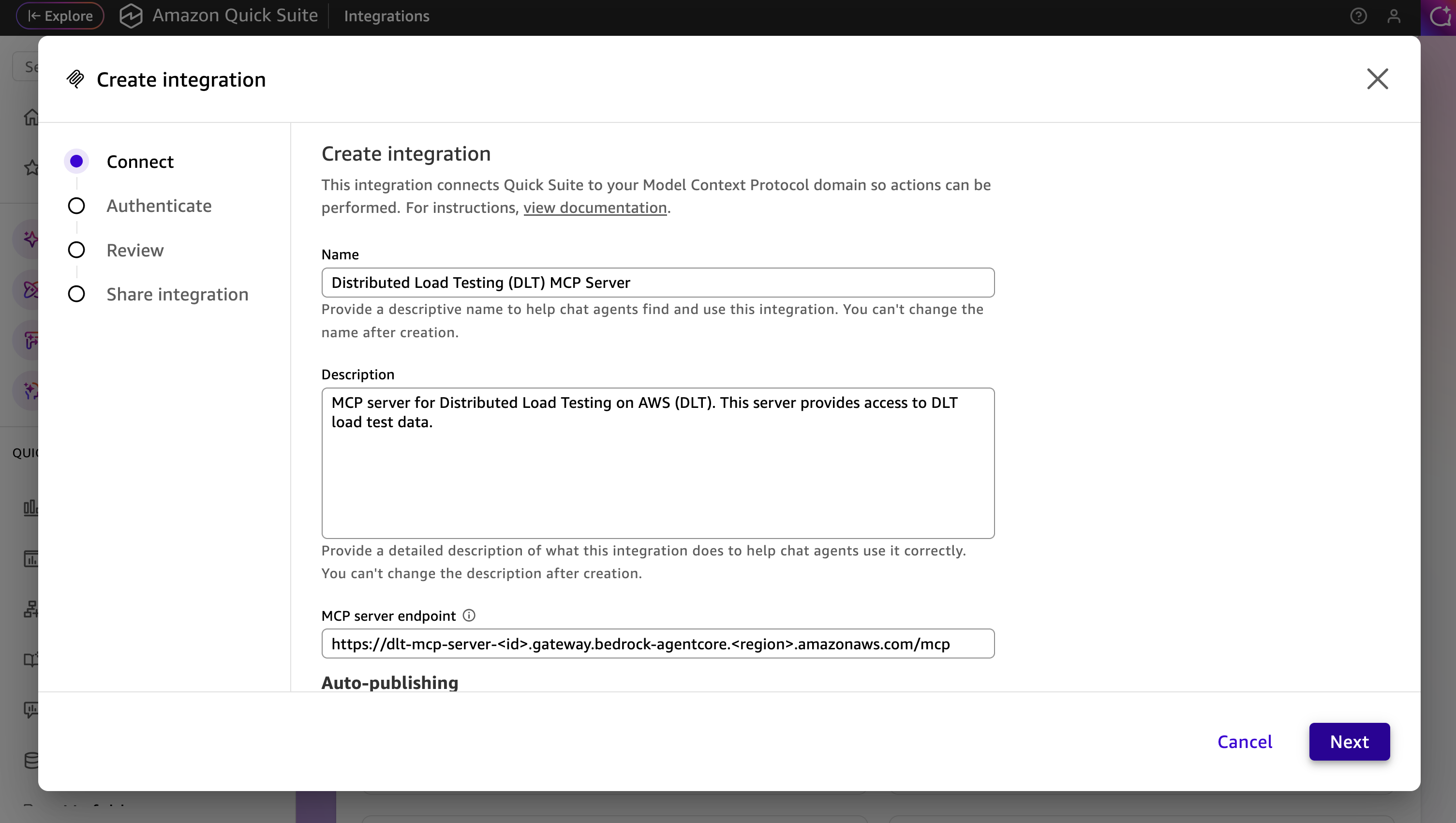

Pasos de configuración

-

En Amazon Q Suite, cree un agente nuevo o seleccione uno existente.

-

Agregue un mensaje de agente que describa cómo interactuar con el servidor MCP de DLT.

-

Agregue una nueva acción y seleccione la acción del servidor MCP.

-

Configure los detalles del servidor MCP:

-

URL del servidor MCP: su punto final MCP de DLT

-

Tipo de autenticación: autenticación basada en servicios

-

Token Endpoint: la URL de su punto final de token de Cognito

-

ID de cliente: el ID de cliente del cliente de la aplicación m2m

-

Secreto de cliente: el secreto de cliente del cliente de la aplicación m2m

-

-

Guarde la configuración de acciones del servidor MCP.

-

Añada la nueva acción del servidor MCP a su agente.

Inicie y pruebe el agente

-

Inicie el agente en Amazon Q Suite.

-

Inicie una conversación con el agente mediante instrucciones en lenguaje natural.

-

El agente utilizará las herramientas del MCP para recuperar y analizar los datos de las pruebas de carga.

Ejemplos de peticiones

Los siguientes ejemplos muestran cómo interactuar con su asistente de IA para analizar los datos de las pruebas de carga a través de la interfaz MCP. Personalice la prueba IDs, los intervalos de fechas y los criterios para que se ajusten a sus necesidades específicas de prueba.

Para obtener información detallada sobre las herramientas MCP disponibles y sus parámetros, consulte las especificaciones de las herramientas MCP en la Guía para desarrolladores.

Consulta sencilla de resultados de pruebas

La interacción en lenguaje natural con el servidor MCP puede ser tan simple Show me the load tests that have completed in the last 24 hours with their associated completion status o más descriptiva, como

Use list_scenarios to find my load tests. Then use get_latest_test_run to show me the basic execution data and performance metrics for the most recent test. If the results look concerning, also get the detailed performance metrics using get_test_run.

Análisis de rendimiento interactivo con divulgación progresiva

I need to analyze my load test performance, but I'm not sure which specific tests to focus on. Please help me by: 1. First, use list_scenarios to show me available test scenarios 2. Ask me which tests I want to analyze based on the list you show me 3. For my selected tests, use list_test_runs to get the test run history 4. Then use get_test_run with the test_run_id to get detailed response times, throughput, and error rates 5. If I want to compare tests, use get_baseline_test_run to compare against the baseline 6. If there are any issues, use get_test_run_artifacts to help me understand what went wrong Please guide me through this step by step, asking for clarification whenever you need more specific information.

Validación de la disponibilidad de producción

Help me validate if my API is ready for production deployment: 1. Use list_scenarios to find recent test scenarios 2. For the most recent test scenario, use get_latest_test_run to get basic execution data 3. Use get_test_run with that test_run_id to get detailed response times, error rates, and throughput 4. Use get_scenario_details with the test_id to show me what load patterns and endpoints were tested 5. If I have a baseline, use get_baseline_test_run to compare current results with the baseline 6. Provide a clear go/no-go recommendation based on the performance data 7. If there are any concerns, use get_test_run_artifacts to help identify potential issues My SLA requirements are: response time under [X]ms, error rate under [Y]%.

Análisis de tendencias de rendimiento

Analyze the performance trend for my load tests over the past [TIME_PERIOD]: 1. Use list_scenarios to get all test scenarios 2. For each scenario, use list_test_runs with start_date and end_date to get tests from that period 3. Use get_test_run for the key test runs to get detailed metrics 4. Use get_baseline_test_run to compare against the baseline 5. Identify any significant changes in response times, error rates, or throughput 6. If you detect performance degradation, use get_test_run_artifacts on the problematic tests to help identify causes 7. Present the trend analysis in a clear format showing whether performance is improving, stable, or degrading Focus on completed tests and limit results to [N] tests if there are too many.

Solución de problemas de pruebas falli

Help me troubleshoot my failed load tests: 1. Use list_scenarios to find test scenarios 2. For each scenario, use list_test_runs to find recent test runs 3. Use get_test_run with the test_run_id to get the basic execution data and failure information 4. Use get_test_run_artifacts to get detailed error messages and logs 5. Use get_scenario_details to understand what was being tested when it failed 6. If I have a similar test that passed, use get_baseline_test_run to identify differences 7. Summarize the causes of failure and suggest next steps for resolution Show me the most recent [N] failed tests from the past [TIME_PERIOD].