Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Migración de datos de Microsoft Azure Blob a Amazon S3 mediante Rclone

Suhas Basavaraj, Aidan Keane y Corey Lane, de Amazon Web Services

Resumen

Este patrón describe cómo usar Rclone

Requisitos previos y limitaciones

Requisitos previos

Una cuenta de AWS activa

Datos almacenados en el servicio de contenedor Blob de Azure

Arquitectura

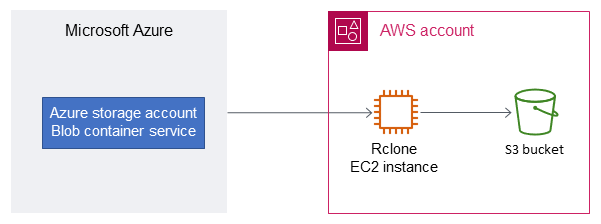

Pila de tecnología de origen

Contenedor de almacenamiento Blob de Azure

Pila de tecnología de destino

Bucket de Amazon S3

Instancia de Amazon Elastic Compute Cloud (Amazon EC2) Linux

Arquitectura

Herramientas

Amazon Simple Storage Service (Amazon S3) es un servicio de almacenamiento de objetos basado en la nube que le ayuda a almacenar, proteger y recuperar cualquier cantidad de datos.

Rclone

es un programa de línea de comandos de código abierto inspirado en rsync. Se usa para administrar archivos en numerosas plataformas de almacenamiento en la nube.

Prácticas recomendadas

Al migrar datos de Azure a Amazon S3, tenga en cuenta estas consideraciones para evitar costos innecesarios o lentitud en la velocidad de transferencia:

Cree su infraestructura de AWS en la misma región geográfica que la cuenta de almacenamiento de Azure y el contenedor Blob, por ejemplo, en la región de AWS

us-east-1(Virginia del Norte) y la región de AzureEast US.Evite usar puerta de enlace NAT si es posible, ya que genera tarifas de transferencia de datos tanto para el ancho de banda de entrada como para el de salida.

Use un punto de conexión de puerta de enlace VPC para Amazon S3 a fin de aumentar el rendimiento.

Considere la posibilidad de utilizar una EC2 instancia basada en el procesador AWS Graviton2 (ARM) para reducir el coste y aumentar el rendimiento en comparación con las instancias x86 de Intel. Rclone presenta compilación cruzada y proporciona un binario ARM precompilado.

Epics

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Prepare un bucket de S3 de destino. | Cree un nuevo bucket de S3 en la región de AWS correspondiente, o bien elija un bucket existente como destino de los datos que desee migrar. | Administrador de AWS |

Crea un rol de instancia de IAM para Amazon EC2. | Cree un nuevo rol de AWS Identity and Access Management (IAM) para Amazon EC2. Esta función le da a la EC2 instancia acceso de escritura al bucket S3 de destino. | Administrador de AWS |

Adjunte una política al rol de la instancia de IAM. | Utilice la consola de IAM o la interfaz de línea de comandos de AWS (AWS CLI) para crear una política en línea para EC2 el rol de instancia que permita permisos de acceso de escritura al bucket de S3 de destino. Para un ejemplo de política, consulte la sección Información adicional. | Administrador de AWS |

Lance una instancia EC2 . | Lance una EC2 instancia de Amazon Linux configurada para usar el rol de servicio de IAM recién creado. Esta instancia también necesitará acceder a los puntos de conexión de la API pública de Azure a través de Internet. notaConsidere la posibilidad de utilizar EC2 instancias basadas en AWS Graviton para reducir los costos. Rclone proporciona binarios compilados en ARM. | Administrador de AWS |

Cree una entidad principal de servicio de Azure AD. | Use la CLI de Azure para crear una entidad principal de servicio de Azure Active Directory (Azure AD) con acceso de solo lectura al contenedor de almacenamiento Blob de Azure de origen. Para obtener instrucciones, consulte la sección Información adicional. Guarde estas credenciales en la EC2 instancia en la ubicación. | Administrador de la nube, Azure |

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Descargar e instalar Rclone. | Descargue e instale el programa de línea de comandos Rclone. Para instrucciones sobre la instalación, consulte la documentación de instalación de Rclone | AWS general, administrador de la nube |

Configure Rclone. | Copie el siguiente archivo de ejemplo

| AWS general, administrador de la nube |

Verifique la configuración de Rclone. | Para confirmar que Rclone está configurado y que los permisos funcionan correctamente, compruebe que Rclone puede analizar el archivo de configuración y que los objetos del contenedor Blob de Azure y del bucket de S3 sean accesibles. Consulte a continuación algunos ejemplos de comandos de validación.

| AWS general, administrador de la nube |

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Migre los datos de sus contenedores. | Ejecute los comandos de Rclone copy Ejemplo: copy Este comando copia datos del contenedor Blob de Azure de origen al bucket de S3 de destino.

Ejemplo: sync Este comando sincroniza los datos entre el contenedor Blob de Azure de origen y el bucket de S3 de destino.

importanteAl usar el comando sync, los datos que no estén presentes en el contenedor de origen se eliminarán del depósito de S3 de destino. | AWS general, administrador de la nube |

Sincronice sus contenedores. | Una vez completada la copia inicial, ejecute el comando de Rclone sync para continuar con la migración. Solo se copiarán los archivos nuevos que no estén ya en el bucket de S3 de destino. | AWS general, administrador de la nube |

Compruebe que los datos se hayan migrado correctamente. | Para comprobar que los datos se han copiado correctamente en el bucket de S3 de destino, ejecute los comandos lsd | AWS general, administrador de la nube |

Recursos relacionados

Guía del usuario de Amazon S3 (documentación de AWS)

Funciones de IAM para Amazon EC2 (documentación de AWS)

Creación de un contenedor Blob de Microsoft Azure

(documentación de Microsoft Azure) Comandos de Rclone

(documentación de Rclone)

Información adicional

Ejemplo de política de roles para instancias EC2

Esta política otorga a tu EC2 instancia acceso de lectura y escritura a un segmento específico de tu cuenta. Si este bucket usa una clave administrada por el cliente para realizar el cifrado en el servidor, es posible que la política necesite obtener acceso adicional a AWS Key Management Service (AWS KMS).

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:ListBucket", "s3:DeleteObject", "s3:GetObject", "s3:PutObject", "s3:PutObjectAcl" ], "Resource": [ "arn:aws:s3:::amzn-s3-demo-bucket/*", "arn:aws:s3:::amzn-s3-demo-bucket" ] }, { "Effect": "Allow", "Action": "s3:ListAllMyBuckets", "Resource": "arn:aws:s3:::*" } ] }

Crear una entidad principal de servicio de Azure AD de solo lectura

Una entidad principal de servicio de Azure es una identidad de seguridad que usan las aplicaciones, los servicios y las herramientas de automatización de los clientes para acceder a recursos específicos de Azure. Considérelo como una identidad de usuario (nombre de usuario y contraseña o certificado) con un rol específico, y con permisos estrictamente controlados para acceder a sus recursos. Para crear una entidad principal de servicio de solo lectura, con permisos de privilegio mínimo, y proteger los datos de Azure ante eliminaciones accidentales, siga estos pasos:

Inicia sesión en el portal de tu cuenta en la nube de Microsoft Azure e inicia Cloud Shell PowerShell o usa la interfaz de línea de comandos (CLI) de Azure en tu estación de trabajo.

Cree una entidad principal de servicio y configúrela con acceso de solo lectura

a su cuenta de almacenamiento Blob de Azure. Guarde la salida JSON de este comando en un archivo local llamado azure-principal.json. El archivo se cargará en tu instancia. EC2 Sustituya las variables de marcador de posición que aparecen entre corchetes ({y}) por el identificador de suscripción de Azure, el nombre del grupo de recursos y el nombre de la cuenta de almacenamiento.az ad sp create-for-rbac ` --name AWS-Rclone-Reader ` --role "Storage Blob Data Reader" ` --scopes /subscriptions/{Subscription ID}/resourceGroups/{Resource Group Name}/providers/Microsoft.Storage/storageAccounts/{Storage Account Name}