Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Agentes de IA generativa: sustituyendo la lógica simbólica por LLMs

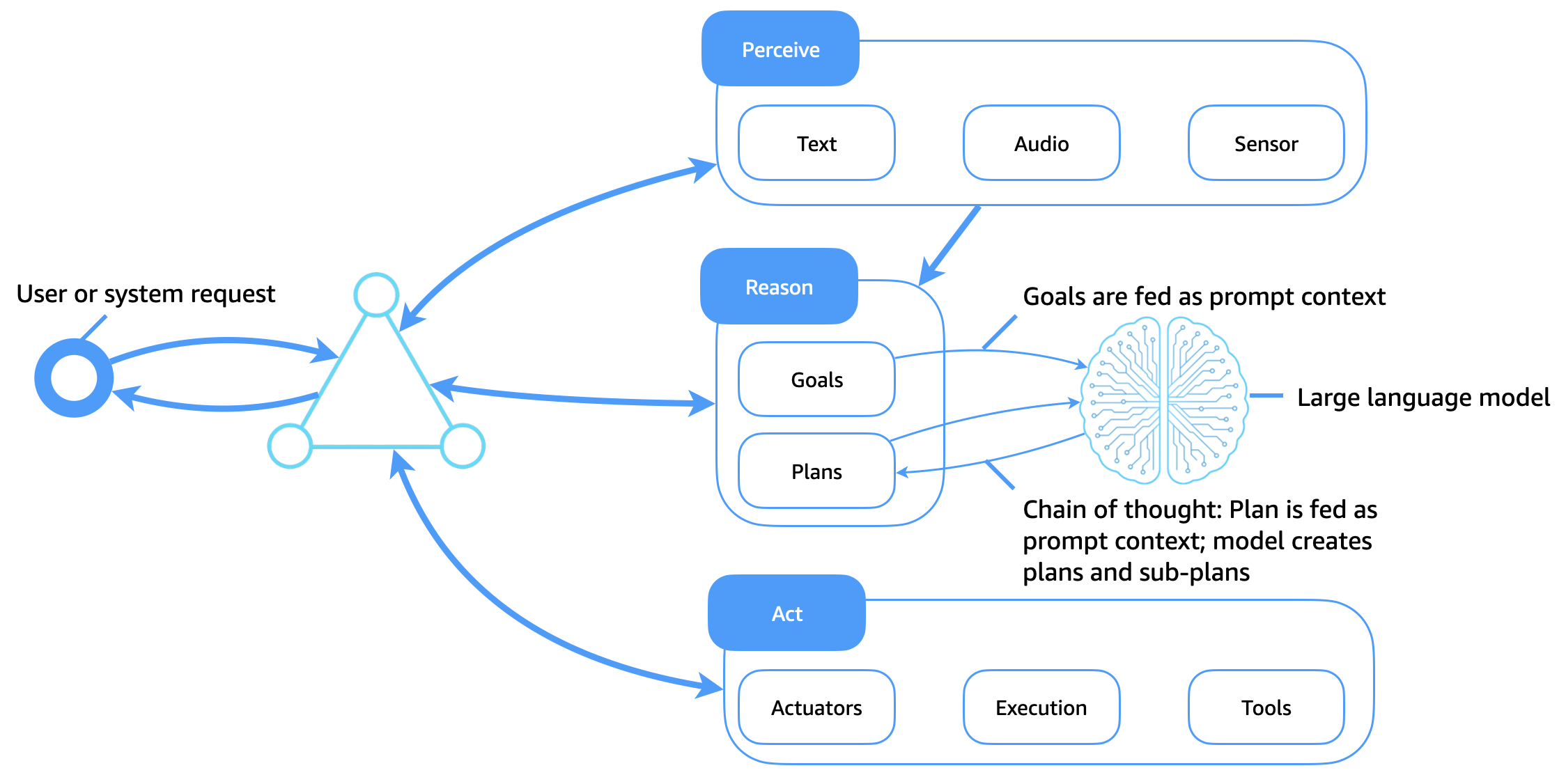

El siguiente diagrama ilustra cómo los modelos de lenguaje grandes (LLMs) sirven ahora como un núcleo cognitivo flexible e inteligente para los agentes de software. A diferencia de los sistemas lógicos simbólicos tradicionales, que se basan en bibliotecas de planes estáticos y reglas codificadas a mano, LLMs permiten el razonamiento adaptativo, la planificación contextual y el uso dinámico de herramientas, lo que transforma la forma en que los agentes perciben, razonan y actúan.

Mejoras clave

Esta arquitectura mejora la arquitectura de agentes tradicional de la siguiente manera:

-

LLMs como motores cognitivos: las metas, los planes y las consultas se transfieren al modelo como un contexto rápido. El LLM genera vías de razonamiento (como una cadena de pensamiento), descompone las tareas en subobjetivos y decide las próximas acciones.

-

Uso de herramientas mediante indicaciones: se LLMs puede dirigir mediante agentes de uso de herramientas o mediante el razonamiento y la actuación (ReAct) para solicitar llamadas APIs y buscar, consultar, calcular e interpretar los resultados.

-

Planificación basada en el contexto: los agentes generan o revisan los planes de forma dinámica en función del objetivo actual del agente, el entorno de entrada y los comentarios, sin necesidad de bibliotecas de planes codificadas.

-

El contexto rápido como memoria: en lugar de utilizar bases de conocimiento simbólicas, los agentes codifican la memoria, los planes y los objetivos como símbolos rápidos que se transmiten al modelo.

-

Aprender mediante un aprendizaje breve y contextualizado: LLMs adapte los comportamientos mediante una ingeniería rápida, lo que reduce la necesidad de readiestramiento explícito o de bibliotecas de planes rígidas.

Lograr memoria a largo plazo en los agentes basados en LLM

A diferencia de los agentes tradicionales, que almacenaban la memoria a largo plazo en bases de conocimiento estructuradas, los agentes de IA generativa deben trabajar dentro de las limitaciones de la ventana de contexto de. LLMs Para ampliar la memoria y fomentar la inteligencia persistente, los agentes de IA generativa utilizan varias técnicas complementarias: el almacenamiento de agentes, la generación con recuperación aumentada (RAG), el aprendizaje contextual y el encadenamiento rápido, y la formación previa.

Almacén de agentes: memoria externa a largo plazo

El estado del agente, el historial del usuario, las decisiones y los resultados se almacenan en un almacén de memoria de agente a largo plazo (como una base de datos vectorial, un almacén de objetos o un almacén de documentos). Las memorias relevantes se recuperan a pedido y se insertan en el contexto de los mensajes de LLM durante el tiempo de ejecución. Esto crea un bucle de memoria persistente, en el que el agente conserva la continuidad entre sesiones, tareas o interacciones.

TRAPO

RAG mejora el rendimiento de la LLM al combinar el conocimiento recuperado con las capacidades generativas. Cuando se establece un objetivo o una consulta, el agente busca en un índice de recuperación (por ejemplo, mediante una búsqueda semántica de documentos, conversaciones anteriores o conocimiento estructurado). Los resultados recuperados se adjuntan a la solicitud de LLM, lo que basa la generación en hechos externos o en un contexto personalizado. Este método amplía la memoria efectiva del agente y mejora la confiabilidad y la exactitud de los hechos.

Aprendizaje contextual y encadenamiento rápido

Los agentes mantienen la memoria a corto plazo utilizando el contexto simbólico de la sesión y el encadenamiento rápido estructurado. Los elementos contextuales, como el plan actual, los resultados de las acciones anteriores y el estado del agente, se transmiten entre llamadas para guiar el comportamiento.

Capacitación previa y ajustes continuos

En el caso de los agentes de dominios específicos, se LLMs les puede seguir capacitando previamente sobre recopilaciones personalizadas, como registros, datos empresariales o documentación de productos. Como alternativa, el ajuste de las instrucciones o el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) pueden incorporar un comportamiento similar al de los agentes directamente en el modelo. Esto hace que los patrones de razonamiento pasen de la lógica del tiempo de respuesta a la representación interna del modelo, reduce la longitud de las indicaciones y mejora la eficiencia.

Beneficios combinados de la IA de los agentes

Estas técnicas, cuando se utilizan juntas, permiten a los agentes de IA generativa:

-

Mantenga el conocimiento contextual a lo largo del tiempo.

-

Adapte el comportamiento en función del historial o las preferencias del usuario.

-

Tome decisiones utilizando up-to-date conocimientos fácticos o privados.

-

Amplíese a los casos de uso empresarial con comportamientos persistentes, conformes y explicables.

Al aprovechar la LLMs memoria externa, las capas de recuperación y la formación continua, los agentes pueden alcanzar un nivel de continuidad cognitiva y un propósito que antes no podían lograr únicamente con sistemas simbólicos.