Aviso de fin del soporte: el 15 de diciembre de 2025, AWS finalizará el soporte para AWS IoT Analytics. Después del 15 de diciembre de 2025, ya no podrás acceder a la AWS IoT Analytics consola ni a AWS IoT Analytics los recursos. Para obtener más información, consulta AWS IoT Analytics el fin del soporte.

Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Paso 1: Redirigir la ingesta de datos en curso

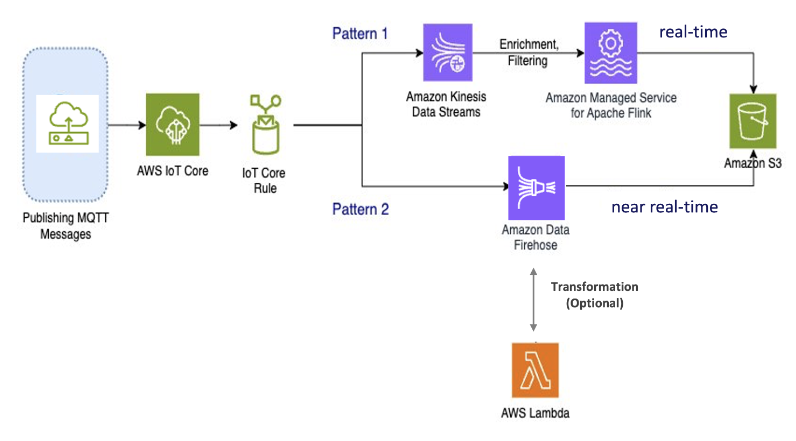

El primer paso de la migración es redirigir la ingesta de datos en curso a un nuevo servicio. Recomendamos dos patrones en función de su caso de uso específico:

Patrón 1: Amazon Kinesis Data Streams con Amazon Managed Service para Apache Flink

En este patrón, comienza publicando datos AWS IoT Core que se integran con Amazon Kinesis Data Streams, lo que le permite recopilar, procesar y analizar un gran ancho de banda de datos en tiempo real.

Métricas y análisis

-

Ingesta de datos: AWS IoT los datos se ingieren en Amazon Kinesis Data Streams en tiempo real. Amazon Kinesis Data Streams puede gestionar un alto rendimiento de datos de millones AWS IoT de dispositivos, lo que permite realizar análisis en tiempo real y detectar anomalías.

-

Procesar datos: utilice Amazon Managed Service para Apache Flink para procesar, enriquecer y filtrar los datos de Amazon Kinesis Data Streams. Flink ofrece funciones sólidas para el procesamiento de eventos complejos, como agregaciones, uniones y operaciones temporales.

-

Almacenar datos: Flink envía los datos procesados a Amazon S3 para su almacenamiento y posterior análisis. Luego, estos datos se pueden consultar con Amazon Athena o integrarse con AWS otros servicios de análisis.

Utilice este patrón si su aplicación utiliza datos de streaming de gran ancho de banda y requiere un procesamiento avanzado, como la coincidencia de patrones o la creación de ventanas. Este patrón es el más adecuado.

Patrón 2: Usa Amazon Data Firehose

En este patrón, los datos se publican en AWS IoT Core, que se integra con Amazon Data Firehose, lo que le permite almacenar datos directamente en Amazon S3. Este patrón también admite el uso AWS Lambda de transformaciones básicas.

Métricas y análisis

-

Ingesta de datos: AWS IoT los datos se ingieren directamente desde sus dispositivos o en AWS IoT Core Amazon Data Firehose.

-

Procesar datos: Amazon Data Firehose realiza transformaciones y procesamientos básicos de los datos, como la conversión y el enriquecimiento de formatos. Puede habilitar la transformación de datos de Firehose configurándola para que invoque AWS Lambda funciones que transformen los datos de origen entrantes antes de entregarlos a los destinos.

-

Datos de almacenamiento: los datos procesados se envían a Amazon S3 prácticamente en tiempo real. Amazon Data Firehose se escala automáticamente para adaptarse al rendimiento de los datos entrantes, lo que garantiza una entrega de datos fiable y eficiente.

Utilice este patrón para las cargas de trabajo que necesitan transformaciones y procesamiento básicos. Además, Amazon Data Firehose simplifica el proceso al ofrecer funciones de almacenamiento en búfer de datos y particionamiento dinámico para los datos almacenados en Amazon S3.