Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Uso del agente de actualización

Modos de implementación compatibles

El agente de actualización de Apache Spark para Amazon EMR admite los dos modos de implementación siguientes para la experiencia de actualización de aplicaciones de end-to-end Spark, que incluyen la actualización de archivos de compilación, la script/dependency actualización, la prueba y validación locales con el clúster de EMR de destino o la aplicación EMR sin servidor, y la validación de la calidad de los datos.

-

EMR activado EC2

-

EMR sin servidor

Consulte Características y capacidades para comprender las características, capacidades y limitaciones detalladas.

Interfaces compatibles

Integración con Amazon SageMaker Unified Studio VS Code Editor Spaces

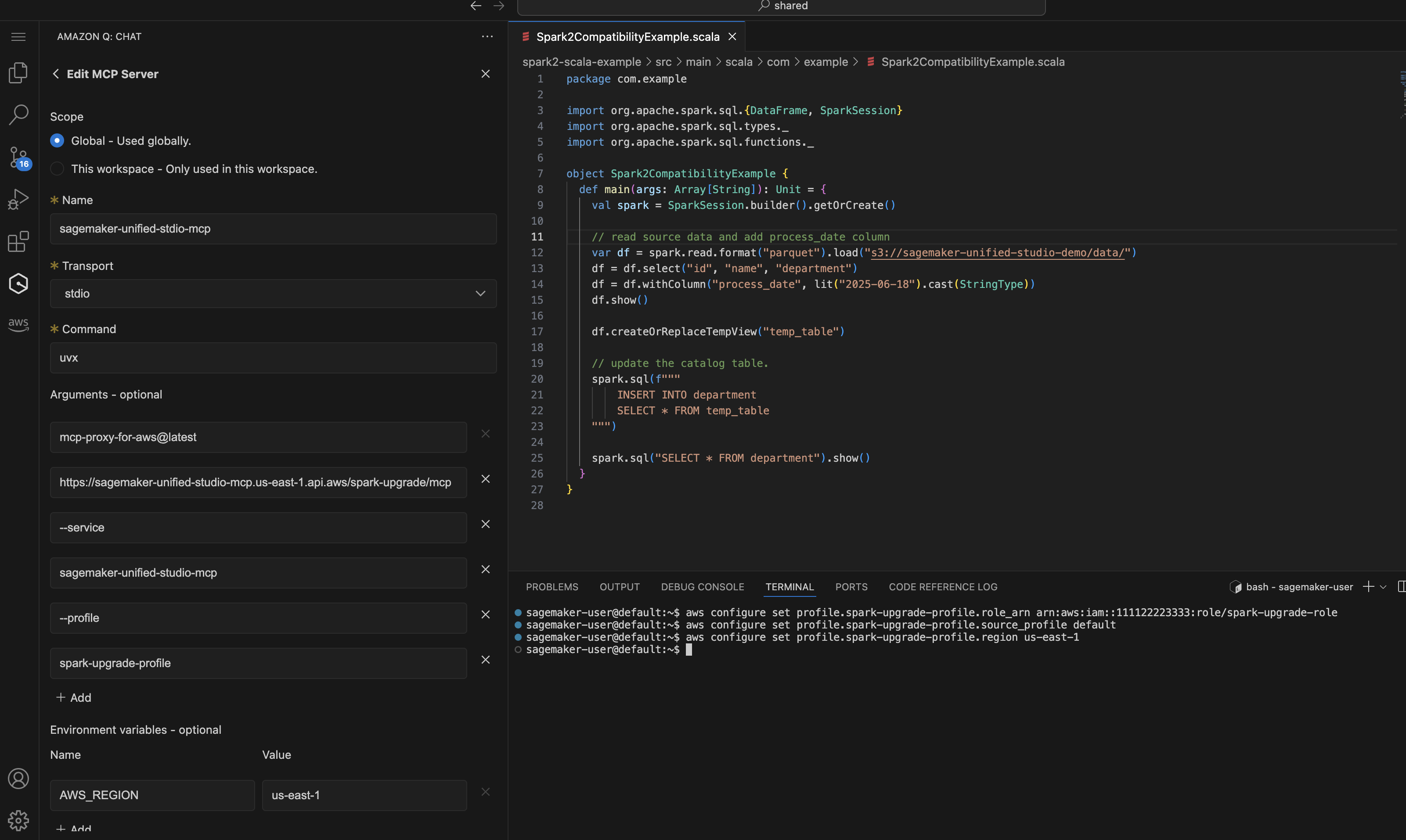

En Amazon SageMaker Unified Studio VS Code Editor Spaces, puede configurar el perfil de IAM y la configuración de MCP tal como se describe en la configuración del agente de actualización simplemente siguiendo la siguiente captura de pantalla:

Una demostración del EMR sobre la experiencia de EC2 actualización con el editor de código SMUS VS. Comienza con un sencillo mensaje para pedirle al agente que inicie el proceso de actualización de Spark.

Upgrade my Spark application <local-project-path> from EMR version 6.0.0 to 7.12.0. Use EMR-EC2 Cluster <cluster-id> to run the validation and s3 paths s3://<please fill in your staging bucket path> to store updated application artifacts. Use spark-upgrade-profile for AWS CLI operations.

Integración con Kiro CLI (QCLI)

Inicie Kiro CLI o su asistente de IA y compruebe las herramientas cargadas para el agente de actualización.

... spark-upgrade (MCP): - check_and_update_build_environment * not trusted - check_and_update_python_environment * not trusted - check_job_status * not trusted - compile_and_build_project * not trusted ...

Una demostración de la experiencia de actualización sin servidor de EMR con Kiro CLI. Simplemente puede iniciar el proceso de actualización con el siguiente mensaje:

Upgrade my Spark application <local-project-path> from EMR version 6.0.0 to 7.12.0. Use EMR-Serverless Applicaion <application-id> and execution role <your EMR Serverless job execution role> to run the validation and s3 paths s3://<please fill in your staging bucket path> to store updated application artifacts.

Integración con otros IDEs

La configuración también se puede utilizar en otros sitios IDEs para conectarse al servidor MCP gestionado:

-

Integración con Cline: para usar el servidor MCP con Cline, modifique

cline_mcp_settings.jsony añada la configuración anterior. Consulte la documentación de Clinepara obtener más información sobre cómo administrar la configuración del MCP. -

Integración con Claude Code Para utilizar el servidor MCP con Claude Code, modifique el archivo de configuración para incluir la configuración MCP. La ruta del archivo varía en función del sistema operativo. Consulte https://code.claude.com/docs/en/mcp

para obtener información detallada sobre la configuración. -

Integración con GitHub Copilot: para utilizar el servidor MCP con GitHub Copilot, siga las instrucciones de https://docs.github.com/en/copilot/how-tos/provide-context/use-mcp/extend- copilot-chat-with-mcp

para modificar el archivo de configuración correspondiente y siga las instrucciones de cada IDE para activar la configuración.

Configurar el clúster EMR o la aplicación EMR sin servidor para la versión de destino

Cree el clúster EMR o la aplicación EMR Serverless con la versión de Spark prevista que planea usar para la aplicación actualizada. El clúster de EMR o la aplicación EMR-S de destino se utilizarán para enviar las ejecuciones del trabajo de validación una vez que se hayan actualizado los artefactos de la aplicación Spark, a fin de comprobar que la actualización se ha realizado correctamente o corregir otros errores encontrados durante la validación. Si ya tiene un clúster de EMR de destino o una aplicación EMR Serverless, puede consultar el existente y omitir este paso. Utilice cuentas de desarrolladores que no sean de producción y seleccione conjuntos de datos simulados de muestra que representen los datos de producción, pero que sean más pequeños para validarlos con la función Actualizaciones de Spark. Consulte esta página para obtener instrucciones sobre cómo crear un clúster de EMR de destino o una aplicación EMR Serverless a partir de las existentes:. Creación de un clúster de EMR/aplicación EMR-S de destino a partir de los existentes