Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Almacenamiento en caché de peticiones para una inferencia de modelos más rápida

nota

El almacenamiento en caché de peticiones de Amazon Bedrock está disponible con carácter general con Claude 3.7 Sonnet, Claude 3.5 Haiku,Amazon Nova Micro, Amazon Nova Lite, Amazon Nova Pro y Amazon Nova Premier. Los clientes a los que se les haya dado acceso a Claude 3.5 Sonnet v2 durante la vista previa del almacenamiento en caché de peticiones conservarán su acceso; sin embargo, ningún otro cliente tendrá acceso al almacenamiento en caché de peticiones en el modelo Claude 3.5 Sonnet v2.

El almacenamiento en caché de peticiones es una característica opcional que puede utilizar con los modelos compatibles en Amazon Bedrock para reducir la latencia de la respuesta de inferencia y los costos de los tokens de entrada. Al añadir partes del contexto a una caché, el modelo puede aprovechar la caché para evitar tener que volver a calcular las entradas, lo que permite a Bedrock compartir los ahorros de computación y reducir las latencias de respuesta.

El almacenamiento en caché de peticiones puede ser útil cuando tiene cargas de trabajo con contextos largos y repetitivos que se reutilizan con frecuencia para múltiples consultas. Por ejemplo, si tiene un chatbot en el que los usuarios pueden cargar documentos y hacer preguntas sobre ellos, el modelo puede tardar mucho tiempo en procesar el documento cada vez que el usuario proporciona información. Con el almacenamiento en caché de peticiones, puede almacenar en caché el documento para que las futuras consultas que contengan el documento no tengan que volver a procesarlo.

Al utilizar el almacenamiento en caché de peticiones, se le cobrará una tarifa reducida por los tokens leídos desde la memoria caché. Según el modelo, los tokens escritos en la memoria caché pueden cobrarse a una tarifa superior a la de los tokens de entrada no almacenados en caché. Los tokens que no se lean o escriban en la memoria caché se cobran según la tarifa de token estándar de ese modelo. Para obtener más información, consulte la página de Precios de Amazon Bedrock

Funcionamiento

Si decide utilizar el almacenamiento en caché de peticiones, Amazon Bedrock crea una caché compuesta por puntos de control de caché. Son marcadores que definen la subsección contigua de la petición que desea almacenar en caché (lo que suele denominarse “prefijo de petición”). Estos prefijos de petición deben ser estáticos entre las solicitudes; si se modifica el prefijo de petición en solicitudes posteriores, se producirá una pérdida de memoria caché.

Los puntos de control de caché tienen un número mínimo y máximo de tokens, según el modelo específico que utilice. Solo puede crear un punto de control de caché si el prefijo de petición total cumple con el número mínimo de tokens. Por ejemplo, el modelo Anthropic Claude 3.7 Sonnet requiere al menos 1024 tokens por punto de control de caché. Esto significa que el primer punto de control de caché se puede definir después de 1024 tokens y el segundo punto de control de caché se puede definir después de 2048 tokens. Si intenta añadir un punto de control de caché antes de alcanzar el número mínimo de tokens, la inferencia se seguirá realizando correctamente, pero el prefijo no se almacenará en caché. La caché tiene un tiempo de vida (TTL) de cinco minutos, que se restablece cada vez que se accede correctamente a la caché. Durante este período, se conserva el contexto de la memoria caché. Si no se realiza ningún acceso a la caché en la ventana TTL, la caché caduca.

Puede utilizar el almacenamiento en caché de peticiones cada vez que obtenga inferencia de modelos en Amazon Bedrock para los modelos compatibles. Las siguientes características de Amazon Bedrock admiten el almacenamiento en caché de peticiones:

- Converse y ConverseStream APIs

-

Puede mantener una conversación con un modelo en el que especifique puntos de control de caché en sus peticiones.

- InvokeModel y InvokeModelWithResponseStream APIs

-

Puede enviar solicitudes de petición únicas en las que se habilite el almacenamiento en caché de peticiones y se especifiquen puntos de control de caché.

- Almacenamiento en caché de peticiones con inferencia entre regiones

-

El almacenamiento en caché de peticiones se puede utilizar junto con la inferencia entre regiones. La inferencia entre regiones selecciona automáticamente la AWS región óptima dentro de su geografía para atender su solicitud de inferencia, lo que maximiza los recursos disponibles y la disponibilidad del modelo. En momentos de alta demanda, estas optimizaciones pueden provocar un aumento de las escrituras en caché.

- Administración de peticiones de Amazon Bedrock

-

Al crear o modificar una petición, puede optar por habilitar el almacenamiento en caché de peticiones. Según el modelo, puede almacenar en caché las peticiones del sistema, las instrucciones del sistema y los mensajes (del usuario y del asistente). También puede elegir deshabilitar el almacenamiento en caché de peticiones.

Le APIs proporcionan la mayor flexibilidad y un control granular sobre la memoria caché de solicitudes. Puede establecer un punto de control de caché individual dentro de sus peticiones. Puede añadirlo a la caché creando más puntos de control de caché, hasta el número máximo de puntos de control de caché permitido para el modelo específico. Para obtener más información, consulte Modelos y regiones compatibles, y límites.

Modelos y regiones compatibles, y límites

En la siguiente tabla se muestran los modelos compatibles junto con su número mínimo de tokens, número máximo de puntos de control de caché y los campos que permiten puntos de control de caché.

| Nombre de modelo | ID del modelo | Tipo de versión | Número mínimo de tokens por punto de control de caché | Número máximo de puntos de control de caché por solicitud | Campos que aceptan puntos de control de caché de peticiones |

|---|---|---|---|---|---|

Claude Opus4.5 |

anthropic.claude-opus-4-5-20251101-v 1:0 |

Disponibilidad general |

4.096 |

4 |

`system`, `messages` y `tools` |

Claude Opus4.1 |

anthropic.claude-opus-4-1-20250805-v1:0 |

Disponibilidad general |

1 024 |

4 |

`system`, `messages` y `tools` |

Claude Opus 4 |

anthropic.claude-opus-4-20250514-v1:0 |

Disponibilidad general |

1 024 |

4 |

`system`, `messages` y `tools` |

Claude Sonnet 4.5 |

anthropic.claude-sonnet-4-5-20250929-v1:0 |

Disponibilidad general |

1 024 |

4 |

`system`, `messages` y `tools` |

Claude Haiku 4.5 |

anthropic.claude-haiku-4-5-20251001-v1:0 |

Disponibilidad general |

4.096 |

4 |

`system`, `messages` y `tools` |

Claude Sonnet 4 |

anthropic.claude-sonnet-4-20250514-v1:0 |

Disponibilidad general |

1 024 |

4 |

`system`, `messages` y `tools` |

Claude 3.7 Sonnet |

anthropic.claude-3-7-sonnet-20250219-v 1:0 |

Disponibilidad general |

1 024 |

4 |

`system`, `messages` y `tools` |

Claude 3.5 Haiku |

anthropic.claude-3-5-haiku-20241022-v1:0 |

Disponibilidad general |

2048 |

4 |

`system`, `messages` y `tools` |

Claude 3.5 Sonnet v2 |

anthropic.claude-3-5-sonnet-20241022-v2:0 |

Vista previa |

1 024 |

4 |

`system`, `messages` y `tools` |

Amazon Nova Micro |

amazona. nova-micro-v1:0 |

Disponibilidad general |

1K1 |

4 |

`system` y `messages` |

Amazon Nova Lite |

amazon. nova-lite-v1:0 |

Disponibilidad general |

1K1 |

4 |

`system` y `messages`2 |

Amazon Nova Pro |

amazon. nova-pro-v1:0 |

Disponibilidad general |

1K1 |

4 |

`system` y `messages`2 |

Amazon Nova Premier |

amazon. nova-premier-v1:0 |

Disponibilidad general |

1K1 |

4 |

`system` y `messages`2 |

1: Los modelos Amazon Nova admiten un número máximo de 20 000 tokens para el almacenamiento en caché de peticiones.

2: El almacenamiento en caché de peticiones se utiliza principalmente para peticiones de texto.

Amazon Nova ofrece un almacenamiento en caché de peticiones automático para todas las peticiones de texto, incluidos los mensajes User y System. Este mecanismo puede proporcionar beneficios de latencia cuando las peticiones comienzan con partes repetitivas, incluso sin una configuración explícita. Sin embargo, para ahorrar costos y garantizar beneficios de rendimiento más sistemáticos, recomendamos optar por el almacenamiento en caché de peticiones explícito.

Administración de caché simplificada para los modelos Claude

Para los modelos Claude, Amazon Bedrock ofrece un enfoque simplificado de administración de la memoria caché que reduce la complejidad de colocar manualmente los puntos de control de caché. En lugar de tener que especificar las ubicaciones exactas de los puntos de control de caché, puede utilizar la administración automática de caché con un único punto de interrupción al final del contenido estático.

Al habilitar la administración simplificada de la memoria caché, el sistema comprueba automáticamente si se ha accedido a la memoria caché en los límites de los bloques de contenido anteriores y analiza hasta aproximadamente 20 bloques de contenido desde el punto de interrupción especificado. Esto permite que el modelo encuentre el prefijo coincidente más largo de la caché sin necesidad de que usted prediga las ubicaciones óptimas de los puntos de control. Para usarlo, coloque un único punto de control de caché al final del contenido estático, antes de cualquier contenido dinámico o variable. El sistema encontrará automáticamente la mejor coincidencia en la caché.

Para un control más detallado, puede seguir utilizando varios puntos de control de caché (hasta cuatro para los modelos Claude) para especificar los límites exactos de la caché. Debe utilizar varios puntos de control de caché si almacena en caché secciones que cambian con diferentes frecuencias o si desea tener más control sobre qué es exactamente lo que se almacena en caché.

importante

La comprobación automática de prefijos solo examina aproximadamente 20 bloques de contenido de su punto de control de caché. Si su contenido estático se extiende más allá de este intervalo, considere la posibilidad de usar varios puntos de control de caché o reestructurar la petición para colocar dentro de este intervalo el contenido que se reutiliza con más frecuencia.

Introducción

En las siguientes secciones se muestra una breve descripción de cómo utilizar la característica de almacenamiento en caché de peticiones para cada método de interacción con los modelos a través de Amazon Bedrock.

La API Converse ofrece opciones avanzadas y flexibles para implementar el almacenamiento en caché de peticiones en conversaciones de varios turnos. Para obtener más información sobre los requisitos de petición de cada modelo, consulte la sección anterior Modelos y regiones compatibles, y límites.

Ejemplo de solicitud

Los siguientes ejemplos muestran un punto de control de caché establecido en los campos messages, system o tools de una solicitud a la API Converse. Puede colocar puntos de control en cualquiera de estas ubicaciones para una solicitud determinada. Por ejemplo, si envía una solicitud al modelo Claude 3.5 Sonnet v2, puede colocar dos puntos de control de caché en messages, un punto de control de caché en system y otro en tools. Para obtener información más detallada y ejemplos de cómo estructurar y enviar solicitudes de la API Converse, consulte Cómo mantener una conversación con las operaciones de la API Converse.

La respuesta del modelo de la API Converse incluye dos campos nuevos que son específicos del almacenamiento en caché de peticiones. Los valores CacheReadInputTokens y CacheWriteInputTokens indican cuántos tokens se han leído de la caché y cuántos se han escrito en ella debido a una solicitud anterior. Estos son valores que Amazon Bedrock le cobra a una tarifa inferior al costo de la inferencia completa del modelo.

El almacenamiento rápido en caché está habilitado de forma predeterminada cuando llamas a la InvokeModelAPI. Puede establecer puntos de control de caché en cualquier punto del cuerpo de la solicitud, de forma similar al ejemplo anterior de la API Converse.

Para obtener más información sobre el envío de una InvokeModel solicitud, consulteEnvíe un único mensaje con InvokeModel.

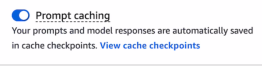

En un entorno de pruebas de chat de la consola de Amazon Bedrock, puede activar la opción de almacenamiento en caché de peticiones y Amazon Bedrock creará automáticamente puntos de control de caché por usted.

Siga las instrucciones de Generación de respuestas en la consola mediante áreas de juego para empezar a usar peticiones en un entorno de pruebas de Amazon Bedrock. En los modelos compatibles, el almacenamiento en caché de peticiones se activa automáticamente en el entorno de pruebas. Sin embargo, si no es así, haga lo siguiente para activar el almacenamiento en caché de peticiones:

-

En el panel lateral izquierdo, abra el menú Configuraciones.

-

Active la opción Almacenamiento en caché de peticiones.

-

Ejecute sus peticiones.

Cuando las respuestas combinadas de entrada y modelo alcancen la cantidad mínima requerida de tokens para un punto de control (que varía según el modelo), Amazon Bedrock creará automáticamente el primer punto de control de caché para usted. A medida que siga chateando, cada vez que alcance el número mínimo de tokens, se creará un nuevo punto de control, hasta el número máximo de puntos de control permitido para el modelo. Puede ver los puntos de control de caché en cualquier momento seleccionando Ver los puntos de control de la caché junto a la opción Almacenamiento en caché de peticiones, como se muestra en la siguiente captura de pantalla.

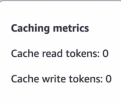

Puede ver cuántos tokens se leen y escriben en la caché debido a cada interacción con el modelo consultando la ventana emergente Métricas de almacenamiento en caché (

![]() ) en las respuestas del entorno de pruebas.

) en las respuestas del entorno de pruebas.

Si desactiva la opción de almacenamiento en caché de peticiones mientras está en medio de una conversación, puede seguir chateando con el modelo.