Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Führen Sie ein Testszenario aus

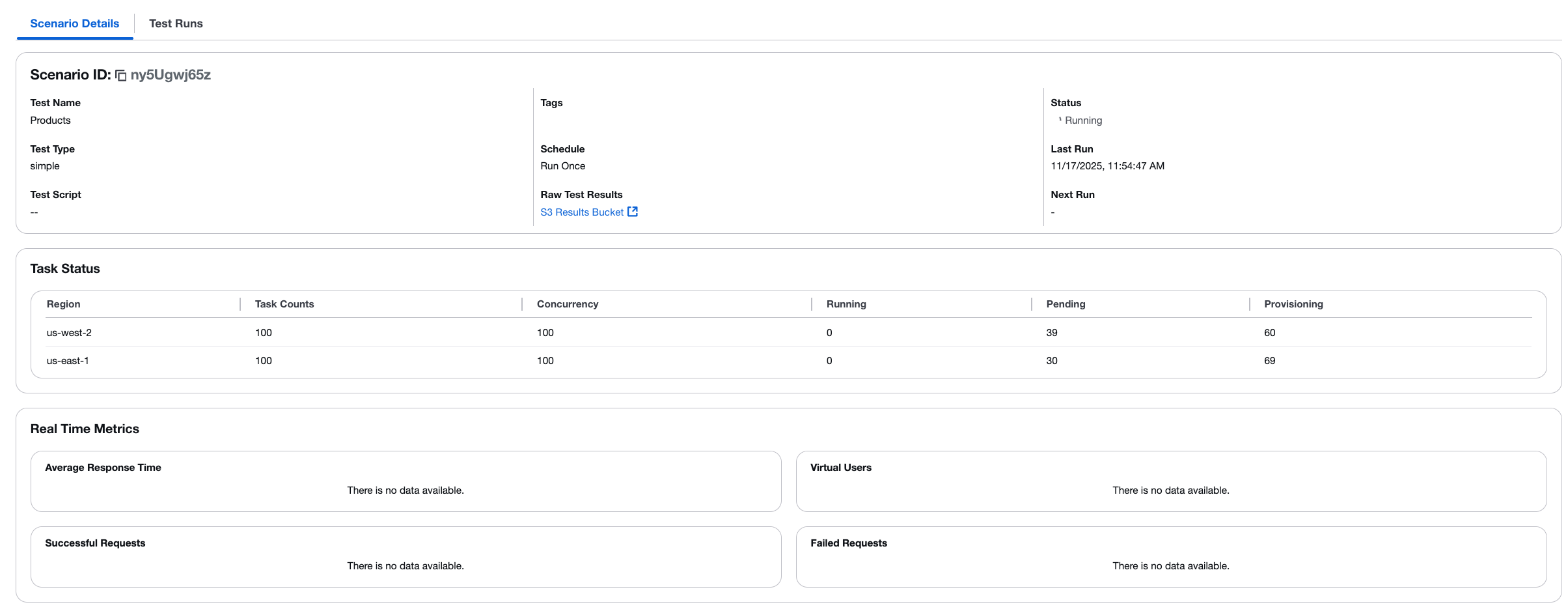

Nachdem Sie ein Testszenario erstellt haben, können Sie es sofort ausführen oder so planen, dass es zu einem bestimmten Zeitpunkt in der future ausgeführt wird. Wenn Sie zu einem laufenden Test navigieren, zeigt die Konsole die Registerkarte Szenariodetails mit Aufgabenstatus und Messdaten in Echtzeit an.

Ansicht der Szenariodetails

Auf der Registerkarte Szenariodetails werden wichtige Informationen zu Ihrem Test angezeigt. In der Tabelle mit dem Aufgabenstatus werden Echtzeitinformationen für jede Region angezeigt.

Tabelle mit dem Aufgabenstatus

In der Tabelle mit dem Aufgabenstatus werden Echtzeitinformationen für jede Region angezeigt:

-

Region — Die AWS-Region, in der Aufgaben ausgeführt werden

-

Anzahl der Aufgaben — Die Gesamtzahl der für die Region konfigurierten Aufgaben

-

Parallelität — Die Anzahl der virtuellen Benutzer pro Aufgabe

-

Wird ausgeführt — Anzahl der Aufgaben, die den Test derzeit ausführen

-

Ausstehend — Anzahl der Aufgaben, die darauf warten, gestartet zu werden

-

Bereitstellung — Anzahl der Aufgaben, die bereitgestellt werden

Arbeitsablauf bei der Testausführung

Wenn ein Test gestartet wird, findet der folgende Workflow statt:

-

Aufgabenbereitstellung — Die Lösung stellt Container (Aufgaben) in den angegebenen AWS-Regionen bereit. Aufgaben werden in der Spalte „Bereitstellung“ angezeigt.

-

Aufgabenstart — Die Lösung stellt weiterhin Aufgaben bereit, bis die Zielanzahl der Aufgaben in jeder Region erreicht ist. Aufgaben werden von „Bereitstellung“ zu „Ausstehend“ zu „Wird ausgeführt“ verschoben.

-

Generierung von Traffic — Nachdem die Lösung alle Aufgaben in einer Region bereitgestellt hat, beginnt sie, Traffic an Ihren Zielendpunkt zu senden.

-

Testausführung — Der Test wird für die konfigurierte Dauer (Hochlauf + Haltezeit) ausgeführt.

-

Analyse der Ergebnisse — Wenn der Test beendet ist, aggregiert und verarbeitet ein Hintergrundanalysejob die Ergebnisse aus allen Regionen.

Status des Testlaufs

Testläufe können die folgenden Status haben:

-

Geplant — Der Test soll in der future ausgeführt werden.

-

Wird ausgeführt — Der Test ist derzeit im Gange.

-

Abgebrochen — Ein Benutzer hat einen laufenden Testlauf abgebrochen.

-

Fehlerhaft — Beim Testlauf ist ein Fehler aufgetreten.

-

Abgeschlossen — Der Testlauf wurde erfolgreich abgeschlossen und die Ergebnisse liegen vor.

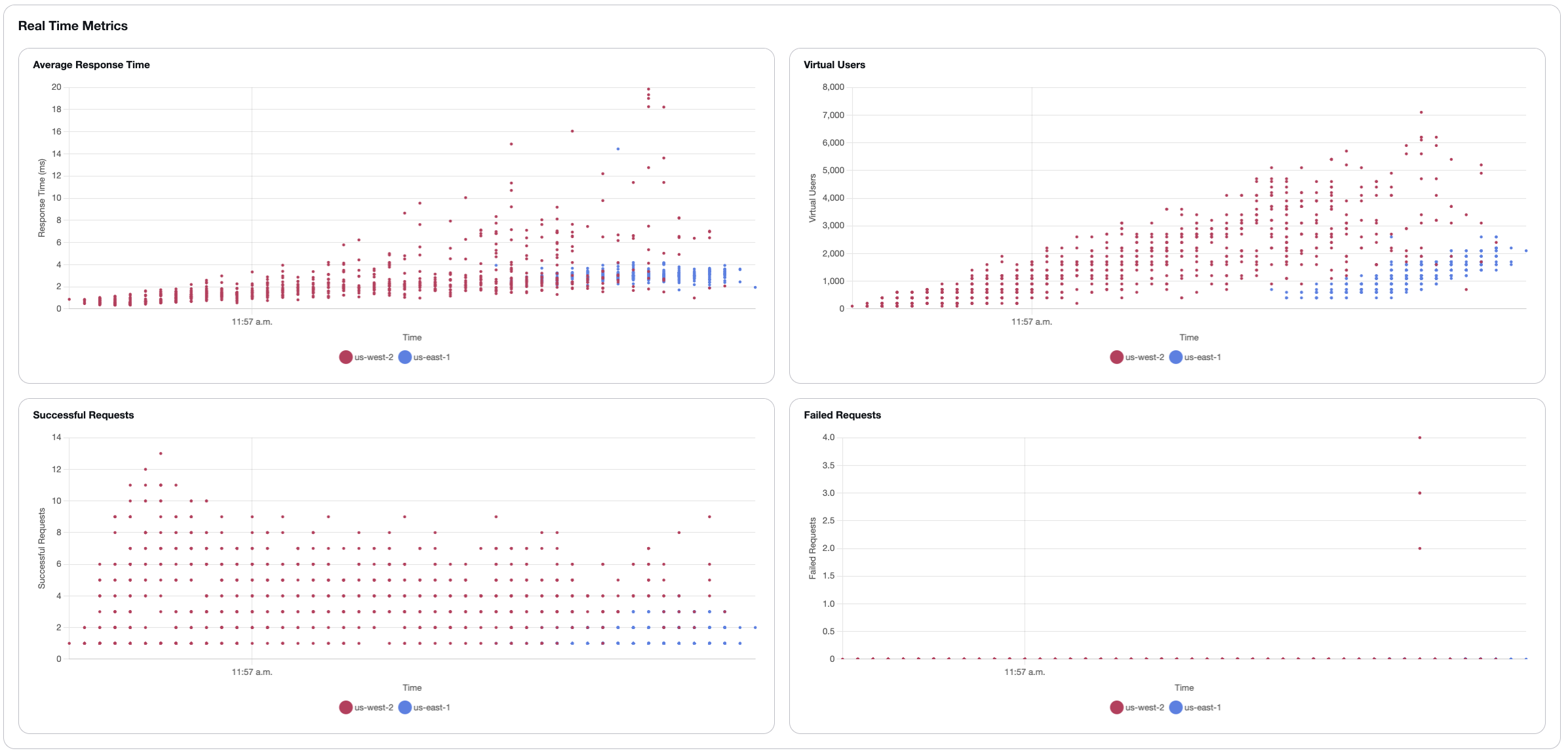

Überwachung mit Live-Daten

Wenn Sie bei der Erstellung des Testszenarios Live-Daten aktiviert haben, können Sie Echtzeitmetriken anzeigen, während der Test ausgeführt wird. Im Abschnitt Echtzeit-Metriken werden vier Diagramme angezeigt, die im Verlauf des Tests kontinuierlich aktualisiert werden. Die Daten werden in Intervallen von einer Sekunde aggregiert.

Beschreibungen der Grafiken

- Durchschnittliche Antwortzeit

-

Zeigt die durchschnittliche Antwortzeit in Sekunden für Anfragen an, die von jeder Region verarbeitet wurden. Die Y-Achse zeigt die Antwortzeit in Sekunden und die X-Achse die Tageszeit. Jede Region wird in der Legende durch eine andere Farbe dargestellt.

- Virtuelle Benutzer

-

Zeigt die Anzahl der gleichzeitigen virtuellen Benutzer an, die in jeder Region aktiv Last erzeugen. Das Diagramm zeigt, wie virtuelle Benutzer während des Tests an Wert gewinnen und das angestrebte Parallelitätsniveau beibehalten wird.

- Erfolgreiche Anfragen

-

Zeigt die Gesamtanzahl erfolgreicher Anfragen im Laufe der Zeit für jede Region an. Das Diagramm zeigt die Geschwindigkeit, mit der erfolgreiche Anfragen verarbeitet werden.

- Fehlgeschlagene Anfragen

-

Zeigt die Gesamtzahl der fehlgeschlagenen Anfragen im Laufe der Zeit für jede Region an. Eine niedrige Anzahl oder Null weist auf eine fehlerfreie Testausführung hin.

Visualisierung mehrerer Regionen

Wenn Tests in mehreren Regionen ausgeführt werden, zeigt jedes Diagramm Daten für alle Regionen gleichzeitig an. Die Legende am unteren Rand jedes Diagramms gibt an, welche Farbe die einzelnen Regionen repräsentiert (z. B. us-west-2 und us-east-1).

Technische Umsetzung

Die CloudWatch Protokollgruppe für die Fargate-Aufgaben enthält einen Abonnementfilter, der Testergebnisse erfasst. Wenn das Muster erkannt wird, strukturiert eine Lambda-Funktion die Daten und veröffentlicht sie in einem AWS IoT Core Core-Thema. Die Webkonsole abonniert dieses Thema und zeigt die Metriken in Echtzeit an.

Anmerkung

Live-Daten sind kurzlebig und nur verfügbar, während der Test läuft. Die Webkonsole speichert maximal 5.000 Datenpunkte. Danach werden die ältesten Daten durch die neuesten ersetzt. Wenn die Seite aktualisiert wird, sind die Grafiken leer und beginnen mit dem nächsten verfügbaren Datenpunkt. Sobald ein Test abgeschlossen ist, speichert die Lösung die Ergebnisdaten in DynamoDB und Amazon S3. Wenn noch keine Daten verfügbar sind, wird in den Diagrammen „Es sind keine Daten verfügbar“ angezeigt.

Einen Test stornieren

Sie können einen laufenden Test über die Webkonsole abbrechen. Wenn Sie einen Test abbrechen, läuft der folgende Arbeitsablauf ab:

-

Die Stornierungsanfrage wird an die

microservicesAPI gesendet -

Die

microservicesAPI ruft dietask-cancelerLambda-Funktion auf, die alle aktuell gestarteten Aufgaben stoppt -

Wenn die

task-runnerLambda-Funktion nach dem ersten Abbruchaufruf weiter ausgeführt wird, werden Aufgaben möglicherweise weiterhin kurz gestartet -

Sobald die

task-runnerLambda-Funktion abgeschlossen ist, fährt AWS Step Functions mit demCancel TestSchritt fort, in dem dietask-cancelerLambda-Funktion erneut ausgeführt wird, um alle verbleibenden Aufgaben zu beenden

Anmerkung

Bei abgebrochenen Tests dauert es einige Zeit, bis der Shutdown-Vorgang abgeschlossen ist, da die Lösung alle Container beendet. Der Teststatus ändert sich auf „Storniert“, sobald alle Ressourcen bereinigt sind.