Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

MCP-Serverintegration

Wenn Sie die optionale MCP-Serverkomponente während der Lösungsbereitstellung bereitgestellt haben, können Sie die Distributed Load Testing-Lösung in KI-Entwicklungstools integrieren, die das Model Context Protocol unterstützen. Der MCP-Server bietet programmatischen Zugriff zum Abrufen, Verwalten und Analysieren von Lasttests mithilfe von KI-Assistenten.

Kunden können mit dem Client ihrer Wahl (Amazon Q, Claude usw.) eine Verbindung zum DLT MCP-Server herstellen, für die jeweils leicht unterschiedliche Konfigurationsanweisungen gelten. Dieser Abschnitt enthält Anweisungen zur Einrichtung von MCP Inspector, Amazon Q CLI, Cline und Amazon Q Suite.

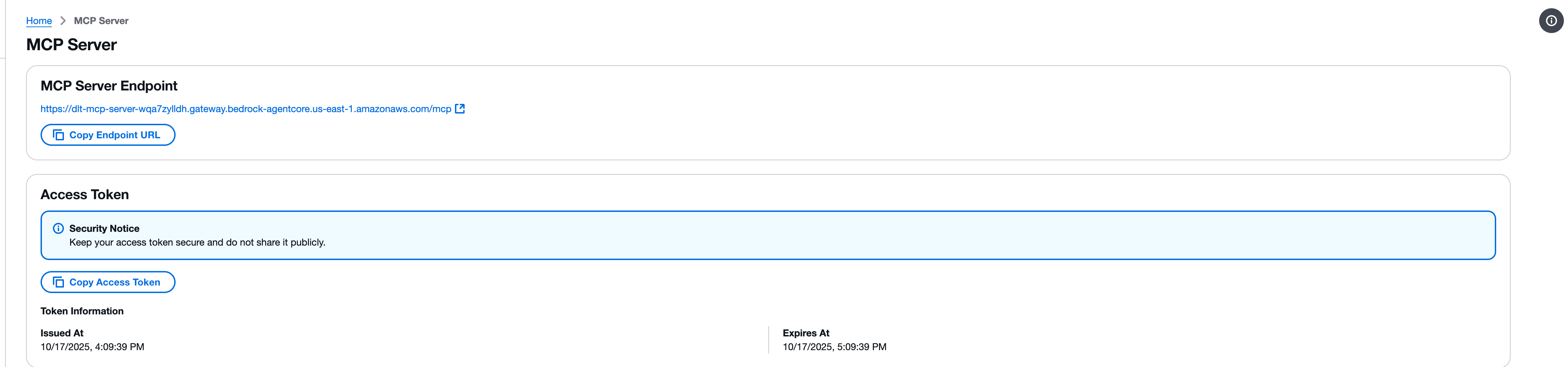

Schritt 1: Holen Sie sich den MCP-Endpunkt und das Zugriffstoken

Bevor Sie einen MCP-Client konfigurieren, müssen Sie Ihren MCP-Serverendpunkt und Ihr Zugriffstoken von der DLT-Webkonsole abrufen.

-

Navigieren Sie in der Distributed Load Testing-Webkonsole zur MCP-Serverseite.

-

Suchen Sie den Abschnitt MCP Server Endpoint.

-

Kopieren Sie die Endpunkt-URL mithilfe der Schaltfläche Endpunkt-URL kopieren. Die Endpunkt-URL folgt dem Format:

https://{gateway-id}.gateway.bedrock-agentcore.{region}.amazonaws.com/mcp -

Suchen Sie den Abschnitt Access Token.

-

Kopieren Sie das Zugriffstoken mit der Schaltfläche Zugriffstoken kopieren.

Wichtig

Bewahren Sie Ihr Zugriffstoken sicher auf und geben Sie es nicht öffentlich weiter. Das Token bietet über die MCP-Schnittstelle schreibgeschützten Zugriff auf Ihre Distributed Load Testing-Lösung.

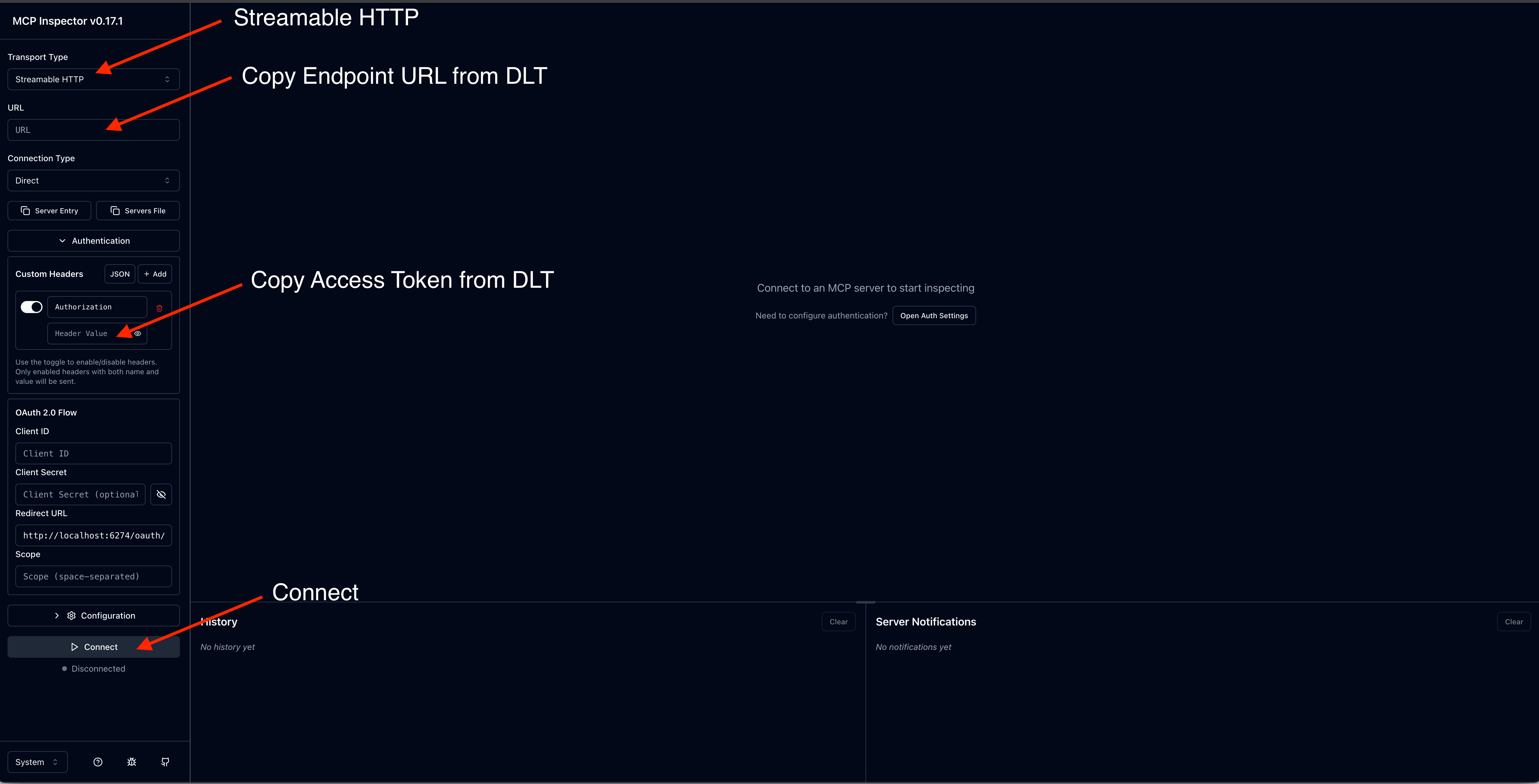

Schritt 2: Testen Sie mit MCP Inspector

Das Model Context Protocol bietet MCP Inspector

Anmerkung

MCP Inspector benötigt Version 0.17 oder höher. Alle Anfragen können auch direkt mit JSON RPC gestellt werden, MCP Inspector bietet jedoch eine benutzerfreundlichere Oberfläche.

Installieren und starten Sie MCP Inspector

-

Installieren Sie npm, falls erforderlich.

-

Führen Sie den folgenden Befehl aus, um MCP Inspector zu starten:

npx @modelcontextprotocol/inspector

Konfigurieren Sie die Verbindung

-

Geben Sie in der MCP Inspector-Oberfläche Ihre MCP Server-Endpunkt-URL ein.

-

Fügen Sie einen Autorisierungsheader mit Ihrem Zugriffstoken hinzu.

-

Klicken Sie auf Connect, um die Verbindung herzustellen.

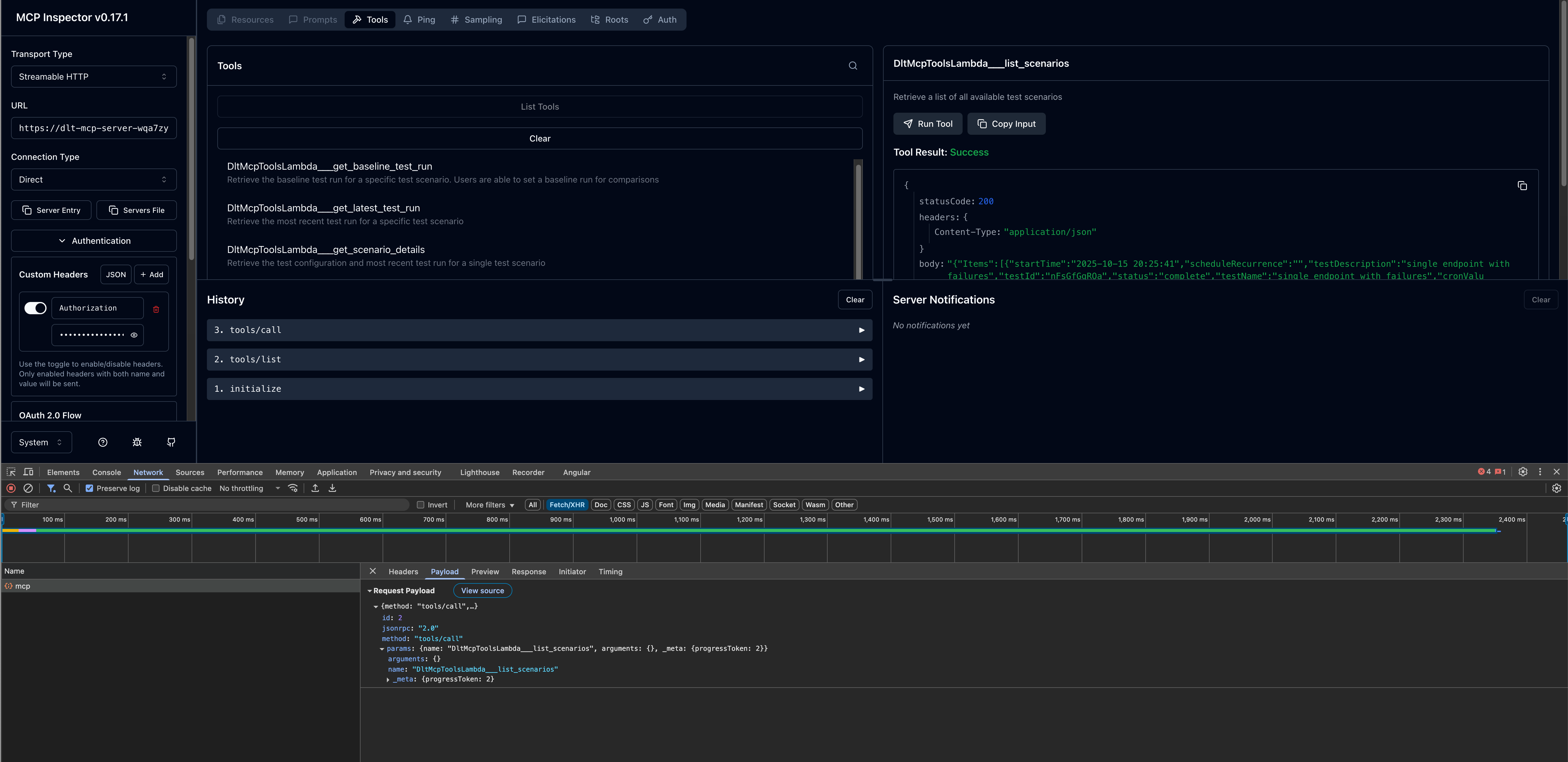

Rufen Sie Tools auf

Sobald die Verbindung hergestellt ist, können Sie die verfügbaren MCP-Tools testen:

-

Durchsuchen Sie die Liste der verfügbaren Tools im linken Bereich.

-

Wählen Sie ein Werkzeug aus (z. B.

list_scenarios). -

Geben Sie alle erforderlichen Parameter an.

-

Klicken Sie auf Aufrufen, um das Tool auszuführen und die Antwort anzuzeigen.

Schritt 3: Konfigurieren Sie KI-Entwicklungsclients

Nachdem Sie Ihre MCP-Serververbindung mit MCP Inspector überprüft haben, können Sie Ihren bevorzugten AI-Entwicklungsclient konfigurieren.

Amazon Q CLI

Amazon Q CLI bietet Befehlszeilenzugriff auf KI-gestützte Entwicklung mit MCP-Serverintegration.

Schritte zur Konfiguration

-

Bearbeiten Sie die

mcp.jsonKonfigurationsdatei. Weitere Informationen zum Speicherort der Konfigurationsdatei finden Sie unter Konfiguration von Remote-MCP-Servern im Amazon Q Developer User Guide. -

Fügen Sie Ihre DLT-MCP-Serverkonfiguration hinzu:

{ "mcpServers": { "dlt-mcp": { "type": "http", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } }

Überprüfen Sie die Konfiguration

-

Geben Sie in einem Terminal ein,

qum Amazon Q CLI zu starten. -

Geben Sie

/mcpein, um alle verfügbaren MCP-Server zu sehen. -

Geben Sie

/toolsein, um die verfügbaren Tools vondlt-mcpund anderen konfigurierten MCP-Servern anzuzeigen. -

Stellen Sie sicher, dass die Initialisierung

dlt-mcperfolgreich war.

Cline

Cline ist ein KI-Codierungsassistent, der die MCP-Serverintegration unterstützt.

Schritte zur Konfiguration

-

Navigieren Sie in Cline zu MCP-Server verwalten > Konfigurieren > MCP-Server konfigurieren.

-

Aktualisieren Sie die Datei:

cline_mcp_settings.json{ "mcpServers": { "dlt-mcp": { "type": "streamableHttp", "url": "https://[api-id].execute-api.[region].amazonaws.com/[stage]/gateway/backend-agent/sse/mcp", "headers": { "Authorization": "your_access_token_here" } } } } -

Speichern Sie die Konfigurationsdatei.

-

Starten Sie Cline neu, um die Änderungen zu übernehmen.

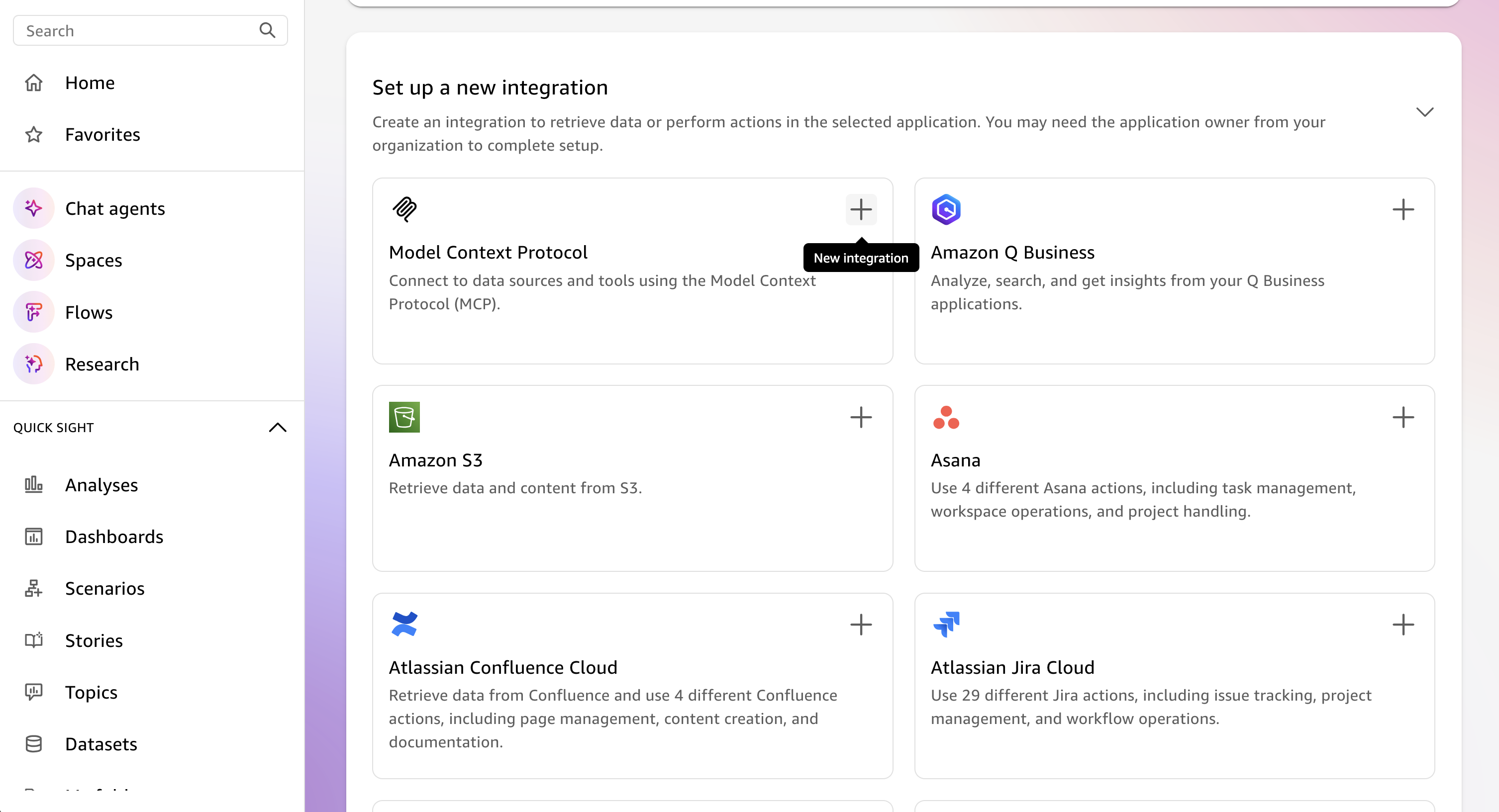

Amazon Q Suite

Amazon Q Suite bietet eine umfassende KI-Assistentenplattform mit Unterstützung für MCP-Serveraktionen.

Voraussetzungen

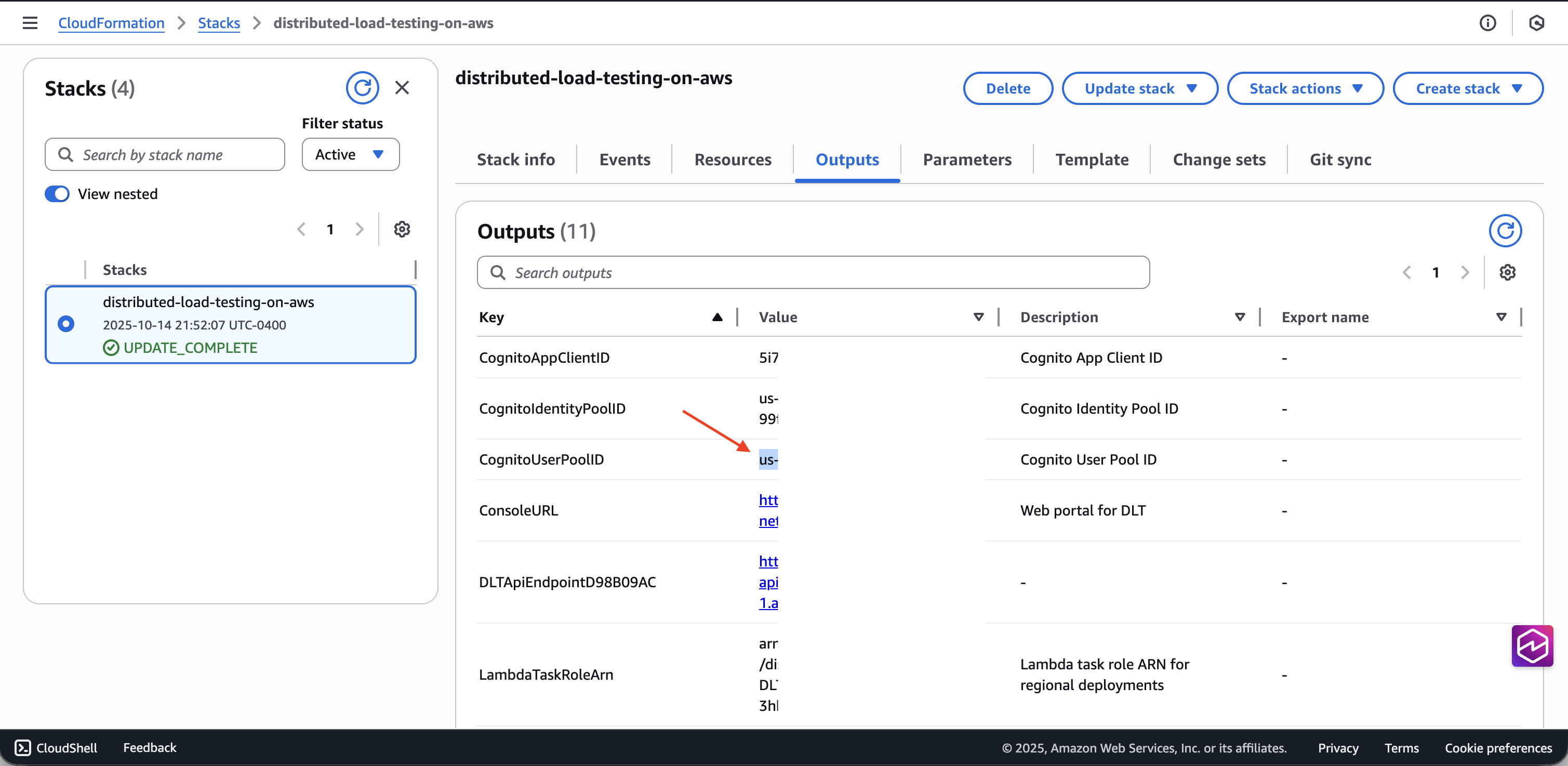

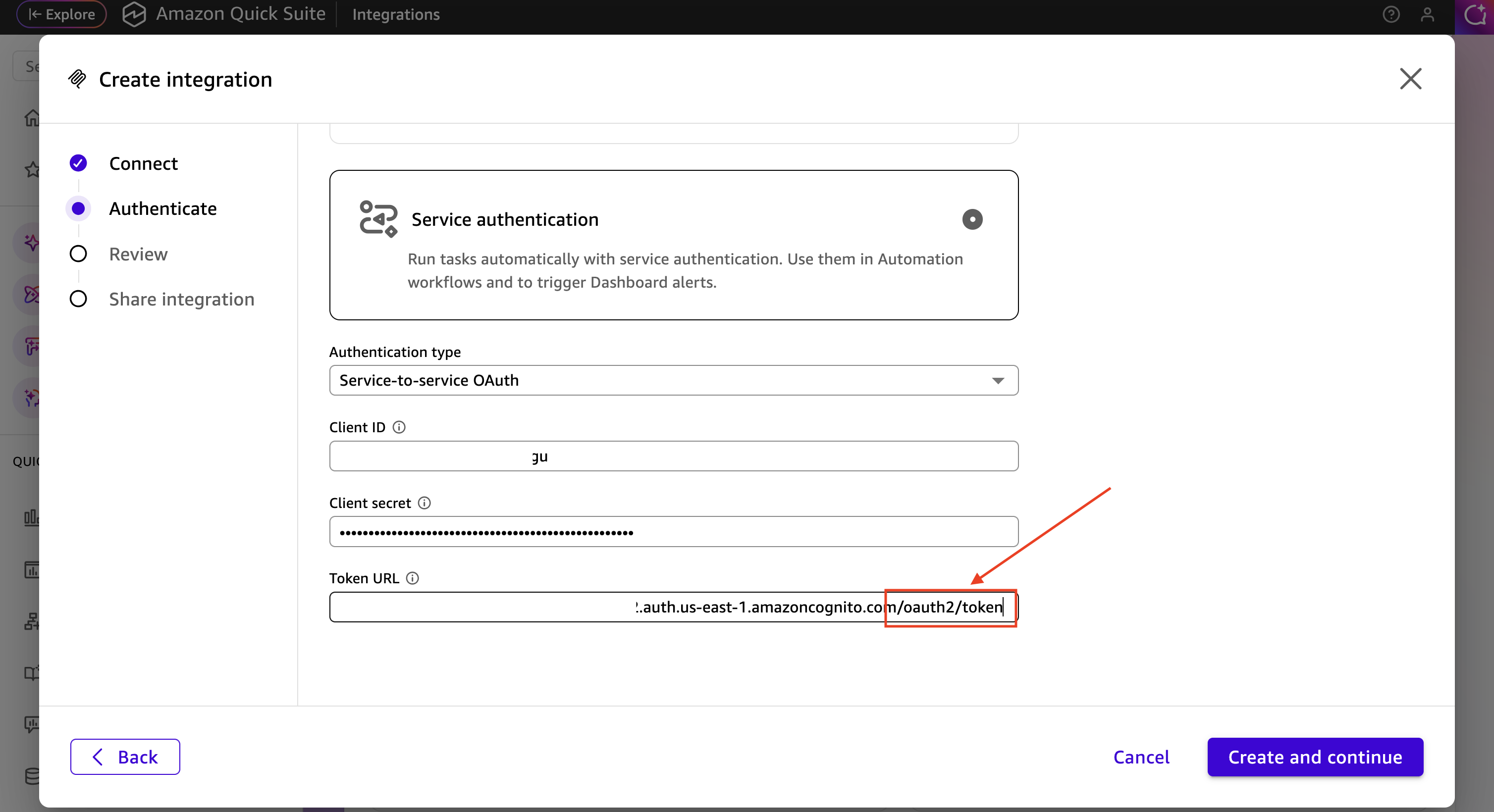

Bevor Sie den MCP-Server in Amazon Q Suite konfigurieren, müssen Sie OAuth Anmeldeinformationen aus dem Cognito-Benutzerpool Ihrer DLT-Bereitstellung abrufen:

-

Navigieren Sie zur CloudFormation AWS-Konsole

. -

Wählen Sie den Distributed Load Testing-Stack aus.

-

Suchen Sie auf der Registerkarte Ausgaben die Cognito-Benutzerpool-ID, die Ihrer DLT-Bereitstellung zugeordnet ist, und kopieren Sie sie.

-

Navigieren Sie zur Amazon-Cognito-Konsole

. -

Wählen Sie den Benutzerpool anhand der Benutzerpool-ID aus den CloudFormation Ausgaben aus.

-

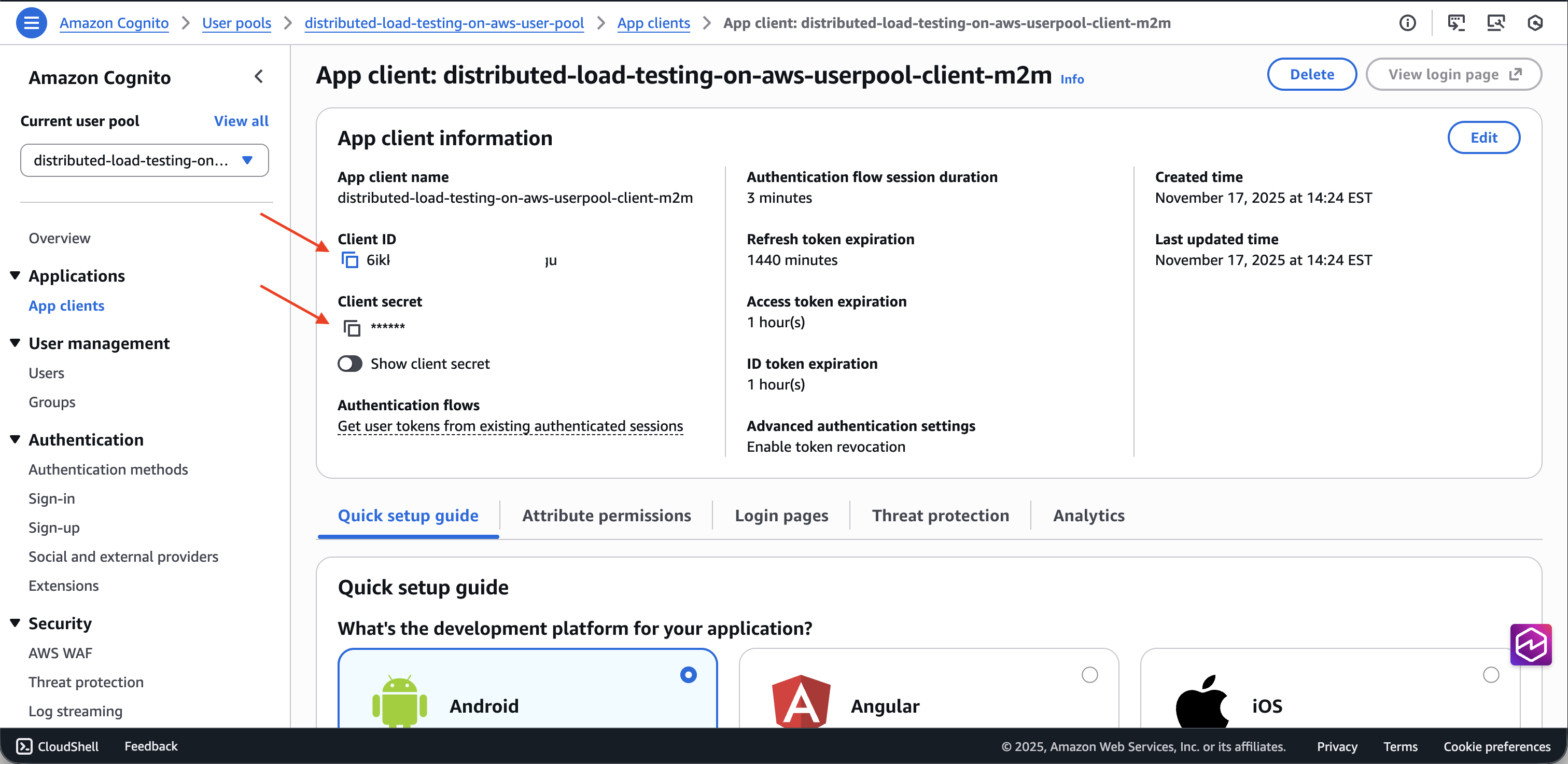

Wählen Sie in der linken Navigationsleiste App-Integration > App-Clients aus.

-

Suchen Sie den App-Client, dessen Name auf

m2m(machine-to-machine) endet. -

Kopieren Sie die Client-ID und den geheimen Client-Schlüssel.

-

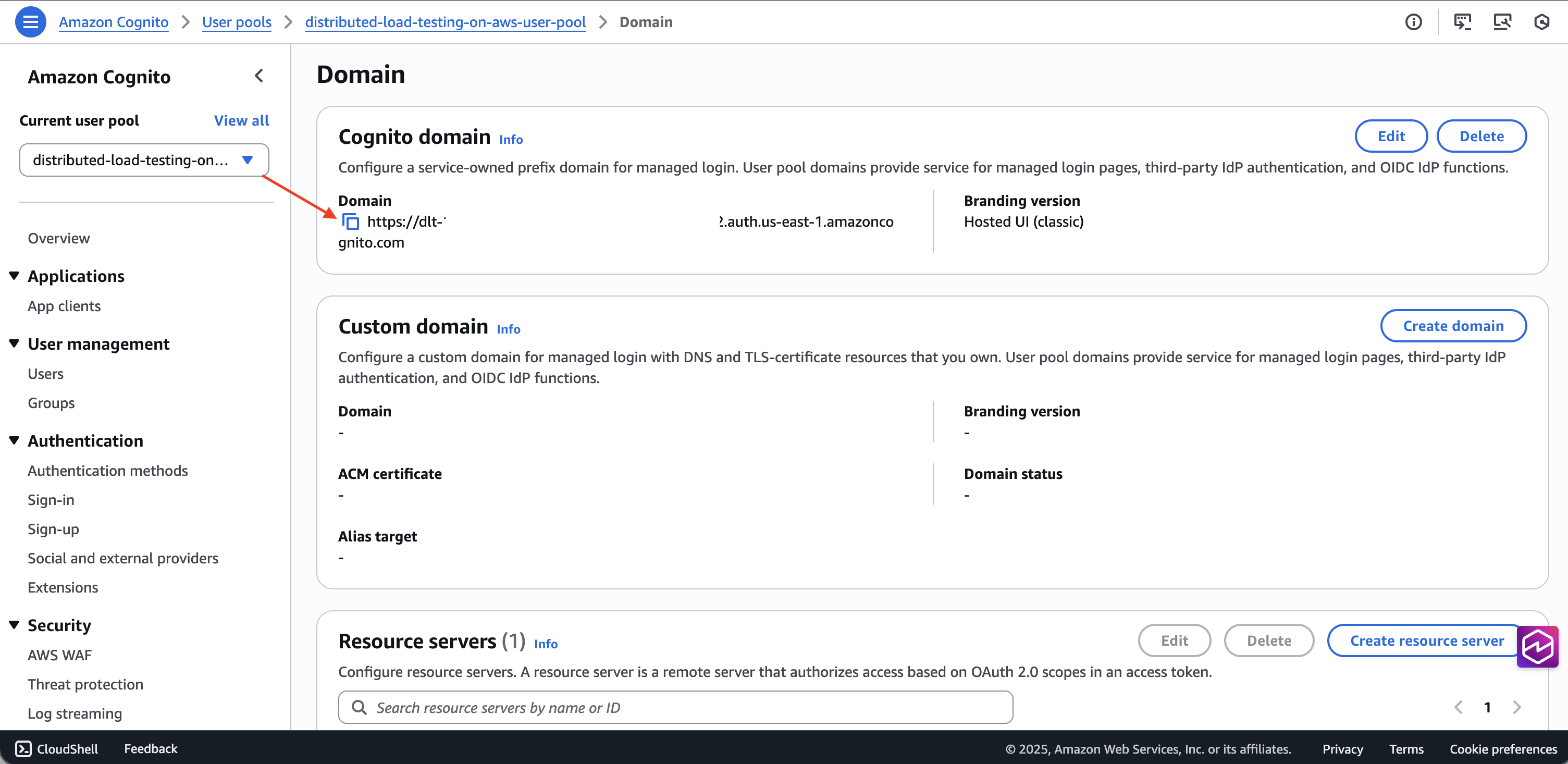

Rufen Sie die Benutzerpool-Domain auf der Registerkarte Domäne ab.

-

Erstellen Sie die Token-Endpunkt-URL, indem

/oauth2/tokenSie sie an das Ende der Domain anhängen.

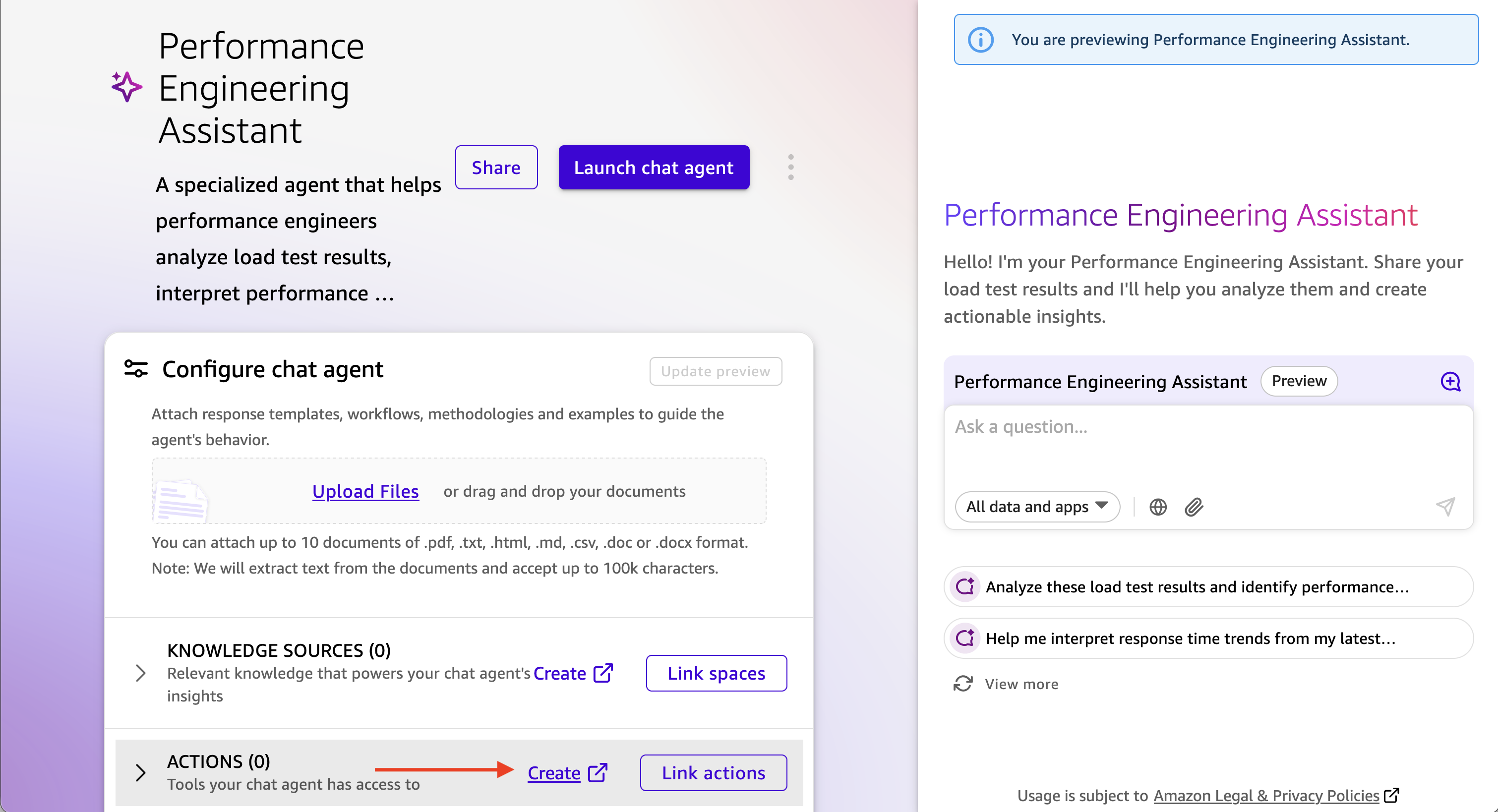

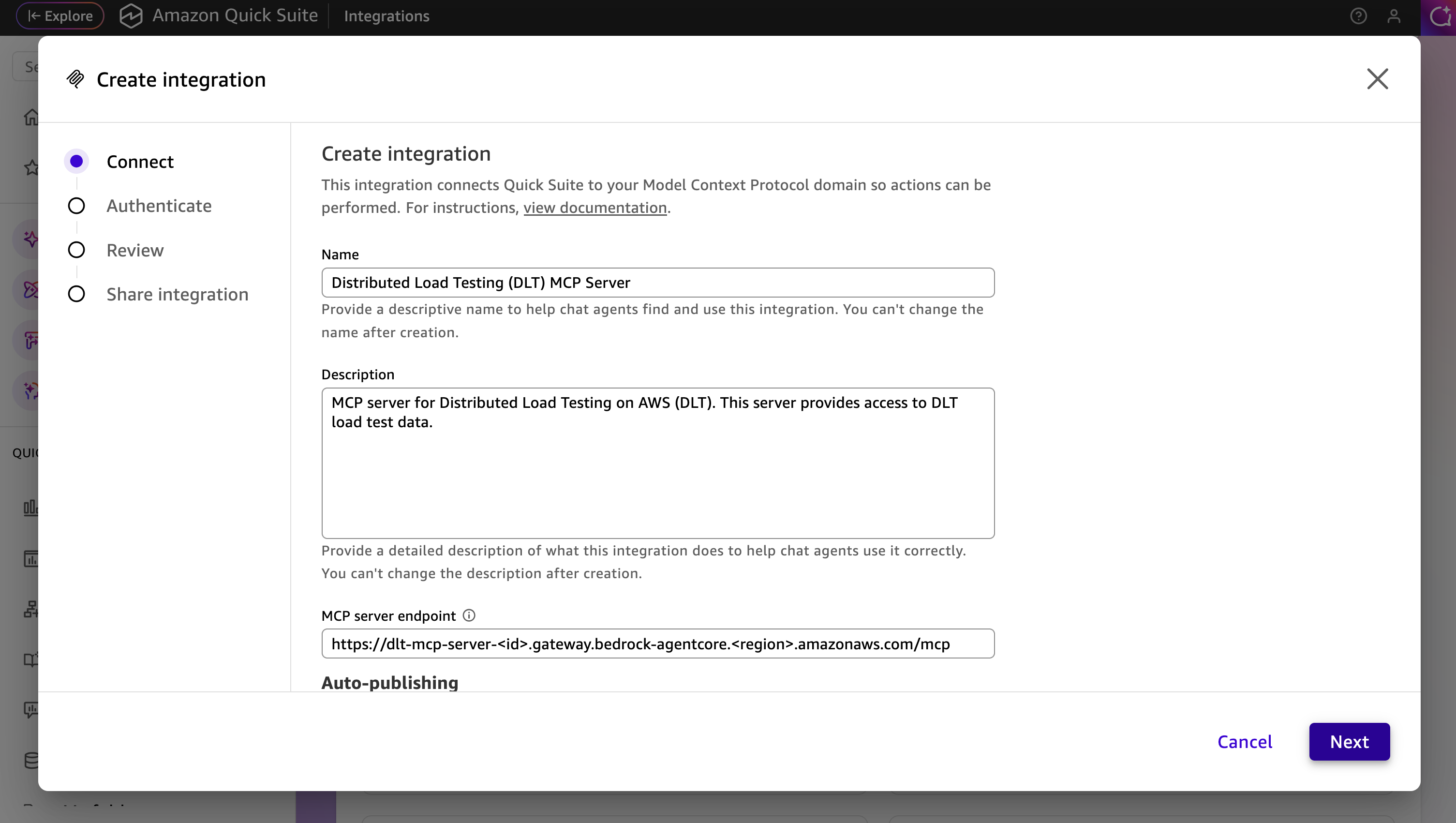

Schritte zur Konfiguration

-

Erstellen Sie in Amazon Q Suite einen neuen Agenten oder wählen Sie einen vorhandenen Agenten aus.

-

Fügen Sie eine Agenten-Eingabeaufforderung hinzu, die beschreibt, wie Sie mit dem DLT MCP-Server interagieren.

-

Fügen Sie eine neue Aktion hinzu und wählen Sie MCP-Serveraktion aus.

-

Konfigurieren Sie die MCP-Serverdetails:

-

MCP-Server-URL: Ihr DLT-MCP-Endpunkt

-

Authentifizierungstyp: Dienstbasierte Authentifizierung

-

Token-Endpunkt: Ihre Cognito-Token-Endpunkt-URL

-

Client-ID: Die Client-ID des M2M-App-Clients

-

Geheimer Client-Schlüssel: Der geheime Client-Schlüssel aus dem M2M-App-Client

-

-

Speichern Sie die MCP-Serveraktionskonfiguration.

-

Fügen Sie Ihrem Agenten die neue MCP-Serveraktion hinzu.

Starten und testen Sie den Agenten

-

Starten Sie den Agenten in Amazon Q Suite.

-

Starten Sie mithilfe von Eingabeaufforderungen in natürlicher Sprache eine Konversation mit dem Agenten.

-

Der Agent verwendet die MCP-Tools, um Ihre Lasttestdaten abzurufen und zu analysieren.

Beispiele für Prompts

Die folgenden Beispiele zeigen, wie Sie mit Ihrem KI-Assistenten interagieren können, um Lasttestdaten über die MCP-Schnittstelle zu analysieren. Passen Sie den Test IDs, die Datumsbereiche und die Kriterien an Ihre spezifischen Testanforderungen an.

Ausführliche Informationen zu den verfügbaren MCP-Tools und ihren Parametern finden Sie in der MCP-Tool-Spezifikation im Developer Guide.

Einfache Abfrage der Testergebnisse

Die Interaktion mit dem MCP-Server in natürlicher Sprache kann so einfach wie Show me the load tests that have completed in the last 24 hours with their associated completion status oder aussagekräftiger sein, z. B.

Use list_scenarios to find my load tests. Then use get_latest_test_run to show me the basic execution data and performance metrics for the most recent test. If the results look concerning, also get the detailed performance metrics using get_test_run.

Interaktive Leistungsanalyse mit schrittweiser Offenlegung

I need to analyze my load test performance, but I'm not sure which specific tests to focus on. Please help me by: 1. First, use list_scenarios to show me available test scenarios 2. Ask me which tests I want to analyze based on the list you show me 3. For my selected tests, use list_test_runs to get the test run history 4. Then use get_test_run with the test_run_id to get detailed response times, throughput, and error rates 5. If I want to compare tests, use get_baseline_test_run to compare against the baseline 6. If there are any issues, use get_test_run_artifacts to help me understand what went wrong Please guide me through this step by step, asking for clarification whenever you need more specific information.

Validierung der Produktionsreife

Help me validate if my API is ready for production deployment: 1. Use list_scenarios to find recent test scenarios 2. For the most recent test scenario, use get_latest_test_run to get basic execution data 3. Use get_test_run with that test_run_id to get detailed response times, error rates, and throughput 4. Use get_scenario_details with the test_id to show me what load patterns and endpoints were tested 5. If I have a baseline, use get_baseline_test_run to compare current results with the baseline 6. Provide a clear go/no-go recommendation based on the performance data 7. If there are any concerns, use get_test_run_artifacts to help identify potential issues My SLA requirements are: response time under [X]ms, error rate under [Y]%.

Analyse der Leistungstrends

Analyze the performance trend for my load tests over the past [TIME_PERIOD]: 1. Use list_scenarios to get all test scenarios 2. For each scenario, use list_test_runs with start_date and end_date to get tests from that period 3. Use get_test_run for the key test runs to get detailed metrics 4. Use get_baseline_test_run to compare against the baseline 5. Identify any significant changes in response times, error rates, or throughput 6. If you detect performance degradation, use get_test_run_artifacts on the problematic tests to help identify causes 7. Present the trend analysis in a clear format showing whether performance is improving, stable, or degrading Focus on completed tests and limit results to [N] tests if there are too many.

Behebung fehlgeschlagener Tests

Help me troubleshoot my failed load tests: 1. Use list_scenarios to find test scenarios 2. For each scenario, use list_test_runs to find recent test runs 3. Use get_test_run with the test_run_id to get the basic execution data and failure information 4. Use get_test_run_artifacts to get detailed error messages and logs 5. Use get_scenario_details to understand what was being tested when it failed 6. If I have a similar test that passed, use get_baseline_test_run to identify differences 7. Summarize the causes of failure and suggest next steps for resolution Show me the most recent [N] failed tests from the past [TIME_PERIOD].