Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Stellen Sie ein kompiliertes Modell mithilfe der Konsole bereit

Sie müssen den Abschnitt mit den Voraussetzungen erfüllen AWS SDK für Python (Boto3), wenn das Modell mit der oder der AWS CLI Amazon SageMaker AI-Konsole kompiliert wurde. Gehen Sie wie folgt vor, um ein mit SageMaker KI NEO kompiliertes Modell mithilfe der AI-Konsole SageMaker https://console.aws.amazon.com SageMaker /AI

Stellen Sie das Modell bereit

Nachdem Sie die Voraussetzungen erfüllt haben, führen Sie die folgenden Schritte aus, um ein mit Neo kompiliertes Modell bereitzustellen:

-

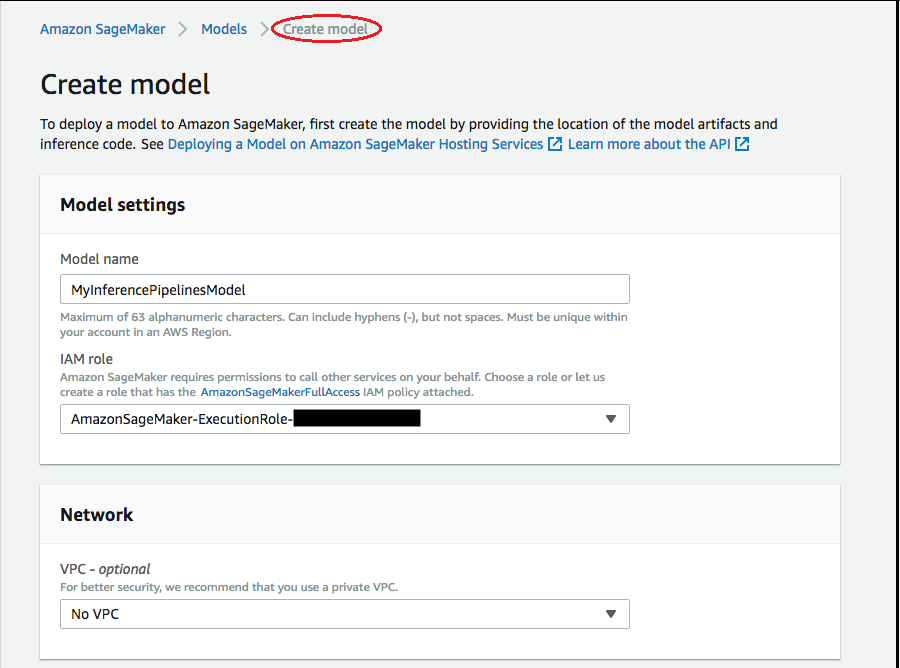

Wählen Sie Models (Modelle) und dann Create models (Modelle erstellen) in der Gruppe Inference (Inferenz) aus. Füllen Sie auf der Seite Modell erstellen die Felder Modellname, IAM-Rolle und VPC (optional) aus, falls erforderlich.

-

Zum Hinzufügen von Informationen über den für die Bereitstellung Ihres Modells verwendeten Container wählen Sie Container hinzufügen und dann Weiter aus. Machen Sie die nötigen Angaben unter Containereingabeoptionen, Speicherort des Inferenzcodeabbilds und Speicherort der Modellartefakte und optional auch unter Containerhostname und Umgebungsvariablen.

-

Zum Bereitstellen von mit Neo kompilierten Modellen wählen Sie die folgenden Optionen:

-

Containereingabeoptionen: Wählen Sie Modellartefakte und Inferenz-Images bereitstellen.

-

Speicherort des Inferenzcode-Bildes: Wählen Sie den URI des Inferenz-Image aus Neo Inference Container Images, abhängig von der AWS -Region und der Art der Anwendung.

-

Speicherort des Modell-Artefakts: Geben Sie den Amazon-S3-Bucket-URI des kompilierten Modell-Artefakts ein, das von der Neo Compilation API erzeugt wurde.

-

Umgebungsvariablen:

-

Lassen Sie dieses Feld leer für SageMaker XGBoost.

-

Wenn Sie Ihr Modell mit SageMaker KI trainiert haben, geben Sie die Umgebungsvariable

SAGEMAKER_SUBMIT_DIRECTORYals Amazon S3 S3-Bucket-URI an, die das Trainingsskript enthält. -

Wenn Sie Ihr Modell nicht mit SageMaker KI trainiert haben, geben Sie die folgenden Umgebungsvariablen an:

Schlüssel Werte für MXNet und PyTorch Werte TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <your region> <your region> MMS_DEFAULT_RESPONSE_TIMEOUT 500 Lassen Sie dieses Feld leer für TF.

-

-

-

Vergewissern Sie sich, dass die Informationen zu den Containern richtig sind, und klicken Sie dann auf Create Model (Modell erstellen). Wählen Sie auf der Modell Landingpage erstellen die Option Endpunkt erstellen aus.

-

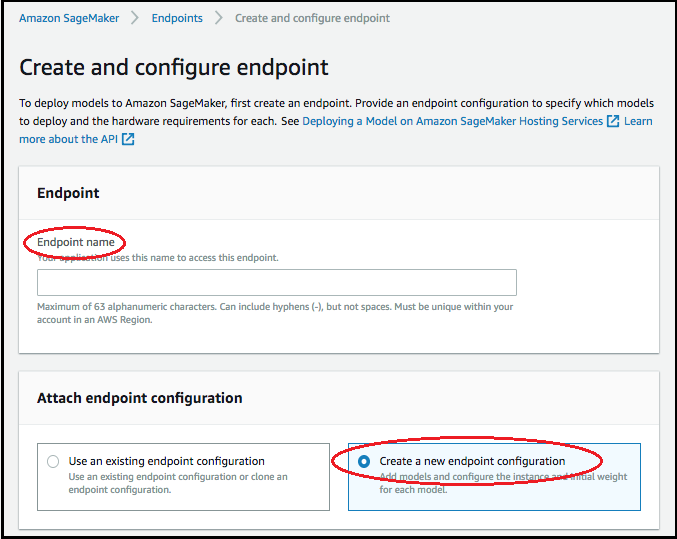

Geben Sie im Bereich Endpunkt erstellen und konfigurieren unter Endpunktname den Namen des Endpunkts an. Wählen Sie für Endpunktkonfiguration anhängen die Option Neue Endpunktkonfiguration erstellen aus.

-

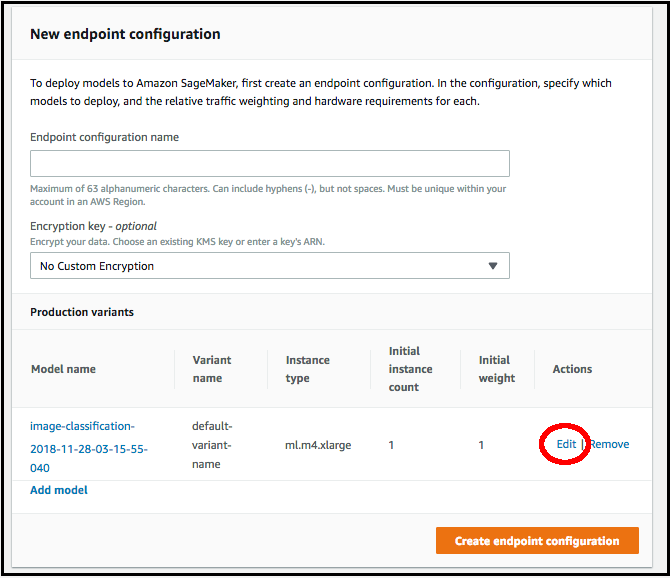

Geben Sie auf der Seite Neue Endpunktkonfiguration unter Endpunktkonfigurationsname den Namen der Endpunktkonfiguration an.

-

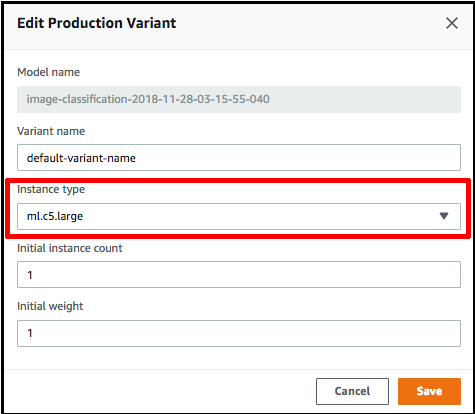

Wählen Sie neben dem Namen des Modells die Option Bearbeiten aus und geben Sie auf der Seite Produktionsvariante bearbeiten den richtigen Instance-Typ an. Der Wert unter Instance-Typ muss unbedingt mit dem in Ihrem Kompilierungsauftrag angegebenen Instance-Typ übereinstimmen.

-

Wählen Sie Save aus.

-

Wählen Sie auf der Seite Neue Endpunktkonfiguration die Option Endpunktkonfiguration erstellen und dann Endpunkt erstellen aus.