Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Informationen zu den Optionen für die Bereitstellung von Modellen und das Abrufen von Inferenzen in Amazon SageMaker AI

Um Ihnen den Einstieg in SageMaker AI Inference zu erleichtern, lesen Sie die folgenden Abschnitte, in denen die Optionen für die Bereitstellung Ihres Modells in SageMaker AI und das Abrufen von Inferenzen erläutert werden. Abschnitt Inferenzoptionen in Amazon SageMaker AI kann Ihnen dabei helfen, herauszufinden, welches Feature für die Inferenz in Ihrem Anwendungsfall am besten geeignet ist.

Im Ressourcen Abschnitt finden Sie weitere Informationen zur Fehlerbehebung und können Informationen, Blogs und Beispiele durchgehen, die Ihnen den Einstieg erleichtern, sowie häufig gestellte Fragen.

Themen

Bevor Sie beginnen

In diesen Themen wird davon ausgegangen, dass Sie ein oder mehrere Machine-Learning-Modelle erstellt und trainiert haben und bereit sind, sie bereitzustellen. Sie brauchen Ihr Modell nicht in SageMaker AI zu trainieren, um es in SageMaker AI einzusetzen und daraus Inferences zu ziehen. Wenn Sie kein eigenes Modell haben, können Sie auch die integrierten Algorithmen oder vortrainierten Modelle von SageMaker AI verwenden.

Wenn Sie mit SageMaker AI noch nicht vertraut sind und noch kein Modell für die Bereitstellung ausgewählt haben, gehen Sie die Schritte im Tutorial Erste Schritte mit Amazon SageMaker AI durch. In diesem Tutorial erfahren Sie, wie SageMaker AI den Data-Science-Prozess verwaltet und die Modellbereitstellung handhabt. Weitere Informationen zum Trainieren eines Modells finden Sie unter Modelle trainieren.

Weitere Informationen, Referenzen und Beispiele finden Sie in der Ressourcen.

Schritte beim Modelleinsatz

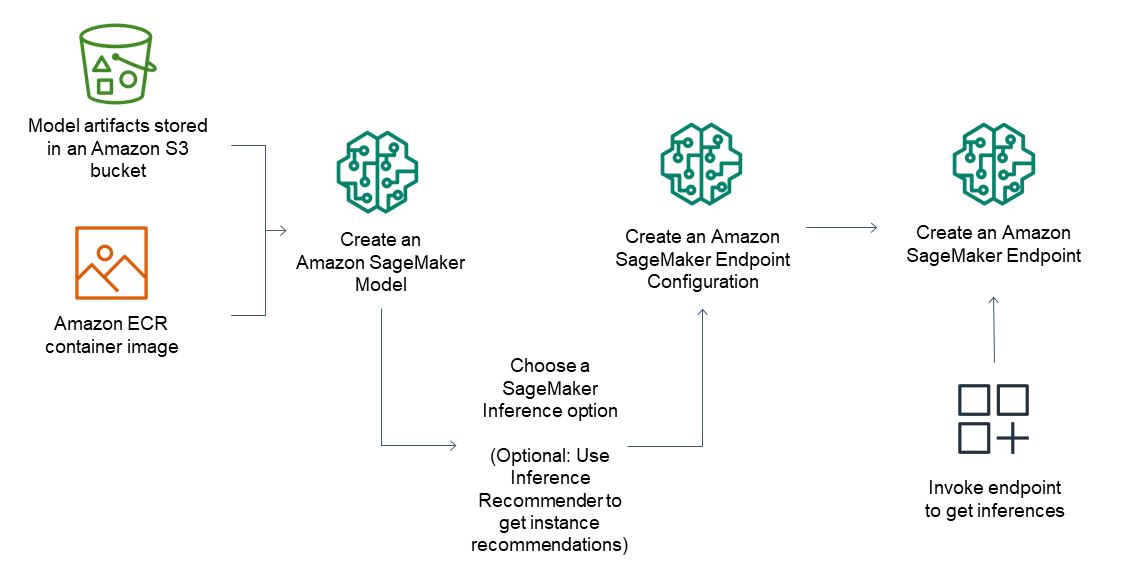

Der allgemeine Arbeitsablauf für Inference-Endpunkte besteht aus den folgenden Schritten:

Erstellen Sie in SageMaker AI Inference ein Modell, indem Sie auf in Amazon S3 gespeicherte Modellartefakte und ein Container-Image verweisen.

Wählen Sie eine Inference-Option aus. Weitere Informationen finden Sie unter Inferenzoptionen in Amazon SageMaker AI.

Erstellen Sie eine Endpunktkonfiguration für SageMaker AI Inference, indem Sie den Instance-Typ und die erforderliche Anzahl der Instances hinter dem Endpunkt auswählen. Mit dem Amazon SageMaker Inference Recommender können Sie Empfehlungen für Instance-Typen erhalten. Für Serverless Inference brauchen Sie nur die Speicherkonfiguration anzugeben, die Sie bei Ihrer Modellgröße brauchen.

Erstellen Sie einen Endpunkt für SageMaker AI Inference.

Rufen Sie Ihren Endpunkt auf, um als Antwort eine Inference zu erhalten.

Das folgende Diagramm zeigt den vorangehenden Arbeitsablauf.

Sie können diese Aktionen mit der AWS Konsole, den AWS SDKs, dem SageMaker Python SDK, dem CloudFormation oder der AWS CLI ausführen.

Für Batch-Inference mit Stapel-Transformation verweisen Sie auf Ihre Modellartefakte und Eingabedaten und erstellen Sie einen Batch-Inference-Auftrag. Anstatt für Inferences einen Endpunkt zu hosten, gibt SageMaker AI Ihre Inferences an einen Amazon S3-Standort Ihrer Wahl aus.